Guia mais abrangente, criado para todos os desenvolvedores de raspagem na web.

A Scorresless oferece serviços de raspagem e automação da Web, movidos a IA, robustos e escaláveis, confiáveis pelas principais empresas. Nossas soluções de nível corporativo são adaptadas para atender às necessidades do seu projeto, com suporte técnico dedicado por toda parte. Com uma equipe técnica forte e prazos de entrega flexíveis, cobramos apenas dados bem -sucedidos, permitindo uma extração de dados eficientes enquanto ignora as limitações.

Entre em contato conosco agora para alimentar o crescimento dos seus negócios.

Forneça seus detalhes de contato e prontamente entraremos em contato para oferecer uma demonstração e introdução do produto. Garantimos que suas informações permaneçam confidenciais, cumprindo os padrões do GDPR.

Sua avaliação gratuita está pronta! Inscreva -se para uma conta sem descarga gratuitamente e seu teste será ativado instantaneamente em sua conta.

Aprenda a construir pipelines confiáveis para web scraping com Claude AI. Este guia em Python compara 10 métodos e recomenda o Scrapeless Browser para escala e manejo de anti-bots.

Aprenda a extrair informações do Reddit em Python com 10 métodos passo a passo, incluindo API, BeautifulSoup e Scrapeless como a melhor solução em grande escala.

Aprenda Web Scraping Usando Perplexity em 2025 com 10 métodos passo a passo, casos reais e Scrapeless como a melhor alternativa para tarefas escaláveis.

Aprenda a extrair os Resultados de Pesquisa do Google (SERPs) em Python com este abrangente guia de 2025. Explore 10 soluções, desde Selenium até APIs dedicadas como Scrapeless, para superar medidas anti-bot e extrair dados valiosos.

Acelere sua extração de dados da web com este guia completo. Aprenda 10 técnicas para uma extração de dados mais rápida, incluindo concorrência, I/O assíncrono e rotação de proxies. Descubra como o Scrapeless pode aumentar sua velocidade de raspagem.

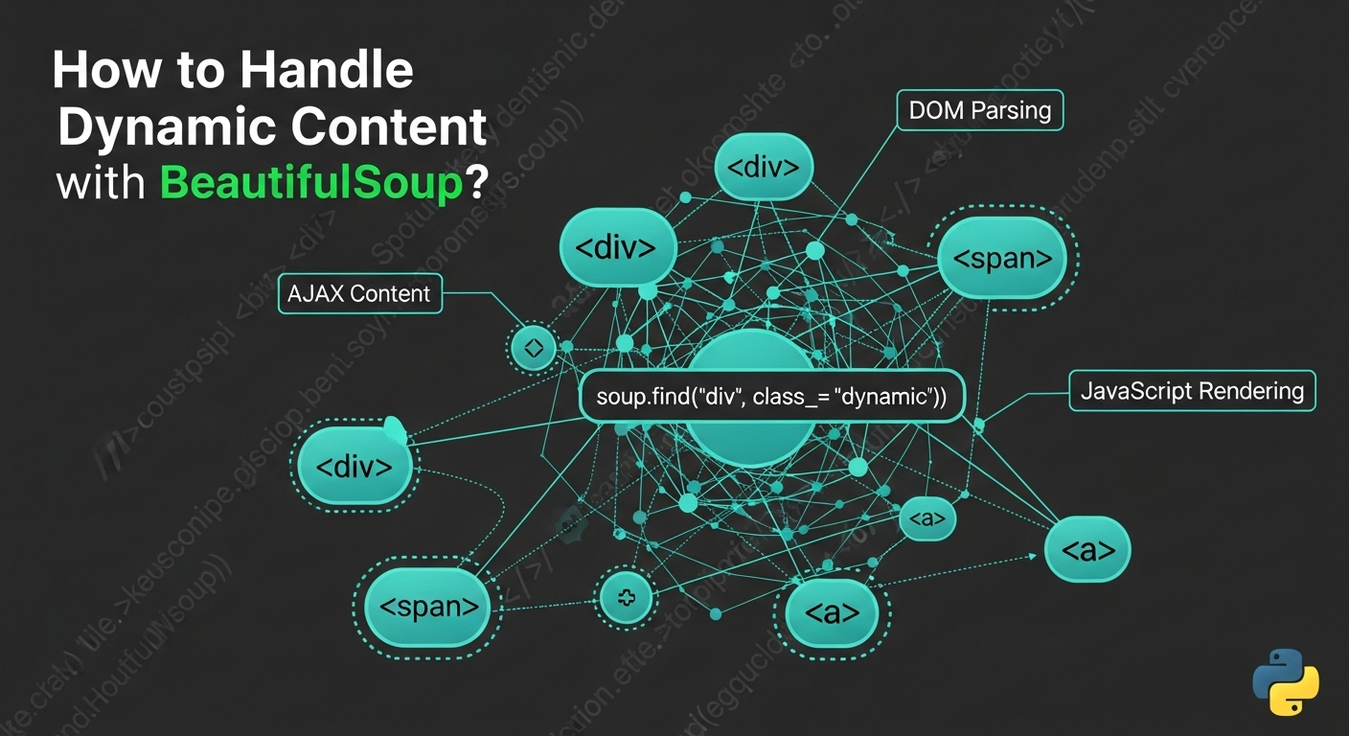

Aprenda a extrair conteúdo dinâmico com BeautifulSoup usando Selenium, Playwright, Requests-HTML, Splash ou APIs de Web Scraping. Guia abrangente com exemplos de código e melhores práticas.

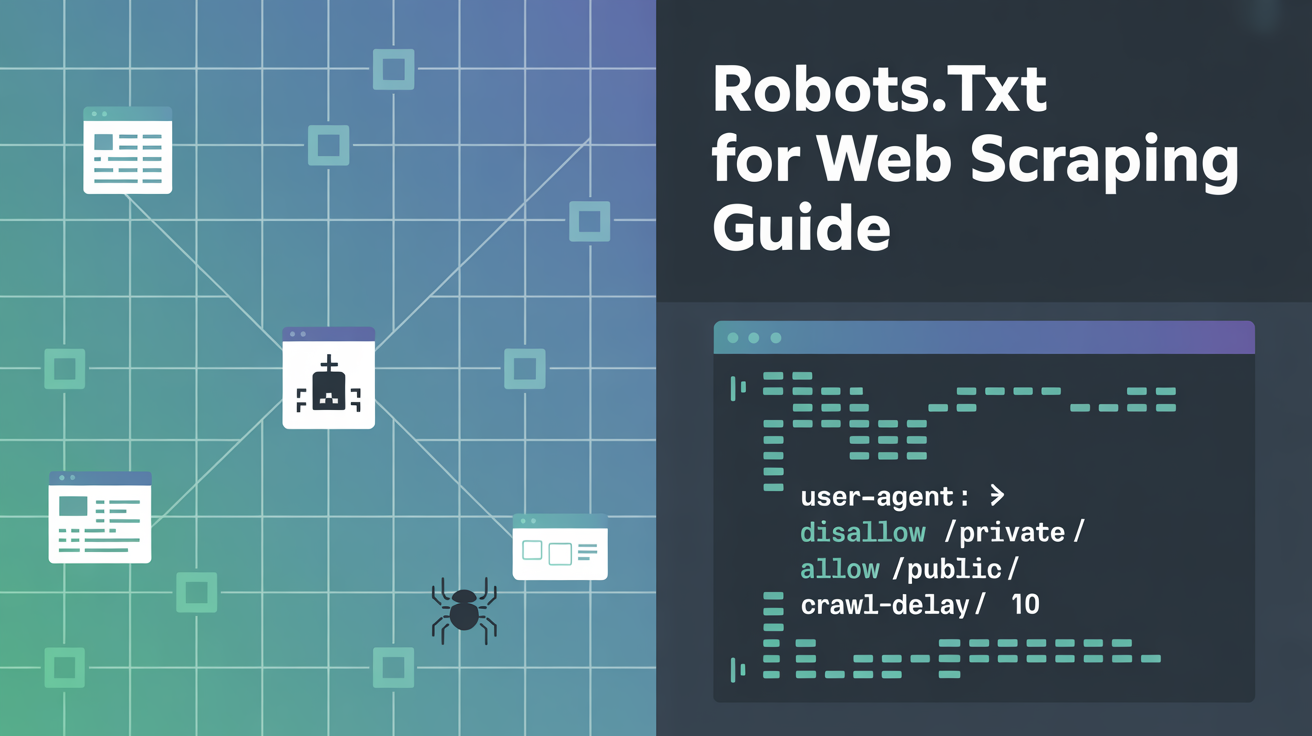

Aprenda a lidar com Robots.txt para web scraping com 10 soluções práticas. Este guia abrange código Python, ferramentas e dicas de conformidade do Scrapeless.

Desbloqueie o poder do web scraping com HTML com este tutorial abrangente. Aprenda 10 soluções detalhadas, desde BeautifulSoup até Playwright, e descubra como o Scrapeless simplifica a extração de dados. Essencial para desenvolvedores e empresas.