Top 5 API trích xuất dữ liệu web tốt nhất năm 2025

Advanced Data Extraction Specialist

Một API thu thập dữ liệu web là một công cụ mạnh mẽ được thiết kế để tự động hóa việc trích xuất dữ liệu từ các trang web trên internet. Mục đích chính của nó là giúp các doanh nghiệp, nhà nghiên cứu và nhà phát triển thu thập và sắp xếp thông tin có giá trị từ nhiều nguồn trực tuyến khác nhau. Các API này rất cần thiết để xử lý hiệu quả khối lượng lớn dữ liệu web, đảm bảo rằng các tổ chức có thể truy cập vào những hiểu biết chính xác và có liên quan mà không cần can thiệp thủ công.

Bất kể trường hợp sử dụng cụ thể của bạn để trích xuất dữ liệu là gì, chúng tôi đã biên soạn một danh sách các API thu thập dữ liệu web tốt nhất hiện nay. Mỗi API đã được đánh giá kỹ lưỡng dựa trên các tính năng, hiệu quả chi phí và hiệu suất tổng thể. Cho dù bạn đang tìm cách nâng cao SEO, sắp xếp hợp lý quy trình thu thập dữ liệu của mình hay thực hiện nghiên cứu toàn diện, các API thu thập dữ liệu web này đều được trang bị để đáp ứng nhu cầu của bạn.

Trình thu thập dữ liệu web tốt nhất năm 2025

- Scrapeless – trình thu thập web tổng thể tốt nhất

- Scrapy – trình thu thập nguồn mở nâng cao

- DYNO Mapper – trình thu thập dữ liệu trực quan tập trung vào SEO

- Oncrawl – trình thu thập dữ liệu web SEO kỹ thuật

- Node Crawler – trình thu thập dữ liệu web dựa trên JavaScript

Bây giờ, hãy cùng tìm hiểu lý do tại sao các nhà cung cấp API thu thập dữ liệu web này nổi bật và tại sao bạn nên xem xét chúng cho nhu cầu thu thập dữ liệu web của mình.

Scrapeless

API Trình thu thập dữ liệu web của Scrapeless được thiết kế để trích xuất hiệu quả dữ liệu có liên quan từ các trang web mục tiêu. Nó tự động duyệt web để thu thập thông tin chính xác bạn cần. Bằng cách kết hợp công nghệ AI Agent và tích hợp Browserless, Scrapeless tạo ra một công cụ thu thập dữ liệu web mạnh mẽ mà không cần mã hóa thủ công. AI Agent tăng cường quá trình thu thập dữ liệu bằng cách tối ưu hóa các tác vụ thu thập dữ liệu, trong khi Browserless xử lý hoạt động trình duyệt không có đầu, đảm bảo thu thập dữ liệu mượt mà từ các trang web động.

Với trình thu thập web của Scrapeless, người dùng có toàn quyền kiểm soát chiến lược và phạm vi thu thập dữ liệu của mình. Phương pháp thu thập dữ liệu theo dõi các liên kết từ một trang bắt đầu, đi qua tất cả các trang có thể truy cập của một trang web cho đến khi mọi trang đều được lập chỉ mục.

Ưu điểm:

- Tỷ lệ thành công cao: Cung cấp trích xuất dữ liệu chính xác và đáng tin cậy với lỗi tối thiểu.

- Khả năng mở rộng: Xử lý hiệu quả việc thu thập dữ liệu quy mô lớn, phù hợp với các trang web rộng lớn.

- Tính năng được hỗ trợ bởi AI: Tận dụng trí tuệ nhân tạo để nâng cao hiệu quả của các tác vụ thu thập dữ liệu web.

- Tích hợp Browserless: Sử dụng công nghệ duyệt web không có đầu để thu thập dữ liệu từ các trang web động và nặng JavaScript một cách liền mạch.

- Thu thập dữ liệu có đạo đức: Tuân theo các thực tiễn tốt nhất trong việc thu thập dữ liệu để đảm bảo hoạt động có đạo đức và tuân thủ.

Nhược điểm:

- Đường cong học tập: Người dùng mới có thể cần thời gian để hiểu đầy đủ và sử dụng tất cả các tính năng nâng cao của Scrapeless.

Giá:

- Phiên bản dùng thử miễn phí

Làm thế nào để có được bản dùng thử miễn phí của Scrapeless?

Để có được bản dùng thử miễn phí của Scrapeless, chỉ cần đăng nhập vào Scrapeless bảng điều khiển. Sau khi đăng nhập, bạn sẽ tìm thấy tùy chọn yêu cầu dùng thử miễn phí trực tiếp từ bảng điều khiển. Đó là một quy trình dễ dàng và đơn giản, cho phép bạn bắt đầu sử dụng công cụ ngay lập tức.

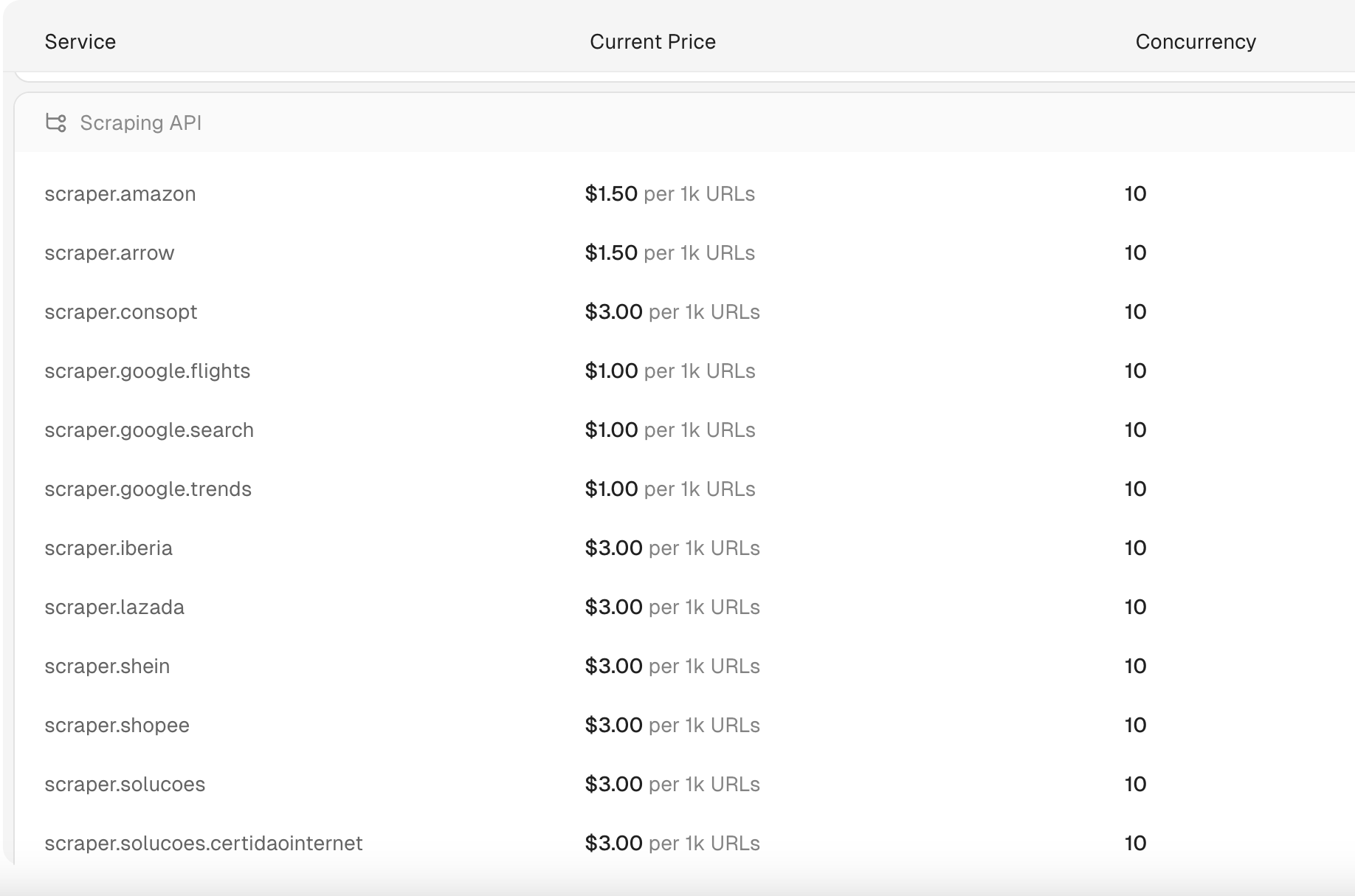

API Thu thập dữ liệu của Scrapeless có giá bao nhiêu?

API Thu thập dữ liệu của Scrapeless bắt đầu từ 1 đô la cho 1.000 URL. Ngoài ra, Scrapeless cung cấp một trong những API SERP giá cả phải chăng và nhanh nhất hiện có, với các truy vấn tìm kiếm được xử lý chỉ trong 1-2 giây. Giá cho các truy vấn tìm kiếm này thấp tới 0,30 đô la cho 1.000 truy vấn, làm cho nó trở thành một trong những giải pháp hiệu quả nhất trên thị trường.

Lưu ý:

- Phí được áp dụng trên cơ sở mỗi yêu cầu.

- Chỉ các yêu cầu thành công mới được tính phí.

Làm thế nào để sử dụng API Thu thập dữ liệu của Scrapeless để lấy dữ liệu Shopee?

Để sử dụng API Thu thập dữ liệu của Scrapeless để thu thập dữ liệu Shopee, bạn thường cần làm theo các bước sau. Hãy nhớ rằng việc thu thập dữ liệu web có thể liên quan đến các vấn đề pháp lý và đạo đức, vì vậy hãy đảm bảo xem xét Điều khoản dịch vụ của Shopee và đảm bảo tuân thủ các luật hiện hành.

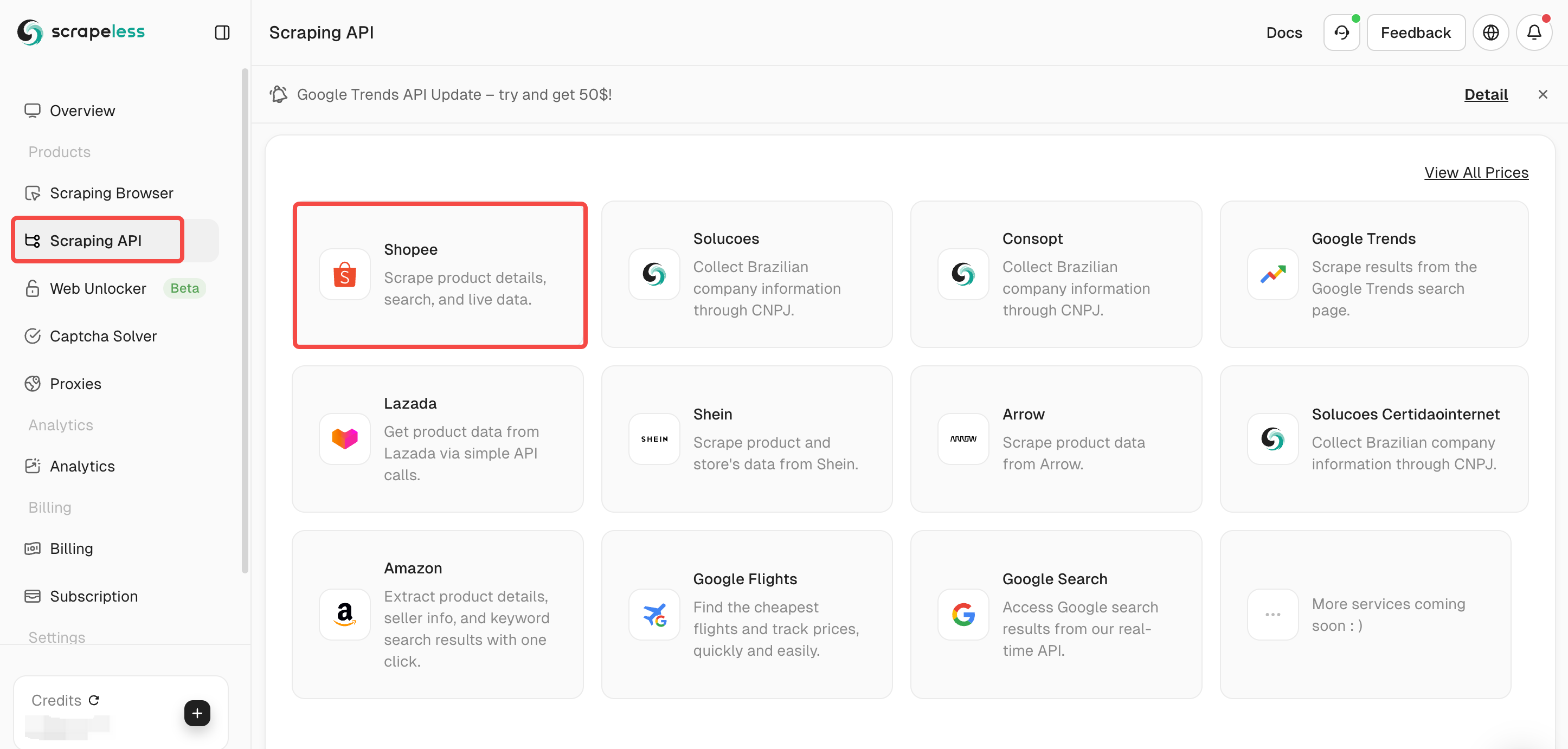

Bước 1. Đăng ký API Scrapeless

Vui lòng đăng nhập vào tài khoản Scrapeless của bạn. Sau khi đăng nhập, bạn sẽ nhận được một khóa API.

Bước 2. Chọn gói thu thập dữ liệu của bạn

Chọn API Thu thập dữ liệu trên bảng điều khiển, sau đó chọn Shopee.

Scrapeless cung cấp nhiều API thu thập dữ liệu, chẳng hạn như Lazada /Shein /Tìm kiếm Google/Chuyến bay Google.

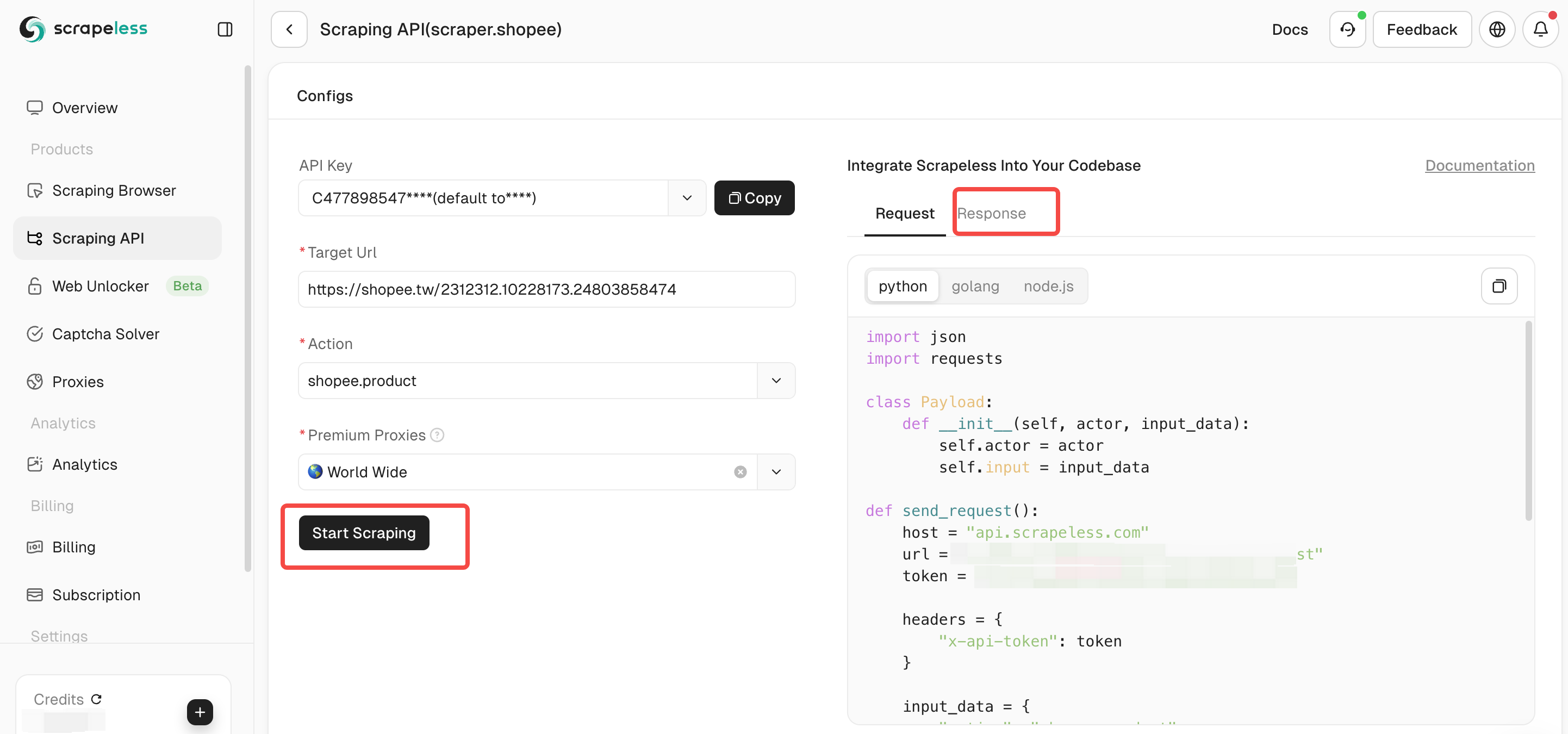

Bước 3. Cấu hình các tham số của API Thu thập dữ liệu Shopee của bạn. Sau đó nhấp vào “Bắt đầu thu thập dữ liệu” và bạn có thể xem dữ liệu kết quả đầu ra ở bảng bên phải.

Làm thế nào để tích hợp Scrapeless vào dự án của bạn?

Để tích hợp Scrapeless vào dự án của bạn, bạn có thể cải thiện hiệu quả thu thập dữ liệu của mình một cách hiệu quả. Scrapeless thường được sử dụng cho các tác vụ thu thập dữ liệu web và trích xuất dữ liệu. Sau đây là một ví dụ về mã để tích hợp Scrapeless vào dự án của bạn. Tất nhiên, bạn cũng có thể xem tài liệu hoàn chỉnh của Scrapeless:

Sản phẩm Shopee

import http.client

import json

conn = http.client.HTTPSConnection("api.scrapeless.com")

payload = json.dumps({

"actor": "scraper.shopee",

"input": {

"action": "shopee.product",

"url": "https://shopee.tw/api/v4/pdp/get_pc?item_id=1413075726&shop_id=19675194"

}

})

headers = {

'Content-Type': 'application/json'

}

conn.request("POST", "/api/v1/scraper/request", payload, headers)

res = conn.getresponse()

data = res.read()

print(data.decode("utf-8"))Tìm kiếm Shopee

import http.client

import json

conn = http.client.HTTPSConnection("api.scrapeless.com")

payload = json.dumps({

"actor": "scraper.shopee",

"input": {

"action": "shopee.product",

"url": "https://shopee.tw/api/v4/pdp/get_pc?item_id=1413075726&shop_id=19675194"

}

})

headers = {

'Content-Type': 'application/json'

}

conn.request("POST", "/api/v1/scraper/request", payload, headers)

res = conn.getresponse()

data = res.read()

print(data.decode("utf-8"))Trực tiếp Shopee

import http.client

import json

conn = http.client.HTTPSConnection("api.scrapeless.com")

payload = json.dumps({

"actor": "scraper.shopee",

"input": {

"action": "shopee.live",

"url": "https://live.shopee.co.th/api/v1/session/{sessionId}"

}

})

headers = {

'Content-Type': 'application/json'

}

conn.request("POST", "/api/v1/scraper/request", payload, headers)

res = conn.getresponse()

data = res.read()

print(data.decode("utf-8"))Shopee Rcmd

import http.client

import json

conn = http.client.HTTPSConnection("api.scrapeless.com")

payload = json.dumps({

"actor": "scraper.shopee",

"input": {

"action": "shopee.rcmd",

"url": "https://shopee.co.th/api/v4/shop/rcmd_items?bundle=shop_page_category_tab_main&item_card_use_scene=category_product_list_topsales&limit=30&offset=0&shop_id=1195212398&sort_type=13&upstream="

}

})

headers = {

'Content-Type': 'application/json'

}

conn.request("POST", "/api/v1/scraper/request", payload, headers)

res = conn.getresponse()

data = res.read()

print(data.decode("utf-8"))Đánh giá Shopee

import http.client

import json

conn = http.client.HTTPSConnection("api.scrapeless.com")

payload = json.dumps({

"actor": "scraper.shopee",

"input": {

"action": "shopee.ratings",

"url": "https://shopee.ph/api/v2/item/get_ratings?exclude_filter=1&filter=0&filter_size=0&flag=1&fold_filter=0&itemid=23760784194&limit=6&offset=0&relevant_reviews=false&request_source=2&shopid=29975023&tag_filter=&type=0&variation_filters="

}

})

headers = {

'Content-Type': 'application/json'

}

conn.request("POST", "/api/v1/scraper/request", payload, headers)

res = conn.getresponse()

data = res.read()

print(data.decode("utf-8"))Scrapy

Scrapy là một framework thu thập dữ liệu web nguồn mở phổ biến được xây dựng bằng Python, được thiết kế để tạo điều kiện cho việc thu thập dữ liệu web và trích xuất dữ liệu thông qua các API thu thập dữ liệu web. Nó cung cấp cho các nhà phát triển các công cụ để xây dựng các trình thu thập dữ liệu mạnh mẽ, có khả năng mở rộng bằng cách tận dụng một hệ thống được tổ chức tốt tập trung vào "spider"—các đơn vị thu thập dữ liệu tự chứa với các hướng dẫn cụ thể để nhắm mục tiêu dữ liệu.

Theo nguyên tắc "đừng lặp lại chính mình" (DRY), Scrapy thúc đẩy khả năng tái sử dụng mã, làm cho nó trở thành một lựa chọn hiệu quả để mở rộng các hoạt động thu thập dữ liệu quy mô lớn. Nhờ tính linh hoạt của mình, Scrapy được các nhà phát triển và nhà khoa học dữ liệu ưa chuộng khi làm việc với các tác vụ thu thập dữ liệu nâng cao.

Ưu điểm:

- Thư viện thu thập dữ liệu nguồn mở: Có sẵn miễn phí theo giấy phép BSD, với sự đóng góp từ một cộng đồng năng động.

- Lý tưởng cho các nhà phát triển và nhà khoa học dữ liệu: Cung cấp các tùy chọn tùy chỉnh mạnh mẽ và kiểm soát đầy đủ quá trình thu thập dữ liệu.

Nhược điểm:

- Thách thức đối với người mới bắt đầu: Yêu cầu hiểu biết vững chắc về Python và các khái niệm thu thập dữ liệu web, điều này có thể là rào cản đối với những người mới trong lĩnh vực này.

- Ngốn nhiều tài nguyên: Có thể tiêu tốn nhiều tài nguyên hệ thống, đặc biệt là khi xử lý các dự án thu thập dữ liệu quy mô lớn.

- Không thân thiện lắm với người mới: Sự phức tạp và nhu cầu về chuyên môn lập trình có thể làm choáng ngợp những người mới bắt đầu thu thập dữ liệu web.

Giá:

- Miễn phí

Bạn có thể cần: Làm thế nào để giải quyết các thách thức thu thập dữ liệu web - Hướng dẫn đầy đủ năm 2025

DYNO Mapper

DYNO Mapper là một trình tạo sơ đồ trang web trực quan trực quan, thu thập dữ liệu các trang web bằng cách theo dõi các liên kết nội bộ, bắt chước hành vi của bot công cụ tìm kiếm. Sau khi thu thập dữ liệu, nó tạo ra một sơ đồ trang web trực quan thể hiện cấu trúc của trang web, giúp người dùng hiểu rõ hơn về điều hướng trang web. Công cụ hỗ trợ nhiều định dạng đầu ra, bao gồm sơ đồ trang web trực quan tương tác, HTML, CSV, XML, PDF, JSON và Excel (XLSX). Ngoài chức năng sơ đồ trang web, DYNO Mapper còn cung cấp khả năng kiểm kê và kiểm toán nội dung, cùng với kiểm tra khả năng truy cập để đảm bảo tuân thủ các tiêu chuẩn trang web ADA. Nó cũng tích hợp liền mạch với các API thu thập dữ liệu web để đáp ứng nhu cầu trích xuất dữ liệu nâng cao, làm cho nó trở thành một trong những trình thu thập dữ liệu web tốt nhất để quản lý nội dung.

Ưu điểm:

- Nhiều định dạng đầu ra: Cung cấp sự linh hoạt bằng cách cung cấp dữ liệu ở nhiều định dạng, nâng cao khả năng sử dụng thông tin.

- Công cụ kiểm kê và kiểm toán nội dung: Giúp sắp xếp hợp lý việc tổ chức và tối ưu hóa nội dung trang web để có hiệu suất tốt hơn.

Nhược điểm:

- Giới hạn kế hoạch miễn phí: Kế hoạch miễn phí có các tính năng bị hạn chế, có thể không đáp ứng nhu cầu của tất cả người dùng.

- Phức tạp để thành thạo: Yêu cầu thời gian và công sức để hiểu đầy đủ và sử dụng tất cả các tính năng nâng cao của nó.

Giá:

- Có bản dùng thử miễn phí, với gói giá cả phải chăng nhất bắt đầu từ 39 đô la/tháng.

Oncrawl

Oncrawl là một công cụ thu thập dữ liệu web mạnh mẽ được thiết kế dành cho phân tích SEO và trang web kỹ thuật. Nó cung cấp các bản kiểm toán SEO chi tiết, bảng điều khiển có thể tùy chỉnh và các giải pháp có thể mở rộng cho các trang web quy mô lớn, làm cho nó trở thành một nguồn tài nguyên quan trọng cho bất kỳ chiến lược tiếp thị kỹ thuật số nào. Là một trong những trình thu thập dữ liệu web tốt nhất, Oncrawl cho phép các doanh nghiệp phân tích và cải thiện sự hiện diện trực tuyến của họ một cách hiệu quả. Ngoài ra, nó tích hợp với các API thu thập dữ liệu web để tăng cường khả năng trích xuất dữ liệu.

Ưu điểm:

- Kiểm toán SEO kỹ lưỡng: Cung cấp cái nhìn sâu sắc toàn diện về hiệu suất SEO của trang web của bạn.

- Bảng điều khiển và báo cáo có thể tùy chỉnh: Người dùng có thể cá nhân hóa báo cáo và bảng điều khiển để đáp ứng các yêu cầu cụ thể của họ.

Nhược điểm:

- Kiểm soát thu thập dữ liệu hạn chế đối với các trang web nhỏ hơn: Có thể không cung cấp nhiều tính linh hoạt trong cài đặt thu thập dữ liệu cho các trang web nhỏ hơn.

- Đường cong học tập dốc: Yêu cầu thời gian để nắm bắt đầy đủ và tận dụng tất cả các tính năng của Oncrawl.

Giá:

- Bắt đầu từ 69 đô la/tháng

Node Crawler

Node Crawler là một thư viện thu thập dữ liệu web phổ biến được thiết kế cho Node.js, được công nhận rộng rãi về tính linh hoạt và dễ sử dụng. Bằng cách sử dụng Cheerio làm trình phân tích cú pháp mặc định, nó cung cấp phân tích cú pháp và thao tác HTML nhanh chóng và hiệu quả. Thư viện cung cấp nhiều tùy chọn tùy chỉnh, chẳng hạn như quản lý hàng đợi để xử lý đồng thời, giới hạn tốc độ và thử lại tự động, làm cho nó trở thành một công cụ mạnh mẽ cho các dự án thu thập dữ liệu web.

Nhờ bản chất nhẹ của nó, Node Crawler đảm bảo mức tiêu thụ bộ nhớ tối thiểu, làm cho nó lý tưởng cho các tác vụ hiệu suất cao, ngay cả khi xử lý khối lượng lớn các yêu cầu. Là một trong những trình thu thập dữ liệu web tốt nhất cho các nhà phát triển Node.js, nó tích hợp hoàn hảo vào quy trình làm việc dựa trên JavaScript và cho phép sử dụng liền mạch các API thu thập dữ liệu web.

Ưu điểm:

- Hoàn hảo cho các nhà phát triển Node.js: Tích hợp dễ dàng vào môi trường JavaScript, làm cho nó trở thành lựa chọn hàng đầu cho các nhà phát triển quen thuộc với Node.js.

- Hiệu quả và nhẹ: Được thiết kế với hiệu suất là ưu tiên hàng đầu, đảm bảo sử dụng bộ nhớ thấp trong quá trình hoạt động, ngay cả khi xử lý nhiều yêu cầu.

Nhược điểm: - Không có khả năng hiển thị JavaScript gốc: Nó không hỗ trợ hiển thị JavaScript theo mặc định, có thể yêu cầu các công cụ hoặc cấu hình bổ sung để thu thập dữ liệu nội dung động.

Giá:

- Miễn phí

So sánh các công cụ thu thập dữ liệu web tốt nhất

| Nhà cung cấp | Tính năng tốt nhất |

|---|---|

| Scrapeless | Cơ sở hạ tầng proxy nâng cao và IP dân cư để thu thập dữ liệu web và thu thập dữ liệu web có thể mở rộng và có đạo đức. |

| Scrapy | Một framework Python nguồn mở mạnh mẽ để xây dựng các trình thu thập dữ liệu và trình thu thập dữ liệu web tùy chỉnh. |

| DYNO Mapper | Tập trung vào việc tạo sơ đồ trang web trực quan và thực hiện kiểm toán SEO để tối ưu hóa và phân tích cấu trúc trang web. |

| Oncrawl | Một trình thu thập dữ liệu web tập trung vào SEO kỹ thuật với phân tích nâng cao cho kiến trúc trang web, ngân sách thu thập dữ liệu và tệp nhật ký. |

| Node Crawler | Một trình thu thập dữ liệu dựa trên JavaScript linh hoạt, được xây dựng trên Node.js, lý tưởng cho các trang web hiện đại với nội dung động. |

Thu thập dữ liệu web là gì?

Thu thập dữ liệu web là một kỹ thuật được sử dụng để tự động trích xuất dữ liệu từ các trang web. Quá trình này bao gồm một số bước chính:

Định nghĩa

Thu thập dữ liệu web, còn được gọi là thu hoạch web hoặc trích xuất dữ liệu web, đề cập đến phương pháp tự động truy xuất và thu thập thông tin từ các trang web. Nó thường liên quan đến việc sử dụng các công cụ phần mềm hoặc các script có thể truy cập internet, tải xuống các trang web và trích xuất dữ liệu cụ thể từ chúng cho nhiều mục đích khác nhau, chẳng hạn như phân tích hoặc lưu trữ trong cơ sở dữ liệu.

Thu thập dữ liệu web hoạt động như thế nào

- Yêu cầu: Quá trình bắt đầu bằng việc gửi yêu cầu đến máy chủ của một trang web, tương tự như việc nhập URL vào trình duyệt.

- Phản hồi: Máy chủ phản hồi bằng cách gửi trang web được yêu cầu, có thể chứa văn bản, hình ảnh và các loại dữ liệu khác.

- Phân tích cú pháp: Sau đó, công cụ thu thập dữ liệu web phân tích nội dung HTML của trang để định vị và trích xuất các điểm dữ liệu cụ thể, chẳng hạn như giá sản phẩm, thông tin liên hệ hoặc các chi tiết có liên quan khác.

- Lưu trữ: Cuối cùng, dữ liệu được trích xuất được lưu ở định dạng có cấu trúc, chẳng hạn như CSV, Excel hoặc cơ sở dữ liệu, để sử dụng sau này.

Ứng dụng của việc thu thập dữ liệu web

Thu thập dữ liệu web có rất nhiều ứng dụng trên nhiều ngành công nghiệp:

- Nghiên cứu thị trường: Thu thập thông tin về giá cả cạnh tranh và sản phẩm.

- Tạo khách hàng tiềm năng: Thu thập thông tin liên hệ cho các nỗ lực bán hàng và tiếp thị.

- Giám sát giá cả: Theo dõi sự thay đổi giá cả của sản phẩm trên các nhà bán lẻ khác nhau.

- Thu thập nội dung: Biên soạn các bài báo tin tức hoặc bài đánh giá sản phẩm từ nhiều nguồn khác nhau.

Sự khác biệt so với thu thập dữ liệu web

Mặc dù thu thập dữ liệu web và thu thập dữ liệu web là những khái niệm liên quan, nhưng chúng phục vụ các mục đích khác nhau. Thu thập dữ liệu web chủ yếu tập trung vào việc khám phá và lập chỉ mục các trang web bằng cách theo dõi các liên kết trên toàn bộ internet. Ngược lại, thu thập dữ liệu web cụ thể nhắm mục tiêu việc trích xuất dữ liệu từ các trang đó sau khi chúng đã được truy cập.

Kết luận

Tóm lại, việc chọn API thu thập dữ liệu web phù hợp là rất quan trọng đối với các doanh nghiệp và nhà phát triển đang tìm cách trích xuất và tận dụng dữ liệu có giá trị từ web. 5 API thu thập dữ liệu web tốt nhất năm 2025 cung cấp một loạt các tính năng đáp ứng các nhu cầu khác nhau—cho dù đó là khả năng mở rộng, dễ sử dụng hay khả năng xử lý dữ liệu nâng cao. Mỗi công cụ này đều có những điểm mạnh riêng, làm cho chúng phù hợp với nhiều ứng dụng, từ tối ưu hóa SEO đến nghiên cứu thị trường và tổng hợp nội dung.

Câu hỏi thường gặp

Các API thu thập dữ liệu web hoạt động như thế nào?

Các API thu thập dữ liệu web hoạt động bằng cách gửi yêu cầu đến các trang web mục tiêu thay mặt người dùng, truy xuất dữ liệu trong khi quản lý các vấn đề phức tạp như xử lý proxy và các biện pháp chống bot. Người dùng có thể truy cập dữ liệu có cấu trúc mà không cần phải phát triển các trình thu thập dữ liệu tùy chỉnh.

Tôi có thể thử các API thu thập dữ liệu web này trước khi cam kết không?

Hầu hết các API thu thập dữ liệu web hàng đầu đều cung cấp các bản dùng thử miễn phí hoặc các mô hình định giá trả theo lượt dùng để cho phép người dùng kiểm tra chức năng và hiệu quả của chúng trước khi thực hiện cam kết tài chính. Ví dụ: Scrapeless cung cấp bản dùng thử miễn phí. Người dùng cũng tham gia thử nghiệm các tính năng mới trên Discord của Scrapeless cũng sẽ nhận được tín dụng có thể được sử dụng trên tất cả các sản phẩm của Scrapeless! 🎉

Tại Scrapless, chúng tôi chỉ truy cập dữ liệu có sẵn công khai trong khi tuân thủ nghiêm ngặt các luật, quy định và chính sách bảo mật trang web hiện hành. Nội dung trong blog này chỉ nhằm mục đích trình diễn và không liên quan đến bất kỳ hoạt động bất hợp pháp hoặc vi phạm nào. Chúng tôi không đảm bảo và từ chối mọi trách nhiệm đối với việc sử dụng thông tin từ blog này hoặc các liên kết của bên thứ ba. Trước khi tham gia vào bất kỳ hoạt động cạo nào, hãy tham khảo ý kiến cố vấn pháp lý của bạn và xem xét các điều khoản dịch vụ của trang web mục tiêu hoặc có được các quyền cần thiết.