Cách nâng cao Crawl4AI với Trình duyệt đám mây Scrapeless

Expert Network Defense Engineer

Trong hướng dẫn này, bạn sẽ tìm hiểu:

- Crawl4AI là gì và những gì nó cung cấp cho việc thu thập dữ liệu web

- Cách tích hợp Crawl4AI với Trình duyệt Scrapeless

Hãy bắt đầu nào!

Phần 1: Crawl4AI là gì?

Tổng quan

Crawl4AI là một công cụ thu thập dữ liệu và crawl web mã nguồn mở được thiết kế để tích hợp một cách liền mạch với các Mô hình Ngôn ngữ Lớn (LLMs), Các đại lý AI và các pipeline dữ liệu. Nó cho phép trích xuất dữ liệu trong thời gian thực với tốc độ cao trong khi vẫn linh hoạt và dễ triển khai.

Các tính năng chính cho thu thập dữ liệu web bằng AI bao gồm:

- Được xây dựng cho LLMs: Tạo ra Markdown có cấu trúc tối ưu cho Tạo ra Tăng cường Lấy dữ liệu (RAG) và tinh chỉnh.

- Kiểm soát trình duyệt linh hoạt: Hỗ trợ quản lý phiên, sử dụng proxy và hook tùy chỉnh.

- Trí tuệ Heuristic: Sử dụng các thuật toán thông minh để tối ưu hóa phân tích dữ liệu.

- Hoàn toàn mã nguồn mở: Không yêu cầu khóa API; có thể triển khai qua Docker và các nền tảng đám mây.

Tìm hiểu thêm trong tài liệu chính thức.

Trường hợp sử dụng

Crawl4AI lý tưởng cho các nhiệm vụ trích xuất dữ liệu quy mô lớn như nghiên cứu thị trường, tập hợp tin tức và thu thập sản phẩm thương mại điện tử. Nó có thể xử lý các trang web động, nhiều JavaScript và phục vụ như một nguồn dữ liệu đáng tin cậy cho các đại lý AI và các pipeline dữ liệu tự động.

Phần 2: Trình duyệt Scrapeless là gì?

Trình duyệt Scrapeless là một công cụ tự động hóa trình duyệt không có máy chủ dựa trên đám mây. Nó được xây dựng trên một kernel Chromium được tùy chỉnh sâu sắc, được hỗ trợ bởi các máy chủ phân phối toàn cầu và mạng proxy. Điều này cho phép người dùng thực hiện và quản lý một số lượng lớn các phiên trình duyệt headless một cách liền mạch, giúp dễ dàng xây dựng các ứng dụng AI và các đại lý AI tương tác với web ở quy mô lớn.

Phần 3: Tại sao kết hợp Scrapeless với Crawl4AI?

Crawl4AI xuất sắc trong việc trích xuất dữ liệu web có cấu trúc và hỗ trợ phân tích dựa trên LLM và thu thập dữ liệu dựa trên mẫu. Tuy nhiên, nó vẫn có thể gặp khó khăn khi đối phó với các cơ chế chống bot tiên tiến, chẳng hạn như:

- Các trình duyệt cục bộ bị chặn bởi Cloudflare, AWS WAF, hoặc reCAPTCHA

- Tắc nghẽn hiệu suất trong quá trình thu thập đồng thời quy mô lớn, với khởi động trình duyệt chậm

- Quy trình gỡ lỗi phức tạp khiến việc theo dõi vấn đề trở nên khó khăn

Trình duyệt đám mây Scrapeless giải quyết những vấn đề này một cách hoàn hảo:

- Bỏ qua chống bot một cú nhấp chuột: Tự động xử lý reCAPTCHA, Cloudflare Turnstile/Challenge, AWS WAF, và nhiều hơn nữa. Kết hợp với sức mạnh trích xuất có cấu trúc của Crawl4AI, nó làm tăng đáng kể tỷ lệ thành công.

- Mở rộng đồng thời không giới hạn: Khởi chạy 50–1000+ phiên trình duyệt cho mỗi nhiệm vụ trong vài giây, loại bỏ giới hạn hiệu suất thu thập cục bộ và tối đa hóa hiệu quả của Crawl4AI.

- Giảm chi phí 40%–80%: So với các dịch vụ đám mây tương tự, tổng chi phí giảm chỉ còn 20%–60%. Giá theo mức sử dụng làm cho nó trở nên hợp lý ngay cả cho các dự án quy mô nhỏ.

- Công cụ gỡ lỗi trực quan: Sử dụng Phát lại phiên và Giám sát URL trực tiếp để theo dõi các nhiệm vụ Crawl4AI trong thời gian thực, nhanh chóng xác định nguyên nhân thất bại và giảm thiểu chi phí gỡ lỗi.

- Tích hợp không tốn kém: Tương thích natively với Playwright (được sử dụng bởi Crawl4AI), chỉ cần một dòng mã để kết nối Crawl4AI với đám mây — không cần phải cải tiến mã.

- Dịch vụ Node Edge (ENS): Nhiều nút toàn cầu mang lại tốc độ khởi động và độ ổn định nhanh hơn 2–3 lần so với các trình duyệt đám mây khác, tăng tốc thực thi Crawl4AI.

- Môi trường cô lập & phiên ổn định: Mỗi hồ sơ Scrapeless chạy trong môi trường riêng với đăng nhập liên tục và cách ly danh tính, ngăn chặn sự can thiệp phiên và cải thiện độ ổn định quy mô lớn.

- Quản lý dấu vân tay linh hoạt: Scrapeless có thể tạo ra dấu vân tay trình duyệt ngẫu nhiên hoặc sử dụng cấu hình tùy chỉnh, giảm thiểu tối đa nguy cơ phát hiện và cải thiện tỷ lệ thành công của Crawl4AI.

Phần 4: Cách sử dụng Scrapeless trong Crawl4AI?

Scrapeless cung cấp dịch vụ trình duyệt đám mây thường trả về một CDP_URL. Crawl4AI có thể kết nối trực tiếp với trình duyệt đám mây sử dụng URL này, mà không cần khởi động trình duyệt cục bộ.

Ví dụ dưới đây minh họa cách tích hợp liền mạch Crawl4AI với Trình duyệt đám mây Scrapeless để thu thập dữ liệu hiệu quả, đồng thời hỗ trợ xoay proxy tự động, dấu vân tay tùy chỉnh, và tái sử dụng hồ sơ.

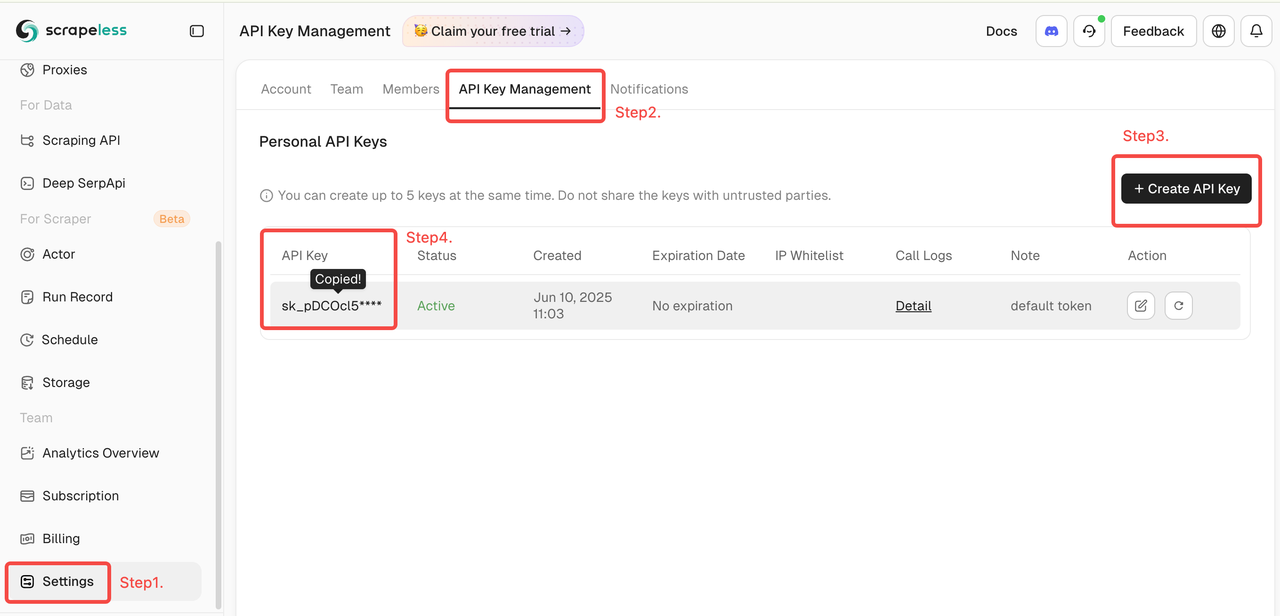

Lấy mã token Scrapeless của bạn

Đăng nhập vào Scrapeless và lấy Mã API của bạn.

1. Bắt Đầu Nhanh

Ví dụ dưới đây cho thấy cách kết nối nhanh chóng và dễ dàng Crawl4AI với Scrapeless Cloud Browser:

Để biết thêm tính năng và hướng dẫn chi tiết, hãy xem giới thiệu.

scrapeless_params = {

"token": "nhận mã của bạn từ https://www.scrapeless.com",

"sessionName": "Trình duyệt Scrapeless",

"sessionTTL": 1000,

}

query_string = urlencode(scrapeless_params)

scrapeless_connection_url = f"wss://browser.scrapeless.com/api/v2/browser?{query_string}"

AsyncWebCrawler(

config=BrowserConfig(

headless=False,

browser_mode="cdp",

cdp_url=scrapeless_connection_url

)

)Sau khi cấu hình, Crawl4AI kết nối với Scrapeless Cloud Browser thông qua chế độ CDP (Chrome DevTools Protocol), cho phép thu thập dữ liệu web mà không cần môi trường trình duyệt cục bộ. Người dùng có thể cấu hình thêm proxy, dấu vân tay, tái sử dụng phiên, và các tính năng khác để đáp ứng các yêu cầu của các kịch bản chống bot phức tạp và nhiều kết nối đồng thời.

2. Xoay Vòng Proxy Tự Động Toàn Cầu

Scrapeless hỗ trợ IP dân cư từ 195 quốc gia. Người dùng có thể cấu hình khu vực mục tiêu bằng cách sử dụng proxycountry, cho phép gửi yêu cầu từ các vị trí cụ thể. Các IP được tự động quay vòng, giúp tránh bị chặn hiệu quả.

import asyncio

from urllib.parse import urlencode

from crawl4ai import CrawlerRunConfig, BrowserConfig, AsyncWebCrawler

async def main():

scrapeless_params = {

"token": "mã của bạn",

"sessionTTL": 1000,

"sessionName": "Demo Proxy",

# Cài đặt quốc gia/khu vực mục tiêu cho proxy, gửi yêu cầu thông qua địa chỉ IP từ khu vực đó. Bạn có thể chỉ định mã quốc gia (ví dụ: US cho Hoa Kỳ, GB cho Vương quốc Anh, ANY cho bất kỳ quốc gia nào). Xem mã quốc gia để biết tất cả các tùy chọn được hỗ trợ.

"proxyCountry": "ANY",

}

query_string = urlencode(scrapeless_params)

scrapeless_connection_url = f"wss://browser.scrapeless.com/api/v2/browser?{query_string}"

async with AsyncWebCrawler(

config=BrowserConfig(

headless=False,

browser_mode="cdp",

cdp_url=scrapeless_connection_url,

)

) as crawler:

result = await crawler.arun(

url="https://www.scrapeless.com/en",

config=CrawlerRunConfig(

wait_for="css:.content",

scan_full_page=True,

),

)

print("-" * 20)

print(f'Mã Trạng Thái: {result.status_code}')

print("-" * 20)

print(f'Tiêu Đề: {result.metadata["title"]}')

print(f'Mô Tả: {result.metadata["description"]}')

print("-" * 20)

asyncio.run(main())3. Dấu Vân Tay Trình Duyệt Tùy Chỉnh

Để mô phỏng hành vi người dùng thực, Scrapeless hỗ trợ tạo ngẫu nhiên các dấu vân tay trình duyệt và cũng cho phép các tham số dấu vân tay tùy chỉnh. Điều này giúp giảm đáng kể nguy cơ bị phát hiện bởi các trang web mục tiêu.

import json

import asyncio

from urllib.parse import quote, urlencode

from crawl4ai import CrawlerRunConfig, BrowserConfig, AsyncWebCrawler

async def main():

# tùy chỉnh dấu vân tay trình duyệt

fingerprint = {

"userAgent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, như Gecko) Chrome/134.1.2.3 Safari/537.36",

"platform": "Windows",

"screen": {

"width": 1280, "height": 1024

},

"localization": {

"languages": ["zh-HK", "en-US", "en"], "timezone": "Châu Á/Hồng Kông",

}

}

fingerprint_json = json.dumps(fingerprint)

encoded_fingerprint = quote(fingerprint_json)

scrapeless_params = {

"token": "mã của bạn",

"sessionTTL": 1000,

"sessionName": "Demo Dấu Vân Tay",

"fingerprint": encoded_fingerprint,

}

query_string = urlencode(scrapeless_params)

scrapeless_connection_url = f"wss://browser.scrapeless.com/api/v2/browser?{query_string}"

async with AsyncWebCrawler(

config=BrowserConfig(

headless=False,

browser_mode="cdp",

cdp_url=scrapeless_connection_url,

)

) as crawler:

result = await crawler.arun(

url="https://www.scrapeless.com/en",

config=CrawlerRunConfig(

wait_for="css:.content",

scan_full_page=True,

),

)

print("-" * 20)

print(f'Mã Trạng Thái: {result.status_code}')

print("-" * 20)

print(f'Tiêu Đề: {result.metadata["title"]}')

print(f'Mô Tả: {result.metadata["description"]}')

print("-" * 20)

asyncio.run(main())4. Tái Sử Dụng Hồ Sơ

Scrapeless gán mỗi hồ sơ một môi trường trình duyệt độc lập, cho phép đăng nhập liên tục và cách ly danh tính. Người dùng chỉ cần cung cấp profileId để sử dụng lại phiên trước đó.

python

import asyncio

from urllib.parse import urlencode

from crawl4ai import CrawlerRunConfig, BrowserConfig, AsyncWebCrawler

async def main():

scrapeless_params = {

"token": "your token",

"sessionTTL": 1000,

"sessionName": "Profile Demo",

"profileId": "your profileId", # tạo hồ sơ trên scrapeless

}

query_string = urlencode(scrapeless_params)

scrapeless_connection_url = f"wss://browser.scrapeless.com/api/v2/browser?{query_string}"

async with AsyncWebCrawler(

config=BrowserConfig(

headless=False,

browser_mode="cdp",

cdp_url=scrapeless_connection_url,

)

) as crawler:

result = await crawler.arun(

url="https://www.scrapeless.com",

config=CrawlerRunConfig(

wait_for="css:.content",

scan_full_page=True,

),

)

print("-" * 20)

print(f'Mã trạng thái: {result.status_code}')

print("-" * 20)

print(f'Tiêu đề: {result.metadata["title"]}')

print(f'Mô tả: {result.metadata["description"]}')

print("-" * 20)

asyncio.run(main())Video

Câu hỏi thường gặp

Q: Làm thế nào để tôi có thể ghi lại và xem quá trình thực thi của trình duyệt?

A: Chỉ cần đặt tham số sessionRecording thành "true". Toàn bộ quá trình thực thi của trình duyệt sẽ được ghi lại tự động. Sau khi phiên kết thúc, bạn có thể phát lại và xem lại toàn bộ hoạt động trong danh sách Lịch sử phiên, bao gồm các cú nhấp, cuộn trang, tải trang và các chi tiết khác. Giá trị mặc định là "false".

scrapeless_params = {

# ...

"sessionRecording": "true",

}Q: Làm thế nào để tôi sử dụng dấu vân tay ngẫu nhiên?

A: Dịch vụ Trình duyệt Scrapeless tự động tạo một dấu vân tay trình duyệt ngẫu nhiên cho mỗi phiên. Người dùng cũng có thể đặt một dấu vân tay tùy chỉnh bằng cách sử dụng trường fingerprint.

Q: Làm thế nào để tôi đặt một proxy tùy chỉnh?

A: Mạng lưới proxy được tích hợp sẵn của chúng tôi hỗ trợ 195 quốc gia/khu vực. Nếu người dùng muốn sử dụng proxy riêng, tham số proxyURL có thể được sử dụng để chỉ định URL proxy, ví dụ: http://user:pass@ip:port.

(Lưu ý: Chức năng proxy tùy chỉnh hiện chỉ khả dụng cho các thuê bao Doanh nghiệp và Doanh nghiệp Plus.)

scrapeless_params = {

# ...

"proxyURL": "proxyURL",

}Tóm tắt

Kết hợp Trình duyệt Đám mây Scrapeless với Crawl4AI cung cấp cho các nhà phát triển một môi trường thu thập dữ liệu web ổn định và có thể mở rộng:

- Không cần cài đặt hoặc duy trì các phiên bản Chrome cục bộ; tất cả các tác vụ chạy trực tiếp trên đám mây.

- Giảm thiểu rủi ro bị chặn và gián đoạn CAPTCHA, vì mỗi phiên được cách ly và hỗ trợ dấu vân tay ngẫu nhiên hoặc tùy chỉnh.

- Cải thiện khả năng gỡ lỗi và tái hiện, với sự hỗ trợ cho việc ghi lại và phát lại phiên tự động.

- Hỗ trợ tự động xoay vòng proxy trên 195 quốc gia/khu vực.

- Sử dụng Dịch vụ Node Edge toàn cầu, cung cấp tốc độ khởi động nhanh hơn so với các dịch vụ tương tự khác.

Sự hợp tác này đánh dấu một cột mốc quan trọng cho Scrapeless và Crawl4AI trong lĩnh vực thu thập dữ liệu web. Tiến tới, Scrapeless sẽ tập trung vào công nghệ trình duyệt đám mây, cung cấp cho các khách hàng doanh nghiệp khả năng trích xuất, tự động hóa và hỗ trợ hạ tầng tác nhân AI hiệu quả, có thể mở rộng. Tận dụng năng lực đám mây mạnh mẽ, Scrapeless sẽ tiếp tục cung cấp các giải pháp tùy chỉnh và theo kịch bản cho các ngành như tài chính, bán lẻ, thương mại điện tử, SEO và tiếp thị, giúp các doanh nghiệp đạt được sự tăng trưởng tự động thực sự trong kỷ nguyên trí tuệ dữ liệu.

Tại Scrapless, chúng tôi chỉ truy cập dữ liệu có sẵn công khai trong khi tuân thủ nghiêm ngặt các luật, quy định và chính sách bảo mật trang web hiện hành. Nội dung trong blog này chỉ nhằm mục đích trình diễn và không liên quan đến bất kỳ hoạt động bất hợp pháp hoặc vi phạm nào. Chúng tôi không đảm bảo và từ chối mọi trách nhiệm đối với việc sử dụng thông tin từ blog này hoặc các liên kết của bên thứ ba. Trước khi tham gia vào bất kỳ hoạt động cạo nào, hãy tham khảo ý kiến cố vấn pháp lý của bạn và xem xét các điều khoản dịch vụ của trang web mục tiêu hoặc có được các quyền cần thiết.