Como obter dados de produtos do Arrow.com?

Senior Web Scraping Engineer

Arrow.com é uma plataforma global líder especializada em componentes eletrônicos, soluções tecnológicas e serviços. Atende a engenheiros, fabricantes e empresas, fornecendo um catálogo abrangente de semicondutores, conectores e soluções embarcadas. Com seu vasto inventário e recursos técnicos, Arrow.com serve como um hub vital para a aquisição, prototipagem e escalonamento de projetos tecnológicos.

Por que é importante raspar dados de produtos da Arrow?

Seus dados possuem imenso valor para várias partes interessadas nas indústrias de eletrônicos e tecnologia. Então, por que eles são importantes? Vamos descobrir agora:

- Informações completas do produto: A Arrow apresenta especificações detalhadas para milhões de componentes, ajudando os engenheiros a selecionar as peças certas para seus projetos.

- Monitoramento de preços: O acesso aos dados de preços permite que as empresas comparem custos e tomem decisões de compra informadas.

- Insights sobre a disponibilidade de estoque: Atualizações em tempo real sobre os níveis de estoque ajudam a prevenir interrupções na cadeia de suprimentos.

- Tendências e análises de mercado: Os dados da Arrow podem revelar tendências na demanda por tecnologias específicas, auxiliando na pesquisa e previsão de mercado.

- Avaliação de fornecedores: As empresas podem avaliar fornecedores com base na variedade de produtos, preço e disponibilidade.

Como raspar a Arrow usando o Puppeteer

- Etapa 1: Instale o Puppeteer via

npmpara configurar seu projeto:

Bash

npm install puppeteer- Etapa 2: Inicialize o Puppeteer. Crie um novo arquivo JavaScript (por exemplo,

scrapeArrow.js) e inclua o código a seguir para iniciar o Puppeteer:

JavaScript

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Defina um agente de usuário para imitar um navegador real

await page.setUserAgent(

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/114.0.0.0 Safari/537.36'

);

console.log('Navegador iniciado com sucesso');

})();- Etapa 3: Navegue para Arrow.com. Adicione o código para abrir a página de pesquisa da Arrow com uma consulta específica:

JavaScript

const searchQuery = 'resistor'; // Substitua pelo termo que você deseja pesquisar

const url = `https://www.arrow.com/en/products/search?q=${encodeURIComponent(searchQuery)}`;

await page.goto(url, { waitUntil: 'networkidle2' });

console.log(`Navegou para: ${url}`);- Etapa 4: Aguardar o carregamento dos elementos da página. Garanta que a página seja totalmente carregada aguardando que os elementos do produto apareçam:

JavaScript

await page.waitForSelector('.product-card'); // Substitua '.product-card' pelo seletor CSS correto

console.log('Elementos do produto carregados com sucesso');- Etapa 5: Extrair dados do produto. Use o método

evaluatedo Puppeteer para raspar nomes de produtos, preços e disponibilidade:

JavaScript

const products = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.product-card')).map(item => {

const name = item.querySelector('.product-name')?.innerText || 'N/A';

const price = item.querySelector('.product-price')?.innerText || 'N/A';

const availability = item.querySelector('.availability-status')?.innerText || 'N/A';

return { name, price, availability };

});

});

console.log(products);- Etapa 6: Fechar o navegador. Após raspar os dados, feche o navegador para liberar recursos:

JavaScript

await browser.close();

console.log('Navegador fechado com sucesso');- Script final:

JavaScript

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

await page.setUserAgent(

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/114.0.0.0 Safari/537.36'

);

const searchQuery = 'resistor';

const url = `https://www.arrow.com/en/products/search?q=${encodeURIComponent(searchQuery)}`;

await page.goto(url, { waitUntil: 'networkidle2' });

console.log(`Navegou para: ${url}`);

await page.waitForSelector('.product-card');

const products = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.product-card')).map(item => {

const name = item.querySelector('.product-name')?.innerText || 'N/A';

const price = item.querySelector('.product-price')?.innerText || 'N/A';

const availability = item.querySelector('.availability-status')?.innerText || 'N/A';

return { name, price, availability };

});

});

console.log(products);

await browser.close();

})();O raspador Puppeteer não é suficiente! Você precisará contornar a detecção anti-bot, como: impressão digital do navegador, CAPTCHA e limitação de taxa. Além disso, a maioria dos sites está implementando métodos de carregamento dinâmico, o que é difícil para seu projeto superar.

Existe alguma maneira mais poderosa e eficaz de raspar detalhes do produto Arrow?

Sim! A API de raspagem fornecerá uma experiência de raspagem mais estável!

API Scrapeless Arrow - O melhor raspador de detalhes de produtos Arrow

A API Scrapeless é uma solução inovadora projetada para simplificar o processo de extração de dados de sites. Nossa API foi projetada para navegar pelos ambientes web mais complexos e gerenciar efetivamente o conteúdo dinâmico e a renderização de JavaScript.

Usando nossa API avançada de raspagem Arrow, você pode acessar os dados do produto de que precisa sem escrever ou manter scripts de raspagem complexos. São necessárias apenas algumas etapas simples para acessar e raspar facilmente as informações de que você precisa.

Como podemos implantar a API Arrow? Siga estas etapas:

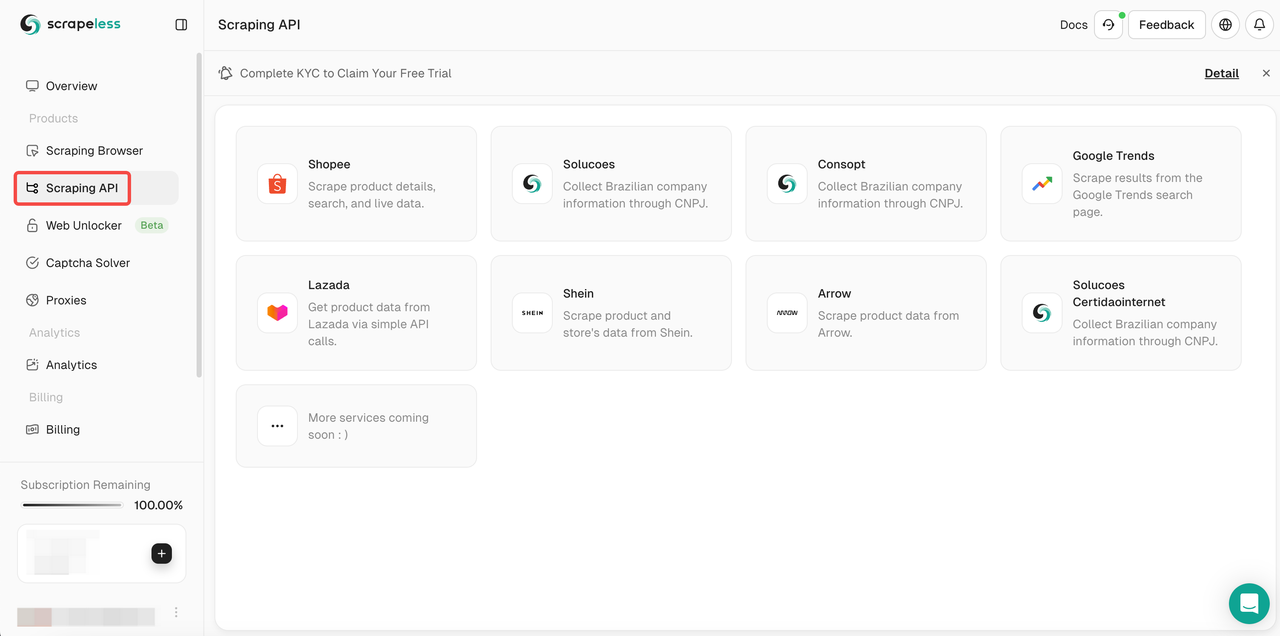

- Etapa 1. Faça login em Scrapeless

- Etapa 2. Clique em "API de Raspagem"

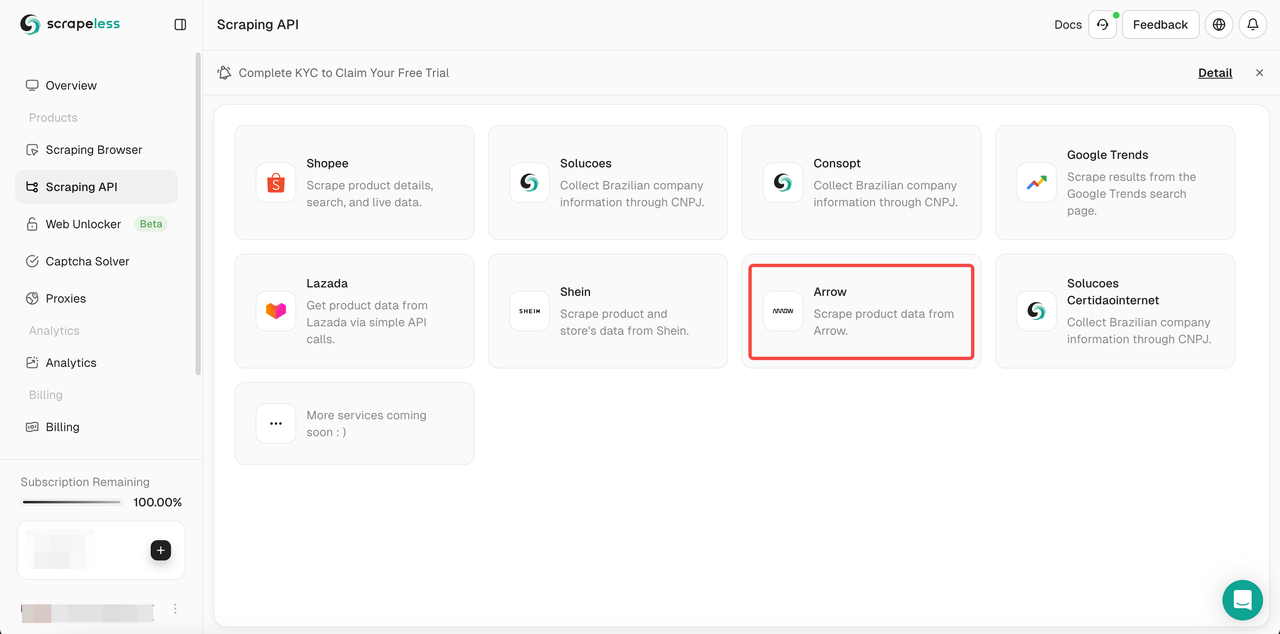

- Etapa 3. Clique na API Arrow e entre na página de edição.

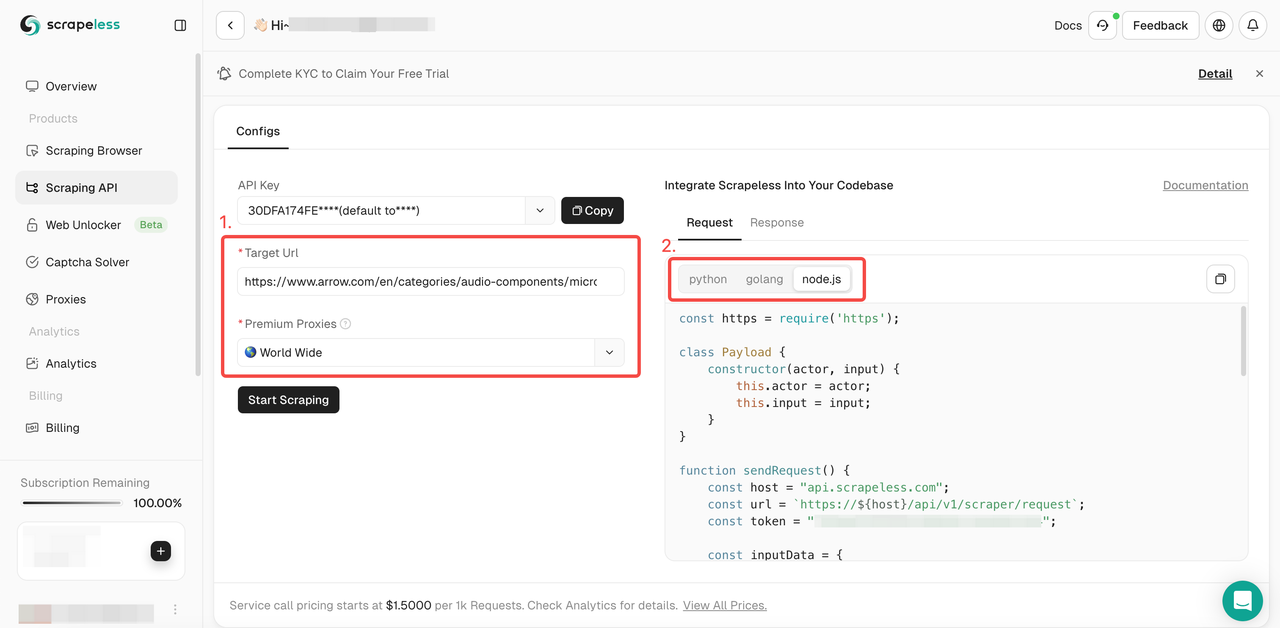

- Etapa 4. Cole o URL da página do produto que você precisa rastrear e configure a região de destino do proxy. Aqui, usamos a página do produto "microfones" da Arrow como exemplo e configuramos o proxy para ser a Índia. Em seguida, selecione o idioma de exibição que precisamos entre

Python,GolangeNodeJS. Usaremos Python como exemplo.

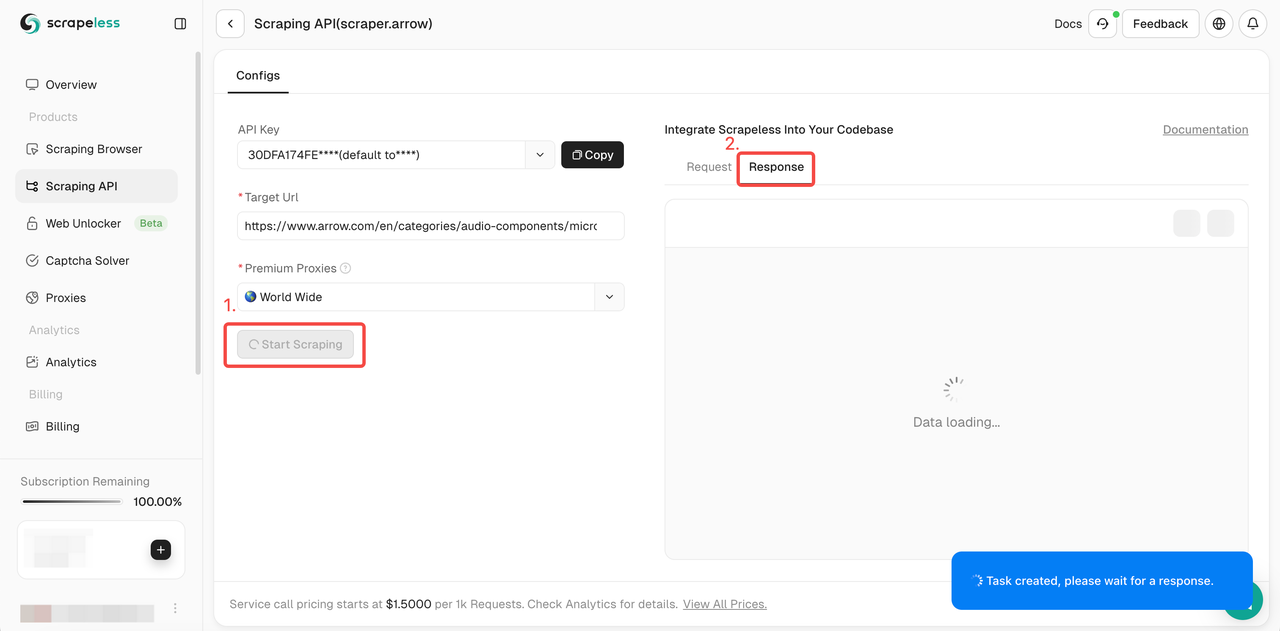

- Etapa 5. Após a configuração, clique em "Iniciar Raspagem" e você receberá a resposta à direita:

- Resultado da raspagem:

Python

{

"data": "H4sIAAAAAAAA/6rm5VJQUEpJLElUslLIK83J0QELpBYV5RdBRXi5agEBAAD//0dMMnUmAAAA"

}Ou você pode implantar nossos códigos de exemplo em seu próprio projeto:

Python

import requests

import json

url = "https://api.scrapeless.com/api/v1/scraper/request"

payload = json.dumps({

"actor": "scraper.arrow",

"input": {

"url": "https://www.arrow.com/en/products/search?page=3&cat=Capacitors"

}

})

headers = {

'Content-Type': 'application/json'

}

response = requests.request("POST", url, headers=headers, data=payload)

print(response.text)Por que usar uma API de raspagem para Arrow?

A Arrow nem sempre fornece APIs públicas para acessar todos os seus dados. No entanto, a API de raspagem Scrapeless Arrow pode fornecer:

- Automação: Economize tempo e reduza o trabalho manual.

- Dados abrangentes: Obtenha dados que podem não estar disponíveis por meios oficiais.

- Personalização: Adapte os dados extraídos para atender às suas necessidades específicas.

- Integração: Use os dados perfeitamente em plataformas de análise, CRMs ou ferramentas de gerenciamento de estoque.

Considerações finais

Os detalhes dos produtos em arrow.com são importantes para nós para Monitoramento de Preços, Gerenciamento de Estoque, Pesquisa de Mercado e Geração de Leads. Uma ferramenta poderosa e abrangente pode facilmente contornar a detecção de sites e o bloqueio de IP.

Com impressão digital de navegador real, rotação de IP e proxy avançado, a API de raspagem Scrapeless Arrow é sua melhor escolha para raspar a Arrow e extrair dados de produtos.

Faça login e obtenha uma versão de teste gratuita especial agora!

Leitura adicional

Na Scorretless, acessamos apenas dados disponíveis ao público, enquanto cumprem estritamente as leis, regulamentos e políticas de privacidade do site aplicáveis. O conteúdo deste blog é apenas para fins de demonstração e não envolve atividades ilegais ou infratoras. Não temos garantias e negamos toda a responsabilidade pelo uso de informações deste blog ou links de terceiros. Antes de se envolver em qualquer atividade de raspagem, consulte seu consultor jurídico e revise os termos de serviço do site de destino ou obtenha as permissões necessárias.