Como Lidar com Conteúdo Dinâmico com BeautifulSoup? Guia Definitivo 2025

Expert Network Defense Engineer

Principais Conclusões:

- BeautifulSoup é para HTML estático; não pode executar JavaScript para renderizar conteúdo dinâmico.

- Para extrair conteúdo dinâmico, combine BeautifulSoup com ferramentas de automação de navegador (Selenium, Playwright) ou APIs especializadas.

- A automação do navegador renderiza a página, permitindo que BeautifulSoup analise o HTML completo.

- Consultar diretamente APIs é altamente eficiente quando o conteúdo dinâmico se origina de endpoints de API conhecidos.

- APIs especializadas em Web Scraping oferecem uma solução simplificada para sites complexos movidos a JavaScript.

Introdução

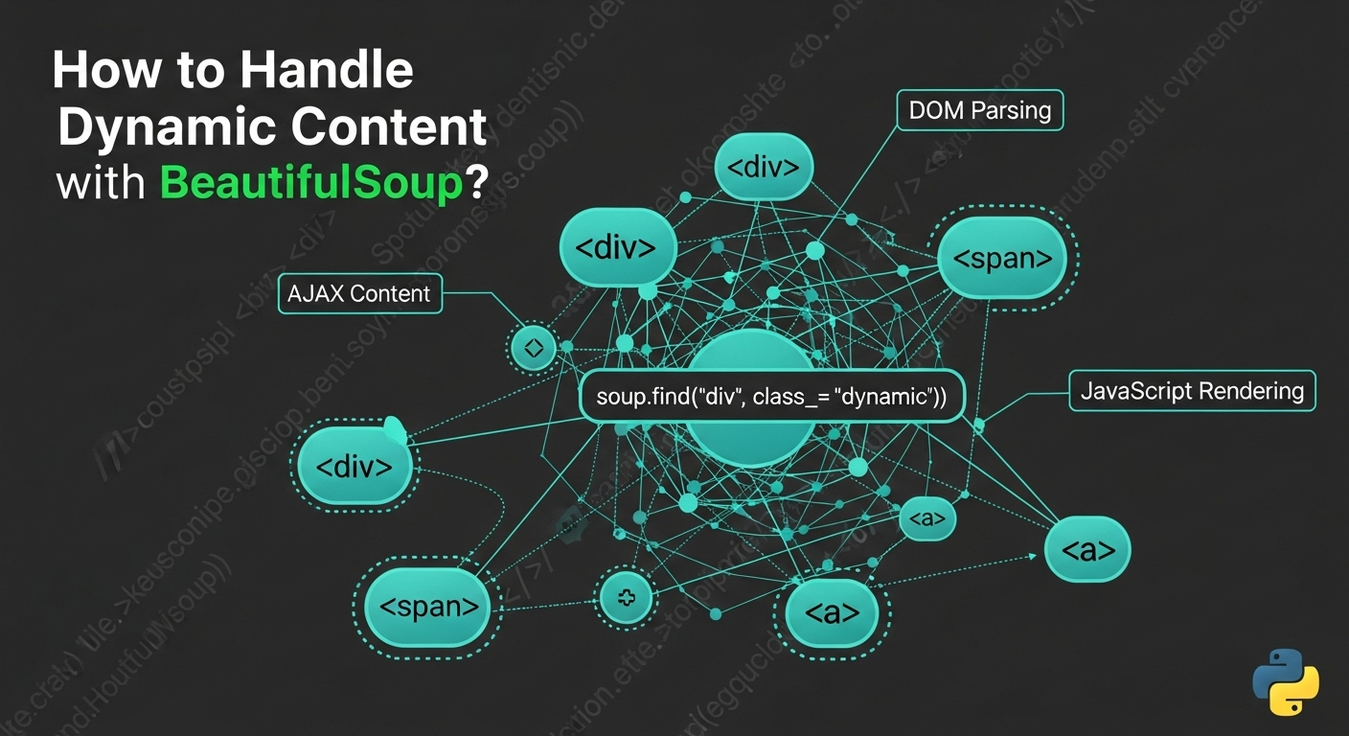

A raspagem da web frequentemente enfrenta um desafio: conteúdo dinâmico. Sites modernos usam JavaScript para carregar dados e renderizar elementos de forma assíncrona, tornando o conteúdo invisível apenas para o BeautifulSoup. Embora o BeautifulSoup se destaque na análise de HTML estático, ele não pode executar JavaScript. Este guia explora métodos eficazes para lidar com conteúdo dinâmico ao usar o BeautifulSoup, fornecendo exemplos práticos e melhores práticas para extrair dados de sites movidos a JavaScript de forma confiável.

Compreendendo Conteúdo Dinâmico e Limitações do BeautifulSoup

Conteúdo dinâmico refere-se a elementos da página da web carregados ou gerados após o HTML inicial, tipicamente via JavaScript. Exemplos incluem chamadas AJAX, renderização do lado do cliente (React, Angular) e WebSockets. BeautifulSoup é um analisador estático; processa apenas o HTML que recebe, não possuindo uma engine JavaScript ou capacidades de renderização. Assim, não pode acessar conteúdo gerado por JavaScript após o carregamento inicial da página. Para superar isso, o BeautifulSoup deve ser emparelhado com ferramentas que simulam um ambiente de navegador.

Solução 1: Combinando BeautifulSoup com Selenium

O Selenium automatiza navegadores da web, executando JavaScript e interagindo com elementos da web. Use-o para carregar uma página, permitir que o conteúdo dinâmico seja renderizado e, em seguida, extrair o HTML completo para que o BeautifulSoup o analise.

Como Funciona:

O Selenium lança um navegador, navega até a URL, espera a execução do JavaScript, recupera a fonte HTML completa e a passa para o BeautifulSoup.

Instalação:

bash

pip install selenium beautifulsoup4 webdriver_managerExemplo de Código em Python (Snippet):

python

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

from webdriver_manager.chrome import ChromeDriverManager

from bs4 import BeautifulSoup

import time

def scrape_dynamic_content_selenium(url):

options = webdriver.ChromeOptions()

options.add_argument('--headless')

driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()), options=options)

driver.get(url)

time.sleep(5) # Ajuste o atraso

html_content = driver.page_source

soup = BeautifulSoup(html_content, 'html.parser')

# ... extrair dados com soup ...

driver.quit()Prós e Contras:

- Prós: Execução completa de JavaScript, interação com o navegador, amplamente adotado.

- Contras: Intensivo em recursos, mais lento, configuração complexa, propenso à detecção anti-bot [1].

Solução 2: Combinando BeautifulSoup com Playwright

Playwright é uma biblioteca moderna para controlar navegadores Chromium, Firefox e WebKit. Oferece mecanismos de espera robustos e costuma ser mais eficiente que o Selenium para conteúdo dinâmico.

Como Funciona:

O Playwright lança um navegador, navega até a URL, espera o carregamento do conteúdo, recupera o HTML completo e o passa para o BeautifulSoup.

Instalação:

bash

pip install playwright beautifulsoup4

playwright installExemplo de Código em Python (Snippet):

python

from playwright.sync_api import sync_playwright

from bs4 import BeautifulSoup

def scrape_dynamic_content_playwright(url):

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto(url, wait_until="networkidle")

html_content = page.content()

soup = BeautifulSoup(html_content, 'html.parser')

# ... extrair dados com soup ...

browser.close()Prós e Contras:

- Prós: Suporte a múltiplos navegadores, API moderna, rápido, espera automática.

- Contras: Intensivo em recursos, requer binários de navegador, pode ser detectado por sistemas anti-bot [2].

Solução 3: Combinando BeautifulSoup com Requests-HTML

requests-html estende requests para renderizar JavaScript usando uma instância headless do Chromium, oferecendo uma maneira mais simples de lidar com conteúdo dinâmico sem automação completa do navegador.

Como Funciona:

requests-html busca o HTML inicial, renderiza o JavaScript em segundo plano e fornece o HTML processado para a análise do BeautifulSoup.

Instalação:

bash

pip install requests-html beautifulsoup4Exemplo de Código em Python (Snippet):

python

from requests_html import HTMLSession

from bs4 import BeautifulSoup

def scrape_dynamic_content_requests_html(url):

session = HTMLSession()

r = session.get(url)

r.html.render(sleep=3, keep_page=False)

html_content = r.html.html

soup = BeautifulSoup(html_content, 'html.parser')

# ... extrair dados com soup ...

python

session.close()Prós e Contras:

- Prós: API mais simples, solicitações e renderização integradas, potencialmente mais leve.

- Contras: Menos robusto para JS complexo/anti-bot, dependência do Chromium, pode ser lento para muitas páginas.

Solução 4: Combinando BeautifulSoup com Splash

Splash é um navegador headless scriptável que roda em um servidor, ideal para renderização controlada de JavaScript, especialmente com Scrapy.

Como Funciona:

Seu script envia uma solicitação ao servidor Splash, que renderiza a página e retorna o HTML completo para o BeautifulSoup analisar.

Instalação:

Requer Docker para rodar o Splash:

bash

docker run -p 8050:8050 scrapinghub/splashExemplo de Código em Python (Trecho):

python

import requests

from bs4 import BeautifulSoup

def scrape_dynamic_content_splash(url, splash_url="http://localhost:8050"):

payload = {

"url": url,

"wait": 2,

"html": 1

}

response = requests.get(f"{splash_url}/render.html", params=payload)

html_content = response.text

soup = BeautifulSoup(html_content, 'html.parser')

# ... extraia dados com soup ...Prós e Contras:

- Prós: Ambiente isolado, scriptável, bom para integração com Scrapy.

- Contras: Configuração complexa (Docker), sobrecarga de desempenho, intenso em recursos.

Solução 5: Consultando APIs Diretamente (Quando Disponíveis)

Frequentemente, o conteúdo dinâmico é carregado via solicitações AJAX para uma API de backend. Consultar essas APIs diretamente pode ser mais eficiente do que a renderização do navegador.

Como Funciona:

Inspecione o tráfego de rede nas ferramentas de desenvolvimento do navegador para encontrar endpoints de API. Replique a solicitação (método, cabeçalhos, payload) usando a biblioteca requests do Python. Analise a resposta JSON/XML. Opcionalmente, use BeautifulSoup se a API retornar trechos HTML.

Instalação:

bash

pip install requests beautifulsoup4Exemplo de Código em Python (Trecho):

python

import requests

import json

from bs4 import BeautifulSoup

def scrape_dynamic_content_api(api_url, headers=None, params=None, data=None):

response = requests.get(api_url, headers=headers, params=params) # ou requests.post

response.raise_for_status()

api_data = response.json()

# ... processe api_data ...

# Se a API retornar trechos HTML:

# soup = BeautifulSoup(api_data["html_content"], 'html.parser')

# ... analise com soup ...Prós e Contras:

- Prós: Rápido, leve em recursos, dados direcionados, menos propenso a anti-bot.

- Contras: Requer descoberta de API, vulnerável a mudanças de API, manipulação de autenticação, nem sempre disponível.

Solução 6: Navegadores Headless (Standalone)

Para renderização leve sem frameworks de automação completos, navegadores headless como pyppeteer (equivalente em Python do Puppeteer) oferecem controle programático sobre um navegador para renderizar páginas pesadas em JavaScript.

Como Funciona:

Um navegador headless é iniciado, navega até a URL, executa JavaScript e extrai o HTML completo, que é então passado para o BeautifulSoup.

Instalação (para pyppeteer):

bash

pip install pyppeteer beautifulsoup4Exemplo de Código em Python (Trecho):

python

import asyncio

from pyppeteer import launch

from bs4 import BeautifulSoup

async def scrape_dynamic_content_pyppeteer(url):

browser = await launch(headless=True)

page = await browser.newPage()

await page.goto(url, waitUntil="networkidle0")

html_content = await page.content()

soup = BeautifulSoup(html_content, 'html.parser')

# ... extraia dados com soup ...

await browser.close()Prós e Contras:

- Prós: Renderização leve, suporte a JavaScript moderno, controle fino.

- Contras: Requer

asyncio, consumo de recursos, configuração do Chromium.

Solução 7: Utilizando APIs de Web Scraping (Serviços Especializados)

Para cenários complexos, APIs especializadas de Web Scraping lidam com renderização de navegador, execução de JavaScript, rotação de IP e evasão de anti-bot, retornando HTML totalmente renderizado ou dados estruturados.

Como Funciona:

Seu script envia uma simples solicitação HTTP à API com a URL de destino. A API lida com toda a renderização e medidas anti-bot, retornando em seguida o HTML limpo para o BeautifulSoup analisar.

Instalação:

bash

pip install requests beautifulsoup4Exemplo de Código em Python (Trecho):

python

import requests

from bs4 import BeautifulSoup

import json

def scrape_dynamic_content_api_service(target_url, api_key, api_endpoint="https://api.scrapeless.com/v1/scrape"):

payload = {

"url": target_url,

"api_key": api_key,

"render_js": True,

}

headers = {"Content-Type": "application/json"}

response = requests.post(api_endpoint, headers=headers, data=json.dumps(payload))

response.raise_for_status()

response_data = response.json()

html_content = response_data.get("html")

if html_content:

soup = BeautifulSoup(html_content, "html.parser")

# ... extraia dados com soup ...Prós e Contras:

- Prós: Simplicidade, alta taxa de sucesso, escalabilidade, eficiência, foco em dados.

- Contras: Serviço pago, dependência externa, menos controle.

Solução 8: Integrando com Scrapy

Scrapy é um framework de raspagem da web de alto nível. Embora não execute JavaScript nativamente, pode se integrar a ferramentas

| 5. Consultando APIs Diretamente | Baixo (Descoberta) | Baixo (Gratuito) | Alto | Alto (se a API for estável) | Dados estruturados de APIs conhecidas, alta velocidade, eficiente em recursos |

| 6. BeautifulSoup + Navegadores Headless (ex: Pyppeteer) | Médio | Baixo (Gratuito) | Bom | Baixo a Médio | Renderização simples de JS, controle programático do navegador, menos sobrecarga do que frameworks completos |

| 7. BeautifulSoup + APIs de Web Scraping | Baixo | Médio a Alto | Muito Alto | Muito Alto | Sites grandes e complexos, evasão de bots, alta confiabilidade |

| 8. Integração Scrapy (com Splash/Selenium) | Muito Alto | Baixo (Gratuito) | Alto | Médio a Alto | Crawling em larga escala para nível empresarial, pipelines de dados robustos |

| 9. requests_html (independente) | Baixo | Baixo (Gratuito) | Moderado | Baixo | Scripts rápidos, renderização básica de JS, abordagem Pythonic |

| 10. Serviço Proxy com Renderização de JS | Baixo | Médio a Alto | Alto | Alto | Descentralização da infraestrutura, prevenção contra bots, scraping em média a larga escala |

Por que Scrapeless é Sua Melhor Alternativa

Embora o BeautifulSoup seja excelente para analisar HTML, lidar com conteúdo dinâmico frequentemente adiciona complexidade significativa. É aqui que uma API especializada de Web Scraping como o Scrapeless oferece uma solução simplificada e robusta. O Scrapeless abstrai os desafios da renderização de JavaScript, rotação de IP e evasão de bots, permitindo que você se concentre puramente na extração de dados.

Como o Scrapeless Simplifica o Web Scraping de Conteúdo Dinâmico:

- Renderização Automática de JavaScript: O Scrapeless executa automaticamente todo o JavaScript, garantindo que o conteúdo dinâmico de AJAX, frameworks do lado do cliente ou WebSockets seja totalmente renderizado. Não há necessidade de gerenciar navegadores headless.

- Bypass Integrado de Anti-Bot e CAPTCHA: Ele integra técnicas de evasão avançadas, incluindo rotação inteligente de IP, impressão digital de navegador e resolução de CAPTCHA, para contornar sistemas de anti-bots sofisticados sem interrupções.

- Integração Simplificada: Seu script Python faz uma solicitação HTTP simples para a API Scrapeless. A API realiza todo o trabalho pesado, retornando HTML limpo e totalmente renderizado para o BeautifulSoup analisar, reduzindo significativamente seu código.

- Escalabilidade e Confiabilidade: Projetado para extração de dados em nível empresarial, o Scrapeless oferece escalabilidade incomparável e alta disponibilidade, sem que você precise gerenciar infraestrutura, proxies ou instâncias de navegador.

- Custo-Benefício: Embora seja um serviço premium, o Scrapeless muitas vezes se mostra mais econômico do que construir e manter soluções personalizadas de scraping dinâmico, economizando tempo e recursos de desenvolvimento.

Ao integrar o Scrapeless, você transforma o scraping de conteúdo dinâmico em um processo eficiente, aproveitando as forças de análise do BeautifulSoup sem as complexidades da renderização de JavaScript e medidas anti-bot.

Conclusão e Chamada para Ação

Lidar com conteúdo dinâmico com BeautifulSoup requer ir além de suas capacidades de análise estática. Existem várias soluções, desde a combinação do BeautifulSoup com ferramentas de automação de navegadores como Selenium e Playwright, até o uso de serviços especializados como Splash ou consultas diretas a APIs. Cada método oferece vantagens e desvantagens distintas.

Para desenvolvedores enfrentando sites modernos e pesados em JavaScript, a escolha depende da escala do projeto, da complexidade do conteúdo dinâmico e das necessidades de evasão de bots. Enquanto a automação de navegador gerenciada pelo usuário oferece controle, ela vem com uma sobrecarga e manutenção significativas.

Para uma abordagem eficiente, escalável e livre de preocupações, uma API dedicada de Web Scraping como o Scrapeless se destaca. Ao descarregar as complexidades da renderização de JavaScript, rotação de IP e contorno de anti-bots, o Scrapeless permite que você maximize o poder de análise do BeautifulSoup sem gerenciamento de infraestrutura. Ele possibilita a extração confiável de dados de sites dinâmicos desafiadores.

Pronto para simplificar seu scraping web dinâmico?

Não deixe que o conteúdo dinâmico seja uma barreira para suas metas de extração de dados. Explore como o Scrapeless pode agilizar seu fluxo de trabalho e fornecer acesso confiável aos dados da web que você precisa. Comece sua avaliação gratuita hoje e experimente o futuro do web scraping.

Comece Sua Avaliação Gratuita com o Scrapeless Agora!

Perguntas Frequentes (FAQ)

Q1: Por que o BeautifulSoup não consegue lidar diretamente com conteúdo dinâmico?

O BeautifulSoup é um analisador de HTML estático; ele não possui um mecanismo de JavaScript e capacidades de renderização. Não consegue executar código JavaScript que carrega conteúdo adicional ou modifica o DOM, portanto, o conteúdo dinâmico gerado após a carga inicial é invisível para ele.

Q2: É sempre necessário usar um navegador headless para conteúdo dinâmico?

Nem sempre. Se o conteúdo dinâmico vem de uma API descobrível, consultar diretamente essa API com requests é mais eficiente. No entanto, para interações complexas em JavaScript, renderização do lado do cliente ou APIs ocultas, um navegador headless ou uma API de scraping especializada se torna necessário.

Q3: Quais são os principais trade-offs entre Selenium/Playwright e APIs de Web Scraping?

Selenium/Playwright: Oferece controle total, gratuito (excluindo infraestrutura), bom para testes. Consome recursos, mais lento, configuração complexa, propenso à detecção anti-bot, alta manutenção.

APIs de Web Scraping: Altamente eficientes, abstraem complexidades (renderização JS, proxies, anti-bot), escaláveis, confiáveis. Serviço pago, controle menos granular, dependência externa.

A escolha depende da escala do projeto, orçamento e controle desejado versus conveniência.

Q4: Como posso identificar se um site usa conteúdo dinâmico?

- Desabilitar JavaScript: Se o conteúdo desaparecer, é dinâmico.

- Dev Tools do Navegador (aba Rede): Procure por requisições XHR/Fetch carregando dados após o HTML inicial.

- Ver Fonte da Página vs. Inspecionar Elemento: Se 'Inspecionar Elemento' mostra mais conteúdo, é dinâmico.

Q5: Posso usar BeautifulSoup para analisar o HTML retornado por uma API de Web Scraping?

Sim, isso é altamente recomendado. As APIs de Web Scraping retornam HTML totalmente renderizado e estático, que o BeautifulSoup é perfeitamente projetado para analisar. Isso combina acesso robusto ao conteúdo com extração de dados flexível.

Referências

[1] ZenRows: Bypass Anti-Bot do Selenium

[2] Playwright: Melhores Práticas

Na Scorretless, acessamos apenas dados disponíveis ao público, enquanto cumprem estritamente as leis, regulamentos e políticas de privacidade do site aplicáveis. O conteúdo deste blog é apenas para fins de demonstração e não envolve atividades ilegais ou infratoras. Não temos garantias e negamos toda a responsabilidade pelo uso de informações deste blog ou links de terceiros. Antes de se envolver em qualquer atividade de raspagem, consulte seu consultor jurídico e revise os termos de serviço do site de destino ou obtenha as permissões necessárias.