Uso do Navegador Scrape-less X

Senior Web Scraping Engineer

O Browser Use é um SDK de automação de navegador que utiliza capturas de tela para capturar o estado do navegador e ações para simular interações do usuário. Este capítulo apresentará como você pode facilmente usar o browser-use para executar tarefas de agentes na Web com chamadas simples.

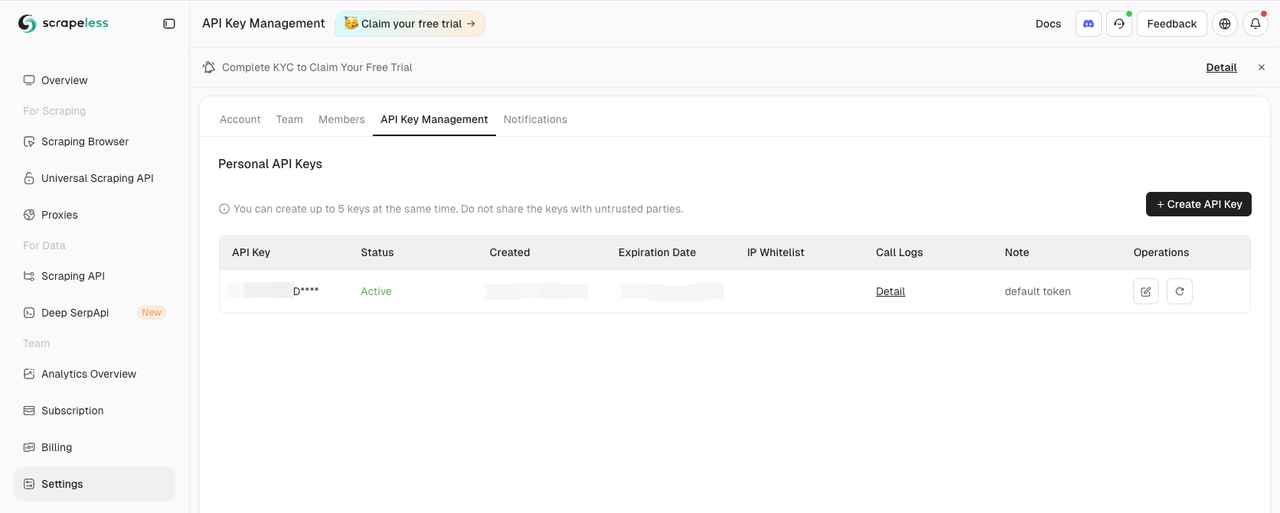

Obter Chave da API Scrapeless

Acesse a aba Configurações do Painel:

Depois, copie e defina as variáveis de ambiente SCRAPELESS_API_KEY no seu arquivo .env.

As variáveis de ambiente OPENAI_API_KEY no seu arquivo .env também são necessárias.

.env

OPENAI_API_KEY=sua-chave-api-openai

SCRAPELESS_API_KEY=sua-chave-api-scrapeless💡 Lembre-se de substituir a chave da API de amostra pela sua chave da API real

Instalar o Browser Use

Com pip (Python>=3.11):

Shell

pip install browser-usePara funcionalidade de memória (requer Python<3.13 devido à compatibilidade com PyTorch):

Shell

pip install "browser-use[memory]"Configurar o Navegador e a Configuração do Agente

Aqui está como configurar o navegador e criar um agente de automação:

Python

from dotenv import load_dotenv

import os

import asyncio

from urllib.parse import urlencode

from langchain_openai import ChatOpenAI

from browser_use import Agent, Browser, BrowserConfig

from pydantic import SecretStr

task = "Vá para o Google, pesquise por 'Scrapeless', clique na primeira publicação e retorne ao título"

async def setup_browser() -> Browser:

scrapeless_base_url = "wss://browser.scrapeless.com/browser"

query_params = {

"token": os.environ.get("SCRAPELESS_API_KEY"),

"session_ttl": 180,

"proxy_country": "ANY"

}

browser_ws_endpoint = f"{scrapeless_base_url}?{urlencode(query_params)}"

config = BrowserConfig(cdp_url=browser_ws_endpoint)

browser = Browser(config)

return browser

async def setup_agent(browser: Browser) -> Agent:

llm = ChatOpenAI(

model="gpt-4o", # Ou escolha o modelo que deseja usar

api_key=SecretStr(os.environ.get("OPENAI_API_KEY")),

)

return Agent(

task=task,

llm=llm,

browser=browser,

)Criar a Função Principal

Aqui está a função principal que junta tudo:

Python

async def main():

load_dotenv()

browser = await setup_browser()

agent = await setup_agent(browser)

result = await agent.run()

print(result)

await browser.close()

asyncio.run(main())Execute seu script

Execute seu script:

Shell

python run main.pyVocê deve ver sua sessão Scrapeless iniciar no Painel Scrapeless.

Código Completo

Python

from dotenv import load_dotenv

import os

import asyncio

from urllib.parse import urlencode

from langchain_openai import ChatOpenAI

from browser_use import Agent, Browser, BrowserConfig

from pydantic import SecretStr

task = "Vá para o Google, pesquise por 'Scrapeless', clique na primeira publicação e retorne ao título"

async def setup_browser() -> Browser:

scrapeless_base_url = "wss://browser.scrapeless.com/browser"

query_params = {

"token": os.environ.get("SCRAPELESS_API_KEY"),

"session_ttl": 180,

"proxy_country": "ANY"

}

browser_ws_endpoint = f"{scrapeless_base_url}?{urlencode(query_params)}"

config = BrowserConfig(cdp_url=browser_ws_endpoint)

browser = Browser(config)

return browser

async def setup_agent(browser: Browser) -> Agent:

llm = ChatOpenAI(

model="gpt-4o", # Ou escolha o modelo que deseja usar

api_key=SecretStr(os.environ.get("OPENAI_API_KEY")),

)

return Agent(

task=task,

llm=llm,

browser=browser,

)

async def main():

load_dotenv()

browser = await setup_browser()

agent = await setup_agent(browser)

result = await agent.run()

print(result)

await browser.close()

asyncio.run(main())💡 O Browser Use atualmente suporta apenas Python.

💡 Você pode copiar a URL da sessão ao vivo para acompanhar o progresso da sessão em tempo real e também pode assistir a uma reprodução da sessão no histórico da sessão.

Na Scorretless, acessamos apenas dados disponíveis ao público, enquanto cumprem estritamente as leis, regulamentos e políticas de privacidade do site aplicáveis. O conteúdo deste blog é apenas para fins de demonstração e não envolve atividades ilegais ou infratoras. Não temos garantias e negamos toda a responsabilidade pelo uso de informações deste blog ou links de terceiros. Antes de se envolver em qualquer atividade de raspagem, consulte seu consultor jurídico e revise os termos de serviço do site de destino ou obtenha as permissões necessárias.