Scrapeless Web Unlocker を使用してウェブサイトのブロックを解除する方法

Senior Web Scraping Engineer

ウェブスクレイピングは、データ分析や市場調査、そしてもちろん競合他社分析にも広く利用されています。しかし、IPブロック、複雑なJavaScriptレンダリング、CAPTCHA認証など、クロールにおける障害に遭遇することは避けられません。ユーザーがよく懸念する重要な問題の1つは、「ウェブサイトのスクレイピングは合法か?」ということです。

自動化された作業を行う際に、検出とブロックを回避するにはどうすればよいでしょうか?

この記事では、最も効果的で時間節約になる方法をご紹介します。

今すぐ読み始めましょう!

なぜウェブサイトをスクレイピングする際にブロックされ続けるのか?

ウェブスクレイピングのヒントに移る前に、まず、ウェブデータのスクレイピング時に遭遇する可能性のある一般的なアンチボット対策を知る必要があります。

常にネットワークブロックに遭遇する場合は、次の8つの側面を確認してください。

1️⃣ 同一のIPからの過剰なリクエスト

ウェブサイトはトラフィックパターンを監視し、短時間で非常に多くのリクエストを行うIPアドレスをブロックする場合があります。これは、スクレイピングと不正使用を防ぐために頻繁に行われます。

2️⃣ IPブラックリスト登録

スクレイピングアクティビティが疑わしいとフラグ付けされた場合、ウェブサイトはあなたのIPをブラックリストに登録する可能性があります。これは、同じIPアドレスから繰り返しサイトにアクセスする場合、またはボットに似た識別可能な行動パターンを使用する場合に発生する可能性があります。

3️⃣ CAPTCHAの使用

多くのウェブサイトでは、CAPTCHAチャレンジを使用して、人間のユーザーとボットを区別しています。スクレイパーがCAPTCHAチャレンジをトリガーした場合、CAPTCHAが解決されるまでブロックされる可能性があります。

4️⃣ JavaScriptレンダリング

複雑なJavaScriptを使用するウェブサイトでは、コンテンツが非表示になったり、動的に生成されたりする可能性があります。従来のスクレイピング方法はこれに対応できず、スクレイピングが不完全になったり失敗したりすることがあります。

これは、ウェブサイトがスクレイパーをブロックする最も基本的な理由です。JSレンダリングの課題を克服するにはどうすればよいでしょうか?心配しないでください。後で解決できます。

5️⃣ ユーザーエージェント検出

ウェブサイトはしばしば「User-Agent」文字列をチェックして、リクエストが実際のブラウザから来ているのか、それともボットから来ているのかを確認します。実際のブラウザを適切に模倣しないスクレイピングツールは検出され、ブロックされる可能性があります。

6️⃣ レート制限とセッション期限切れ

ウェブサイトは、特定の時間枠内で実行できるリクエスト数を制限し、特定の数の操作後にセッションが期限切れになる場合があります。ウェブサイトに繰り返しアクセスすると、一時的または永続的なブロックにつながる可能性があります。

7️⃣ フィンガープリンティング

最新のウェブサイトでは、ブラウザフィンガープリンティング技術を使用して、自動化されたスクレイピングを検出します。この方法は、画面解像度、タイムゾーン、その他のブラウザの特性などの一意のパターンを追跡するため、ウェブサイトがスクレイピングツールを識別してブロックしやすくなります。

8️⃣ ジオブロッキング

一部のウェブサイトでは、IPアドレスの地理的な場所に基づいてアクセスを制限しています。アクセスが許可されていない地域からスクレイピングを行っている場合、ブロックが発生する可能性があります。

Scrapeless Web Unlocker - ウェブサイトスクレイピングのための最適なソリューション

Scrapelessは、主要なウェブサイトアンブロッカーであるだけでなく、包括的なウェブスクレイピングソリューションでもあります。

強力なウェブアンブロッカーとして、Scrapelessはユーザーに簡素化され効率的なHTML抽出サービスを提供します。高度なプロキシ選択技術と自動アンブロッキングメカニズムにより、Scrapelessは複雑なアンチクローラー保護を簡単にバイパスし、ユーザーが必要なデータを取得するのを支援します。

なぜScrapeless Web Unlockerを選択する必要があるのか?

⚙️ 効率的なJavaScriptレンダリング(JSRender)

ScrapelessのJSRenderテクノロジーは、高度なブラウザシミュレーションレンダリングエンジンを使用しており、ウェブページの動的コンテンツの読み込みをリアルタイムで処理できます。動的なページ、シングルページアプリケーション(SPA)など、コンテンツの生成にJavaScriptを必要とする最新のウェブサイトに特に適しています。

従来のクローラーツールと比較して、**ScrapelessのJSRenderはJavaScriptによって生成された複雑なデータを短時間でレンダリングできます。**これは、インタラクションや動的な更新を必要とするコンテンツ(eコマースウェブサイトの商品詳細ページなど)をクロールする上で非常に重要です。たとえば、Shopee、Amazon、Lazadaから商品ページをスクレイピングする場合、Scrapelessはすべての動的データ(価格、在庫、レビューなど)を読み込んで抽出し、重要な情報を欠落させることはありません。

🧩 IPブロックのバイパス

Scrapelessは、安定したアクセス体験を確保するためにIPを自動的に切り替えることができる、組み込みのインテリジェントプロキシプールを提供します。プロキシプールは高品質なIPリソースをインテリジェントに選択するため、大規模なクロールでも、ウェブサイトのIPブロックや制限を効果的にバイパスし、クロールタスクがスムーズに進むようにすることができます。

ユーザーは追加の設定を行う必要はありません。私たちは最高の自動化レベルを確保し、多くの開発時間と労力を節約します。ユーザーはIPブロックを心配することなく、ビジネスロジックに集中できます。

⚔️ 自動CAPTCHAソルバー

Scrapelessには、画像CAPTCHA、テキストCAPTCHA、Google reCAPTCHAチャレンジに対応できる統合CAPTCHAソルバーが搭載されています。これにより、手動による介入なしに、中断のないスクレイピングセッションを確保します。

ウェブサイトのスクレイピングは合法か?と疑問に思っている人のために—答えは、ウェブサイトの利用規約とデータ収集の性質によって異なります。公開されている情報は多くの場合問題ありませんが、ウェブスクレイピングを行う際には、倫理的および法的考慮事項を常に考慮する必要があります。

Scrapelessはバイパスメカニズムを自動化することでプロセスを簡素化し、企業や開発者が貴重な洞察を効率的に抽出することに集中できるようにします。

Scrapeless Web Unlockerの使用方法

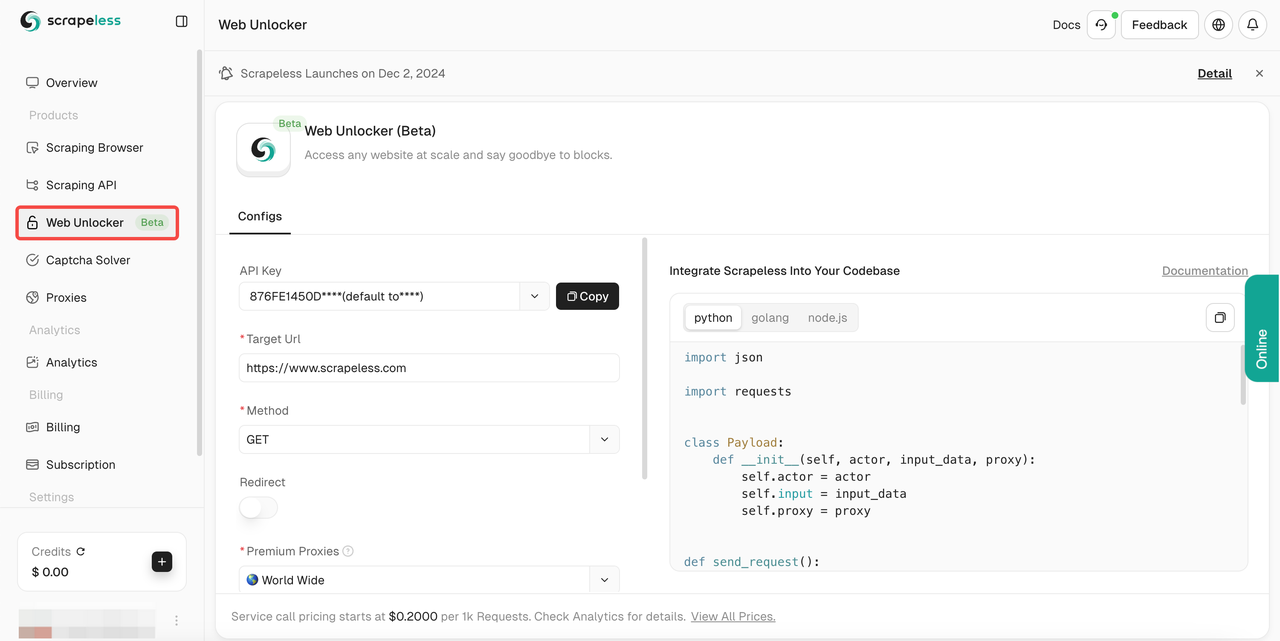

- ステップ1。Scrapelessにログインします。

- ステップ2。「Web Unlocker」を入力します。

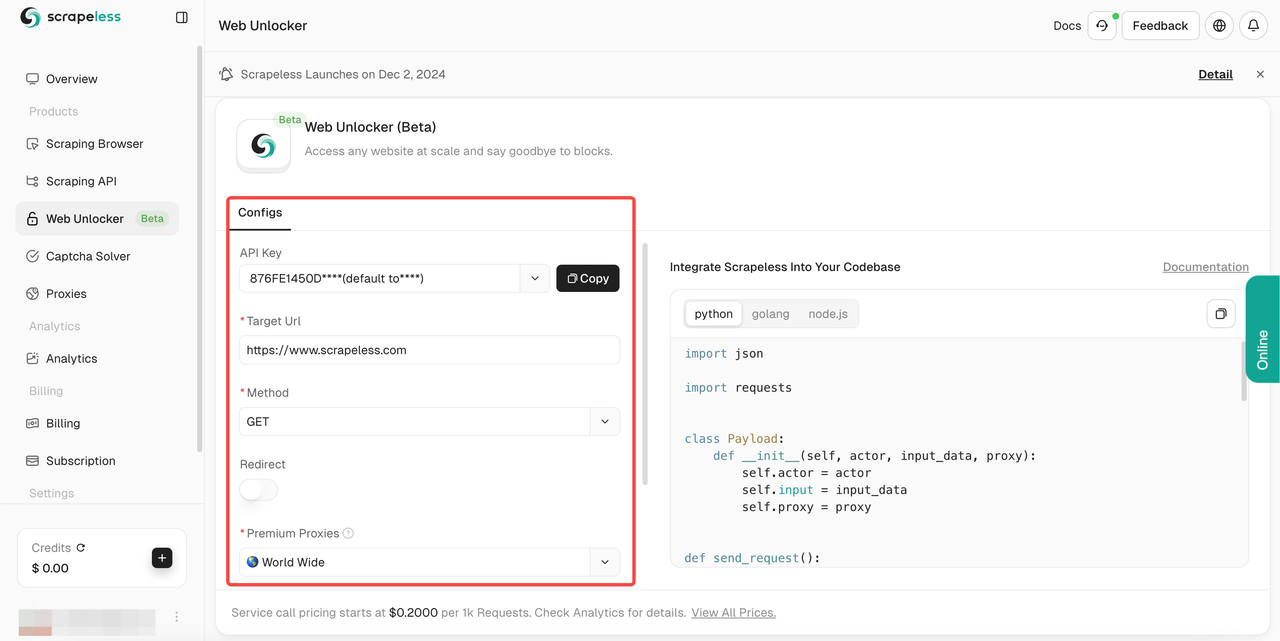

- ステップ3。必要に応じて左側の操作パネルを設定します。

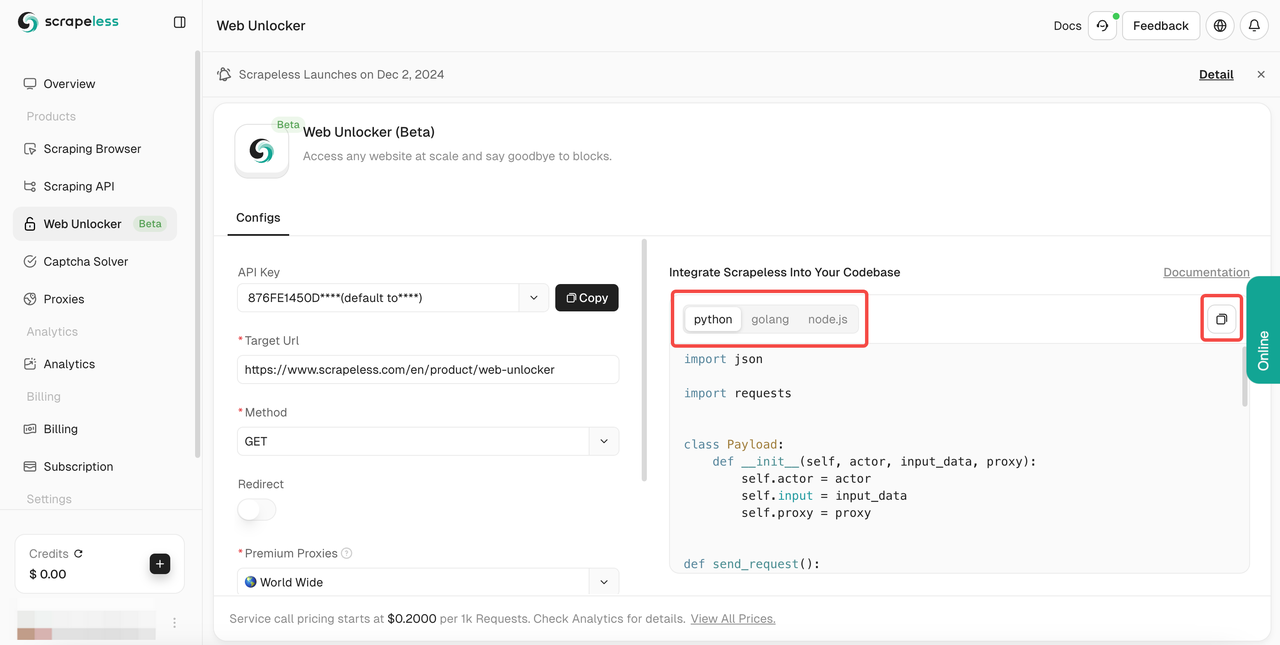

- ステップ4。

target urlを入力すると、Scrapelessは自動的にコンテンツをクロールします。右側の結果表示ボックスでクロール結果を確認できます。必要な言語(Python、Golang、またはnode.js)を選択し、最後に右上のロゴをクリックして結果をコピーします。

これにより、あらゆる公開ウェブサイトに中断なくアクセスできます。さまざまなクロール方法をサポートし、JavaScriptのレンダリングに優れ、アンチクロールテクノロジーを実装して、効果的にウェブを閲覧するためのツールを提供します。

または、以下のサンプルコードを使用して、独自のプロジェクトに効果的に統合することもできます。

- Url: ターゲットウェブサイト

- Method: リクエストメソッド

- Redirect: リダイレクトを許可するかどうか

- Headers: カスタムリクエストヘッダーフィールド

Python:

Python

import requests

import json

url = "https://api.scrapeless.com/api/v1/unlocker/request"

payload = json.dumps({

"actor": "unlocker.webunlocker",

"input": {

"url": "https://httpbin.io/get",

"proxy_country": "US",

"type": "",

"redirect": False,

"method": "GET",

"request_id": "",

"extractor": ""

}

})

headers = {

'Content-Type': 'application/json'

}

response = requests.request("POST", url, headers=headers, data=payload)

print(response.text)JavaScript:

JavaScript

var myHeaders = new Headers();

myHeaders.append("Content-Type", "application/json");

var raw = JSON.stringify({

"actor": "unlocker.webunlocker",

"input": {

"url": "https://httpbin.io/get",

"proxy_country": "US",

"type": "",

"redirect": false,

"method": "GET",

"request_id": "",

"extractor": ""

}

});

var requestOptions = {

method: 'POST',

headers: myHeaders,

body: raw,

redirect: 'follow'

};

fetch("https://api.scrapeless.com/api/v1/unlocker/request", requestOptions)

.then(response => response.text())

.then(result => console.log(result))

.catch(error => console.log('error', error));Go

Go

package main

import (

"fmt"

"strings"

"net/http"

"io/ioutil"

)

func main() {

url := "https://api.scrapeless.com/api/v1/unlocker/request"

method := "POST"

payload := strings.NewReader(`{

"actor": "unlocker.webunlocker",

"input": {

"url": "https://httpbin.io/get",

"proxy_country": "US",

"type": "",

"redirect": false,

"method": "GET",

"request_id": "",

"extractor": ""

}

}`)

client := &http.Client {

}

req, err := http.NewRequest(method, url, payload)

if err != nil {

fmt.Println(err)

return

}

req.Header.Add("Content-Type", "application/json")

res, err := client.Do(req)

if err != nil {

fmt.Println(err)

return

}

defer res.Body.Close()

body, err := ioutil.ReadAll(res.Body)

if err != nil {

fmt.Println(err)

return

}

fmt.Println(string(body))

}ブロックされずにスクレイピングを行う代替ソリューション

1. IPローテーション

スクレイピングウェブサイトがウェブクローラーを検出する最初の方法は、IPアドレスをチェックし、ウェブサイトとのやり取りを追跡することです。「そのユーザー」からの奇妙な行動パターン、または不可能なリクエスト頻度をサーバーが検出すると、サーバーはそのIPアドレスが再びウェブサイトにアクセスすることをブロックできます。

同じIPアドレスですべてのリクエストを送信しないようにするには、IPローテーションサービス(Scrapelessのローテーション住宅プロキシなど)を使用して、プロキシプールを介してリクエストをルーティングし、ウェブサイトをクロールしながら実際のIPアドレスを隠すことができます。これにより、ほとんどのウェブサイトをブロックされることなくクロールできます。

住宅プロキシを使用する理由は何ですか?より厳しいブロック要件のある一部のウェブサイトでは、プロキシ検出に対してより厳しくなります。住宅プロキシを選択すると、クローラーのアイデンティティがより現実的になり、スクレイピングウェブサイトの取り組みがより安定します。

最終的に、IPローテーションを使用すると、クローラーはさまざまなユーザーからのリクエストのように見せかけ、オンライントラフィックの通常の動作を模倣できます。

Scrapelessプロキシを使用する場合、当社のインテリジェントIPローテーションシステムは、長年の統計分析と機械学習を活用して、データセンター、住宅、モバイルプロキシプールから必要に応じてプロキシをローテーションし、99.99%の成功率を確保します。

2. ヘッドレスブラウザを使用する

最も難しいスクレイピングウェブサイトは、ウェブフォント、拡張機能、ブラウザーのCookie、JavaScriptの実行など、リクエストが実際のユーザーから来ているかどうかを判断する微妙な兆候を検出する可能性があります。

これらのウェブサイトをスクレイピングするには、独自のヘッドレスブラウザを展開する(またはScrapelessスクレイピングブラウザにやらせる)必要があります。

ヘッドレスブラウザを使用すると、実際のユーザーが使用するものと同一の実際のウェブブラウザを制御するプログラムを作成して、検出を完全に回避できます。

3. CAPTCHAソルバースプロバイダー

CAPTCHAソルバーは、私たちがよく使用するサードパーティサービスです。これらは、光学文字認識(OCR)、機械学習、またはサードパーティの人間ソルバーなどのテクノロジーを使用して、CAPTCHAチャレンジを自動的に無料で解決し、スクレイピングボットがウェブブロックをバイパスできるようにします。

これらのツールは、CAPTCHA認証によって発生する中断を防ぐことで、継続的で自動化されたスクレイピングウェブサイトアクティビティを可能にします。人間の行動を模倣したり、CAPTCHAをリアルタイムで解決したりすることで、ボットとして検出されるのを回避し、スムーズなスクレイピングプロセスを維持します。

ただし、これらのツールはウェブサイトの利用規約およびプライバシーポリシーに違反する可能性があるため、そのようなツールを使用することの倫理的および法的影響を考慮することが重要です。ウェブサイトのスクレイピングは合法ですか?それは管轄区域とウェブサイトの条件によって異なります。常に地域の法律と規制を遵守してください。その上、これらのツールは通常、価格も高くなります。

4. 本物のユーザーエージェントを設定する

本物のユーザーエージェントを設定することは、スクレイピングウェブサイトアクティビティ中に検出を回避する一般的な方法です。ウェブサイトは、リクエスト内のユーザーエージェントヘッダーを使用して、それが実際のユーザーブラウザから送信されたものか、自動化されたボットから送信されたものかを識別することがよくあります。ユーザーエージェントを偽装したりランダム化したりすることで、スクレイピングスクリプトは通常のユーザーから送信されたもののように見えるようになり、検出される可能性が低くなります。

実装方法:

- 実際のブラウザのユーザーエージェントを偽装する

一般的なブラウザのユーザーエージェント文字列(Chrome、Firefox、Safariなど)を使用して、実際のユーザーの動作を模倣します。たとえば、Pythonでは、requestsライブラリを使用して、一般的なブラウザのユーザーエージェントヘッダーを設定できます。

Python

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

response = requests.get('https://example.com', headers=headers)- ユーザーエージェントを動的にローテーションする

プロキシプールまたはAPI(random-user-agentなど)を使用して、さまざまなユーザーエージェント文字列をローテーションし、単一のユーザーエージェントに基づいたスクレイピングパターンをウェブサイトが認識するのを難しくします。

5. その他のヘッダーを組み合わせる

ユーザーエージェントに加えて、他のヘッダー(Referer、Accept-Languageなど)も偽装して、実際のブラウザのリクエストをさらに模倣できます。

一般的に、Googleからアクセスされているように見せるのが最適です。

次のようなヘッダーを使用できます。「Referer」:「https://www.google.com/」

これにより、ウェブサイトが自動化されたリクエストと本物のユーザーインタラクションを区別するのがさらに困難になります。

6. クローリングリクエスト間のランダムな間隔を設定する

ウェブサイトは、リクエストの頻度と規則性に基づいてスクレイピングアクティビティを検出することがよくあります。リクエストが速すぎるか、予測可能なパターンで送信されると、ウェブサイトがスクレイパーを識別してブロックするのが容易になります。リクエスト間にランダムな遅延を導入することで、スクレイピング動作をより自然に見せることができます。

Pythonのtime.sleep()関数を使用して、リクエスト間に遅延を導入できます。ランダムな間隔を設定することで、各リクエスト間の時間を変えることができ、動作が予測不能になります。

Python

import time

import random

import requests

# 1〜3秒のランダムな遅延でリクエストを送信する

headers = {'User-Agent': 'Mozilla/5.0'}

url = 'https://example.com'

for i in range(10):

response = requests.get(url, headers=headers)

print(f"Request {i+1} Status: {response.status_code}")

time.sleep(random.uniform(1, 3)) # 1〜3秒のランダムなスリープ7. ハニーポットトラップを回避する

多くのウェブサイトは、ボットのみがそれらに従うため、目に見えないリンクを使用してウェブクローラーを検出します。

検出を回避するには、リンクにCSSプロパティ「display: none」または「visibility: hidden」が設定されているかどうかを確認する必要があります。いずれかが設定されている場合は、リンクにアクセスしないでください。そうしないと、クローラーが検出にさらされ、サーバーがリクエスト属性を識別してブロックされる可能性があります。

ハニーポットは、ウェブサイトがクローラーを発見するために使用される一般的な方法であるため、スクレイピングするすべてのページでこのチェックを実行してください。

さらに、一部の高度なウェブマスターは、リンクの色を白(または背景色に一致させる)に設定することもあるため、「color: #fff;」または「color: #ffffff」などのプロパティを確認して、リンクが目に見えない状態を維持する価値があります。

8. Googleキャッシュを削除する

スクレイピング中にブロックされるのを回避するには、Googleのキャッシュをクリアまたはバイパスすることが重要です。Googleのキャッシュは、以前のやり取りを保存し、ウェブサイトが疑わしいスクレイピングアクティビティを検出するのに役立つ可能性があります。Googleのキャッシュに対処するためのいくつかの戦略を以下に示します。

Puppeteer: clearBrowserCookies()とclearBrowserCache()関数をPuppeteerで使用して、スクレイピングセッション間でCookieとキャッシュをクリアします。

JavaScript

cookies and cache between scraping sessions.

const browser = await puppeteer.launch();

const page = await browser.newPage();

// キャッシュとCookieをクリアする

await page.clearBrowserCache();

await page.clearBrowserCookies();クローリングをシンプルで効率的にする時間です!

Scrapeless Web Unlockerは、インテリジェントプロキシプール、効率的なJavaScriptレンダリング(JSRender)、自動CAPTCHA処理を統合した強力なツールであり、ウェブサイトのスクレイピングにおける一般的な問題を解決するために設計されています。Scrapelessは、複雑なスクレイピングタスクをシンプル、効率的、信頼性の高いものにします。

スクレイピングの制限を打破し、効率を向上させたい場合、複雑な動的ページの処理であろうと大規模なスクレイピングタスクであろうと、Scrapeless Web Unlockerは信頼できるソリューションです。

今すぐScrapelessを無料で使い始めましょう!比類のないスクレイピングパフォーマンスを体験し、データ収集を容易にしましょう!

Scrapelessでは、適用される法律、規制、およびWebサイトのプライバシーポリシーを厳密に遵守しながら、公開されているデータのみにアクセスします。 このブログのコンテンツは、デモンストレーションのみを目的としており、違法または侵害の活動は含まれません。 このブログまたはサードパーティのリンクからの情報の使用に対するすべての責任を保証せず、放棄します。 スクレイピング活動に従事する前に、法律顧問に相談し、ターゲットウェブサイトの利用規約を確認するか、必要な許可を取得してください。