無料ノーコードウェブスクレイパー8選|2025年ベストセレクト

Senior Web Scraping Engineer

ノーコードスクレイパーとは?

ノーコードウェブスクレイピングツール、別名マネージドまたはホステッドスクレイピングとは、コードインフラストラクチャを構築または維持することなく、ウェブサイトからデータ抽出を支援するウェブスクレイピング手法です。これらのツールは通常、視覚的なインターフェースまたは合理化されたワークフローで構築されており、ユーザーはウェブスクレイピングタスクを簡単に設定および実行できます。

コードレススクレイピングの主な利点の1つは、ウェブからデータ収集に必要な時間と労力を大幅に削減できることです。ターゲットURLをアップロードし、人気のあるウェブサイトや一般的なユースケース向けに事前に構築されたスクレイピングテンプレートを使用することで、ほぼ瞬時にデータを取得できます。

これらのツールは、手動によるコーディングとインフラストラクチャ管理の必要性を排除し、抽出されたデータの分析と貴重な洞察の獲得により多くの時間を割くことができます。

スケーラビリティは、コードレススクレイピングツールに付属するもう1つの利点です。たとえば、ScrapelessのAPIサービスを使用すると、cronジョブまたはカスタム間隔を使用してスクレイピングタスクをスケジュールし、より高度な自動化とスケーラビリティを実現できます。

これは、競合他社の動向を継続的に監視する場合に特に役立ちます。はい、彼らは毎日価格やリスティングキーワードを変更する可能性があるため、競争力を維持するためにこれらの変化に対応する必要があります。

なぜノーコードスクレイパーを選択すべきか?

- ビジュアルインターフェース: ノーコードウェブスクレイピングツールは、多くの場合、ドラッグアンドドロップインターフェースまたはポイントアンドクリック機能を提供しており、ユーザーはコードの書き方を知らなくても、スクレイピングしたいウェブサイトの要素を選択できます。

- 事前設定されたテンプレート: 多くのノーコードウェブスクレイパーには、一般的なウェブスクレイピングタスク用の事前に構築されたテンプレートが付属しており、開始がさらに容易になります。

- 自動化: これらのツールは、多くの場合、反復的なスクレイピングタスクを自動化するため、ユーザーは手動で介入する必要なく、スクレイピングジョブをスケジュールまたはトリガーできます。

- 互換性: ノーコードウェブスクレイパーは、組み込みのブラウザまたはクラウド環境を利用してページをレンダリングすることにより、JavaScriptを使用するものを含め、静的および動的なウェブサイトからのデータを処理できます。

- データエクスポート: CSV、Excel、またはAPI統合などのさまざまな形式でスクレイピングされたデータをエクスポートできるため、他のシステムでデータに簡単にアクセスして分析したり使用したりできます。

- プログラミングの知識は不要: 主要な利点は、ユーザーがPython、JavaScriptなどのプログラミング言語を学習することなく、複雑なスクレイピングワークフローを構築できることです。

ノーコードスクレイパーのコア評価基準

- 使いやすさ: 操作は直感的で簡単ですか?私にとって、使い始めるのが簡単なツールを選択することは最優先事項です。ツールが複雑すぎたり、操作が面倒すぎたりする場合、機能がどれだけ強力であっても、圧倒されてしまいます。優れたノーコードウェブスクレイピングツールは、少なくともクリーンなユーザーインターフェースと明確な操作手順を備えている必要があります。

- データスクレイピング能力: 複雑な動的なウェブページをスクレイピングできますか?ノーコードウェブスクレイパーの最も重要な機能は、ウェブデータを正確かつ迅速にスクレイピングする能力です。特に、動的なウェブサイトとJavaScriptでレンダリングされたページを処理できますか?結局のところ、多くのウェブサイトは現在、JavaScriptを介してコンテンツを読み込んでいるため、通常のツールでは処理できないことがよくあります。

- アンチ検知能力: ウェブサイトのアンチスクレイピングメカニズムをバイパスできますか?ノーコードウェブスクレイパーを使用してスクレイピングを行うと、多くのウェブサイトにはアンチスクレイピング対策(IP制限、CAPTCHAなど)が導入されています。これにより、一部のツールを使用すると、ブロックまたはCAPTCHAの課題が発生することがよくあります。

- APIと自動化: 統合と自動化されたタスクをサポートしていますか?頻繁に繰り返しデータをスクレイピングする必要がある人として、私のツールがAPIをサポートして、スクレイピングタスクを自動化し、既存のビジネスプロセスに統合できることを願っています。

- 価格と費用対効果: ツールの費用は妥当ですか?私は通常、費用対効果の高いツールを選択します。無料ツールは便利ですが、多くの場合、その機能と制限は私のニーズを満たしません。有料版が機能豊富で価格が妥当な場合、非常に価値のある投資となります。

ランキング:8つの最高のノーコードスクレイパーツールの分析

以下は、厳選した8つの最高のノーコードウェブスクレイピングツールです。機能は異なり、実際のニーズに合った製品を選択する必要があります。

概要比較

| 主な機能 | 有料プラン | 無料トライアル | 使いやすさ | |

|---|---|---|---|---|

| Scrapeless | 包括的で安定しており、非常に成功している | 49ドル~ | 全サービスで1ヶ月間の無料トライアル | ⭐⭐⭐⭐⭐ |

| ParseHub | 技術的な知識のないユーザーに適している | 189ドル~ | 99ドル相当の価値あり | ⭐⭐⭐⭐⭐ |

| Diffbot | AIウェブ構造解析 | 299ドル~ | 機能制限のある長期プラン | ⭐⭐⭐⭐ |

| Outscraper | Google検索カテゴリデータ向け | ニーズに応じて | 最初の500アクションまで | ⭐⭐⭐⭐ |

| WebHarvy | 小規模なデータ収集タスクに最適 | 129ドル~ | サポートなし | ⭐⭐⭐⭐ |

| DataMiner | 表やリストなどの構造化データのクロール | 19.99ドル~ | 無料プランは月間500ページ提供 | ⭐⭐⭐ |

| Simplescraper | 小規模プロジェクト向け | 39ドル~ | 100クレジットの無料スタータープラン | ⭐⭐⭐ |

| Browse AI | 競合分析と価格追跡に最適 | 19ドル~ | 50クレジット | ⭐⭐⭐ |

#1 Scrapeless – 包括的で安定したノーコードウェブスクレイパー

Scrapelessは、Browserlessテクノロジーを搭載したクラウドベースのウェブスクレイピングツールであり、ユーザーに安定したスクレイピング環境を提供するように設計されています。インテリジェントプロキシ を通じてIP制限のバイパスをサポートしており、eコマース、ニュース、およびSEOデータ抽出に特に適しています。

プログラミングスキルがないユーザー、またはコーディングに多くの時間を費やしたくないユーザー向けに、Scrapelessは、内部ビジネスシステムに迅速に統合してデータスクレイピングタスクを自動化できるシンプルなAPIインターフェースを提供します。ScrapelessのAPIは、強力な開発機能を通じてJavaScriptレンダリングを完全にサポートしています。数回クリックして簡単な設定を行うだけで、通常は複雑なスクレイパー設定が必要な作業を完了できます。

Scrapelessは、AIエージェントサービスの開始も予定しています。全体として、特に従来のノーコードスクレイパーと比較して優れたアンチ検知能力があるため、長期的な大規模なデータスクレイピングを必要とするユーザーに最適です。

Scrapelessをデプロイする方法を以下に示します。最も明確な手順は次のとおりです。

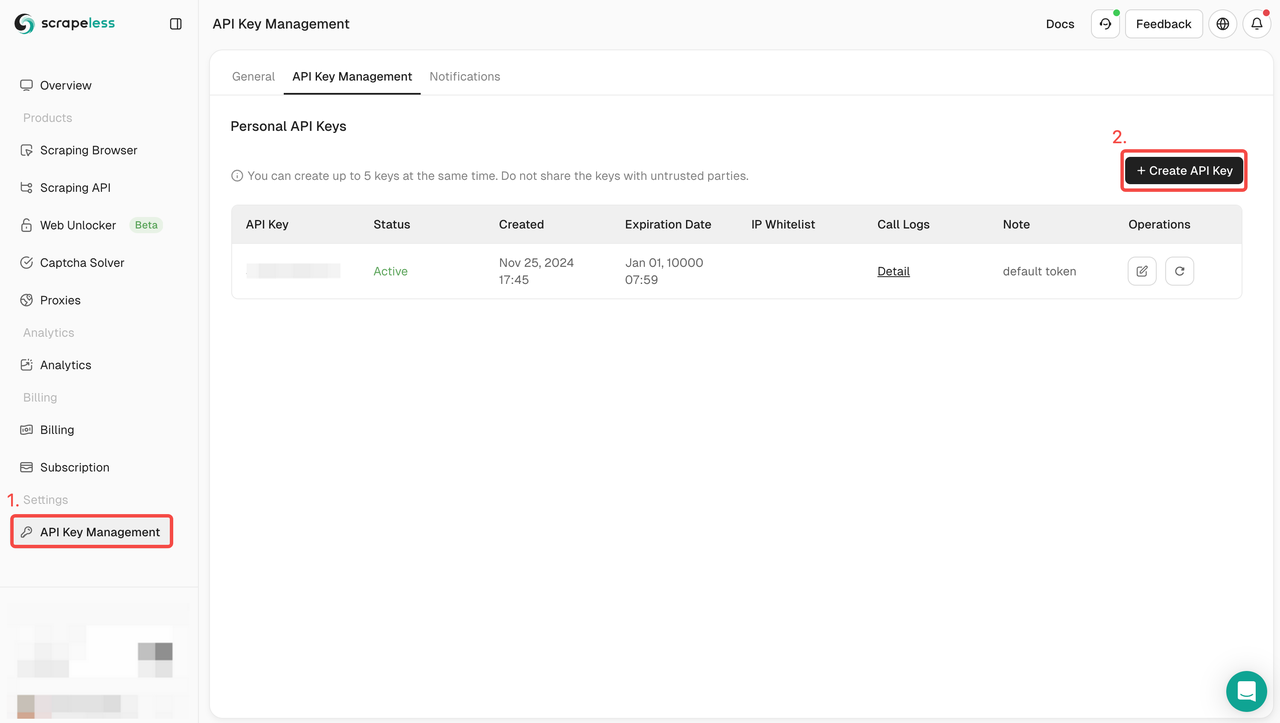

手順1. APIキーを取得する

開始するには、ScrapelessダッシュボードからAPIキーを取得する必要があります。

- Scrapelessダッシュボードにログインします。

- APIキー管理に移動します。

- 作成をクリックして、独自のAPIキーを生成します。

- 作成したら、APIキーをクリックしてコピーします。

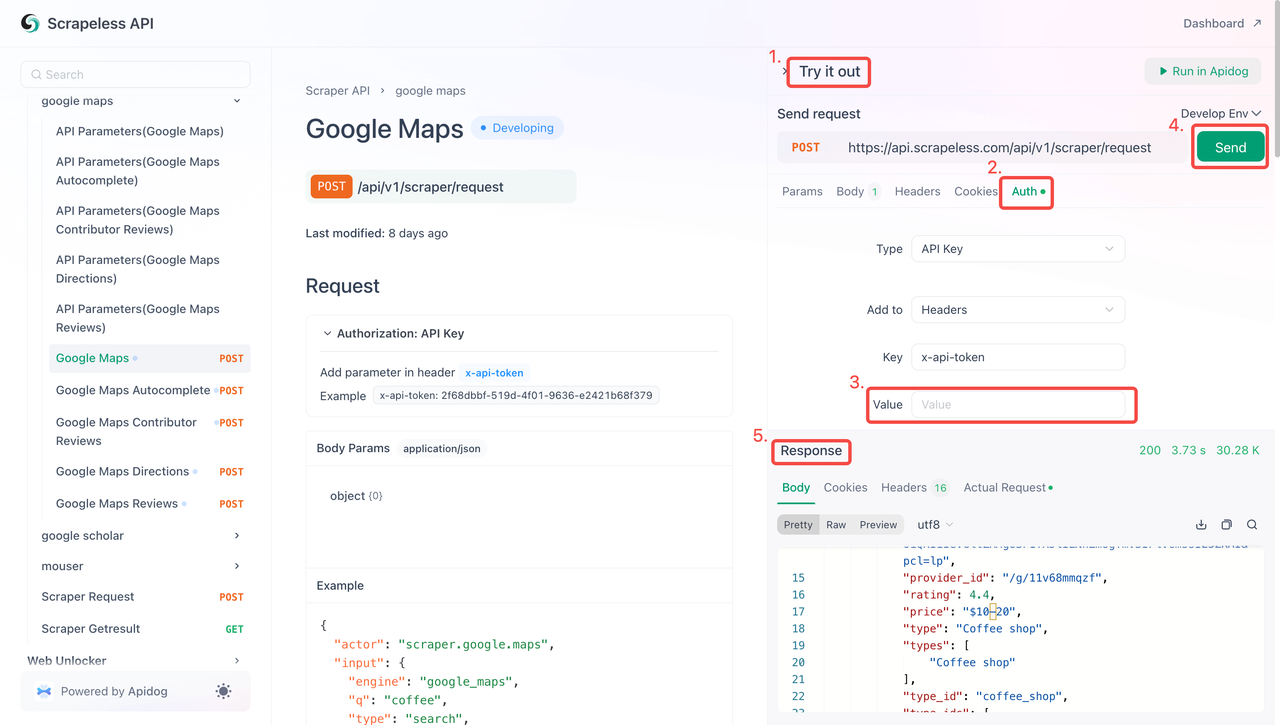

手順2:コードでAPIキーを使用する

これで、APIキーを使用してScrapelessをプロジェクトに統合できます。APIをテストして実装するには、次の手順に従います。

- APIドキュメントにアクセスします。

- 目的のエンドポイントで「Try it out」をクリックします。

- 「Auth」フィールドにAPIキーを入力します。

- 「Send」をクリックして、スクレイピング応答を取得します。

以下は、Googleマップスクレイパーに直接統合できるサンプルコードスニペットです。

Python

Python

import http.client

import json

conn = http.client.HTTPSConnection("api.scrapeless.com")

payload = json.dumps({

"actor": "scraper.google.maps",

"input": {

"engine": "google_maps",

"q": "coffee",

"type": "search",

"ll": "@40.7455096,-74.0083012,14z",

"hl": "en",

"gl": "us"

}

})

headers = {

'Content-Type': 'application/json'

}

conn.request("POST", "/api/v1/scraper/request", payload, headers)

res = conn.getresponse()

data = res.read()

print(data.decode("utf-8"))JavaScript

JavaScript

var myHeaders = new Headers();

myHeaders.append("Content-Type", "application/json");

var raw = JSON.stringify({

"actor": "scraper.google.maps",

"input": {

"engine": "google_maps",

"q": "coffee",

"type": "search",

"ll": "@40.7455096,-74.0083012,14z",

"hl": "en",

"gl": "us"

}

});

var requestOptions = {

method: 'POST',

headers: myHeaders,

body: raw,

redirect: 'follow'

};

fetch("https://api.scrapeless.com/api/v1/scraper/request", requestOptions)

.then(response => response.text())

.then(result => console.log(result))

.catch(error => console.log('error', error));#2 ParseHub – 複雑なウェブサイト向けのビジュアルスクレイピングツール

- 主な機能:

✅ ビジュアルインターフェース、技術的な知識のないユーザーに適している

✅ ウェブスクレイピングのスケジュール設定

ParseHubは、強力なビジュアルデータ収集機能を提供しており、プログラミング経験のないユーザーにとって優れた選択肢です。JavaScriptでレンダリングされたウェブサイトの処理もサポートしています。ただし、無料版は機能が制限されているため、完全にコミットすることなくウェブスクレイピングを試したいウェブデータ愛好家にとって特に魅力的です。

#3 Diffbot – ニュースや記事のスクレイピングに最適なAIウェブ構造解析

- 主な機能:

✅ AIコンテンツ認識、ルールを手動で設定する必要がない

✅ 記事、コメントなど、非構造化データに適している

Diffbotは、AIテクノロジーを使用してウェブ構造を解析するツールであり、ニュースウェブサイトやブログなどの非構造化コンテンツからデータ抽出に特に適しています。強力なAIモデルにより、ユーザーはスクレイピングルールを手動で設定することなく、必要な情報を簡単に抽出できます。

#4 Outscraper – Google検索とマップのデータスクレイピングに最適

- 主な機能:

✅ Googleデータ用に特別に設計されており、優れたスクレイピングパフォーマンスを発揮する

✅ 自動化されたデータ収集のためのAPIサポートを提供する

✅ Googleマップと検索結果からデータ抽出できる

Outscraperは、GoogleマップやGoogle検索結果などのGoogle関連データのスクレイピングに重点を置いており、ローカルビジネスデータ分析に非常に適しています。APIを通じて、ユーザーはデータ収集タスクを迅速に統合および自動化できます。

#5 WebHarvy – Windowsデスクトップウェブスクレイピングツール

- 主な機能:

✅ ユーザーフレンドリーなインターフェース、小規模なデータスクレイピングタスクに最適

✅ 購入後に生涯使用可能

WebHarvyは、Windowsデスクトップベースのビジュアルスクレイパーであり、小規模なデータ収集タスクに最適です。ユーザーフレンドリーなインターフェースは、技術的な知識のないユーザー向けに設計されており、グラフィカルインターフェースを介してスクレイピングルールを簡単に設定できます。

#6 DataMiner – 小規模なクローラー向けの軽量Chrome拡張機能

- 主な機能:

✅ インストール後にすぐに使用可能、敷居が低い

✅ 表やリストなどの構造化データのクロールに適している

DataMinerは、小規模なデータスクレイピングタスクに適した軽量なChrome拡張機能です。インストールと使用が簡単であるため、表やリストなどの構造化データの抽出に最適です。

#7 Simplescraper – APIフレンドリーな軽量スクレイピングツール

- 主な機能:

✅ APIへの迅速なアクセス、自動化されたスクレイピングをサポートする

✅ 使いやすい、技術的な知識のないユーザーに適している

✅ 安定したAPIパフォーマンスを持つ小規模プロジェクトに最適

Simplescraperは、ユーザーフレンドリーなAPIを提供しており、中規模プロジェクトのユーザーに最適であり、迅速なウェブデータスクレイピングと自動化された処理を可能にします。スクレイピングワークフローを既存のシステムに統合しようとする開発者にとって最適です。

#8 Browse AI – ウェブサイトの変更の監視用に設計されている

- 主な機能:

✅ ウェブデータの変更を自動的に追跡する

✅ 競合分析と価格追跡に最適

✅ ビジュアル設定インターフェースを備えている

Browse AIは、ウェブサイトデータの変更監視に特化しており、価格追跡や市場監視などの定期的なタスクに適しています。指定されたウェブページの更新を自動的に監視でき、競合分析やSEOデータ監視のニーズに対応できます。

まとめ

ノーコードウェブスクレイパーは、データ収集と非技術系チームのギャップを埋めますが、複雑なインフラストラクチャを最初から開発することなくデータを迅速に収集できるようにするため、技術系チームにも役立ちます。

公開ウェブデータの収集をナビゲートすることは、難しい作業になる可能性があります。しかし、上記の8つの優れたノーコードウェブスクレイピングツールを使用することで、プログラマーではないユーザーでも、ウェブスクレイピングを簡単に活用できるようになりました。残りの作業は、プロジェクトの要件を満たすツールを選択することだけです。

ウェブサイトのスクレイピングと自動化ツールについてさらに知りたいですか?より効果的なソリューションの詳細を読む!

FAQ

1. ノーコードスクレイパーの使用は合法ですか?

一般的に、公開されているデータをスクレイピングすることは合法です。ただし、個人データ、知的財産、またはログインの背後にあるデータをスクレイピングすることは、法的懸念を引き起こす可能性があります。

2. ノーコードスクレイパーはどのように機能しますか?

ノーコードスクレイパーは、ユーザーフレンドリーなインターフェースを提供し、ユーザーはコードを記述せずにウェブサイトからデータ抽出できます。ユーザーはウェブページ上の要素を選択して、抽出するデータを定義できます。その後、ツールはウェブサイトのナビゲーション、指定されたデータの抽出、およびCSVやJSONなどの構造化された形式でのエクスポートのプロセスを自動化します。

3. ノーコードスクレイパーを使用して、任意のウェブサイトからデータをスクレイピングできますか?

ノーコードスクレイパーは多くのウェブサイトで使用できますが、スクレイピング活動がウェブサイトの利用規約および適用される法律に準拠していることを確認することが重要です。

4. ノーコードスクレイパーによって取得されたデータは信頼できますか?

はい。Scrapelessを例に挙げましょう。Scrapelessは99%の成功率と信頼性を保証します。Googleトレンドのスクレイピングの安定性と精度は、ほぼ100%に達しています!

Scrapelessでは、適用される法律、規制、およびWebサイトのプライバシーポリシーを厳密に遵守しながら、公開されているデータのみにアクセスします。 このブログのコンテンツは、デモンストレーションのみを目的としており、違法または侵害の活動は含まれません。 このブログまたはサードパーティのリンクからの情報の使用に対するすべての責任を保証せず、放棄します。 スクレイピング活動に従事する前に、法律顧問に相談し、ターゲットウェブサイトの利用規約を確認するか、必要な許可を取得してください。