動的コンテンツをBeautifulSoupで処理する方法? 2025年の決定版ガイド

Expert Network Defense Engineer

主なポイント:

- BeautifulSoupは静的HTML用であり、動的コンテンツをレンダリングするためにJavaScriptを実行できません。

- 動的コンテンツをスクレイプするには、BeautifulSoupをブラウザ自動化ツール(Selenium、Playwright)や特化したAPIと組み合わせます。

- ブラウザ自動化によってページがレンダリングされ、BeautifulSoupが完全なHTMLを解析できるようになります。

- 動的コンテンツが既知のAPIエンドポイントから発生する場合、APIを直接クエリすることは非常に効率的です。

- 特化したウェブスクレイピングAPIは、複雑なJavaScript駆動サイトのためのスリムなソリューションを提供します。

はじめに

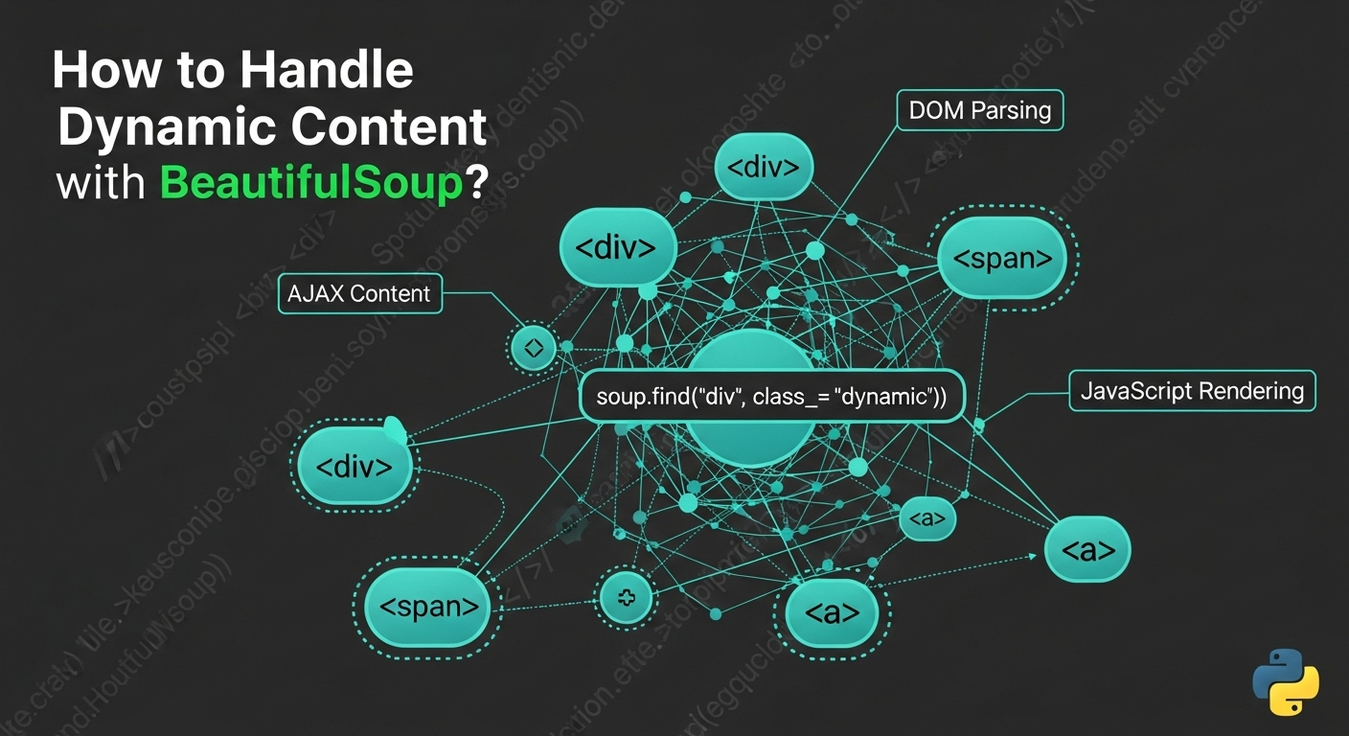

ウェブスクレイピングはしばしば課題に直面します:動的コンテンツ。モダンなウェブサイトはJavaScriptを使用してデータを読み込み、要素を非同期にレンダリングするため、BeautifulSoupだけではコンテンツが見えません。BeautifulSoupは静的HTMLを解析するのに優れていますが、JavaScriptを実行することはできません。このガイドでは、BeautifulSoupを使用して動的コンテンツを処理するための効果的な方法を探求し、JavaScript駆動のウェブサイトから信頼性のあるデータを抽出するための実用的な例とベストプラクティスを提供します。

動的コンテンツとBeautifulSoupの制限を理解する

動的コンテンツとは、初期HTMLの後に読み込まれたり生成されたりするウェブページ要素を指し、通常はJavaScriptを介して行われます。例としては、AJAXコール、クライアントサイドレンダリング(React、Angular)、およびWebSocketsがあります。BeautifulSoupは静的パーサーであり、受け取ったHTMLのみを処理し、JavaScriptエンジンやレンダリング機能を持っていません。したがって、初回ページロード後にJavaScriptによって生成されたコンテンツにアクセスすることはできません。これを克服するために、BeautifulSoupはブラウザ環境をシミュレートするツールと組み合わせる必要があります。

解決策1: BeautifulSoupとSeleniumの組み合わせ

Seleniumはウェブブラウザを自動化し、JavaScriptを実行し、ウェブ要素と対話します。これを使用してページを読み込み、動的なコンテンツをレンダリングさせた後、BeautifulSoupが解析できる完全なHTMLを抽出します。

仕組み:

Seleniumはブラウザを起動し、URLに移動し、JavaScriptが実行されるのを待ち、完全なHTMLソースを取得し、それをBeautifulSoupに渡します。

インストール:

bash

pip install selenium beautifulsoup4 webdriver_managerPythonコード例(スニペット):

python

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

from webdriver_manager.chrome import ChromeDriverManager

from bs4 import BeautifulSoup

import time

def scrape_dynamic_content_selenium(url):

options = webdriver.ChromeOptions()

options.add_argument('--headless')

driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()), options=options)

driver.get(url)

time.sleep(5) # 遅延を調整

html_content = driver.page_source

soup = BeautifulSoup(html_content, 'html.parser')

# ... soupでデータを抽出 ...

driver.quit()長所と短所:

- 長所: 完全なJavaScript実行、ブラウザとの対話、広く採用されている。

- 短所: リソース集約型、遅く、複雑なセットアップ、ボット検出に敏感 [1]。

解決策2: BeautifulSoupとPlaywrightの組み合わせ

PlaywrightはChromium、Firefox、WebKitブラウザを制御するためのモダンライブラリです。強力な待機メカニズムを提供し、動的コンテンツに対してはSeleniumよりもパフォーマンスが高いことが多いです。

仕組み:

Playwrightはブラウザを起動し、URLに移動し、コンテンツが読み込まれるのを待ち、完全なHTMLを取得し、それをBeautifulSoupに渡します。

インストール:

bash

pip install playwright beautifulsoup4

playwright installPythonコード例(スニペット):

python

from playwright.sync_api import sync_playwright

from bs4 import BeautifulSoup

def scrape_dynamic_content_playwright(url):

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto(url, wait_until="networkidle")

html_content = page.content()

soup = BeautifulSoup(html_content, 'html.parser')

# ... soupでデータを抽出 ...

browser.close()長所と短所:

- 長所: マルチブラウザサポート、モダンAPI、高速、自動待機。

- 短所: リソース集約型、ブラウザバイナリが必要、ボットシステムに検出される可能性がある [2]。

解決策3: BeautifulSoupとRequests-HTMLの組み合わせ

requests-htmlはrequestsを拡張して、ヘッドレスChromiumインスタンスを使用してJavaScriptをレンダリングし、完全なブラウザ自動化なしで動的コンテンツを処理するよりシンプルな方法を提供します。

仕組み:

requests-htmlは初期HTMLを取得し、バックグラウンドでJavaScriptをレンダリングし、処理されたHTMLをBeautifulSoup解析用に提供します。

インストール:

bash

pip install requests-html beautifulsoup4Pythonコード例(スニペット):

python

from requests_html import HTMLSession

from bs4 import BeautifulSoup

def scrape_dynamic_content_requests_html(url):

session = HTMLSession()

r = session.get(url)

r.html.render(sleep=3, keep_page=False)

html_content = r.html.html

soup = BeautifulSoup(html_content, 'html.parser')

# ... soupでデータを抽出 ...セッションを閉じる

### 利点と欠点:

* **利点:** シンプルなAPI、統合されたリクエストとレンダリング、軽量である可能性。

* **欠点:** 複雑なJS/アンチボットに対して堅牢性が低い、Chromium依存、ページ数が多いと遅くなる可能性があります。

## 解決策4: BeautifulSoupとSplashの組み合わせ

Splashは、サーバー上で動作するスクリプト可能なヘッドレスブラウザで、特にScrapyとの統合に最適な制御されたJavaScriptレンダリングです。

### 仕組み:

スクリプトがSplashサーバーにリクエストを送信し、ページがレンダリングされ、BeautifulSoupが解析するための完全なHTMLを返します。

### インストール:

Splashを実行するにはDockerが必要です:

```bash

docker run -p 8050:8050 scrapinghub/splashPythonコード例(スニペット):

python

import requests

from bs4 import BeautifulSoup

def scrape_dynamic_content_splash(url, splash_url="http://localhost:8050"):

payload = {

"url": url,

"wait": 2,

"html": 1

}

response = requests.get(f"{splash_url}/render.html", params=payload)

html_content = response.text

soup = BeautifulSoup(html_content, 'html.parser')

# ... soupを使ってデータを抽出 ...利点と欠点:

- 利点: 隔離された環境、スクリプト化可能、Scrapyとの統合に適している。

- 欠点: 複雑なセットアップ(Docker)、パフォーマンスオーバーヘッド、リソース集約型。

解決策5: APIを直接クエリする(利用可能な場合)

動的コンテンツは、多くの場合、バックエンドAPIへのAJAXリクエストを介して読み込まれます。これらのAPIを直接クエリする方が、ブラウザのレンダリングよりも効率的である可能性があります。

仕組み:

ブラウザの開発者ツールでネットワークトラフィックを調査してAPIエンドポイントを見つけます。Pythonのrequestsライブラリを使用してリクエスト(メソッド、ヘッダー、ペイロード)を再現します。JSON/XMLレスポンスを解析します。オプションで、APIがHTMLスニペットを返す場合はBeautifulSoupを使用します。

インストール:

bash

pip install requests beautifulsoup4Pythonコード例(スニペット):

python

import requests

import json

from bs4 import BeautifulSoup

def scrape_dynamic_content_api(api_url, headers=None, params=None, data=None):

response = requests.get(api_url, headers=headers, params=params) # または requests.post

response.raise_for_status()

api_data = response.json()

# ... api_dataを処理 ...

# APIがHTMLスニペットを返した場合:

# soup = BeautifulSoup(api_data["html_content"], 'html.parser')

# ... soupを使って解析 ...利点と欠点:

- 利点: 高速、リソース軽量、ターゲットデータ、アンチボットへの耐性が高い。

- 欠点: APIの発見が必要、APIの変更に脆弱、認証処理、常に利用可能ではない。

解決策6: ヘッドレスブラウザ(スタンドアロン)

完全な自動化フレームワークなしで軽量レンダリングをするために、pyppeteer(PuppeteerのPython版)などのヘッドレスブラウザは、JavaScriptが重いページをレンダリングするためのプログラム制御を提供します。

仕組み:

ヘッドレスブラウザが起動し、URLに移動してJavaScriptを実行し、完全なHTMLを抽出し、その後BeautifulSoupに渡されます。

インストール(pyppeteer用):

bash

pip install pyppeteer beautifulsoup4Pythonコード例(スニペット):

python

import asyncio

from pyppeteer import launch

from bs4 import BeautifulSoup

async def scrape_dynamic_content_pyppeteer(url):

browser = await launch(headless=True)

page = await browser.newPage()

await page.goto(url, waitUntil="networkidle0")

html_content = await page.content()

soup = BeautifulSoup(html_content, 'html.parser')

# ... soupを使ってデータを抽出 ...

await browser.close()利点と欠点:

- 利点: 軽量レンダリング、最新のJavaScriptサポート、細かな制御。

- 欠点:

asyncioが必要、リソース消費、Chromiumのセットアップ。

解決策7: ウェブスクレイピングAPIの利用(専門サービス)

複雑なシナリオでは、専門のウェブスクレイピングAPIがブラウザレンダリング、JavaScript実行、IPローテーション、アンチボット回避を処理し、完全にレンダリングされたHTMLまたは構造化データを返します。

仕組み:

スクリプトがターゲットURLを持つシンプルなHTTPリクエストをAPIに送信します。APIはすべてのレンダリングとアンチボット対策を処理し、その後BeautifulSoupが解析するためのクリーンなHTMLを返します。

インストール:

bash

pip install requests beautifulsoup4Pythonコード例(スニペット):

python

import requests

from bs4 import BeautifulSoup

import json

def scrape_dynamic_content_api_service(target_url, api_key, api_endpoint="https://api.scrapeless.com/v1/scrape"):

payload = {

"url": target_url,

"api_key": api_key,

"render_js": True,

}

headers = {"Content-Type": "application/json"}

response = requests.post(api_endpoint, headers=headers, data=json.dumps(payload))

response.raise_for_status()

response_data = response.json()

html_content = response_data.get("html")

if html_content:

soup = BeautifulSoup(html_content, "html.parser")

# ... soupを使ってデータを抽出 ...- 利点: シンプルさ、高い成功率、スケーラビリティ、効率性、データへの集中。

- 欠点: 有料サービス、外部依存、制御が少ない。

ソリューション8: Scrapyとの統合

Scrapyは、高レベルのウェブスクレイピングフレームワークです。JavaScriptをネイティブで実行することはありませんが、ミドルウェアを介してSplashやSelenium/Playwrightなどのツールと統合し、動的コンテンツを処理できるため、大規模プロジェクトに適しています。

仕組み:

Scrapyはリクエストを送信し、ミドルウェアによってインターセプトされ、JavaScriptレンダリングサービスに転送されます。レンダリングされたHTMLがScrapyに返され、その後、BeautifulSoupまたはScrapy独自のセレクタで解析できます。

インストール:

bash

pip install scrapy beautifulsoup4

# Splash統合用: pip install scrapy-splash およびDockerコンテナの実行利点と欠点:

- 利点: スケーラビリティ、堅牢性、柔軟性、大規模プロジェクトに最適。

- 欠点: 学習曲線が急、単純なタスクに対するオーバーヘッド、JavaScriptレンダリングには外部サービスが必要。

ソリューション9: requests_htmlを使用したシンプルなJavaScriptレンダリング

requests_htmlは、requestsをヘッドレスChromiumと組み合わせてJavaScriptをレンダリングし、完全なブラウザ自動化よりもシンプルなアプローチを提供します。

仕組み:

生のHTMLを取得し、ヘッドレスブラウザでJavaScriptをレンダリングした後、BeautifulSoupで解析するために完全にレンダリングされたHTMLを提供します。

インストール:

bash

pip install requests-html beautifulsoup4Pythonコード例(スニペット):

python

from requests_html import HTMLSession

from bs4 import BeautifulSoup

def scrape_dynamic_content_requests_html_simple(url):

session = HTMLSession()

r = session.get(url)

r.html.render(sleep=2, keep_page=False)

html_content = r.html.html

soup = BeautifulSoup(html_content, 'html.parser')

# ... データを抽出する ...

session.close()利点と欠点:

- 利点: シンプルさ、リクエスト/レンダリング統合、リソース効率が高い可能性。

- 欠点: 複雑なJS/アンチボットにはあまり堅牢でない、Chromium依存、遅くなる可能性あり。

ソリューション10: 組み込みJavaScriptレンダリングのあるプロキシサービスを使用

高度なプロキシサービスは、組み込みのJavaScriptレンダリングを提供し、プロキシ、CAPTCHA、アンチボット対策を処理しながら完全にレンダリングされたHTMLを返す仲介者として機能します。

仕組み:

スクリプトがプロキシサービスにリクエストを送信し、JavaScriptでページをレンダリングして、BeautifulSoup解析用の完全なHTMLを返します。

インストール:

bash

pip install requests beautifulsoup4Pythonコード例(スニペット):

python

import requests

from bs4 import BeautifulSoup

import json

def scrape_dynamic_content_proxy_service(target_url, proxy_api_key, proxy_endpoint="https://api.someproxyservice.com/render"):

payload = {

"url": target_url,

"api_key": proxy_api_key,

"render_js": True,

}

headers = {"Content-Type": "application/json"}

response = requests.post(proxy_endpoint, headers=headers, data=json.dumps(payload))

response.raise_for_status()

response_data = response.json()

html_content = response_data.get("html")

if html_content:

soup = BeautifulSoup(html_content, "html.parser")

# ... データを抽出する ...利点と欠点:

- 利点: 簡素化されたインフラストラクチャ、統合ソリューション(JSレンダリング、アンチボット)、スケーラビリティ、使いやすさ。

- 欠点: 有料サービス、外部依存、制御が少ない。

比較概要: BeautifulSoupを用いた動的コンテンツのソリューション

| ソリューション | 複雑さ(設定/メンテナンス) | コスト(典型的) | パフォーマンス | 堅牢性(アンチボット) | 最適な用途 |

|---|---|---|---|---|---|

| 1. BeautifulSoup + Selenium | 中から高 | 低(無料) | 中程度 | 低から中程度 | 複雑なインタラクション、テスト、小規模から中規模のスクレイピング |

| 2. BeautifulSoup + Playwright | 中 | 低(無料) | 良好 | 低から中程度 | モダンなWebアプリ、マルチブラウザテスト、小規模から中規模のスクレイピング |

| 3. BeautifulSoup + Requests-HTML | 低から中 | 低(無料) | 中程度 | 低 | シンプルな動的ページ、クイックスクリプト、複雑性の低いJSレンダリング |

| 4. BeautifulSoup + Splash | 高(Docker) | 低(無料) | 中程度 | 中程度 | Scrapy統合、孤立したレンダリング、複雑なJS、大規模プロジェクト |

| 5. APIを直接クエリする | 低 (発見) | 低 (無料) | 高 | 高 (APIが安定している場合) | 既知のAPIからの構造化データ、高速、リソース効率が良い |

| 6. BeautifulSoup + ヘッドレスブラウザ (例: Pyppeteer) | 中程度 | 低 (無料) | 良い | 低から中程度 | 簡単なJSレンダリング、プログラム的なブラウザ制御、完全なフレームワークよりもオーバーヘッドが少ない |

| 7. BeautifulSoup + ウェブスクレイピングAPI | 低 | 中程度から高 | 非常に高い | 非常に高い | 大規模で複雑なサイト、アンチボット回避、高い信頼性 |

| 8. Scrapy統合 (Splash/Selenium使用) | 非常に高い | 低 (無料) | 高 | 中程度から高 | エンタープライズグレード、大規模なクローリング、堅牢なデータパイプライン |

9. requests_html (スタンドアロン) |

低 | 低 (無料) | 中程度 | 低 | 簡単なスクリプト、基本的なJSレンダリング、Pythonicなアプローチ |

| 10. JSレンダリング付きプロキシサービス | 低 | 中程度から高 | 高 | 高 | インフラのオフロード、アンチボット、中程度から大規模なスクレイピング |

Scrapelessが最良の代替案である理由

BeautifulSoupはHTMLの解析に優れていますが、動的コンテンツの処理はしばしば significant な複雑さを追加します。ここで、Scrapelessのような専門のウェブスクレイピングAPIが、流れるような堅牢なソリューションを提供します。Scrapelessは、JavaScriptレンダリング、IPローテーション、アンチボット回避の課題を抽象化し、データ抽出に純粋に集中できるようにします。

Scrapelessが動的コンテンツのスクレイピングを簡素化する方法:

- 自動JavaScriptレンダリング: ScrapelessはすべてのJavaScriptを自動的に実行し、AJAX、クライアントサイドフレームワーク、またはWebSocketからの動的コンテンツが完全にレンダリングされることを保証します。ヘッドレスブラウザを管理する必要はありません。

- 統合されたアンチボットおよびCAPTCHA回避: インテリジェントなIPローテーション、ブラウザフィンガープリンティング、CAPTCHA解決を含む高度な回避技術を統合し、洗練されたアンチボットシステムをシームレスに回避します。

- 簡素化された統合: PythonスクリプトはScrapeless APIにシンプルなHTTPリクエストを送信します。APIが重い処理をすべて行い、BeautifulSoupが解析できるクリーンで完全にレンダリングされたHTMLを返し、コードベースを大幅に削減します。

- スケーラビリティと信頼性: エンタープライズグレードのデータ抽出のために設計されたScrapelessは、比類なきスケーラビリティと高い稼働率を提供し、インフラ、プロキシ、またはブラウザインスタンスを管理する必要はありません。

- コスト効果: プレミアムサービスでありながら、Scrapelessはカスタム動的スクレイピングソリューションを構築および維持するよりもコスト効果が高い場合が多く、開発時間とリソースを節約します。

Scrapelessを統合することで、動的コンテンツのスクレイピングを効率的なプロセスに変換し、JavaScriptレンダリングやアンチボット対策の複雑さを持たずにBeautifulSoupの解析の強みを活用できるようになります。

結論とアクションの呼びかけ

BeautifulSoupで動的コンテンツを処理するには、その静的解析能力を超える必要があります。SeleniumやPlaywrightのようなブラウザ自動化ツールを組み合わせることから、Splashのような専門サービスを利用したりAPIを直接クエリしたりと、さまざまなソリューションが存在します。それぞれの方法には独自の利点とトレードオフがあります。

現代のJavaScriptが重いウェブサイトに取り組む開発者にとって、選択はプロジェクトの規模、動的コンテンツの複雑さ、およびアンチボット回避ニーズに依存します。自己管理されたブラウザ自動化は制御を提供しますが、かなりのオーバーヘッドとメンテナンスが発生します。

効率的、スケーラブル、そして手間のかからないアプローチには、Scrapelessのような専用のウェブスクレイピングAPIが際立っています。JavaScriptレンダリング、IPローテーション、アンチボット回避の複雑さをオフロードすることにより、Scrapelessはインフラ管理なしでBeautifulSoupの解析能力を最大限に引き出すことを可能にします。それは挑戦的な動的ウェブサイトからの信頼性のあるデータ抽出を実現します。

動的ウェブスクレイピングを簡素化する準備はできていますか?

動的コンテンツをデータ抽出の障害にしないでください。Scrapelessがどのようにワークフローを簡素化し、必要なウェブデータへの信頼できるアクセスを提供できるかを探ってみてください。今すぐ無料トライアルを始めて、ウェブスクレイピングの未来を体験してください。

よくある質問 (FAQ)

Q1: なぜBeautifulSoupは動的コンテンツを直接処理できないのですか?

BeautifulSoupは静的なHTMLパーサーです。JavaScriptエンジンとレンダリング機能がないため、追加コンテンツを読み込んだりDOMを変更したりするJavaScriptコードを実行できず、初期ロード後に生成された動的コンテンツは見えません。

Q2: 動的コンテンツには常にヘッドレスブラウザを使用する必要がありますか?

常にそうとは限りません。動的コンテンツが発見可能なAPIから来る場合、requestsを使ってそのAPIを直接クエリする方が効率的です。しかし、複雑なJavaScriptの相互作用、クライアントサイドレンダリング、または隠れたAPIの場合、ヘッドレスブラウザや専門のスクレイピングAPIが必要になります。

Q3: Selenium/PlaywrightとWebスクレイピングAPIの主なトレードオフは何ですか?

Selenium/Playwright: 完全な制御を提供し、無料(インフラを除く)、テストに適しています。リソースを消費し、遅く、セットアップが複雑で、ボット検出に敏感で、高いメンテナンスが必要です。

WebスクレイピングAPI: 非常に効率的で、複雑さを抽象化します(JSレンダリング、プロキシ、ボット対策)、スケーラブルで信頼性があります。料金サービスで、細かい制御が少なく、外部依存性があります。

選択はプロジェクトの規模、予算、望む制御の程度と利便性によります。

Q4: ウェブサイトが動的コンテンツを使用しているかどうかをどうやって識別できますか?

- JavaScriptを無効にする: コンテンツが消える場合、それは動的です。

- ブラウザの開発者ツール(ネットワークタブ): 初期HTMLの後にデータを読み込むXHR/Fetchリクエストを探します。

- ページソースの表示と要素の検査: '要素の検査'がより多くのコンテンツを表示する場合、それは動的です。

Q5: WebスクレイピングAPIから返されたHTMLを解析するのにBeautifulSoupを使用できますか?

はい、これは非常に推奨されます。WebスクレイピングAPIは完全にレンダリングされた静的HTMLを返すため、BeautifulSoupはそれを解析するのに最適に設計されています。これは堅牢なコンテンツアクセスと柔軟なデータ抽出を組み合わせます。

Scrapelessでは、適用される法律、規制、およびWebサイトのプライバシーポリシーを厳密に遵守しながら、公開されているデータのみにアクセスします。 このブログのコンテンツは、デモンストレーションのみを目的としており、違法または侵害の活動は含まれません。 このブログまたはサードパーティのリンクからの情報の使用に対するすべての責任を保証せず、放棄します。 スクレイピング活動に従事する前に、法律顧問に相談し、ターゲットウェブサイトの利用規約を確認するか、必要な許可を取得してください。