Top 5 Ferramentas de Coleta de Dados da Web para 2025

Senior Web Scraping Engineer

O objetivo da coleta de dados da web é extrair informações que estão originalmente dispersas e são difíceis de usar diretamente, e organizá-las em um formato de dados útil, que é então usado para responder a perguntas de negócios, aprimorar algoritmos e competir com outras empresas.

Como coletar dados de sites de forma fácil e precisa?

Este blog apresentará 5 das melhores ferramentas de coleta de dados da web. Comece a ler e obtenha o melhor!

As 5 Melhores Ferramentas de Coleta de Dados da Web

- #1. Scrapeless: Um coletor de dados abrangente.

- #2. Mention: Uma ferramenta útil de monitoramento de notícias e lembrete de palavras-chave.

- #3. SurveyMonkey: Coleta facilmente insights de clientes, funcionários e mercado.

- #4. Lead411: Plataforma precisa de inteligência de vendas.

- #5. Magpi: Um sistema de coleta de dados móvel totalmente funcional.

O Que é Coleta de Dados da Web?

Coleta de dados da web, também conhecida como web scraping ou rastreamento de dados, refere-se ao processo de extração de dados estruturados ou não estruturados da Internet por meio de ferramentas automatizadas.

A coleta de dados da web geralmente usa crawlers para simular usuários visitando sites e extraindo os dados necessários analisando o conteúdo da página da web.

Por exemplo, preços de produtos, informações de estoque e avaliações de usuários de plataformas de comércio eletrônico podem ser coletados, ou tópicos em tendência e dados de interação do usuário nas mídias sociais podem ser coletados. Esses dados podem então ser usados em uma variedade de cenários, como pesquisa de mercado, análise da concorrência, decisões de negócios, otimização de SEO ou modelos de treinamento de inteligência artificial.

O Que as Empresas Esperam Alcançar por Meio da Coleta de Dados da Web?

A coleta de dados da web permite que as empresas aproveitem a vasta quantidade de informações disponíveis online para obter insights acionáveis e impulsionar decisões estratégicas.

Ao coletar e analisar sistematicamente esses dados, as empresas buscam alcançar vários objetivos principais:

- Análise de mercado e previsão de tendências

As empresas usam dados da web para monitorar tendências do setor, preferências do consumidor e demandas de mercado. Isso ajuda-as a ficar à frente dos concorrentes, adaptando-se às tendências emergentes e adaptando seus produtos ou serviços de acordo.

- Inteligência Competitiva

Ao coletar dados de sites concorrentes (por exemplo, preços, ofertas de produtos e estratégias de marketing), as empresas podem identificar lacunas no mercado, otimizar suas próprias estratégias e manter uma vantagem competitiva.

- Insights do Cliente

A coleta de dados da web permite que as empresas analisem o comportamento do cliente, avaliações e feedback. Isso ajuda a entender os pontos problemáticos, preferências e expectativas do consumidor, aumentando a satisfação e a fidelidade do cliente.

- Estratégias de precificação dinâmica

Plataformas de comércio eletrônico e varejistas usam web scraping em tempo real para rastrear os preços dos concorrentes e ajustar dinamicamente seus próprios preços, garantindo que permaneçam competitivos, enquanto maximizam as margens de lucro.

- Otimização de conteúdo

As empresas coletam dados sobre palavras-chave populares, tópicos em tendência e métricas de engajamento do público para otimizar o SEO de seu conteúdo e aumentar sua visibilidade online.

- Gestão de riscos

As empresas usam a coleta de dados de rede para monitorar riscos potenciais, como mudanças regulatórias, problemas de reputação ou interrupções na cadeia de suprimentos. Isso permite que elas tomem medidas proativas e mitiguem os riscos de forma eficaz.

- IA e dados de aprendizado de máquina

As empresas coletam grandes conjuntos de dados para treinar modelos de IA e aprimorar algoritmos de aprendizado de máquina. Por exemplo, raspar dados de imagem, texto ou linguagem ajuda a melhorar soluções baseadas em IA, como sistemas de recomendação ou análise preditiva.

5 Melhores Ferramentas para Coleta de Dados da Web

Critérios de Avaliação

Fornecer transparência sobre a metodologia de classificação. Alguns critérios podem incluir:

- Eficiência: Velocidade e precisão da coleta de dados.

- Recursos antibloqueio: Capacidade de contornar medidas anti-raspagem.

- Experiência do usuário: Facilidade de uso, interface intuitiva e tempo de configuração.

- Compatibilidade: Linguagens, plataformas e integrações suportadas.

- Custo-efetividade: Valor pelo dinheiro com base em recursos e preços.

- Conformidade legal: Adesão a leis de privacidade de dados como GDPR e CCPA.

#1. Scrapeless

Scrapeless destaca-se como a ferramenta principal para coleta de dados da web, oferecendo confiabilidade, acessibilidade e facilidade de uso incomparáveis. Projetado para atender às necessidades da raspagem de dados moderna, o Scrapeless combina tecnologia de ponta com um conjunto de recursos integrados, tornando-o uma solução completa para qualquer desafio de coleta de dados.

Por Que Mais de Dois Mil Negócios Usam o Scrapeless para Coleta de Dados?

- Preços Acessíveis: O Scrapeless foi projetado para oferecer valor excepcional.

- Estabilidade e Confiabilidade: Com um histórico comprovado, o Scrapeless fornece respostas de API estáveis, mesmo sob altas cargas de trabalho.

- Altas Taxas de Sucesso: Diga adeus às extrações malsucedidas e o Scrapeless promete 99,99% de acesso bem-sucedido aos dados da web.

- Escalabilidade: Lidar com milhares de consultas sem esforço, graças à robusta infraestrutura por trás do Scrapeless.

O que diferencia o Scrapeless é sua impressionante estabilidade e alta taxa de sucesso, garantindo operações suaves e ininterruptas. Seu preço econômico o torna acessível a empresas de todos os tamanhos, enquanto sua interface amigável permite que até mesmo usuários não técnicos comecem a usar sem esforço. Além disso, o Scrapeless é reconhecido por seus tempos de resposta rápidos, fornecendo desempenho impecável em vários cenários de raspagem.

O verdadeiro poder da plataforma reside em seus recursos integrados: um desbloqueador da web, navegador de raspagem, API de raspagem, solucionador de CAPTCHA e proxies integrados, todos trabalhando juntos para lidar com tarefas complexas de raspagem da web com facilidade. O Scrapeless emprega tecnologia avançada antidetecção para evitar 99,99% da detecção anti-bot e restrições de rede, oferecendo aos usuários uma solução confiável e eficiente para contornar as barreiras mais difíceis.

#2. Mention

O Mention é uma plataforma de monitoramento de mídia que permite que startups acompanhem as menções de marca e o sentimento na web. Os recursos incluem monitoramento de notícias, alertas de palavras-chave e descoberta de influenciadores.

O Mention permite que pequenas startups fiquem por dentro das conversas online sobre sua marca com uma solução de monitoramento fácil de usar e acessível. Os insights ajudam as equipes a se envolver com potenciais clientes e influenciadores.

#3. SurveyMonkey

O SurveyMonkey fornece às startups uma plataforma de pesquisa online fácil de usar para coletar insights de clientes, funcionários e mercado. Os recursos incluem criação de pesquisas, distribuição, ferramentas de análise e integrações.

O SurveyMonkey permite que empresas em estágio inicial criem e gerenciem pesquisas de feedback sem grande experiência. Planos acessíveis oferecem recursos e suporte poderosos.

#4. Lead411

O Lead411 oferece uma plataforma de inteligência de vendas adaptada para startups que buscam aumentar seu pipeline. Os principais recursos incluem dados de leads e empresas, ferramentas de pesquisa de e-mail e alertas em tempo real.

O Lead411 fornece às equipes de vendas uma maneira fácil de identificar leads e aprimorar campanhas de marketing outbound. O preço competitivo de nível básico remove barreiras ao crescimento precoce.

#5. Magpi

O Magpi é um sistema de coleta de dados móvel feito sob medida para startups e pequenas equipes de pesquisa. Os recursos incluem formulários, pesquisas, captura de dados offline, análises e gerenciamento de conjuntos de dados.

O Magpi fornece às organizações uma maneira de coletar insights em campo sem exigir grande experiência interna. O plano básico oferece recursos avançados para suportar uma variedade de casos de uso.

APIs de Raspagem: O Melhor Método de Coleta de Dados da Web

Muitos sites e plataformas oferecem APIs que permitem que os desenvolvedores acessem dados específicos em um formato estruturado. As APIs são confiáveis, eficientes e geralmente incluem atualizações em tempo real. Os exemplos incluem a API do Twitter, a API do Google SERP e as APIs de comércio eletrônico.

No entanto, eles podem ter limitações, como limites de taxa ou acesso limitado a dados, e geralmente são mais caros do que as APIs fornecidas diretamente pelos sites.

Felizmente, algumas APIs de raspagem de terceiros são acessíveis e possuem um alto grau de estabilidade e sucesso (como o Scrapeless).

O Scrapeless oferece uma plataforma de raspagem da web confiável e escalonável a preços competitivos, garantindo excelente valor para seus usuários:

- Navegador de Raspagem: A partir de US$ 0,09 por hora

- API de Raspagem: A partir de US$ 0,80 por 1.000 URLs

- Desbloqueador da Web: US$ 0,20 por 1.000 URLs

- Solucionador de CAPTCHA: A partir de US$ 0,80 por 1.000 URLs

- Proxies: US$ 2,80 por GB

Ao se inscrever, você pode aproveitar descontos de até 20% em cada serviço. Você tem requisitos específicos? Entre em contato conosco hoje e forneceremos economias ainda maiores, adaptadas às suas necessidades!

Vamos descobrir por que a API de Raspagem do Scrapeless é eficaz para a coleta de dados. Siga minhas etapas para raspar dados da Pesquisa Google.

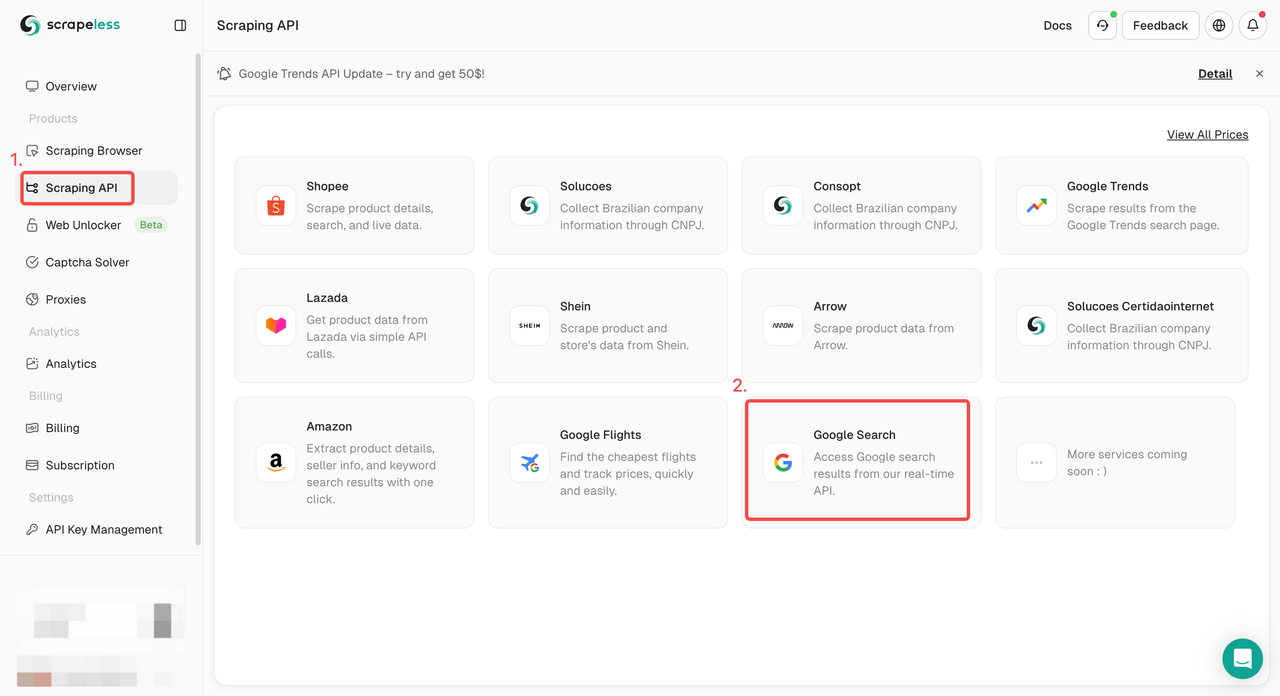

Etapa 1. Faça login no Painel do Scrapeless e vá para "API de Pesquisa Google".

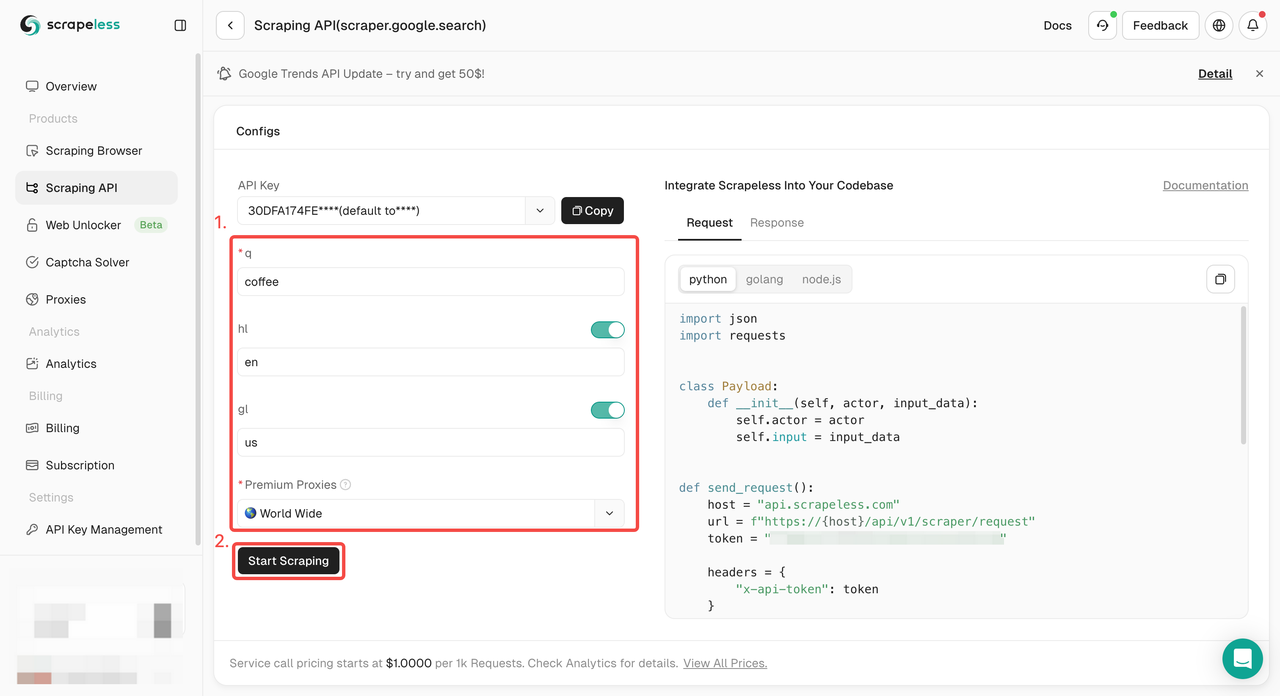

Etapa 2. Configure as palavras-chave, região, idioma, proxy e outras informações necessárias à esquerda. Depois de verificar se tudo está correto, clique em "Iniciar Raspagem".

q: O parâmetro define a consulta que você deseja pesquisar.gl: O parâmetro define o país a ser usado para a pesquisa Google.hl: O parâmetro define o idioma a ser usado para a pesquisa Google.

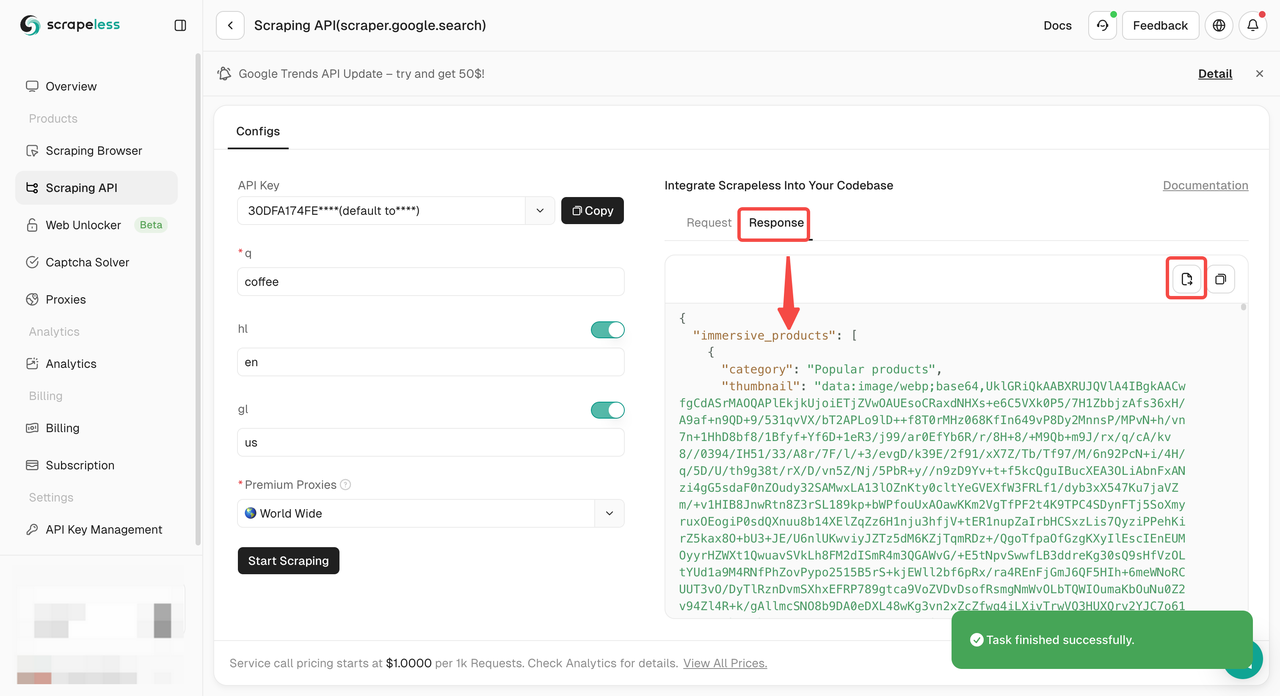

Etapa 3. Obtenha os resultados de rastreamento e exporte-os.

Precisa apenas de um código de exemplo para integrar ao seu projeto? Nós o cobrimos! Ou você pode visitar nossa documentação da API para qualquer idioma que precisar.

- Python:

Python

import http.client

import json

conn = http.client.HTTPSConnection("api.scrapeless.com")

payload = json.dumps({

"actor": "scraper.google.search",

"input": {

"q": "coffee",

"hl": "en",

"gl": "us"

}

})

headers = {

'Content-Type': 'application/json'

}

conn.request("POST", "/api/v1/scraper/request", payload, headers)

res = conn.getresponse()

data = res.read()

print(data.decode("utf-8"))- Golang

Go

package main

import (

"fmt"

"strings"

"net/http"

"io/ioutil"

)

func main() {

url := "https://api.scrapeless.com/api/v1/scraper/request"

method := "POST"

payload := strings.NewReader(`{

"actor": "scraper.google.search",

"input": {

"q": "coffee",

"hl": "en",

"gl": "us"

}

}`)

client := &http.Client {

}

req, err := http.NewRequest(method, url, payload)

if err != nil {

fmt.Println(err)

return

}

req.Header.Add("Content-Type", "application/json")

res, err := client.Do(req)

if err != nil {

fmt.Println(err)

return

}

defer res.Body.Close()

body, err := ioutil.ReadAll(res.Body)

if err != nil {

fmt.Println(err)

return

}

fmt.Println(string(body))

}Por Que Cada Vez Mais Empresas Estão Usando Ferramentas de Coleta de Dados?

- Eficiência e Produtividade Aprimoradas: Os dados criam um ciclo de feedback crucial para as organizações. Por exemplo, uma empresa no setor de tecnologia de anúncios pode usar dados da web para validar automaticamente o texto do anúncio, o posicionamento do link e as imagens, garantindo que o anúncio correto chegue ao público certo, eliminando verificações manuais e otimizando os resultados. 📈

- Tomada de Decisões Mais Rápida e Eficaz: A coleta de dados da web em tempo real permite que as empresas tomem decisões instantâneas importantes. Por exemplo, as empresas de investimento podem coletar dados sobre o volume de negociação de ações ou sentimento social para tomar melhores decisões de compra/venda. 💡

- Melhor Desempenho Financeiro: As empresas podem melhorar a lucratividade analisando o tráfego da web, palavras-chave e tendências de busca, levando a um melhor posicionamento de produtos e marcas e geração de leads mais direcionados. 💰

- Identificação e Criação de Novas Receitas de Produtos e Serviços: Por meio de pesquisas de mercado baseadas em dados, as empresas podem melhorar a lucratividade. Por exemplo, uma empresa que analisa paisagens competitivas pode identificar necessidades não atendidas dos consumidores por meio de avaliações e feedback dos consumidores. 📊

- Experiência do Cliente Aprimorada: As empresas podem usar dados da web para testes de sites e experiência do usuário, garantindo que anúncios, conteúdo e aplicativos funcionem conforme o esperado, com base em dados de usuários geográficos. 🌐

- Vantagem Competitiva: Os dados da web permitem que as empresas obtenham uma vantagem competitiva comparando preços e ofertas de pacotes em tempo real. A indústria de viagens é um ótimo exemplo, onde as agências de viagens online (OTAs) usam a coleta de dados para criar estratégias de precificação dinâmica, prejudicando os concorrentes. 🏆

Encontre Sua Melhor Ferramenta de Coleta de Dados!

Seja para pesquisar um site ou compilar um relatório de conformidade, essas ferramentas de raspagem da web podem ajudá-lo a coletar facilmente as informações de que precisa das pessoas certas. Cada uma das cinco ferramentas neste artigo tem um cenário de aplicação diferente.

No entanto, para evitar a seleção e chamada repetidas, você pode usar o Scrapeless diretamente! É um kit de ferramentas de coleta de dados poderoso. Com suas ferramentas de IA avançadas e renderização JS, você pode obter os dados necessários de forma fácil e precisa.

Na Scorretless, acessamos apenas dados disponíveis ao público, enquanto cumprem estritamente as leis, regulamentos e políticas de privacidade do site aplicáveis. O conteúdo deste blog é apenas para fins de demonstração e não envolve atividades ilegais ou infratoras. Não temos garantias e negamos toda a responsabilidade pelo uso de informações deste blog ou links de terceiros. Antes de se envolver em qualquer atividade de raspagem, consulte seu consultor jurídico e revise os termos de serviço do site de destino ou obtenha as permissões necessárias.