Kayakから航空券データをスクレイピングする方法

Advanced Data Extraction Specialist

Kayakからフライト価格を追跡したり、お得な情報を比較したり、旅行に関する情報を収集したいですか?✈️ フライトデータをスクレイピングすることで、旅行アナリスト、開発者、または最高の航空運賃を探している人など、競争優位に立つことができます。しかし、Kayakの反スクレイピング対策により、データを直接抽出することは困難です。

このガイドでは、ブロックされることなく、適切なツールとテクニックを使用してKayakからフライトデータをスクレイピングする方法を示します。スクレイピング環境のセットアップから、動的コンテンツの処理、制限の回避まで、正確なフライト情報を効率的に収集するために必要なすべてを学習します。始めましょう!

Kayakとは?

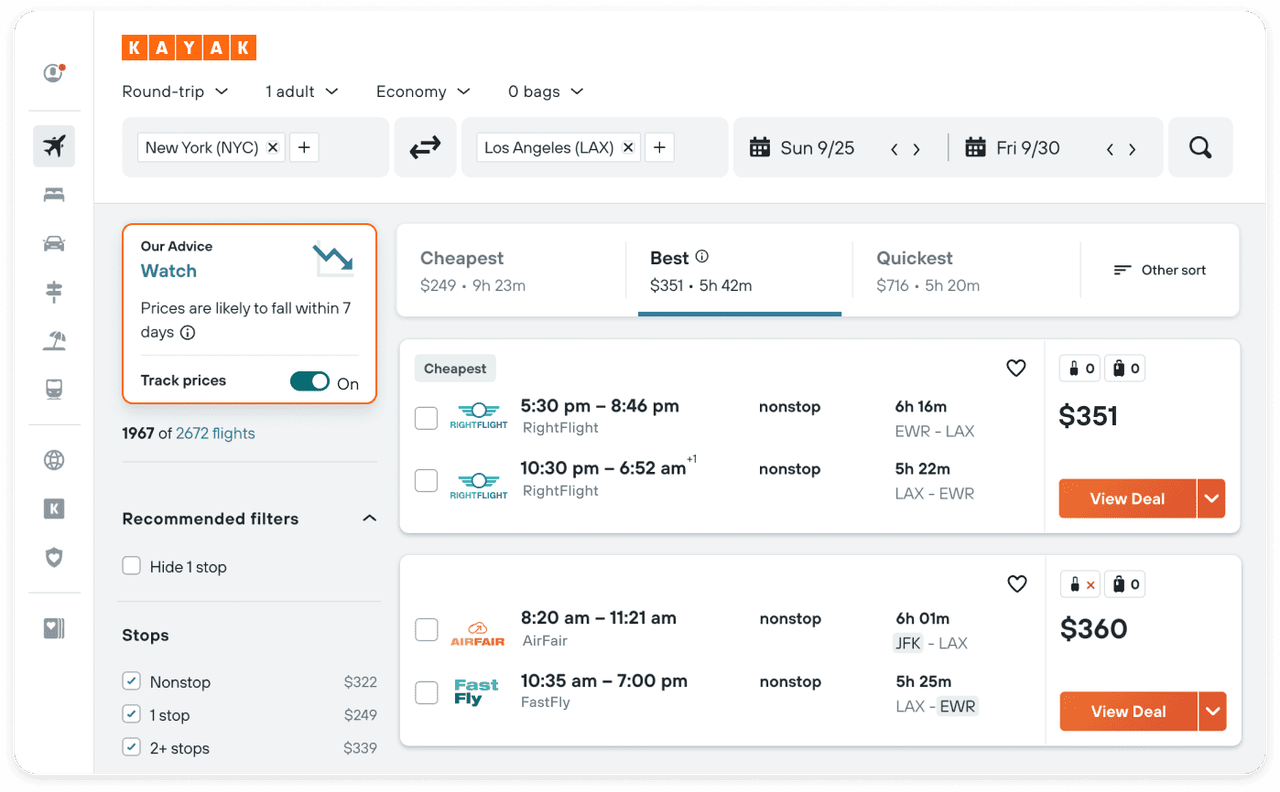

画像引用元:Kayak

2004年にローンチされたKayakは、広く使用されている旅行検索エンジンとなり、旅行者がフライト、ホテル、レンタカー、バケーションパッケージで最高の取引を見つけるのに役立っています。数多くの旅行サイトからの価格を集約および比較することで、Kayakはユーザーがプロバイダーまたは独自のプラットフォームを通じて直接予約できるようにします。

なぜフライトデータをスクレイピングするのですか?

フライトデータは、多くの分野で非常に価値があります。以下に示します。

- 旅行計画:正確でリアルタイムのフライト情報は、プラットフォームがユーザーに最新の旅行情報を提供するのに役立ち、ユーザーが最も適切な時期に旅行を予約できるようにします。

- 価格監視:長期間にわたってフライト価格を追跡することで、企業は価格変動の傾向を特定し、旅行者がチケットを購入するのに最適な時期を予測できます。

- 市場分析:過去のフライトデータは、消費者需要の変化する傾向、人気の旅行期間、価格戦略を明らかにし、観光業界のアナリストや市場調査担当者にとって強力なサポートとなります。

Kayakのデータをスクレイピングすることは合法ですか?

Kayakのデータの技術的な詳細に進む前に、法的および倫理的な問題を検討することが重要です。

- **プラットフォームのルールに従う:**Kayakの利用規約をよく読んで、データスクレイピングが許可されているかどうかを確認してください。

- **robots.txtファイルに従う:**Kayakのrobots.txtファイルを確認して、どのページがクローラーに対して許可されているか、または禁止されているかを理解してください。

- **サーバーへの負荷を避ける:**Kayakのサーバーに過負荷をかけるのを避けるために、クロールリクエストの頻度を合理的に制御してください。

Kayakからフライトデータをスクレイピングする方法

このセクションでは、最も正確で最新の情報を取得できるように、Kayakからフライトデータをスクレイピングするための効果的な方法を紹介します。

1. 使用するツールの紹介

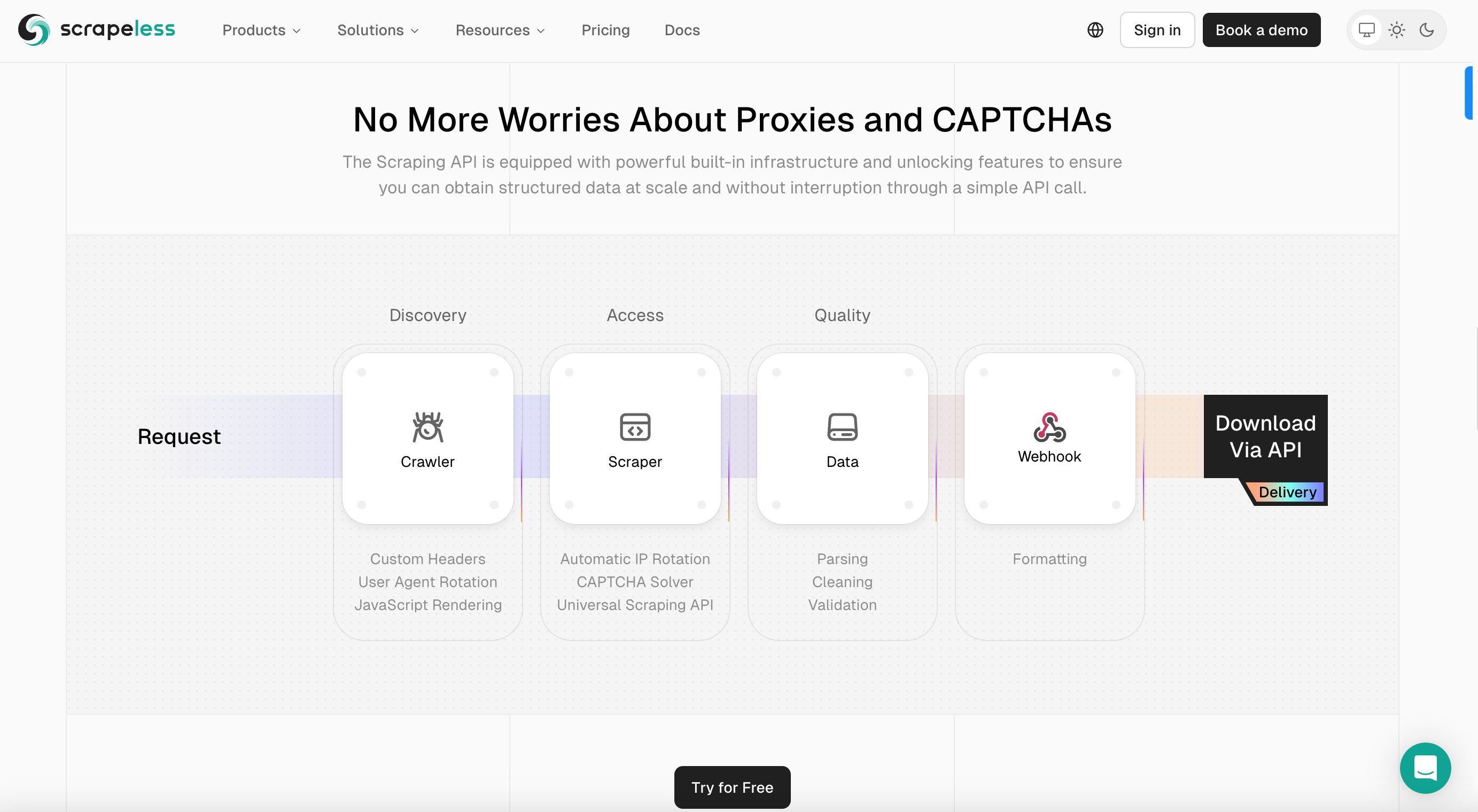

このセクションでは、Scrapelessを使用してKayakフライトデータを簡単にスクレイピングする方法を紹介します。Scrapelessは、シームレスで効率的なデータ抽出を提供するように設計された高度なWebスクレイピングプラットフォームです。

Scrapelessを選択する理由

- **広範なプロキシネットワーク:**Scrapelessは、世界中に広がる高品質のローテーションプロキシの大規模で多様なネットワークを提供します。

- **包括的なデータアクセス:**Scrapelessは、eコマースウェブサイト、検索エンジン、ソーシャルメディアなど、さまざまなデータソースへのアクセスを提供します。

- **リアルタイムデータ伝送:**Scrapelessはリアルタイムのデータ取得を保証し、Kayakフライト情報のスクレイピング、市場調査、競合分析などをサポートします。

- **カスタマイズ可能なデータ収集:**強力なツールとAPI統合により、Scrapelessはユーザーがデータ収集プロセスをカスタマイズできます。

- **コンプライアンスとセキュリティ:**Scrapelessは、データプライバシーとすべての法的要件への準拠を優先します。

2. セットアップと準備

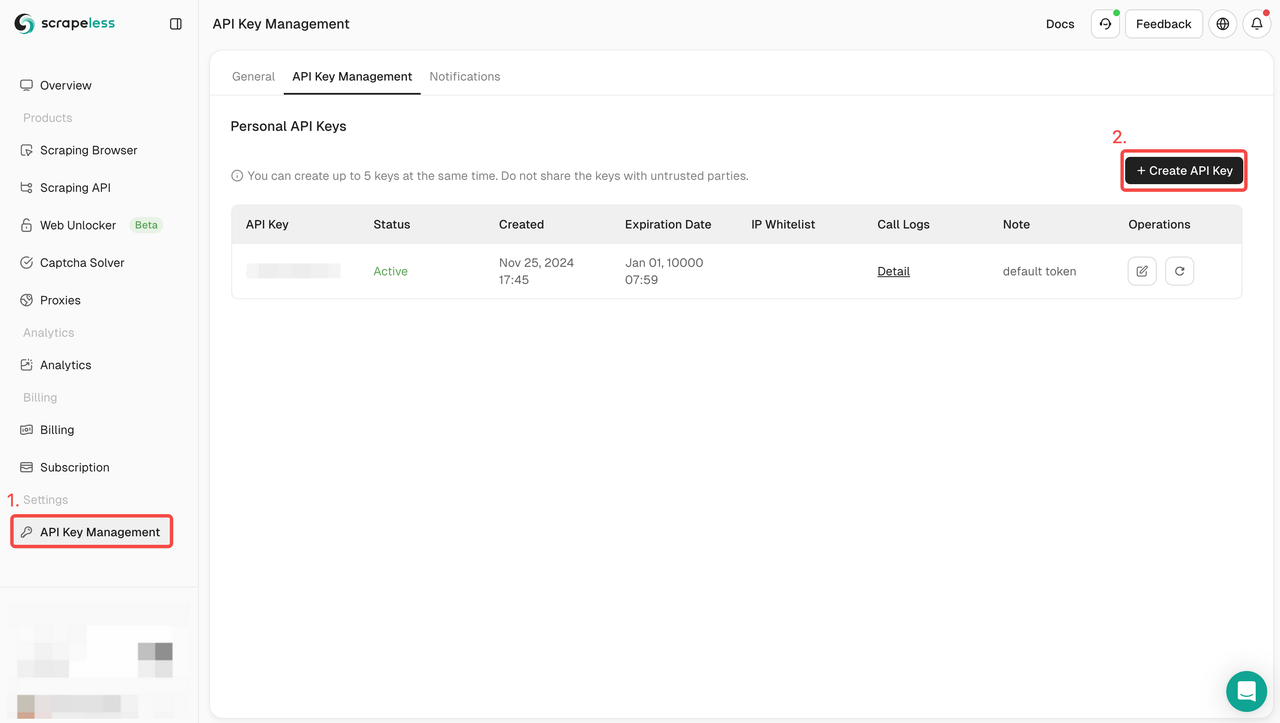

- Scrapelessで無料登録すると、2ドル分の無料クレジットが利用できます。

- APIキー管理に移動します。次に、「作成」をクリックして、一意のAPIキーを生成します。作成後、APをクリックしてコピーします。

3. クローリングコードの記述

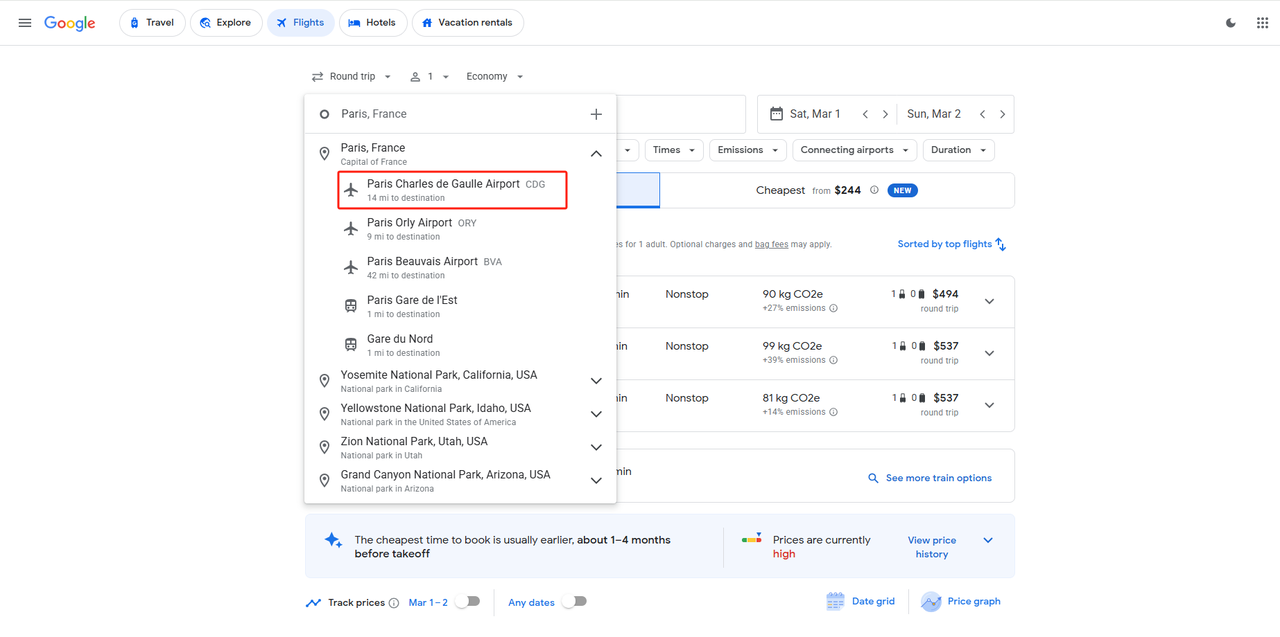

パリのシャルル・ド・ゴール空港からベルリンのブランデンブルク空港に到着し、2025年3月1日に出発し、2025年3月4日に帰国したいとします。出発地、目的地、出発日、帰国日が決まれば、完全なパラメーター構造を形成できます。

input_data = {

"departure_id": "CDG",

"arrival_id": "BER",

"data_type": 1,

"outbound_date": "2025-03-01",

"return_date": "2025-03-04"

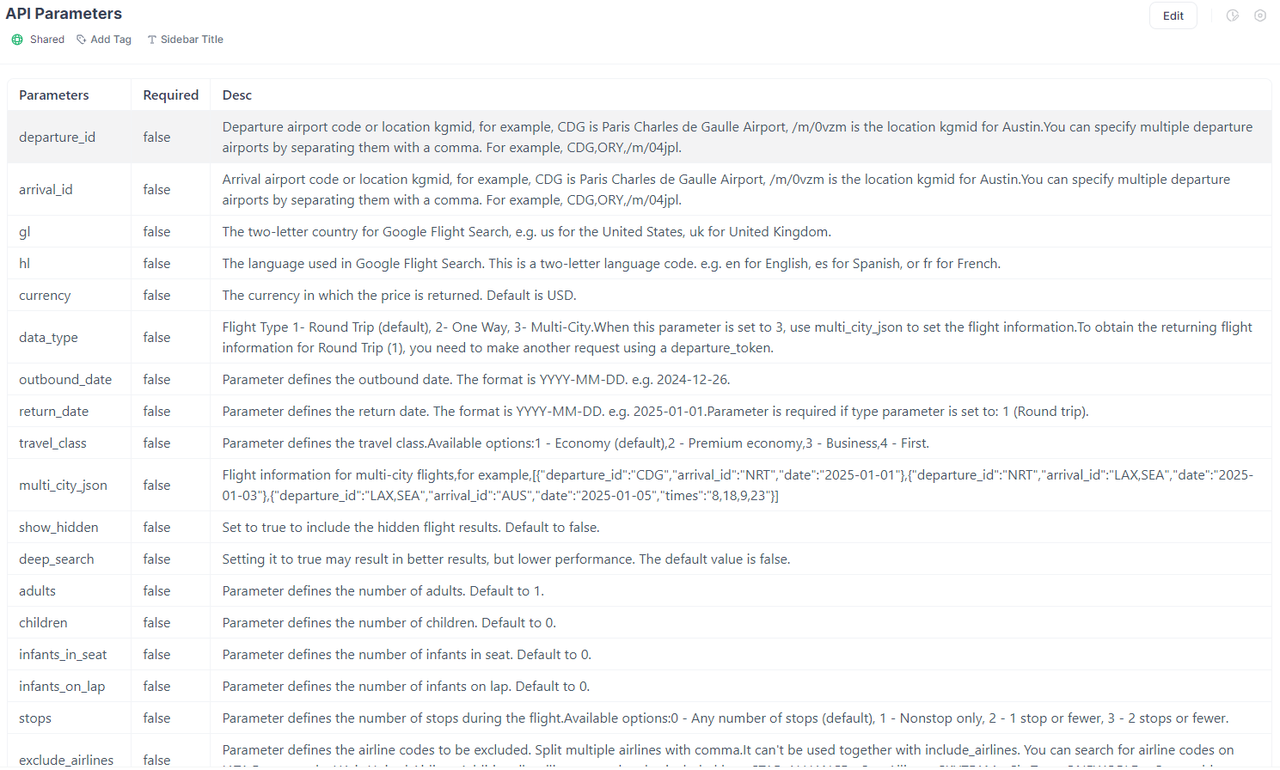

}パラメーターの説明:

departure_idとarrival_idは、入力された空港に対応する空港コードで、国際航空運送協会によって設定されています。対応する空港のコードがわからない場合は、Google Flightsに直接アクセスして出発地と目的地で取得できます。

data_typeは出発の種類を表し、1は往復を表します。

パラメーターが形成された後、完全なコードを組み立てることができます。その際、your_tokenをScrapeless APIキーに置き換える必要もあります。

import json

import requests

class Payload:

def __init__(self, actor, input_data):

self.actor = actor

self.input = input_data

def send_request():

host = "api.scrapeless.com"

url = f"https://{host}/api/v1/scraper/request"

token = "your_token"

headers = {

"x-api-token": token

}

input_data = {

"departure_id": "CDG",

"arrival_id": "BER",

"data_type": 1,

"outbound_date": "2025-03-01",

"return_date": "2025-03-04"

}

payload = Payload("scraper.google.flights", input_data)

json_payload = json.dumps(payload.__dict__)

response = requests.post(url, headers=headers, data=json_payload)

if response.status_code != 200:

print("Error:", response.status_code, response.text)

return

print("body", response.text)

if __name__ == "__main__":

send_request()もちろん、私たちのパラメーターはそれよりもはるかに多いです。乗客数、乗り継ぎ回数、最大価格など、Google Flightsの他のパラメーターも提供できます。詳細については、Scrapeless API公式ウェブサイトのドキュメントを参照してください。

Scrapeless Google Flights APIから多くのデータを取得できます。たとえば、次のとおりです。

- 出発時刻と到着時刻

- 空港情報

- フライト時間

- 炭素排出量情報

- 価格

- 乗り継ぎ情報

- 航空会社情報

- その他

4. CSVへのエクスポート方法

結果をCSVにエクスポートする必要がある場合は、次のコードを追加するだけです。

result = response.json()

best_flights = result['best_flights']

with open('flights-maps-results.csv', 'w', newline='') as csvfile:

csv_writer = csv.writer(csvfile)

# ヘッダーの書き込み

csv_writer.writerow(["departure_time", "arrival_time", "flight_number", "price"])

# データの書き込み

for best_flight in best_flights:

flights = best_flight['flights']

for flight in flights:

departure_airport = flight['departure_airport']

arrival_airport = flight['arrival_airport']

csv_writer.writerow(

[departure_airport["time"], arrival_airport["time"], flight["flight_number"], best_flight["price"]])

print('CSVファイルへの書き込みが完了しました。')5. Scrapelessが他にどのようなデータをクロールできるか?

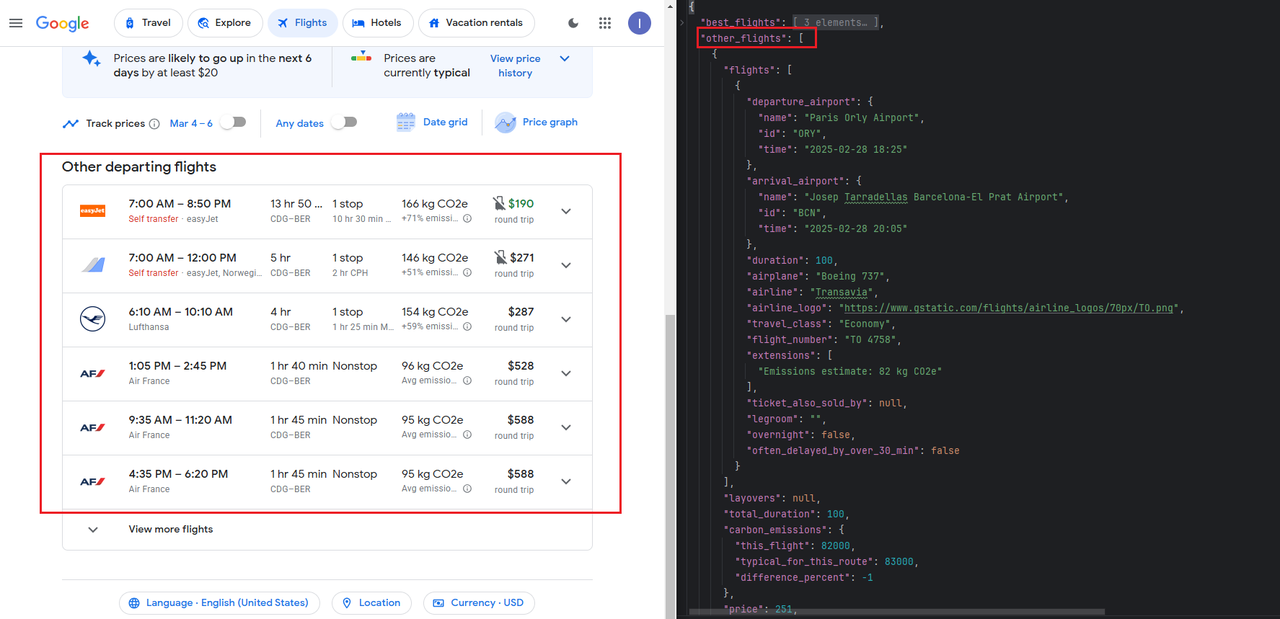

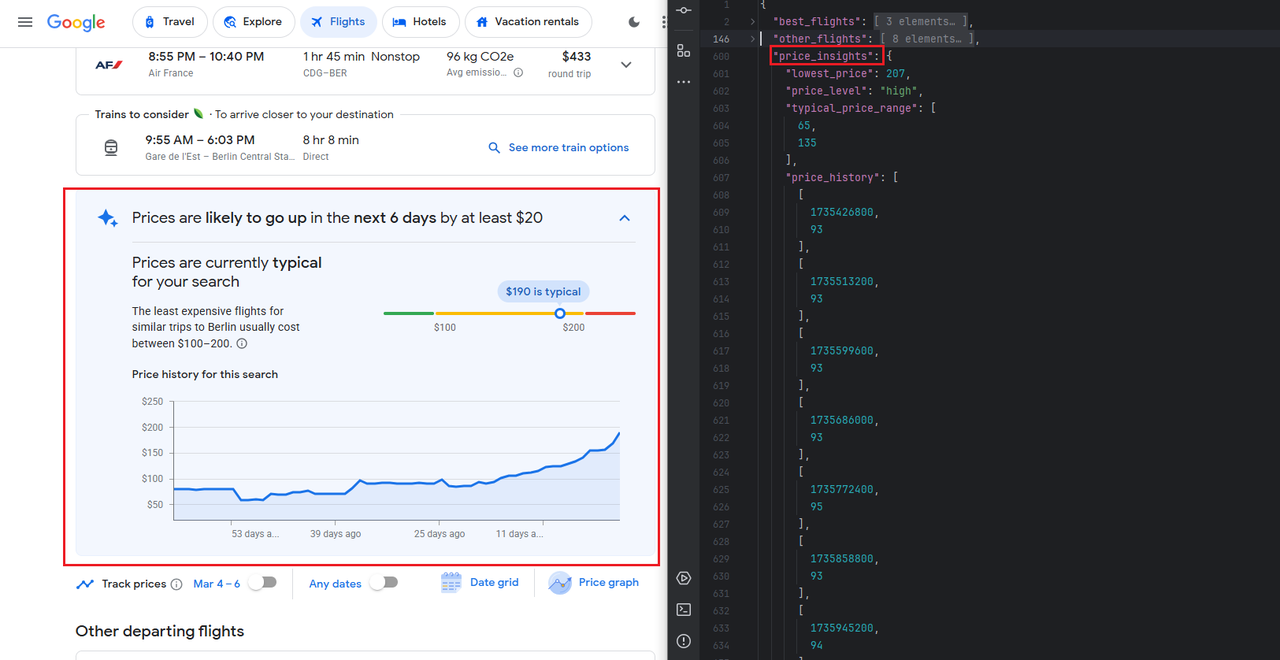

Scrapelessは、上記で示したKayakのフライト時間と価格情報を含む、さまざまなクロールシナリオを提供します。Scrapelessは、「他の出発フライト」、「過去の価格トレンド」などの情報も提供します。異なるパラメーターを構築するだけで済みます。

その他の出発フライト

過去の価格トレンド

さらに、Scrapelessは次のデータインターフェースも提供します。

- Google Maps

- Google Jobs

- Google Trends

- Google Hotel

…

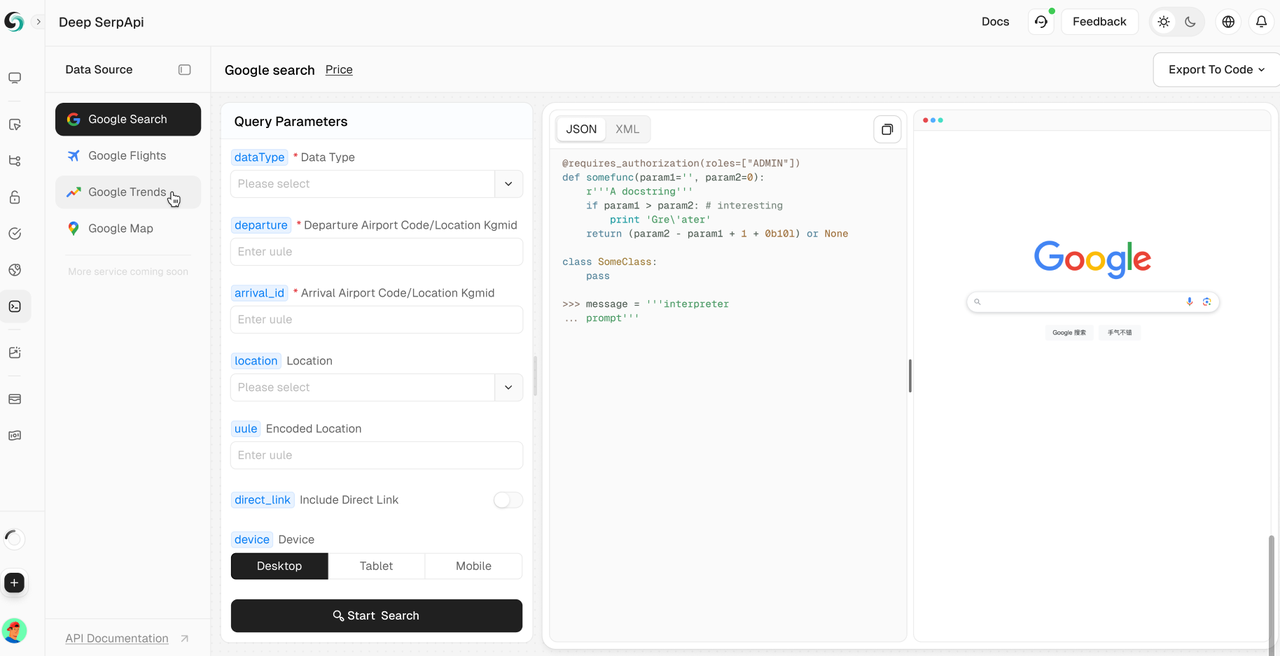

その他のツールのおすすめ:Scrapeless Deep SerpApi

Deep SerpApiは、大規模言語モデル(LLM)とAIエージェント向けの専用の検索エンジンであり、リアルタイムで正確かつ公平な情報を提供し、AIアプリケーションがデータを効率的に取得および処理するのに役立つことを目的としています。

主な機能:

- 包括的なデータカバレッジと高価値クロール:20以上のGoogle Search APIシナリオインターフェースを内蔵し、主要な検索エンジンからのデータにアクセスできます。

- リアルタイムデータ更新:過去24時間の履歴データ更新をサポートし、最新の情報を保証します。

- 費用対効果:Deep SerpApiは、クエリ1000件あたり0.10ドルからの価格を提供しており、応答時間は1〜2秒で、開発者や企業が効率的かつ低コストでデータを取得できます。

- 高度なデータ統合機能:利用可能なすべてのオンラインチャネルと検索エンジンからの情報を統合できます。

🎺🎺お知らせ!

開発者サポートプログラム:Scrapeless Deep SerpApiをAIツール、アプリケーション、またはプロジェクトに統合します。[すでにDifyをサポートしており、まもなくLangchain、Langflow、FlowiseAI、その他のフレームワークをサポートします]。その後、結果をGitHubまたはソーシャルメディアで共有すると、最大月額500ドルの1〜12か月の無料開発者サポートを受けられます。

追加のリソース

他のGoogleスクレイピングテクニックに興味がある場合は、次の詳細な記事をお読みください。

まとめ

結論として、Kayakからフライトデータをスクレイピングすることで、旅行者と企業にとって貴重な洞察が得られます。適切なツールと倫理的な慣行を使用することにより、リアルタイムデータを簡単に収集できます。

参加してみませんか?詳細なヒントやアドバイスについては、Discordコミュニティに参加してください。

Scrapelessでは、適用される法律、規制、およびWebサイトのプライバシーポリシーを厳密に遵守しながら、公開されているデータのみにアクセスします。 このブログのコンテンツは、デモンストレーションのみを目的としており、違法または侵害の活動は含まれません。 このブログまたはサードパーティのリンクからの情報の使用に対するすべての責任を保証せず、放棄します。 スクレイピング活動に従事する前に、法律顧問に相談し、ターゲットウェブサイトの利用規約を確認するか、必要な許可を取得してください。