地理解决方案:使用无痕浏览器自动化复杂性,以构建内容分析引擎

Expert Network Defense Engineer

将人工智能答案转化为商业优势——Scrapeless GEO 解决方案帮助您捕获、分析和行动。

生成引擎优化(GEO)正在迅速成为搜索行业中最具颠覆性的发展趋势之一。随着大型语言模型(LLM)重塑用户发现信息、评估品牌和做出决策的方式,企业不仅必须在传统搜索结果中可见,还必须确保其内容出现在 AI 生成的答案中。

然而,这只是更大范式转变的一个方面——我们正进入“无处不在的搜索”时代:用户不再仅仅依赖谷歌,而是通过各种 AI 引擎、助手应用程序和垂直模型获取答案。在这个竞争激烈的环境中,Perplexity 以惊人的速度崛起,不仅提供即时答案,还提供实时来源引用、数据管道和深入分析,使其成为内容研究、市场洞察和竞争对手监控的必要工具。

来源:Backlinko

但真正的挑战在于:如果您仍然是手动逐个提问给 Perplexity,那么您的效率根本无法跟上行业的步伐。因此,本文将揭示如何使用 Scrapeless 浏览器自动化 Perplexity,将其转变为一个持续运行、可扩展的内容分析引擎,使您在生成搜索时代中获得优势。

1. 什么是 GEO,为什么它很重要?

生成引擎优化(GEO)是创建和优化内容的实践,以便其出现在与 Google AI 概述、AI 模态、ChatGPT 及 Perplexity 等平台上生成的 AI 答案中。

在过去,成功意味着在搜索引擎结果页面(SERP)中排名高。展望未来,"领先"的概念可能不再存在。相反,您需要成为首选推荐——AI 工具选择在其答案中展示的解决方案。

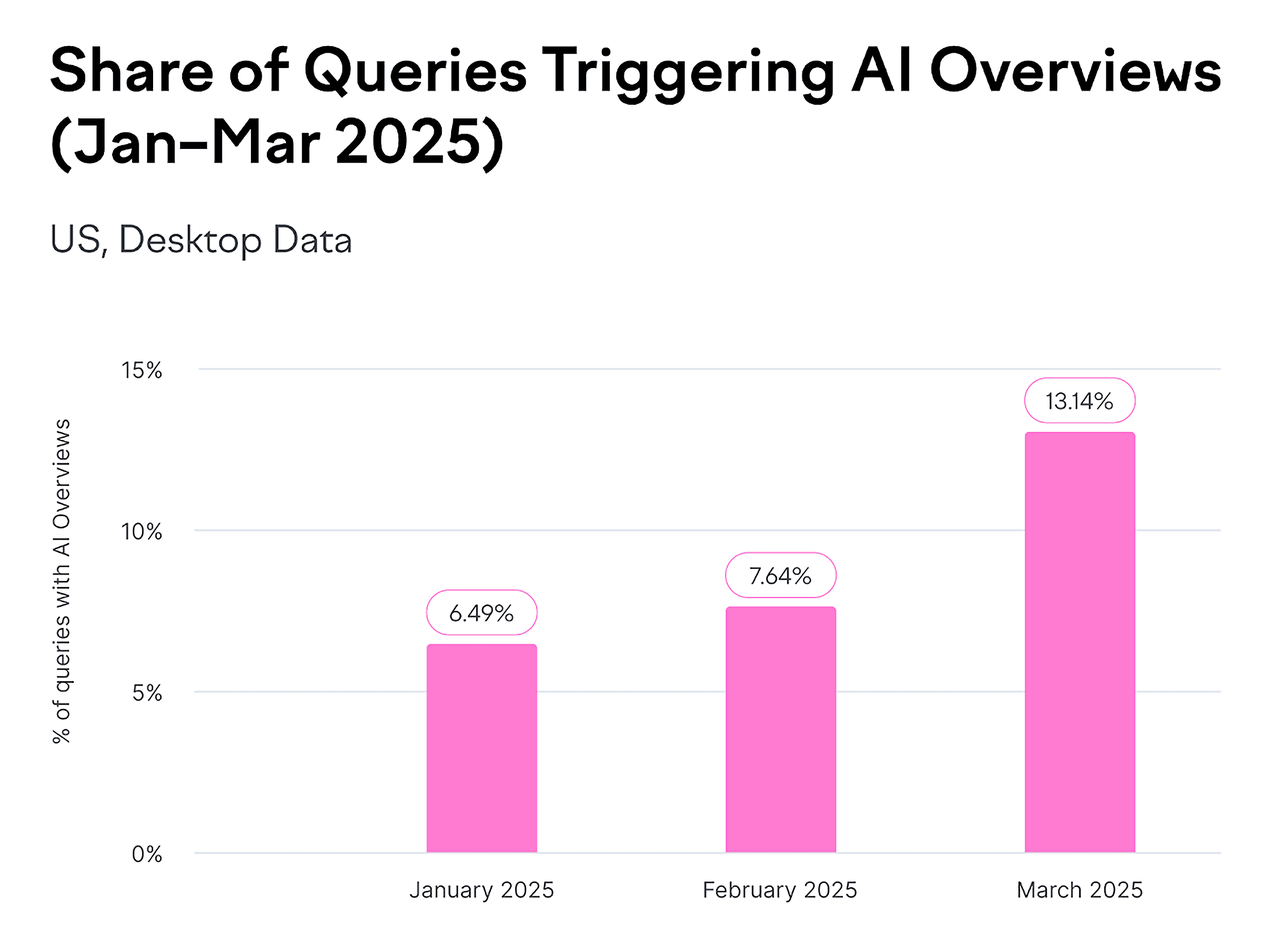

数据自会说明一切:

- Perplexity 的用户基础正在呈指数增长,今年已超过 1 亿月活跃用户,已达到谷歌的 1/20。

- Google AI 概述现在每月出现在数十亿次搜索中——涵盖至少 13% 的所有搜索结果。

来源:Backlinko

GEO 优化的核心目标不再仅限于驱动点击,而是集中在三个关键指标上:

- 品牌可见性: 增加您的品牌出现在 AI 生成的答案中的可能性。

- 来源权威性: 确保您的域名、内容或数据被模型选为可信的参考。

- 叙述一致性与正面定位: 让 AI 专业、准确、正面地描述您的品牌。

这意味着传统 SEO 逻辑中的“关键词排名”正逐渐让位于 AI 的来源引用机制。

品牌必须从“可发现”演变为“可信、被引用和被积极推荐”。

2. 为什么要关注 Perplexity?

Perplexity AI 每月大约有 1500 万活跃用户,且增长率持续上升。特别是在北美和欧洲,它几乎已成为“AI 搜索”的代名词。

对于内容策略、SEO 和市场分析团队而言,Perplexity 不再仅仅是一个“AI 搜索引擎”——它已成为一个新的“智能研究终端”。

您可以利用它来:

- 比较生成引擎优化中的内容差异

- 查看哪些网站在不同市场中被常引用相同关键词

- 快速总结竞争对手的主题策略

然而,也面临挑战:

👉 Perplexity 目前仅支持海外注册,使得大多数中国用户无法使用。

👉 免费版本未提供完整的 API 访问权限。

这为企业或内容团队创造了一个自然障碍:他们无法系统性地收集和分析大规模数据。

3. 为什么选择 Scrapeless 自动化?

Scrapeless Browser 提供了一种更智能的方法。它不仅仅是一个简单的爬虫——它是一个在云端运行的真实浏览器实例。您无需在本地打开 Chrome 或担心被检测为机器人。只需一行 Puppeteer 代码,您就可以像人类一样与网站互动。

例如,您可以:

- 打开

perplexity.ai - 自动输入问题

- 等待生成结果

- 提取答案文本和引用链接

- 保存整个页面的 HTML、截图、WebSocket 消息和网络请求

Scrapeless Browser 的独特优势

1. 企业级反检测技术

现代 AI 网站如 Perplexity 拥有强大的反爬虫保护:

- Cloudflare Turnstile 验证

- 浏览器指纹识别

- 行为模式分析

- IP 声誉检查

Scrapeless 如何处理这些问题:

ts

const CONNECTION_OPTIONS = {

proxyCountry: "US", // 使用美国 IP

sessionRecording: "true", // 记录会话以供调试

sessionTTL: "900", // 会话保持 15 分钟

sessionName: "perplexity-scraper" // 持久会话

};- 自动模拟真实用户行为

- 随机化浏览器指纹

- 内置 CAPTCHA 解码器

- 涵盖 195 个国家的代理网络

2. 全球代理网络

Perplexity 的回答因用户的位置而异:

- 🇺🇸 美国用户看到美国本地内容

- 🇬🇧 英国用户看到英国视角

- 🇯🇵 日本用户看到日文内容

Scrapeless 解决方案:

ts

proxyCountry: "US" // 针对美国视角

proxyCountry: "GB" // 针对欧洲市场见解- 从不同国家运行多个查询以进行全球比较

- 支持 195 个国家的代理节点和自定义浏览器代理

3. 会话持久性 + 录制回放

在开发和调试自动化脚本时,常见的痛点是:

- ❌ 不知道错误发生在哪里

- ❌ 无法重现问题

- ❌ 反复运行脚本以调试

Scrapeless 实时会话:

ts

sessionRecording: "true" // 启用会话录制- 实时查看: 实时观看浏览器中的自动化过程

- 回放: 如果失败,重放整个过程

4. 零维护成本

传统解决方案需要:

- 本地 Puppeteer: 维护服务器,更新 Chrome,处理崩溃

- 自托管云浏览器: DevOps 团队、监控、扩展

- 每月成本: 2 名工程师 × 20 小时 ≈ $2,000

Scrapeless Browser:

- ✅ 云托管,自动更新

- ✅ 99.9% 的正常运行时间保证

- ✅ 自动扩展,无需担心并发

- 💰 成本:按需付费,约 $50–200/月

投资回报率比较:

- 传统:$2,000(劳动力) + $200(服务器) = $2,200/月

- Scrapeless:$100/月

- 节省: 95%!

5. 即用型集成

Scrapeless Browser 与主流自动化库完全兼容:

- ✅ Puppeteer (Node.js)

- ✅ Playwright (Node.js / Python)

- ✅ CDP (Chrome DevTools Protocol)

迁移成本几乎为零:

ts

import puppeteer from "puppeteer-core"

// 原来的:本地浏览器

// const browser = await puppeteer.launch();

// 迁移到 Scrapeless Browser,只需更改一行:

const browser = await puppeteer.connect({

browserWSEndpoint: "wss://browser.scrapeless.com/api/v2/browser?token=YOUR_API_TOKEN"

})

const page = await browser.newPage()

await page.goto("https://google.com")4. Scrapeless Browser + Puppeteer:自动获取 Perplexity.ai 回答的详细指南

接下来,我们将使用 Scrapeless Browser + Puppeteer 自动访问 Perplexity.ai,提交问题并捕获答案、页面链接、HTML 片段和网络数据。

无需本地安装 Chrome——开箱即用,支持代理、会话录制和 WebSocket 监控。

步骤 1:配置 Scrapeless 连接

ts

const sleep = (ms) => new Promise(r => setTimeout(r, ms));

const tokenValue = process.env.SCRAPELESS_TOKEN || "YOUR_API_TOKEN";

const CONNECTION_OPTIONS = {

proxyCountry: "ANY", // 自动选择最快的节点

sessionRecording: "true", // 启用会话录制

sessionTTL: "900", // 会话保持 15 分钟

sessionName: "perplexity-scraper", // 会话名称

};

function buildConnectionURL(token) {

const q = new URLSearchParams({ token, ...CONNECTION_OPTIONS });

return `wss://browser.scrapeless.com/api/v2/browser?${q.toString()}`;

}- 登录 Scrapeless 获取您的 API 令牌。

💡 关键点:

proxyCountry: "ANY"自动选择最快的节点以减少延迟。- 如果需要特定区域的内容,例如美国新闻,请更改为

"US"。 sessionRecording允许在控制台中播放以便于调试。

步骤 2:连接到云浏览器

ts

const connectionURL = buildConnectionURL(tokenValue);

const browser = await puppeteer.connect({

browserWSEndpoint: connectionURL,

defaultViewport: { width: 1280, height: 900 }

});

const page = await browser.newPage();

page.setDefaultNavigationTimeout(120000);

page.setDefaultTimeout(120000);

try {

await page.setUserAgent(

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/140.0.0.0 Safari/537.36"

);

} catch (e) {}💡 注意事项:

puppeteer-core是轻量级的;它无需下载本地的 Chromium 便可连接到远程浏览器。- 设置桌面用户代理有助于避免基本的反抓取检测。

- 使用

try-catch是防御性编程,以增强脚本的稳健性。

步骤 3:监控所有网络活动(核心!)

这是脚本的关键部分!它同时捕获两种类型的数据:

3.1 监听 HTTP 响应

ts

const rawResponses = [];

page.on("response", async (res) => {

try {

const url = res.url();

const status = res.status();

const resourceType = res.request ? res.request().resourceType() : "unknown";

const headers = res.headers ? res.headers() : {};

let snippet = "";

try {

const t = await res.text();

snippet = typeof t === "string" ? t.slice(0, 20000) : String(t).slice(0, 20000);

} catch (e) {

snippet = "<read-failed>";

}

rawResponses.push({ url, status, resourceType, headers, snippet });

} catch (e) {}

});捕获内容:

- API 调用、图片、CSS、JS 等。

- 响应状态码和 HTTP 头信息

- 响应内容的前 20KB(避免内存溢出,同时足以进行 JSON 分析)

3.2 监听 WebSocket 帧(关键!)

ts

const wsFrames = [];

try {

const cdp = await page.target().createCDPSession();

await cdp.send("Network.enable");

cdp.on("Network.webSocketFrameReceived", (evt) => {

try {

const { response } = evt;

wsFrames.push({

timestamp: evt.timestamp,

opcode: response.opcode,

payload: response.payloadData ?

response.payloadData.slice(0, 20000) :

response.payloadData,

});

} catch (e) {}

});

} catch (e) {

// 如果 CDP 不可用,静默跳过

}为什么 WebSocket 很重要:

Perplexity 的答案不是一次性返回的,而是通过 WebSocket 流式传输:

用户输入问题

↓

Perplexity 后端生成答案

↓

答案通过 WebSocket 逐字推送

↓

实时在前端显示(类似 ChatGPT 打字效果)捕获 WebSocket 的好处:

- 观察完整的答案生成过程

- 分析 Perplexity 的 AI 推理链

- 调试不完整或部分答案

步骤 4:访问 Perplexity 网站

ts

await page.goto("https://www.perplexity.ai/", {

waitUntil: "domcontentloaded",

timeout: 90000

});步骤 5:智能输入你的问题

ts

const prompt = "嗨,ChatGPT,你知道 Scrapeless 是什么吗?";

await findAndType(page, prompt);步骤 6:等待渲染并捕获结果

ts

await page.waitForTimeout(1500);

const results = await page.evaluate(() => {

const pick = el => el ? (el.innerText || "").trim() : "";

const out = { answers: [], links: [], rawHtmlSnippet: "" };

const selectors = ['[data-testid*="answer"]','[data-testid*="result"]','.Answer','article','main'];

selectors.forEach(s => {

const el = document.querySelector(s);

if(el){ const t = pick(el); if(t.length>30) out.answers.push({ selector:s,text:t.slice(0,20000) }); }

});

const main = document.querySelector("main") || document.body;

out.links = Array.from(main.querySelectorAll("a")).slice(0,200).map(a=>({ href:a.href, text:(a.innerText||"").trim() }));

out.rawHtmlSnippet = main.innerHTML.slice(0,200000);

return out;

});💡 注意事项:

- 捕获答案、链接和 HTML 摘要

- 保留重要数据并截断过长内容以提高性能

步骤 7:保存输出

ts

await fs.writeFile("./perplexity_results.json", JSON.stringify(results, null, 2));

await fs.writeFile("./perplexity_page.html", await page.content());

await fs.writeFile("./perplexity_raw_responses.json", JSON.stringify(rawResponses, null, 2));

await fs.writeFile("./perplexity_ws_frames.json", JSON.stringify(wsFrames, null, 2));

await page.screenshot({ path: "./perplexity_screenshot.png", fullPage: true });- JSON、HTML、WebSocket 帧和截图都已保存

- 便于后续分析、调试或重现

步骤 8:关闭浏览器

ts

await browser.close();

console.log("完成 — 输出已保存");5. 完整代码示例

// perplexity_clean.mjs

import puppeteer from "puppeteer-core";

import fs from "fs/promises";

const sleep = (ms) => new Promise((r) => setTimeout(r, ms));// 将 token 放在环境变量 SCRAPELESS_TOKEN,或在下面直接填入硬编码值

const tokenValue = process.env.SCRAPELESS_TOKEN || "sk_0YEQhMuYK0izhydNSFlPZ59NMgFYk300X15oW69QY6yJxMtmo5Ewq8YwOvXT0JaW";

const CONNECTION_OPTIONS = {

proxyCountry: "ANY",

sessionRecording: "true",

sessionTTL: "900",

sessionName: "perplexity-scraper",

};

function buildConnectionURL(token) {

const q = new URLSearchParams({ token, ...CONNECTION_OPTIONS });

return wss://browser.scrapeless.com/api/v2/browser?${q.toString()};

}

async function findAndType(page, prompt) {

// 常见的输入选择器集合(默默尝试,不打印“未找到”)

const selectors = [

'textarea[placeholder*="Ask"]',

'textarea[placeholder*="Ask anything"]',

'input[placeholder*="Ask"]',

'[contenteditable="true"]',

'div[role="textbox"]',

'div[role="combobox"]',

'textarea',

'input[type="search"]',

'[aria-label*="Ask"]',

];

for (const sel of selectors) {

try {

const el = await page.$(sel);

if (!el) continue;

// 确保可见

const visible = await el.boundingBox();

if (!visible) continue;

// 决定 contenteditable 与普通输入的区别

const isContentEditable = await page.evaluate((s) => {

const e = document.querySelector(s);

if (!e) return false;

if (e.isContentEditable) return true;

const role = e.getAttribute && e.getAttribute("role");

if (role && (role.includes("textbox") || role.includes("combobox"))) return true;

return false;

}, sel);

if (isContentEditable) {

await page.focus(sel);

// 尽可能使用 JavaScript 输入并触发输入元素以确保与 React/富文本编辑器兼容

await page.evaluate((s, t) => {

const el = document.querySelector(s);

if (!el) return;

// 如果元素是可编辑的,执行写入并派发输入事件

try {

el.focus();

if (document.execCommand) {

// insertText 在某些浏览器中受支持

document.execCommand("selectAll", false);

document.execCommand("insertText", false, t);

} else {

// 回退

el.innerText = t;

}

} catch (e) {

el.innerText = t;

}

el.dispatchEvent(new Event("input", { bubbles: true }));

}, sel, prompt);

await page.keyboard.press("Enter");

return true;

} else {

// 普通输入/文本区域

try {

await el.click({ clickCount: 1 });

} catch (e) {}

await page.focus(sel);

// 清空并输入

await page.evaluate((s) => {

const e = document.querySelector(s);

if (!e) return;

if ("value" in e) e.value = "";

}, sel);

await page.type(sel, prompt, { delay: 25 });

await page.keyboard.press("Enter");

return true;

}

} catch (e) {

// 忽略并继续下一个选择器(保持安静)

}}

// 返回:在用键盘输入之前确保页面已获得焦点(安静,不打印警告)

try {

await page.mouse.click(640, 200).catch(() => {});

await sleep(200);

await page.keyboard.type(prompt, { delay: 25 });

await page.keyboard.press("Enter");

return true;

} catch (e) {

return false;

}

}

(async () => {

const connectionURL = buildConnectionURL(tokenValue);

const browser = await puppeteer.connect({

browserWSEndpoint: connectionURL,

defaultViewport: { width: 1280, height: 900 },

});

const page = await browser.newPage();

page.setDefaultNavigationTimeout(120000);

page.setDefaultTimeout(120000);

// 使用常见的桌面用户代理(这减少了被简单保护机制检测到的机会)

try {

await page.setUserAgent(

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/140.0.0.0 Safari/537.36"

);

} catch (e) {}

// 准备收集数据(简要)

const rawResponses = [];

const wsFrames = [];

page.on("response", async (res) => {

try {

const url = res.url();

const status = res.status();

const resourceType = res.request ? res.request().resourceType() : "unknown";

const headers = res.headers ? res.headers() : {};

let snippet = "";

try {

const t = await res.text();

snippet = typeof t === "string" ? t.slice(0, 20000) : String(t).slice(0, 20000);

} catch (e) {

snippet = "<read-failed>";

}

rawResponses.push({ url, status, resourceType, headers, snippet });

} catch (e) {}

});

// 尝试打开 CDP 会话以捕获 websocket 帧(如果不可能则默默跳过)

try {

const cdp = await page.target().createCDPSession();

await cdp.send("Network.enable");

cdp.on("Network.webSocketFrameReceived", (evt) => {

try {

const { response } = evt;

wsFrames.push({

timestamp: evt.timestamp,

opcode: response.opcode,

payload: response.payloadData ? response.payloadData.slice(0, 20000) : response.payloadData,

});

} catch (e) {}

});

} catch (e) {}

// 导航到 Perplexity(仅使用 domcontentloaded)

await page.goto("https://www.perplexity.ai/", { waitUntil: "domcontentloaded", timeout: 90000 });

// 输入并提交你的问题(默默尝试)

const prompt = "嗨,ChatGPT,你知道 Scrapeless 是什么吗?";

await findAndType(page, prompt);

// 答案会在页面上短暂呈现

await sleep(1500);

// 等待更长的文本出现在页面上(但不产生额外的日志)

const start = Date.now();

while (Date.now() - start < 20000) {

const ok = await page.evaluate(() => {

const main = document.querySelector("main") || document.body;

if (!main) return false;

return Array.from(main.querySelectorAll("*")).some((el) => (el.innerText || "").trim().length > 80);

});

if (ok) break;

await sleep(500);

}

// 提取答案 / 链接 / HTML片段

const results = await page.evaluate(() => {

const pick = (el) => (el ? (el.innerText || "").trim() : "");

const out = { answers: [], links: [], rawHtmlSnippet: "" };

const selectors = [

'[data-testid*="answer"]',

'[data-testid*="result"]',

'.Answer',

'.answer',

'.result',

'article',

'main',

];

for (const s of selectors) {

const el = document.querySelector(s);

if (el) {

const t = pick(el);

if (t.length > 30) out.answers.push({ selector: s, text: t.slice(0, 20000) });

}

}

if (out.answers.length === 0) {

const main = document.querySelector("main") || document.body;

const blocks = Array.from(main.querySelectorAll("article, section, div, p")).slice(0, 8);

for (const b of blocks) {

const t = pick(b);

if (t.length > 30) out.answers.push({ selector: b.tagName, text: t.slice(0, 20000) });

}

}

const main = document.querySelector("main") || document.body;

out.links = Array.from(main.querySelectorAll("a")).slice(0, 200).map(a => ({ href: a.href, text: (a.innerText || "").trim() }));

out.rawHtmlSnippet = (main && main.innerHTML) ? main.innerHTML.slice(0, 200000) : "";

return out;});

// 保存输出(默默地)

try {

const pageHtml = await page.content();

await page.screenshot({ path: "./perplexity_screenshot.png", fullPage: true }).catch(() => {});

await fs.writeFile("./perplexity_results.json", JSON.stringify({ results, extractedAt: new Date().toISOString() }, null, 2));

await fs.writeFile("./perplexity_page.html", pageHtml);

await fs.writeFile("./perplexity_raw_responses.json", JSON.stringify(rawResponses, null, 2));

await fs.writeFile("./perplexity_ws_frames.json", JSON.stringify(wsFrames, null, 2));

} catch (e) {}

await browser.close();

// 仅打印必要的简要信息。

console.log("完成 — 输出:perplexity_results.json, perplexity_page.html, perplexity_raw_responses.json, perplexity_ws_frames.json, perplexity_screenshot.png");

process.exit(0);

})().catch(async (err) => {

try { await fs.writeFile("./perplexity_error.txt", String(err)); } catch (e) {}

console.error("错误 — 请查看 perplexity_error.txt");

process.exit(1);

});

## 6. 如何使用这些 JSON 数据进行 GEO?(实用指南)

Perplexity 返回的 `answers` 字段本质上告诉你:

AI 如何最终生成答案——它引用了谁,信任了哪些页面,强化了哪些观点,以及忽视了哪些内容。

换句话说:

**理解 `answers` = 理解为什么你的品牌被 AI 引用,为什么没有被引用,以及如何提高引用率。**

---

### GEO 的核心任务:控制 AI 的“引用机制”

传统的 SEO 旨在使页面在搜索结果中排名更高。

GEO 旨在使模型在生成答案时更可能 **引用你的内容**。

Perplexity 的 `answers` JSON 让你看到:

- AI 引用哪些 URLs(`source_urls`)

- 每个 URL 对答案的影响权重

- AI 使用的内容摘要

- AI 如何构建最终答案(段落 / 项目符号)

这些直接对应于你可以优化 GEO 的领域。

---

### ① 识别引用来源:你是否在模型的“受信任列表”上?

示例:

```json

"title": "Web Scraper PRO - Scrapeless",

"url": "https://scrapeless.com"如果你的网站缺失:

- 你的内容不在 AI 的受信任域列表中

- 你的结构化信息不足

- 它没有满足 AI 的抓取/理解要求

GEO 行动: 构建 AI 偏好的爬取内容结构

- FAQ 块(被 AI 高度引用)

- 数据驱动的内容(更受模型信任)

- 可复制的内容(短句子,清晰事实)

② 查看哪些内容/竞争者被引用得最多 → 推导AI偏好

示例:

json

"title": "Scrapeless AI浏览器评论2024:游戏规则改变者还是另一个工具?",

"url": "https://www.futuretools.io"观察:

- AI偏好长文本知识库(例如,维基百科)

- 更喜欢真实讨论(Reddit、Trustpilot)

- 更偏好结构化评论(TomsGuide)

GEO行动: 模仿这些网站的内容结构和知识密度

③ 分析AI提取的内容摘要 → 生成匹配内容

在answers中的示例:

json

"Scrapeless是一个网络抓取工具包和API,使用AI来..."该模型依赖这些可复现的事实来回答问题。

GEO行动: 生成相同类型的清晰、可量化和可复现的内容

- 使用简短句子

- 保持清晰的主谓宾结构

- 使内容直接可引用

- 使用列表结构

④ 检查AI的回答结构 → 创建“可直接引用”的内容

AI的最终答案通常包括:

- 步骤

- 摘要

- 对比表

- 优点/缺点

- 故障排除步骤

GEO行动: 预构建相同结构的内容。

因为:AI偏好结构相似、逻辑清晰且易于提取的内容

⑤ 检查AI是否误解您的品牌定位 → 优化叙述一致性

观察answers JSON中的答案是否偏离您的品牌定位。

GEO行动:

- 创建权威的关于页面

- 提供经过验证的品牌描述

- 在多个网站上保持一致的品牌叙述

- 发布可靠的反向链接

❗ 这是GEO的本质:

这不是关于排名,而是关于让AI将您包含在其可信知识库中。

Perplexity的answers JSON是您最直接的数据来源:

- 了解AI的引用逻辑

- 检查竞争者的内容结构

- 理解AI偏好的格式

- 验证品牌定位

- 识别被忽视的内容

在生成搜索的时代,传统的SEO思维“首位排名”正在被重新定义:真正的竞争不再是关于谁在搜索结果中排名更高,而是关于谁的内容被AI积极引用、信任并在其答案中呈现。

Scrapeless首次使企业能够获得对AI决策逻辑的全面洞察,并将其转化为可操作的GEO策略。

Scrapeless浏览器的核心优势:

- 全球代理网络: 在195个国家覆盖,从多个市场视角访问数据

- 真实行为模拟: 自动处理反抓取措施、浏览器指纹和CAPTCHA

- 全面的数据捕获: 捕获答案文本、引用链接、HTML等

- 基于云和零维护: 不需要本地浏览器或服务器,节省高达95%的成本

- 完整的GEO工具包: AI引用监控、结构化内容分析和全球数据抓取

生成引擎优化(GEO)不再是选择性问题——它现在是内容竞争力的核心支柱。如果您希望在AI搜索时代获得战略优势,Scrapeless的完整GEO解决方案是最佳起点。

Scrapeless不仅提供浏览器自动化和GEO数据自动化,还提供先进的工具和策略,以完全控制AI引用机制。联系我们以解锁完整的GEO数据解决方案!

展望未来,Scrapeless将继续专注于云浏览器技术,为企业提供高性能数据提取、自动化工作流程和AI代理基础设施支持,服务于金融、零售、电子商务、营销等行业。Scrapeless提供定制的、基于场景的解决方案,帮助企业在智能数据时代保持领先。

免责声明

该账户发布的网络抓取、数据提取、自动化脚本及相关技术内容仅用于技术交流、学习和研究目的,旨在分享行业经验和开发技术。

合法使用

所有示例和方法均旨在供读者合法合规使用。请确保遵守网站的服务条款、隐私政策和当地法律。

风险责任

该账户对读者使用所描述的技术或方法所导致的任何直接或间接损失不承担责任,包括但不限于账户禁用、数据丢失或法律责任。

内容准确性

我们努力确保内容的准确性和及时性,但无法保证所有例子在每个环境中都能有效。

版权与引用

内容来自公开可用的来源或作者的原创作品。请在转载时引用来源,并不得用于非法或商业目的。该账户对使用第三方数据或网站的后果不承担责任。

在Scrapeless,我们仅访问公开可用的数据,并严格遵循适用的法律、法规和网站隐私政策。本博客中的内容仅供演示之用,不涉及任何非法或侵权活动。我们对使用本博客或第三方链接中的信息不做任何保证,并免除所有责任。在进行任何抓取活动之前,请咨询您的法律顾问,并审查目标网站的服务条款或获取必要的许可。