如何使用BeautifulSoup处理动态内容?2025年终极指南

Advanced Data Extraction Specialist

主要收获:

- BeautifulSoup 适用于静态 HTML;它无法执行 JavaScript 来渲染动态内容。

- 要抓取动态内容,可以将 BeautifulSoup 与浏览器自动化工具(如 Selenium、Playwright)或专用 API 结合使用。

- 浏览器自动化会渲染页面,从而使 BeautifulSoup 能够解析完整的 HTML。

- 直接查询 API 在动态内容来自已知 API 端点时效率极高。

- 专用的网络爬虫 API 为复杂的 JavaScript 驱动的网站提供了一种简化的解决方案。

介绍

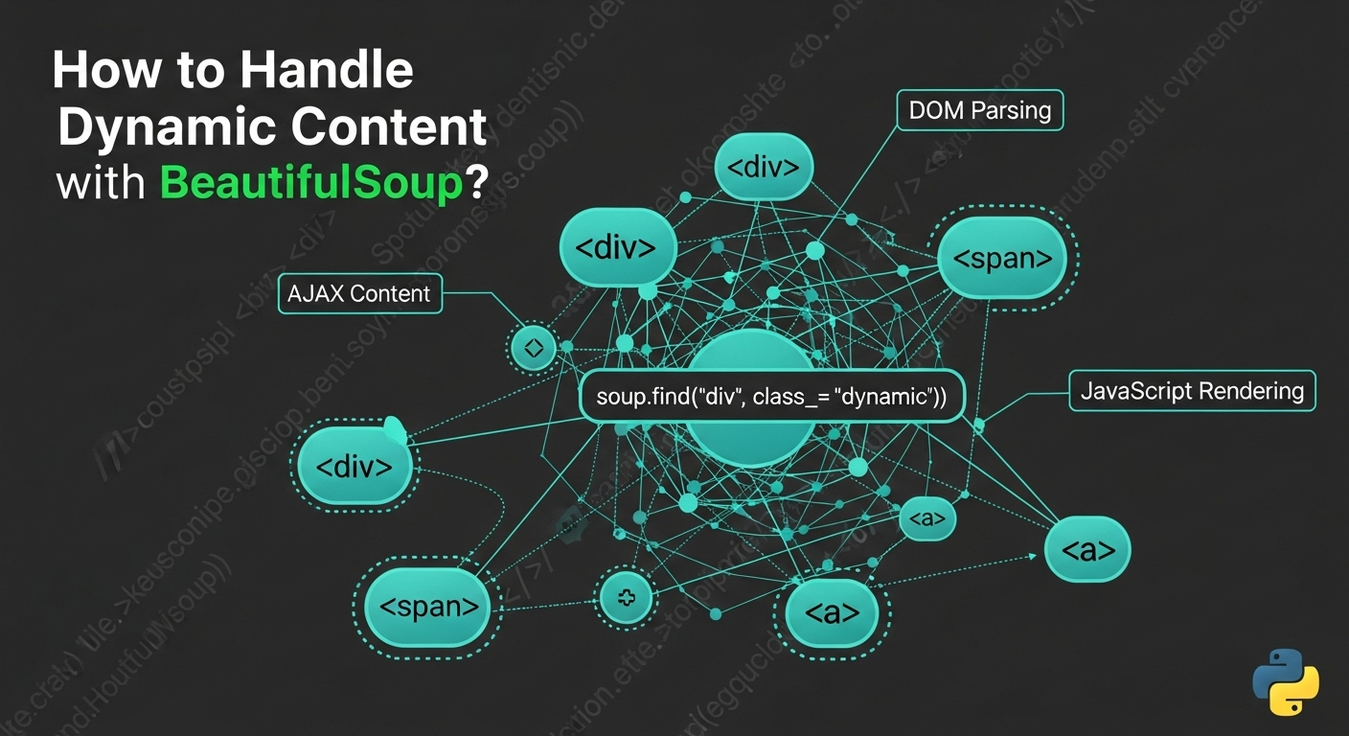

网络爬虫常面临一个挑战:动态内容。现代网站使用 JavaScript 以异步方式加载数据和渲染元素,使内容仅通过 BeautifulSoup 不可见。虽然 BeautifulSoup 擅长解析静态 HTML,但无法执行 JavaScript。本指南探讨使用 BeautifulSoup 处理动态内容的有效方法,提供可靠从 JavaScript 驱动的网站提取数据的实用示例和最佳实践。

理解动态内容及 BeautifulSoup 的局限性

动态内容是指在初始 HTML 加载后通过 JavaScript 加载或生成的网页元素。例子包括 AJAX 调用、客户端渲染(React、Angular)和 WebSockets。BeautifulSoup 是一个静态解析器;它仅处理接收到的 HTML,缺乏 JavaScript 引擎或渲染能力。因此,它无法访问初始页面加载后由 JavaScript 生成的内容。为了解决这个问题,BeautifulSoup 必须与能够模拟浏览器环境的工具配合使用。

解决方案 1:将 BeautifulSoup 与 Selenium 结合

Selenium 自动化浏览器,执行 JavaScript 并与网页元素交互。使用它加载页面,使动态内容渲染,然后提取完整的 HTML 供 BeautifulSoup 解析。

工作原理:

Selenium 启动浏览器,导航至 URL,等待 JavaScript 执行,检索完整的 HTML 源代码,然后将其传递给 BeautifulSoup。

安装:

bash

pip install selenium beautifulsoup4 webdriver_managerPython 代码示例(片段):

python

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

from webdriver_manager.chrome import ChromeDriverManager

from bs4 import BeautifulSoup

import time

def scrape_dynamic_content_selenium(url):

options = webdriver.ChromeOptions()

options.add_argument('--headless')

driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()), options=options)

driver.get(url)

time.sleep(5) # 调整延迟

html_content = driver.page_source

soup = BeautifulSoup(html_content, 'html.parser')

# ... 使用 soup 提取数据 ...

driver.quit()优缺点:

- 优点: 完整的 JavaScript 执行,浏览器交互,广泛采用。

- 缺点: 资源密集,速度较慢,设置复杂,易受抗机器人的检测影响 [1]。

解决方案 2:将 BeautifulSoup 与 Playwright 结合

Playwright 是一个现代库,用于控制 Chromium、Firefox 和 WebKit 浏览器。它提供了强大的等待机制,并且在处理动态内容时通常比 Selenium 更高效。

工作原理:

Playwright 启动浏览器,导航至 URL,等待内容加载,检索完整的 HTML,然后将其传递给 BeautifulSoup。

安装:

bash

pip install playwright beautifulsoup4

playwright installPython 代码示例(片段):

python

from playwright.sync_api import sync_playwright

from bs4 import BeautifulSoup

def scrape_dynamic_content_playwright(url):

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto(url, wait_until="networkidle")

html_content = page.content()

soup = BeautifulSoup(html_content, 'html.parser')

# ... 使用 soup 提取数据 ...

browser.close()优缺点:

- 优点: 支持多个浏览器,现代 API,快速,自动等待。

- 缺点: 资源密集,需要浏览器二进制文件,可能会被抗机器人系统检测 [2]。

解决方案 3:将 BeautifulSoup 与 Requests-HTML 结合

requests-html 扩展 requests,使用无头的 Chromium 实例渲染 JavaScript,提供一种更简单的方法来处理动态内容,而无需完整的浏览器自动化。

工作原理:

requests-html 获取初始 HTML,后台渲染 JavaScript,然后提供处理后的 HTML 供 BeautifulSoup 解析。

安装:

bash

pip install requests-html beautifulsoup4Python 代码示例(片段):

python

from requests_html import HTMLSession

from bs4 import BeautifulSoup

def scrape_dynamic_content_requests_html(url):

session = HTMLSession()

r = session.get(url)

r.html.render(sleep=3, keep_page=False)

html_content = r.html.html

soup = BeautifulSoup(html_content, 'html.parser')

# ... 使用 soup 提取数据 ...session.close()

### 优点和缺点:

* **优点:** API 更简单,集成请求和渲染,潜在的轻量级。

* **缺点:** 对复杂的 JS/反爬虫支持不足,依赖 Chromium,处理多个页面时可能较慢。

## 解决方案 4:将 BeautifulSoup 与 Splash 结合使用

Splash 是一个可脚本化的无头浏览器,运行在服务器上,理想用于受控 JavaScript 渲染,特别是与 Scrapy 一起使用。

### 工作原理:

您的脚本向 Splash 服务器发送请求,渲染页面并返回完整的 HTML 供 BeautifulSoup 解析。

### 安装:

需要 Docker 来运行 Splash:

```bash

docker run -p 8050:8050 scrapinghub/splashPython 代码示例(代码片段):

python

import requests

from bs4 import BeautifulSoup

def scrape_dynamic_content_splash(url, splash_url="http://localhost:8050"):

payload = {

"url": url,

"wait": 2,

"html": 1

}

response = requests.get(f"{splash_url}/render.html", params=payload)

html_content = response.text

soup = BeautifulSoup(html_content, 'html.parser')

# ... 使用 soup 提取数据 ...优点和缺点:

- 优点: 隔离环境,可脚本化,适合 Scrapy 集成。

- 缺点: 复杂的设置(Docker),性能开销大,资源消耗高。

解决方案 5:直接查询 APIs(可用时)

通常,动态内容通过 AJAX 请求加载到后端 API。直接查询这些 API 比浏览器渲染更高效。

工作原理:

在浏览器开发工具中检查网络流量以查找 API 端点。使用 Python 的 requests 库复制请求(方法、头部、负载)。解析 JSON/XML 响应。如果 API 返回 HTML 片段,您可以选择使用 BeautifulSoup。

安装:

bash

pip install requests beautifulsoup4Python 代码示例(代码片段):

python

import requests

import json

from bs4 import BeautifulSoup

def scrape_dynamic_content_api(api_url, headers=None, params=None, data=None):

response = requests.get(api_url, headers=headers, params=params) # 或 requests.post

response.raise_for_status()

api_data = response.json()

# ... 处理 api_data ...

# 如果 API 返回 HTML 片段:

# soup = BeautifulSoup(api_data["html_content"], 'html.parser')

# ... 使用 soup 解析 ...优点和缺点:

- 优点: 快速,资源轻,目标数据,较少受到反爬虫影响。

- 缺点: 需要 API 发现,易受 API 变化影响,认证处理,未必总是可用。

解决方案 6:无头浏览器(独立)

对于轻量级渲染而无需完整自动化框架,无头浏览器如 pyppeteer(Python 的 Puppeteer 等效)提供对浏览器的编程控制,以渲染重 JavaScript 页面。

工作原理:

无头浏览器启动,导航到 URL,执行 JavaScript,提取完整的 HTML,然后传递给 BeautifulSoup。

安装(针对 pyppeteer):

bash

pip install pyppeteer beautifulsoup4Python 代码示例(代码片段):

python

import asyncio

from pyppeteer import launch

from bs4 import BeautifulSoup

async def scrape_dynamic_content_pyppeteer(url):

browser = await launch(headless=True)

page = await browser.newPage()

await page.goto(url, waitUntil="networkidle0")

html_content = await page.content()

soup = BeautifulSoup(html_content, 'html.parser')

# ... 使用 soup 提取数据 ...

await browser.close()优点和缺点:

- 优点: 轻量级渲染,现代 JavaScript 支持,精细控制。

- 缺点: 需要

asyncio,资源消耗,Chromium 设置。

解决方案 7:利用网页抓取 API(专业服务)

对于复杂场景,专业的网页抓取 API 处理浏览器渲染、JavaScript 执行、IP 轮换和反爬虫,返回完全渲染的 HTML 或结构化数据。

工作原理:

您的脚本向 API 发送简单的 HTTP 请求,附带目标 URL。API 处理所有渲染和反爬虫措施,然后返回清洁的 HTML 供 BeautifulSoup 解析。

安装:

bash

pip install requests beautifulsoup4Python 代码示例(代码片段):

python

import requests

from bs4 import BeautifulSoup

import json

def scrape_dynamic_content_api_service(target_url, api_key, api_endpoint="https://api.scrapeless.com/v1/scrape"):

payload = {

"url": target_url,

"api_key": api_key,

"render_js": True,

}

headers = {"Content-Type": "application/json"}

response = requests.post(api_endpoint, headers=headers, data=json.dumps(payload))

response.raise_for_status()

response_data = response.json()

html_content = response_data.get("html")

if html_content:

soup = BeautifulSoup(html_content, "html.parser")

# ... 使用 soup 提取数据 ...优点和缺点:

- 优点: 简单性,高成功率,可扩展性,效率,专注于数据。

- 缺点: 收费服务,外部依赖,控制较少。

解决方案8:与Scrapy集成

Scrapy是一个高级网页抓取框架。虽然它不原生执行JavaScript,但可以通过中间件与Splash或Selenium/Playwright等工具集成,以处理动态内容,使其适用于大规模项目。

工作原理:

Scrapy发送请求,该请求被中间件拦截并转发至JavaScript渲染服务。渲染后的HTML返回给Scrapy,Scrapy可以使用BeautifulSoup或其自身选择器解析它。

安装:

bash

pip install scrapy beautifulsoup4

# 对于Splash集成: pip install scrapy-splash并运行Docker容器优缺点:

- 优点: 可扩展性,稳健性,灵活性,适合大规模项目。

- 缺点: 学习曲线陡峭,简单任务的开销,JavaScript渲染需要外部服务。

解决方案9:使用requests_html进行简单的JavaScript渲染

requests_html将requests与无头Chromium结合起来渲染JavaScript,提供比完整浏览器自动化更简单的方法。

工作原理:

它获取原始HTML,然后在无头浏览器中渲染JavaScript,为BeautifulSoup解析提供完全渲染的HTML。

安装:

bash

pip install requests-html beautifulsoup4Python代码示例(片段):

python

from requests_html import HTMLSession

from bs4 import BeautifulSoup

def scrape_dynamic_content_requests_html_simple(url):

session = HTMLSession()

r = session.get(url)

r.html.render(sleep=2, keep_page=False)

html_content = r.html.html

soup = BeautifulSoup(html_content, 'html.parser')

# ... 使用soup提取数据 ...

session.close()优缺点:

- 优点: 简单性,集成的请求/渲染,潜在的资源效率。

- 缺点: 对于复杂JS/反机器人不够稳健,依赖Chromium,可能较慢。

解决方案10:使用内置JavaScript渲染的代理服务

高级代理服务提供内置JavaScript渲染,充当中介以返回完全渲染的HTML,同时处理代理、验证码和反机器人措施。

工作原理:

您的脚本向代理服务发送请求,该服务使用JavaScript渲染页面并返回完整的HTML以供BeautifulSoup解析。

安装:

bash

pip install requests beautifulsoup4Python代码示例(片段):

python

import requests

from bs4 import BeautifulSoup

import json

def scrape_dynamic_content_proxy_service(target_url, proxy_api_key, proxy_endpoint="https://api.someproxyservice.com/render"):

payload = {

"url": target_url,

"api_key": proxy_api_key,

"render_js": True,

}

headers = {"Content-Type": "application/json"}

response = requests.post(proxy_endpoint, headers=headers, data=json.dumps(payload))

response.raise_for_status()

response_data = response.json()

html_content = response_data.get("html")

if html_content:

soup = BeautifulSoup(html_content, "html.parser")

# ... 使用soup提取数据 ...优缺点:

- 优点: 简化的基础设施,集成解决方案(JS渲染,反机器人),可扩展性,易用性。

- 缺点: 收费服务,外部依赖,控制较少。

比较总结:使用BeautifulSoup处理动态内容的解决方案

| 解决方案 | 复杂性(设置/维护) | 成本(典型) | 性能 | 稳健性(反机器人) | 最佳适用场景 |

|---|---|---|---|---|---|

| 1. BeautifulSoup + Selenium | 中等到高 | 低(免费) | 中等 | 低到中 | 复杂的交互,测试,小到中规模的抓取 |

| 2. BeautifulSoup + Playwright | 中等 | 低(免费) | 较好 | 低到中 | 现代网页应用,多浏览器测试,小到中规模的抓取 |

| 3. BeautifulSoup + Requests-HTML | 低到中 | 低(免费) | 中等 | 低 | 简单动态页面,快速脚本,较少复杂的JS渲染 |

| 4. BeautifulSoup + Splash | 高(Docker) | 低(免费) | 中等 | 中 | Scrapy集成,独立渲染,复杂JS,大规模项目 |

| 5. 直接查询 API | 低(发现) | 低(免费) | 高 | 高(如果 API 稳定) | 来自已知 API 的结构化数据,高速,资源高效 |

| 6. BeautifulSoup + 无头浏览器(如 Pyppeteer) | 中等 | 低(免费) | 良好 | 低至中等 | 简单的 JS 渲染,程序化浏览器控制,比完整框架开销更小 |

| 7. BeautifulSoup + 网络爬取 API | 低 | 中到高 | 非常高 | 非常高 | 大规模、复杂网站,反机器人规避,高可靠性 |

| 8. Scrapy 集成(与 Splash/Selenium) | 非常高 | 低(免费) | 高 | 中到高 | 企业级,大规模爬网,强大的数据管道 |

9. requests_html(独立) |

低 | 低(免费) | 中等 | 低 | 快速脚本,基本的 JS 渲染,Python 风格 |

| 10. 具有 JS 渲染的代理服务 | 低 | 中到高 | 高 | 高 | 卸载基础设施,反机器人,中到大规模爬取 |

为什么 Scrapeless 是您最好的替代方案

虽然 BeautifulSoup 在解析 HTML 方面表现出色,但处理动态内容往往会增加显著的复杂性。这时像 Scrapeless 这样的专业网络爬取 API 提供了一个简化且可靠的解决方案。Scrapeless 摆脱了 JavaScript 渲染、IP 轮换和反机器人规避的挑战,让您可以专注于数据提取。

Scrapeless 如何简化动态内容爬取:

- 自动化 JavaScript 渲染: Scrapeless 自动执行所有 JavaScript,确保 AJAX、客户端框架或 WebSockets 的动态内容完全渲染。无需管理无头浏览器。

- 内置反机器人及验证码绕过: 它集成了先进的规避技术,包括智能 IP 轮换、浏览器指纹识别和验证码解决,以无缝绕过复杂的反机器人系统。

- 简化集成: 您的 Python 脚本向 Scrapeless API 发出简单的 HTTP 请求。API 处理所有繁重的工作,返回干净、完全渲染的 HTML 供 BeautifulSoup 解析,显著减少您的代码量。

- 可扩展性和可靠性: 为企业级数据提取而设计,Scrapeless 提供无与伦比的可扩展性和高正常运行时间,无需您管理基础设施、代理或浏览器实例。

- 成本效益: 虽然是一项高级服务,Scrapeless 通常被证明比构建和维护自定义动态爬取解决方案更具成本效益,节省开发时间和资源。

通过集成 Scrapeless,您将动态内容爬取转变为高效的过程,利用 BeautifulSoup 的解析优势,而不必面临 JavaScript 渲染和反机器人措施的复杂性。

结论与行动号召

使用 BeautifulSoup 处理动态内容需要超越其静态解析能力。存在各种解决方案,从将 BeautifulSoup 与 Selenium 和 Playwright 等浏览器自动化工具配对,到利用 Splash 等专业服务或直接查询 API。每种方法都有其独特的优势和权衡。

对于需要处理现代、JavaScript 重的网站的开发者来说,选择取决于项目规模、动态内容复杂性和反机器人规避需求。虽然自我管理的浏览器自动化提供了控制,但伴随而来的开销和维护也是显著的。

对于高效、可扩展且无忧的方法,专用的网络爬取 API,如 Scrapeless,脱颖而出。通过卸载 JavaScript 渲染、IP 轮换和反机器人绕过的复杂性,Scrapeless 使您能够最大化利用 BeautifulSoup 的解析能力,而无需管理基础设施。它支持从具有挑战性的动态网站可靠地提取数据。

准备好简化您的动态网页爬取了吗?

不要让动态内容成为您数据提取目标的障碍。探索 Scrapeless 如何简化您的工作流程,并为您提供可靠的网络数据访问。立即开始您的免费试用,体验网页爬取的未来。

常见问题解答(FAQ)

Q1: 为什么 BeautifulSoup 无法直接处理动态内容?

BeautifulSoup 是一个静态 HTML 解析器;它缺乏 JavaScript 引擎和渲染能力。它无法执行加载额外内容或修改 DOM 的 JavaScript 代码,因此在初始加载后生成的动态内容对其不可见。

Q2: 处理动态内容时总是需要使用无头浏览器吗?

并不总是如此。如果动态内容来自可发现的API,直接使用requests查询该API会更高效。但是,对于复杂的JavaScript交互、客户端渲染或隐藏的API,则需要无头浏览器或专业的抓取API。

Q3:Selenium/Playwright和网页抓取API之间的主要权衡是什么?

Selenium/Playwright: 提供全面控制,免费(不包括基础设施),适合测试。消耗资源,速度较慢,设置复杂,容易被反机器人检测,高维护。

网页抓取API: 效率高,抽象复杂性(JS渲染、代理、反机器人),可扩展,可靠。付费服务,控制粒度较低,外部依赖。

选择取决于项目规模、预算以及希望控制与便利之间的权衡。

Q4:我如何判断一个网站是否使用动态内容?

- 禁用JavaScript: 如果内容消失,则为动态内容。

- 浏览器开发工具(网络标签): 寻找在初始HTML加载后发送的XHR/Fetch请求。

- 查看页面源代码与检查元素: 如果“检查元素”显示更多内容,则为动态。

Q5:我可以使用BeautifulSoup解析网页抓取API返回的HTML吗?

可以,这被高度推荐。网页抓取API返回完全渲染的静态HTML,BeautifulSoup非常适合解析。这样结合了强大的内容访问与灵活的数据提取。

在Scrapeless,我们仅访问公开可用的数据,并严格遵循适用的法律、法规和网站隐私政策。本博客中的内容仅供演示之用,不涉及任何非法或侵权活动。我们对使用本博客或第三方链接中的信息不做任何保证,并免除所有责任。在进行任何抓取活动之前,请咨询您的法律顾问,并审查目标网站的服务条款或获取必要的许可。