最佳AI爬虫浏览器:从任何网站抓取和监控数据

Specialist in Anti-Bot Strategies

网络爬取对于防止您的业务或产品落后至关重要。网络数据可以告诉您几乎所有关于潜在消费者的信息,从他们支付的平均价格到当前必备的功能。

如何减少爬取负担并提高工作效率?

使用最佳的网络爬取工具对于获取高质量的数据至关重要,因此您需要确保获得最适合工作的工具。

立即开始阅读本文,了解有关网络爬取的所有信息并获取最佳的爬取浏览器!

为什么数据爬取至关重要?

过时的信息会导致公司资源分配效率低下,或错过最新的赚钱机会。您绝对需要依赖节假日前的周度快消品价格数据来制定下个月的定价。

网络数据可以极大地帮助提高销售额和生产力。现代互联网极其活跃——用户每天产生惊人的2.5万亿字节的数据。无论您是初创公司还是拥有数十年历史的大公司,互联网数据中的有用信息都可以帮助您吸引竞争对手的潜在客户,并让他们为您的产品付费。

然而,大量的潜在客户数据意味着您可能需要终生手动提取数据才能赶上进度。而且手动数据提取还会遇到各种挑战!

爬取和监控数据时的挑战

1. 反爬虫措施

许多网站部署各种技术来检测和阻止爬取活动。这些措施是为了保护他们的数据并防止滥用。

- 验证码 (CAPTCHA):这些是旨在区分人和机器人活动的难题。常见的验证码形式包括扭曲的文本、图像识别任务或点击选择操作。

- 速率限制: 网站可能会限制在给定时间段内来自单个IP地址的请求数量,以防止服务器过载。如果在短时间内发送了过多的请求,您的IP可能会被阻止。

- IP阻止: 网站通常会跟踪发出请求的IP地址。如果他们检测到爬取行为,他们可能会阻止或限制来自该IP的访问。

- JavaScript渲染: 许多现代网站使用JavaScript动态加载内容。传统的爬取方法(例如,使用Requests或BeautifulSoup等库)难以爬取此类内容。

- 浏览器指纹: 网站可以通过分析浏览器行为和指纹(例如屏幕分辨率、已安装的插件和其他特征)来检测非人类流量。

因验证码和反机器人检测而感到沮丧?Scrapeless解锁99.9%的网站

免费试用!

2. 动态和复杂的网站结构

网站通常使用通过JavaScript动态加载数据的框架构建。这些动态网站经常使用AJAX请求在页面加载后提取内容,这使得使用传统方法进行爬取变得困难。

- 大量使用JavaScript的网站: 从新闻网站或社交媒体平台等网站爬取内容通常需要能够渲染JavaScript。如果没有这个,内容可能不会出现在页面的HTML源代码中。

- 无限滚动: 具有无限滚动的网站(例如,社交媒体或电子商务网站)会在用户向下滚动时加载更多内容。这在确定何时已加载所有必要数据以及如何高效地提取数据方面带来了挑战。

- 复杂的HTML结构: 具有复杂HTML结构(例如,嵌套元素、不规则标签名称或不一致的布局)的网站可能会使解析内容变得困难。

3. 反机器人解决方案

网站越来越多地部署复杂的反机器人解决方案来保护他们的数据,这使得爬取任务更加困难。

- 设备指纹: 网站可以使用先进的技术来检测类似机器人的行为,例如分析浏览器的指纹、网络配置,甚至鼠标移动。

- 行为分析: 一些网站会跟踪您的互动(例如,鼠标移动、点击和滚动行为)以检测机器人行为。如果爬虫的行为不像人类,它可能会触发反机器人措施。

爬取浏览器如何工作?

步骤1. 发送HTTP请求

步骤2. 渲染网页

步骤3. 导航网页

步骤4. 提取数据

步骤5. 处理动态内容

步骤6. 管理会话和Cookie

步骤7. 处理反爬虫机制

步骤8. 处理错误和故障

步骤9. 存储和输出数据

爬取浏览器如何绕过挑战?

爬取浏览器可以有效地避免网站监控和阻止,主要依赖以下关键技术:

1. 内置验证码求解器

爬取浏览器集成了验证码求解服务,可以自动识别和解决网站的验证码挑战。

2. IP轮换

通过IP轮换,爬取浏览器可以频繁更改请求源的IP地址,从而防止单个IP地址在短时间内发出大量请求。使用轮换代理,每个请求都可以使用不同的IP地址,然后绕过IP阻止。

3. 用户代理随机化

通过用户代理随机化,爬取浏览器可以模拟来自不同浏览器、设备和操作系统的请求,降低被识别为爬虫的风险。通过不断更改User-Agent字符串,爬虫可以使请求看起来像是来自不同的用户,而不是单个自动化工具。

4. 真实指纹

爬取浏览器模拟真实用户的浏览器指纹,而不是更改或伪造指纹以避免识别。真实的指纹可以使爬虫的行为更像普通用户,就像其他使用相同设备和浏览器访问网站的用户一样。

您可能也喜欢:2025年5款最佳爬取浏览器

最佳AI爬取浏览器 - Scrapeless

Scrapeless爬取浏览器 提供高性能的无服务器平台。它有效地简化了从动态网站提取数据的过程。开发人员无需专用服务器即可运行、管理和监控无头浏览器,从而实现高效的网络自动化和数据收集。

为什么Scrapeless对于网络爬取很特别?

Scrapeless爬取浏览器 拥有覆盖195个国家/地区和7000多万个住宅IP的全球网络、强大的网络解锁器和高度稳定的验证码求解器。它非常适合需要可靠且可扩展的网络爬取解决方案的用户。

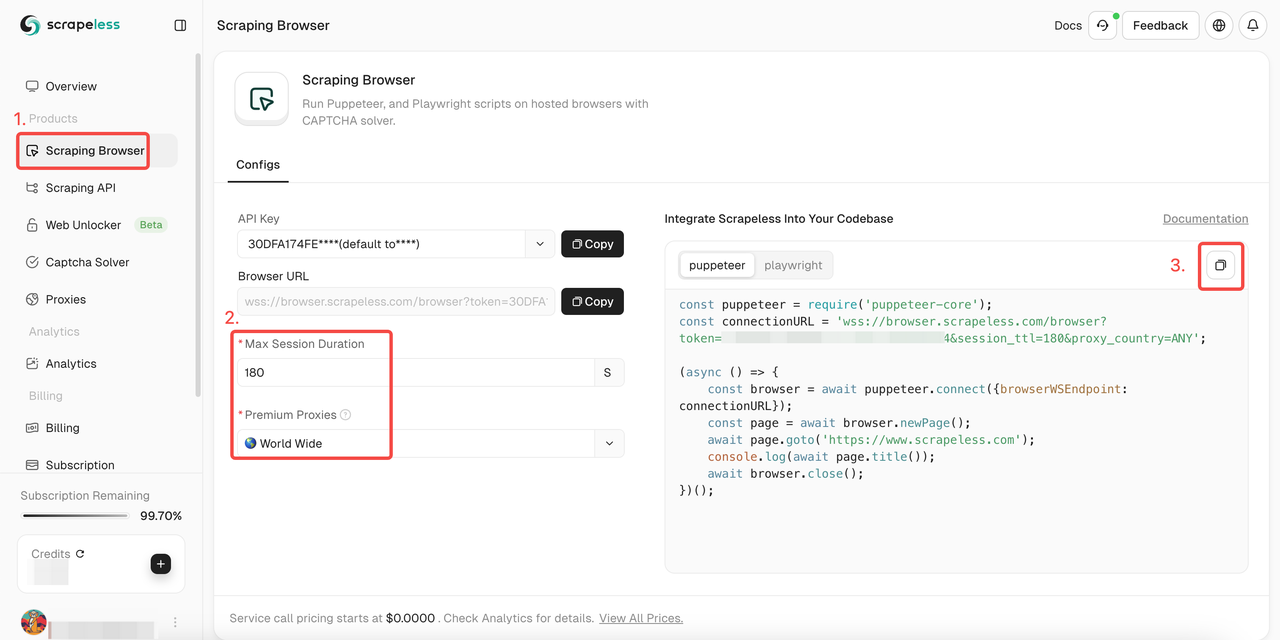

如何使用Scrapeless爬取浏览器?

- 步骤1. 登录 Scrapeless

- 步骤2. 进入“爬取浏览器”

- 步骤3. 根据您的需求设置参数

- 步骤4. 复制用于集成到您的项目的示例代码:

Puppeteer

JavaScript

const puppeteer = require('puppeteer-core');

const connectionURL = 'wss://browser.scrapeless.com/browser?token='; //输入API令牌

(async () => {

const browser = await puppeteer.connect({browserWSEndpoint: connectionURL});

const page = await browser.newPage();

await page.goto('https://www.scrapeless.com');

console.log(await page.title());

await browser.close();

})();Playwright

JavaScript

const {chromium} = require('playwright-core');

const connectionURL = 'wss://browser.scrapeless.com/browser?token='; //输入API令牌

(async () => {

const browser = await chromium.connectOverCDP(connectionURL);

const page = await browser.newPage();

await page.goto('https://www.scrapeless.com');

console.log(await page.title());

await browser.close();

})();想要了解更多详情?我们的文档 将会极大地帮助您!

Puppeteer:

步骤1. 安装必要的库

首先,安装puppeteer-core,这是一个轻量级的Puppeteer版本,旨在连接到现有的浏览器实例:

Bash

npm install puppeteer-core步骤2. 编写代码以连接到爬取浏览器

在您的Puppeteer代码中,使用以下方法连接到爬取浏览器:

JavaScript

const puppeteer = require('puppeteer-core');

const connectionURL = 'wss://browser.scrapeless.com/browser?token=APIKey&session_ttl=180&proxy_country=ANY';

(async () => {

const browser = await puppeteer.connect({browserWSEndpoint: connectionURL});

const page = await browser.newPage();

await page.goto('https://www.scrapeless.com');

console.log(await page.title());

await browser.close();

})();这样,您可以利用爬取浏览器的基础设施,包括可扩展性、IP轮换和全球访问。

示例:

以下是一些与爬取浏览器集成后的常见Puppeteer操作:

- 导航和页面内容提取

JavaScript

const page = await browser.newPage();

await page.goto('https://www.example.com');

console.log(await page.title());

const html = await page.content();

console.log(html);

await browser.close();- 截屏

JavaScript

const page = await browser.newPage();

await page.goto('https://www.example.com');

await page.screenshot({ path: 'example.png' });

console.log('Screenshot saved as example.png');

await browser.close();- 运行自定义脚本

JavaScript

const page = await browser.newPage();

await page.goto('https://www.example.com');

const result = await page.evaluate(() => document.title);

console.log('Page title:', result);

await browser.close();Playwright:

步骤1. 安装必要的库

首先,安装playwright-core,这是一个轻量级的Playwright版本,用于连接到现有的浏览器实例:

Bash

npm install playwright-core步骤2. 编写代码以连接到爬取浏览器

在Playwright代码中,使用以下方法连接到爬取浏览器:

JavaScript

const { chromium } = require('playwright-core');

const connectionURL = 'wss://browser.scrapeless.com/browser?token=APIKey&session_ttl=180&proxy_country=ANY';

(async () => {

const browser = await chromium.connectOverCDP(connectionURL);

const page = await browser.newPage();

await page.goto('https://www.scrapeless.com');

console.log(await page.title());

await browser.close();

})();这使您可以利用爬取浏览器的基础设施,包括可扩展性、IP轮换和全球访问。

示例

以下是一些与爬取浏览器集成后的常见Playwright操作:

- 导航和页面内容提取

JavaScript

const page = await browser.newPage();

await page.goto('https://www.example.com');

console.log(await page.title());

const html = await page.content();

console.log(html);

await browser.close();- 截屏

JavaScript

const page = await browser.newPage();

await page.goto('https://www.example.com');

await page.screenshot({ path: 'example.png' });

console.log('Screenshot saved as example.png');

await browser.close();- 运行自定义脚本

JavaScript

const page = await browser.newPage();

await page.goto('https://www.example.com');

const result = await page.evaluate(() => document.title);

console.log('Page title:', result);

await browser.close();选择网络爬虫时应考虑的8个因素

- 数据提取能力: 一个好的网络爬取工具支持各种数据格式,并且可以从各种网页结构中提取内容,包括静态HTML页面和使用JavaScript的动态网站。

- 易用性: 评估工具的学习曲线、用户界面和可用文档。使用该工具的人应该理解该工具的复杂性。

- 可扩展性: 考虑工具处理大规模数据提取的能力。性能方面的可扩展性和适应越来越多的数据或请求的能力至关重要。

- 自动化能力: 检查可用的自动化程度。查找计划功能、自动处理验证码以及自动管理cookie和会话的能力。

- IP轮换和代理支持: 该工具应提供强大的IP轮换和代理管理支持,以避免被阻止。

- 错误处理和恢复: 研究该工具如何管理错误,例如连接中断或意外的站点更改。

- 与其他系统的集成: 确定该工具是否可以与其他系统和平台(例如数据库、云服务或数据分析工具)无缝集成。与API的兼容性也是一个显著的优势。

- 数据清洗和处理: 查找内置的或易于集成的清洗和处理功能,以简化从原始数据到可用信息的流程。

结束语

网络爬虫很容易被网站识别并导致被阻止!如何获得流畅的数据提取过程?

Scrapeless爬取浏览器内置的网络解锁器、验证码求解器、轮换IP和智能代理可以帮助您轻松避免网站阻止并实现数据爬取!

在Scrapeless,我们仅访问公开可用的数据,并严格遵循适用的法律、法规和网站隐私政策。本博客中的内容仅供演示之用,不涉及任何非法或侵权活动。我们对使用本博客或第三方链接中的信息不做任何保证,并免除所有责任。在进行任何抓取活动之前,请咨询您的法律顾问,并审查目标网站的服务条款或获取必要的许可。