Cách xử lý nội dung động với BeautifulSoup? Hướng dẫn cuối cùng 2025

Expert Network Defense Engineer

Những điểm chính:

- BeautifulSoup chỉ dành cho HTML tĩnh; nó không thể thực thi JavaScript để hiển thị nội dung động.

- Để thu thập nội dung động, hãy kết hợp BeautifulSoup với các công cụ tự động hóa trình duyệt (Selenium, Playwright) hoặc các API chuyên dụng.

- Tự động hóa trình duyệt hiển thị trang, cho phép BeautifulSoup phân tích toàn bộ HTML.

- Truy vấn trực tiếp các API rất hiệu quả khi nội dung động xuất phát từ các điểm cuối API đã biết.

- Các API thu thập web chuyên dụng cung cấp giải pháp hợp lý cho các trang phức tạp do JavaScript điều khiển.

Giới thiệu

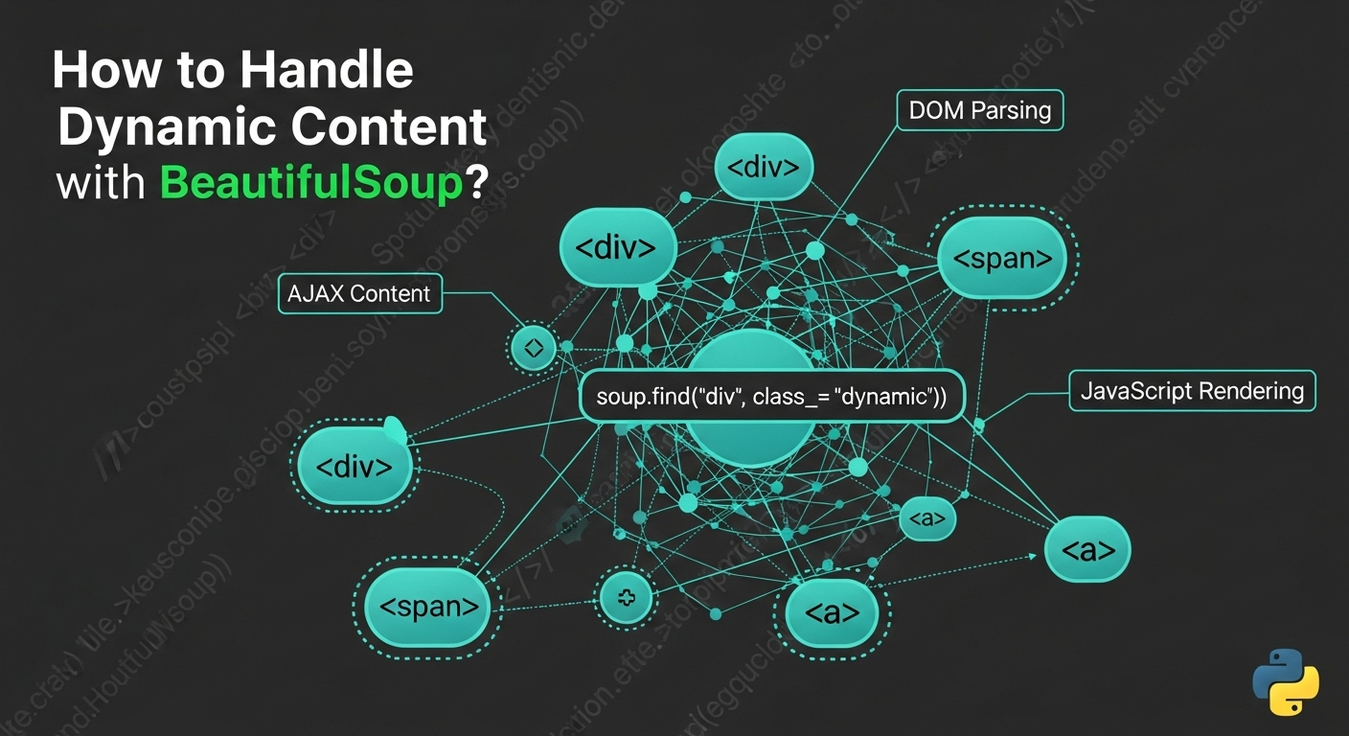

Thu thập dữ liệu web thường gặp một thách thức: nội dung động. Các trang web hiện đại sử dụng JavaScript để tải dữ liệu và hiển thị các phần tử không đồng bộ, làm cho nội dung không hiển thị chỉ với BeautifulSoup. Trong khi BeautifulSoup rất xuất sắc trong việc phân tích HTML tĩnh, nó không thể thi hành JavaScript. Hướng dẫn này khám phá những phương pháp hiệu quả để xử lý nội dung động khi sử dụng BeautifulSoup, cung cấp các ví dụ thực tế và các phương pháp tốt nhất để trích xuất dữ liệu từ các trang web do JavaScript điều khiển một cách đáng tin cậy.

Hiểu nội dung động và các giới hạn của BeautifulSoup

Nội dung động đề cập đến các phần tử trang web được tải hoặc tạo ra sau HTML ban đầu, thường thông qua JavaScript. Ví dụ bao gồm các cuộc gọi AJAX, tạo nội dung phía khách hàng (React, Angular), và WebSockets. BeautifulSoup là một trình phân tích tĩnh; nó chỉ xử lý HTML mà nó nhận được, thiếu động cơ JavaScript hoặc khả năng hiển thị. Do đó, nó không thể truy cập nội dung được tạo ra bởi JavaScript sau khi tải trang ban đầu. Để khắc phục điều này, BeautifulSoup phải được ghép nối với các công cụ mô phỏng môi trường trình duyệt.

Giải pháp 1: Kết hợp BeautifulSoup với Selenium

Selenium tự động hóa các trình duyệt web, thực thi JavaScript và tương tác với các phần tử web. Sử dụng nó để tải một trang, cho phép nội dung động hiển thị, sau đó trích xuất toàn bộ HTML để BeautifulSoup phân tích.

Cách hoạt động:

Selenium khởi động trình duyệt, điều hướng đến URL, chờ JavaScript thực thi, thu hồi mã nguồn HTML hoàn chỉnh, và sau đó truyền cho BeautifulSoup.

Cài đặt:

bash

pip install selenium beautifulsoup4 webdriver_managerVí dụ mã Python (Đoạn mã):

python

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

from webdriver_manager.chrome import ChromeDriverManager

from bs4 import BeautifulSoup

import time

def scrape_dynamic_content_selenium(url):

options = webdriver.ChromeOptions()

options.add_argument('--headless')

driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()), options=options)

driver.get(url)

time.sleep(5) # Điều chỉnh độ trễ

html_content = driver.page_source

soup = BeautifulSoup(html_content, 'html.parser')

# ... trích xuất dữ liệu với soup ...

driver.quit()Ưu điểm & Nhược điểm:

- Ưu điểm: Thực thi JavaScript đầy đủ, tương tác với trình duyệt, được sử dụng rộng rãi.

- Nhược điểm: Tốn tài nguyên, chậm hơn, thiết lập phức tạp, dễ bị phát hiện chống bot [1].

Giải pháp 2: Kết hợp BeautifulSoup với Playwright

Playwright là một thư viện hiện đại để điều khiển các trình duyệt Chromium, Firefox và WebKit. Nó cung cấp các cơ chế chờ mạnh mẽ và thường có hiệu suất tốt hơn Selenium cho nội dung động.

Cách hoạt động:

Playwright khởi động trình duyệt, điều hướng đến URL, chờ nội dung tải, thu hồi toàn bộ HTML, và sau đó truyền cho BeautifulSoup.

Cài đặt:

bash

pip install playwright beautifulsoup4

playwright installVí dụ mã Python (Đoạn mã):

python

from playwright.sync_api import sync_playwright

from bs4 import BeautifulSoup

def scrape_dynamic_content_playwright(url):

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto(url, wait_until="networkidle")

html_content = page.content()

soup = BeautifulSoup(html_content, 'html.parser')

# ... trích xuất dữ liệu với soup ...

browser.close()Ưu điểm & Nhược điểm:

- Ưu điểm: Hỗ trợ đa trình duyệt, API hiện đại, nhanh, tự động chờ.

- Nhược điểm: Tốn tài nguyên, yêu cầu tệp nhị phân trình duyệt, có thể bị phát hiện bởi các hệ thống chống bot [2].

Giải pháp 3: Kết hợp BeautifulSoup với Requests-HTML

requests-html mở rộng requests để hiển thị JavaScript bằng cách sử dụng một phiên bản Chromium không đầu, cung cấp phương pháp đơn giản hơn để xử lý nội dung động mà không cần tự động hóa trình duyệt đầy đủ.

Cách hoạt động:

requests-html lấy HTML ban đầu, hiển thị JavaScript ở chế độ nền, và sau đó cung cấp HTML đã xử lý cho BeautifulSoup phân tích.

Cài đặt:

bash

pip install requests-html beautifulsoup4Ví dụ mã Python (Đoạn mã):

python

from requests_html import HTMLSession

from bs4 import BeautifulSoup

def scrape_dynamic_content_requests_html(url):

session = HTMLSession()

r = session.get(url)

r.html.render(sleep=3, keep_page=False)

html_content = r.html.html

soup = BeautifulSoup(html_content, 'html.parser')

# ... trích xuất dữ liệu với soup ...

python

session.close()Ưu & Nhược Điểm:

- Ưu điểm: API đơn giản hơn, kết hợp yêu cầu và việc render, có thể nhẹ hơn.

- Nhược điểm: Ít mạnh mẽ hơn cho JS phức tạp/chống bot, phụ thuộc vào Chromium, có thể chậm cho nhiều trang.

Giải pháp 4: Kết hợp BeautifulSoup với Splash

Splash là một trình duyệt không giao diện có thể lập trình được chạy trên máy chủ, lý tưởng cho việc render JavaScript có kiểm soát, đặc biệt với Scrapy.

Cách Hoạt Động:

Kịch bản của bạn gửi yêu cầu đến máy chủ Splash, máy chủ sẽ render trang và trả về HTML đầy đủ để BeautifulSoup phân tích.

Cài Đặt:

Cần Docker để chạy Splash:

bash

docker run -p 8050:8050 scrapinghub/splashVí Dụ Mã Python (Đoạn Mã):

python

import requests

from bs4 import BeautifulSoup

def scrape_dynamic_content_splash(url, splash_url="http://localhost:8050"):

payload = {

"url": url,

"wait": 2,

"html": 1

}

response = requests.get(f"{splash_url}/render.html", params=payload)

html_content = response.text

soup = BeautifulSoup(html_content, 'html.parser')

# ... trích xuất dữ liệu với soup ...Ưu & Nhược Điểm:

- Ưu điểm: Môi trường cách ly, có thể lập trình, tốt cho tích hợp Scrapy.

- Nhược điểm: Thiết lập phức tạp (Docker), quá trình chậm, tiêu tốn tài nguyên.

Giải pháp 5: Truy Vấn Trực Tiếp Các API (Khi Có)

Thường thì nội dung động được tải thông qua các yêu cầu AJAX đến một API backend. Truy vấn trực tiếp các API này có thể hiệu quả hơn so với render bằng trình duyệt.

Cách Hoạt Động:

Kiểm tra lưu lượng mạng trong công cụ phát triển của trình duyệt để tìm các điểm cuối API. Tái tạo yêu cầu (phương thức, tiêu đề, dữ liệu) bằng cách sử dụng thư viện requests của Python. Phân tích phản hồi JSON/XML. Tùy chọn, sử dụng BeautifulSoup nếu API trả về các đoạn HTML.

Cài Đặt:

bash

pip install requests beautifulsoup4Ví Dụ Mã Python (Đoạn Mã):

python

import requests

import json

from bs4 import BeautifulSoup

def scrape_dynamic_content_api(api_url, headers=None, params=None, data=None):

response = requests.get(api_url, headers=headers, params=params) # hoặc requests.post

response.raise_for_status()

api_data = response.json()

# ... xử lý api_data ...

# Nếu API trả về các đoạn HTML:

# soup = BeautifulSoup(api_data["html_content"], 'html.parser')

# ... phân tích với soup ...Ưu & Nhược Điểm:

- Ưu điểm: Nhanh, nhẹ tài nguyên, dữ liệu mục tiêu, ít bị chống bot.

- Nhược điểm: Yêu cầu phát hiện API, dễ bị thay đổi API, xử lý xác thực, không phải lúc nào cũng có sẵn.

Giải pháp 6: Trình Duyệt Không Giao Diện (Độc Lập)

Để render nhẹ mà không cần các framework tự động hóa đầy đủ, các trình duyệt không giao diện như pyppeteer (tương đương với Puppeteer trong Python) cung cấp điều khiển lập trình đối với trình duyệt để render các trang nặng JavaScript.

Cách Hoạt Động:

Một trình duyệt không giao diện khởi chạy, điều hướng đến URL, thực thi JavaScript, trích xuất HTML đầy đủ, sau đó được chuyển cho BeautifulSoup.

Cài Đặt (cho pyppeteer):

bash

pip install pyppeteer beautifulsoup4Ví Dụ Mã Python (Đoạn Mã):

python

import asyncio

from pyppeteer import launch

from bs4 import BeautifulSoup

async def scrape_dynamic_content_pyppeteer(url):

browser = await launch(headless=True)

page = await browser.newPage()

await page.goto(url, waitUntil="networkidle0")

html_content = await page.content()

soup = BeautifulSoup(html_content, 'html.parser')

# ... trích xuất dữ liệu với soup ...

await browser.close()Ưu & Nhược Điểm:

- Ưu điểm: Rendering nhẹ, hỗ trợ JavaScript hiện đại, kiểm soát chi tiết.

- Nhược điểm: Yêu cầu

asyncio, tiêu tốn tài nguyên, thiết lập Chromium.

Giải pháp 7: Sử Dụng Các API Web Scraping (Dịch Vụ Chuyên Biệt)

Đối với các tình huống phức tạp, các API Web Scraping chuyên biệt xử lý việc render trình duyệt, thực thi JavaScript, xoay vòng IP, và né tránh chống bot, trả về HTML đã được render đầy đủ hoặc dữ liệu có cấu trúc.

Cách Hoạt Động:

Kịch bản của bạn gửi một yêu cầu HTTP đơn giản đến API với URL mục tiêu. API xử lý tất cả việc render và các biện pháp chống bot, sau đó trả về HTML sạch để BeautifulSoup phân tích.

Cài Đặt:

bash

pip install requests beautifulsoup4Ví Dụ Mã Python (Đoạn Mã):

python

import requests

from bs4 import BeautifulSoup

import json

def scrape_dynamic_content_api_service(target_url, api_key, api_endpoint="https://api.scrapeless.com/v1/scrape"):

payload = {

"url": target_url,

"api_key": api_key,

"render_js": True,

}

headers = {"Content-Type": "application/json"}

response = requests.post(api_endpoint, headers=headers, data=json.dumps(payload))

response.raise_for_status()

response_data = response.json()

html_content = response_data.get("html")

if html_content:

soup = BeautifulSoup(html_content, "html.parser")

# ... trích xuất dữ liệu với soup ...Ưu & Nhược Điểm:

- Ưu điểm: Đơn giản, tỷ lệ thành công cao, khả năng mở rộng, hiệu quả, tập trung vào dữ liệu.

- Nhược điểm: Dịch vụ trả phí, phụ thuộc bên ngoài, kiểm soát thấp.

Giải pháp 8: Tích hợp với Scrapy

Scrapy là một khung web scraping cấp cao. Mặc dù nó không thực thi JavaScript một cách tự nhiên, nhưng nó có thể tích hợp với các công cụ như Splash hoặc Selenium/Playwright qua middleware để xử lý nội dung động, khiến nó phù hợp cho các dự án quy mô lớn.

Cách hoạt động:

Scrapy gửi một yêu cầu, được middleware chặn và chuyển tiếp đến một dịch vụ render JavaScript. HTML đã render được trả lại cho Scrapy, sau đó có thể được phân tích bởi BeautifulSoup hoặc các bộ chọn của Scrapy.

Cài đặt:

bash

pip install scrapy beautifulsoup4

# Để tích hợp với Splash: pip install scrapy-splash và chạy container DockerƯu & nhược điểm:

- Ưu điểm: Khả năng mở rộng, độ bền, tính linh hoạt, tốt cho các dự án quy mô lớn.

- Nhược điểm: Đường cong học tập dốc, chi phí cao cho các tác vụ đơn giản, việc render JavaScript yêu cầu dịch vụ bên ngoài.

Giải pháp 9: Sử dụng requests_html để Render JavaScript đơn giản

requests_html kết hợp requests với Chromium không giao diện để render JavaScript, cung cấp cách tiếp cận đơn giản hơn so với tự động hóa trình duyệt đầy đủ.

Cách hoạt động:

Nó lấy HTML thô, sau đó render JavaScript trong một trình duyệt không giao diện, cung cấp HTML đã được render hoàn toàn cho việc phân tích BeautifulSoup.

Cài đặt:

bash

pip install requests-html beautifulsoup4Ví dụ mã Python (Đoạn mã):

python

from requests_html import HTMLSession

from bs4 import BeautifulSoup

def scrape_dynamic_content_requests_html_simple(url):

session = HTMLSession()

r = session.get(url)

r.html.render(sleep=2, keep_page=False)

html_content = r.html.html

soup = BeautifulSoup(html_content, 'html.parser')

# ... trích xuất dữ liệu bằng soup ...

session.close()Ưu & nhược điểm:

- Ưu điểm: Đơn giản, tích hợp yêu cầu/rendering, tiết kiệm tài nguyên.

- Nhược điểm: Ít bền vững cho JS/phòng chống bot phức tạp, phụ thuộc vào Chromium, có thể chậm.

Giải pháp 10: Sử dụng dịch vụ Proxy với Render JavaScript tích hợp

Các dịch vụ proxy nâng cao cung cấp khả năng render JavaScript tích hợp, hoạt động như một bên trung gian để trả về HTML đã render hoàn toàn trong khi xử lý proxy, CAPTCHA và các biện pháp chống bot.

Cách hoạt động:

Mã của bạn gửi một yêu cầu đến dịch vụ proxy, dịch vụ này render trang với JavaScript và trả về HTML đầy đủ cho việc phân tích BeautifulSoup.

Cài đặt:

bash

pip install requests beautifulsoup4Ví dụ mã Python (Đoạn mã):

python

import requests

from bs4 import BeautifulSoup

import json

def scrape_dynamic_content_proxy_service(target_url, proxy_api_key, proxy_endpoint="https://api.someproxyservice.com/render"):

payload = {

"url": target_url,

"api_key": proxy_api_key,

"render_js": True,

}

headers = {"Content-Type": "application/json"}

response = requests.post(proxy_endpoint, headers=headers, data=json.dumps(payload))

response.raise_for_status()

response_data = response.json()

html_content = response_data.get("html")

if html_content:

soup = BeautifulSoup(html_content, "html.parser")

# ... trích xuất dữ liệu bằng soup ...Ưu & nhược điểm:

- Ưu điểm: Hạ tầng đơn giản, giải pháp tích hợp (rendering JS, chống bot), khả năng mở rộng, dễ sử dụng.

- Nhược điểm: Dịch vụ trả phí, phụ thuộc bên ngoài, kiểm soát thấp.

Tóm tắt So sánh: Giải pháp cho Nội dung Động với BeautifulSoup

| Giải pháp | Độ phức tạp (Thiết lập/Bảo trì) | Chi phí (Điển hình) | Hiệu suất | Độ bền (Chống Bot) | Tốt cho |

|---|---|---|---|---|---|

| 1. BeautifulSoup + Selenium | Trung bình đến Cao | Thấp (Miễn phí) | Trung bình | Thấp đến Trung bình | Tương tác phức tạp, kiểm tra, scraping quy mô nhỏ đến vừa |

| 2. BeautifulSoup + Playwright | Trung bình | Thấp (Miễn phí) | Tốt | Thấp đến Trung bình | Ứng dụng web hiện đại, kiểm tra nhiều trình duyệt, scraping quy mô nhỏ đến vừa |

| 3. BeautifulSoup + Requests-HTML | Thấp đến Trung bình | Thấp (Miễn phí) | Trung bình | Thấp | Trang động đơn giản, kịch bản nhanh, render JS ít phức tạp |

| 4. BeautifulSoup + Splash | Cao (Docker) | Thấp (Miễn phí) | Trung bình | Trung bình | Tích hợp Scrapy, render độc lập, JS phức tạp, các dự án quy mô lớn |

| 5. Truy vấn API trực tiếp | Thấp (Khám phá) | Thấp (Miễn phí) | Cao | Cao (nếu API ổn định) | Dữ liệu có cấu trúc từ các API đã biết, tốc độ cao, tiết kiệm tài nguyên |

| 6. BeautifulSoup + Trình duyệt không đầu (ví dụ: Pyppeteer) | Trung bình | Thấp (Miễn phí) | Tốt | Thấp đến Trung bình | Kết xuất JS đơn giản, điều khiển trình duyệt theo chương trình, ít tài nguyên hơn so với các khung đầy đủ |

| 7. BeautifulSoup + API Web Scraping | Thấp | Trung bình đến Cao | Rất Cao | Rất Cao | Các trang lớn, phức tạp, né bot, độ tin cậy cao |

| 8. Tích hợp Scrapy (với Splash/Selenium) | Rất Cao | Thấp (Miễn phí) | Cao | Trung bình đến Cao | Crawler quy mô lớn, chất lượng doanh nghiệp, hệ thống xử lý dữ liệu vững chắc |

9. requests_html (độc lập) |

Thấp | Thấp (Miễn phí) | Vừa phải | Thấp | Các kịch bản nhanh, kết xuất JS cơ bản, cách tiếp cận Pythonic |

| 10. Dịch vụ Proxy với Kết xuất JS | Thấp | Trung bình đến Cao | Cao | Cao | Giảm tải hạ tầng, né bot, scraping quy mô trung bình đến lớn |

Tại sao Scrapeless là Lựa chọn Tốt nhất của Bạn

Mặc dù BeautifulSoup rất xuất sắc trong việc phân tích HTML, nhưng việc xử lý nội dung động thường tăng thêm độ phức tạp đáng kể. Đây là lý do mà một API Web Scraping chuyên biệt như Scrapeless cung cấp giải pháp tối ưu và đáng tin cậy. Scrapeless loại bỏ những thách thức về kết xuất JavaScript, xoay vòng IP và né bot, cho phép bạn tập trung hoàn toàn vào việc trích xuất dữ liệu.

Cách Scrapeless Đơn giản hóa Việc Scraping Nội dung Động:

- Kết xuất JavaScript Tự động: Scrapeless tự động thực thi tất cả JavaScript, đảm bảo nội dung động từ AJAX, khung bên phía khách hàng hoặc WebSockets được kết xuất hoàn toàn. Không cần quản lý trình duyệt không đầu.

- Né bot và Vượt qua CAPTCHA Tích hợp Sẵn: Nó tích hợp các kỹ thuật né tránh tiên tiến, bao gồm xoay vòng IP thông minh, nhận dạng dấu vân tay trình duyệt và giải CAPTCHA, để vượt qua các hệ thống né bot phức tạp một cách liền mạch.

- Tích hợp Đơn giản: Kịch bản Python của bạn chỉ cần thực hiện một yêu cầu HTTP đơn giản đến API Scrapeless. API này xử lý tất cả công việc nặng nhọc, trả về HTML sạch sẽ, đã được kết xuất hoàn toàn cho BeautifulSoup phân tích, giảm đáng kể mã nguồn của bạn.

- Khả năng Mở Rộng và Độ Tin Cậy: Được thiết kế để trích xuất dữ liệu chất lượng doanh nghiệp, Scrapeless cung cấp khả năng mở rộng vô đối và thời gian hoạt động cao, mà không cần bạn quản lý hạ tầng, proxy hay phiên trình duyệt.

- Hiệu quả Chi Phí: Mặc dù là dịch vụ cao cấp, Scrapeless thường chứng minh hiệu quả hơn về chi phí so với việc xây dựng và duy trì các giải pháp scraping động tùy chỉnh, tiết kiệm thời gian và nguồn lực phát triển.

Bằng cách tích hợp Scrapeless, bạn biến việc scraping nội dung động thành một quá trình hiệu quả, tận dụng sức mạnh phân tích của BeautifulSoup mà không gặp phải những phức tạp của việc kết xuất JavaScript và các biện pháp né bot.

Kết luận và Kêu gọi Hành động

Xử lý nội dung động với BeautifulSoup cần vượt ra ngoài khả năng phân tích tĩnh của nó. Có nhiều giải pháp khác nhau, từ việc kết hợp BeautifulSoup với các công cụ tự động hóa trình duyệt như Selenium và Playwright, đến việc tận dụng các dịch vụ chuyên biệt như Splash hoặc truy vấn trực tiếp API. Mỗi phương pháp đều có những ưu điểm và nhược điểm riêng.

Đối với các nhà phát triển đang xử lý các trang web hiện đại, nặng JavaScript, lựa chọn phụ thuộc vào quy mô dự án, độ phức tạp của nội dung động và các nhu cầu né bot. Trong khi tự quản lý tự động hóa trình duyệt mang lại sự kiểm soát, nó cũng đi kèm với độ nặng lớn và bảo trì.

Để có cách tiếp cận hiệu quả, có thể mở rộng và không rắc rối, một API Web Scraping chuyên dụng như Scrapeless nổi bật. Bằng cách giảm tải những phức tạp của việc kết xuất JavaScript, xoay vòng IP và né bot, Scrapeless cho phép bạn tối đa hóa sức mạnh phân tích của BeautifulSoup mà không phải quản lý hạ tầng. Nó cho phép trích xuất dữ liệu đáng tin cậy từ những trang web động đầy thách thức.

Sẵn sàng để đơn giản hóa việc web scraping động của bạn?

Đừng để nội dung động trở thành rào cản cho các mục tiêu trích xuất dữ liệu của bạn. Khám phá cách Scrapeless có thể hợp lý hóa quy trình làm việc của bạn và cung cấp quyền truy cập đáng tin cậy vào dữ liệu web mà bạn cần. Bắt đầu dùng thử miễn phí hôm nay và trải nghiệm tương lai của web scraping.

Bắt đầu Dùng thử Miễn phí với Scrapeless Ngay!

Câu hỏi Thường gặp (FAQ)

Q1: Tại sao BeautifulSoup không thể xử lý nội dung động trực tiếp?

BeautifulSoup là một parser HTML tĩnh; nó thiếu một động cơ JavaScript và khả năng kết xuất. Nó không thể thực thi mã JavaScript làm tải thêm nội dung hoặc chỉnh sửa DOM, vì vậy nội dung động được tạo ra sau khi tải ban đầu là vô hình đối với nó.

Q2: Có cần thiết phải sử dụng trình duyệt không đầu cho nội dung động không?

Không phải lúc nào cũng vậy. Nếu nội dung động đến từ một API có thể khám phá, việc truy vấn trực tiếp API đó bằng requests hiệu quả hơn. Tuy nhiên, đối với các tương tác JavaScript phức tạp, việc render ở phía client, hoặc các API ẩn, một trình duyệt không giao diện hoặc API quét chuyên dụng trở nên cần thiết.

Q3: Những đánh đổi chính giữa Selenium/Playwright và API Web Scraping là gì?

Selenium/Playwright: Cung cấp kiểm soát toàn diện, miễn phí (không tính hạ tầng), tốt cho kiểm thử. Tiêu tốn tài nguyên, chậm hơn, thiết lập phức tạp, dễ bị phát hiện bởi chống bot, bảo trì cao.

API Web Scraping: Rất hiệu quả, trừu tượng hóa các phức tạp (render JS, proxy, chống bot), có thể mở rộng, đáng tin cậy. Dịch vụ trả phí, kiểm soát ít chi tiết hơn, phụ thuộc vào bên ngoài.

Sự lựa chọn phụ thuộc vào quy mô dự án, ngân sách và sự kiểm soát mong muốn so với tiện lợi.

Q4: Làm thế nào tôi có thể xác định xem một trang web sử dụng nội dung động hay không?

- Vô hiệu hóa JavaScript: Nếu nội dung biến mất, đó là động.

- Công cụ phát triển trình duyệt (tab Mạng): Tìm các yêu cầu XHR/Fetch tải dữ liệu sau HTML ban đầu.

- Xem mã nguồn trang so với Kiểm tra phần tử: Nếu 'Kiểm tra phần tử' hiển thị nhiều nội dung hơn, đó là động.

Q5: Tôi có thể sử dụng BeautifulSoup để phân tích HTML được trả về bởi một API Web Scraping không?

Có, điều này được khuyến nghị cao. Các API Web Scraping trả về HTML tĩnh đã được render hoàn chỉnh, mà BeautifulSoup được thiết kế hoàn hảo để phân tích. Điều này kết hợp khả năng truy cập nội dung mạnh mẽ với việc trích xuất dữ liệu linh hoạt.

Tài liệu tham khảo

[1] ZenRows: Bypass Chống Bot của Selenium

[2] Playwright: Các Thực Hành Tốt Nhất

Tại Scrapless, chúng tôi chỉ truy cập dữ liệu có sẵn công khai trong khi tuân thủ nghiêm ngặt các luật, quy định và chính sách bảo mật trang web hiện hành. Nội dung trong blog này chỉ nhằm mục đích trình diễn và không liên quan đến bất kỳ hoạt động bất hợp pháp hoặc vi phạm nào. Chúng tôi không đảm bảo và từ chối mọi trách nhiệm đối với việc sử dụng thông tin từ blog này hoặc các liên kết của bên thứ ba. Trước khi tham gia vào bất kỳ hoạt động cạo nào, hãy tham khảo ý kiến cố vấn pháp lý của bạn và xem xét các điều khoản dịch vụ của trang web mục tiêu hoặc có được các quyền cần thiết.