Cách xây dựng phân tích tìm kiếm thông minh với Scrapeless và Google Gemini

Advanced Data Extraction Specialist

Trong hướng dẫn này, chúng ta sẽ xây dựng một hệ thống phân tích tìm kiếm mạnh mẽ bằng cách kết hợp khả năng thu thập dữ liệu web của Scrapeless với phân tích AI của Google Gemini. Bạn sẽ học cách trích xuất dữ liệu tìm kiếm của Google và tự động tạo ra những thông tin hữu ích.

Điều kiện tiên quyết

- Python 3.8+

- Khóa API Scrapeless

- Khóa API Google Gemini

- Kiến thức cơ bản về Python

Bước 1: Thiết lập Môi trường của Bạn

1. Tạo một Môi trường Ảo Python

Trước khi cài đặt các gói, bạn nên tạo một môi trường ảo để tách biệt các phụ thuộc của dự án:

Trên Windows:

# Tạo môi trường ảo

python -m venv scrapeless-gemini-env

# Kích hoạt môi trường

scrapeless-gemini-env\Scripts\activateTrên macOS:

# Tạo môi trường ảo

python3 -m venv scrapeless-gemini-env

# Kích hoạt môi trường

source scrapeless-gemini-env/bin/activateTrên Linux:

# Tạo môi trường ảo

python3 -m venv scrapeless-gemini-env

# Kích hoạt môi trường

source scrapeless-gemini-env/bin/activateLưu ý: Bạn sẽ thấy (scrapeless-gemini-env) trong dấu nhắc terminal của bạn khi môi trường ảo đang hoạt động.

2. Cài đặt Các Gói Cần Thiết

Khi môi trường ảo của bạn đã được kích hoạt, hãy cài đặt các gói cần thiết:

pip install requests google-generativeai python-dotenv pandas3. Cấu hình Môi Trường

Tạo một tệp .env trong thư mục dự án của bạn cho các khóa API:

SCRAPELESS_API_TOKEN=your_token_here

GEMINI_API_KEY=your_gemini_key_here4. Nhận Các Khóa API của Bạn

Đối với Khóa API Gemini: (AIzaSyBGhCVNdBsVVHlRNLEPEADGVQeKmDvDEfI)

Truy cập Google AI Studio để tạo khóa API Gemini miễn phí của bạn. Chỉ cần đăng nhập bằng tài khoản Google của bạn và tạo một khóa API mới.

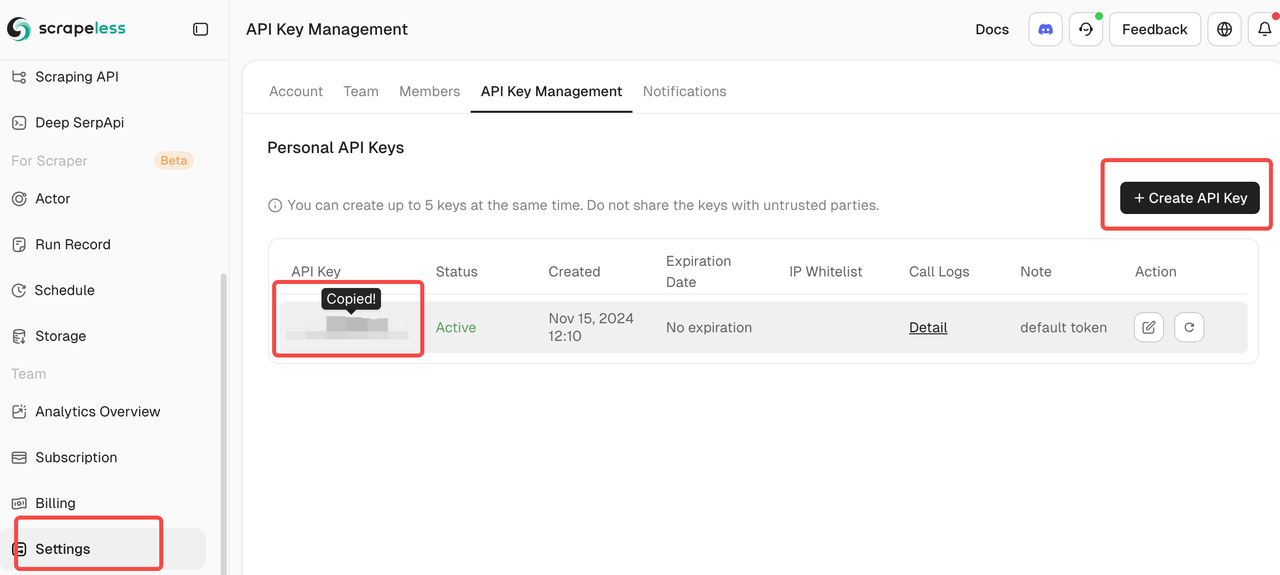

Đối với Mã thông báo API Scrapeless:

Đăng ký tại Scrapeless để nhận mã thông báo API của bạn. Nền tảng cung cấp một kế hoạch miễn phí hào phóng hoàn hảo để bắt đầu thu thập dữ liệu SERP.

Bước 2: Tạo Khách hàng Scrapeless

Hãy xây dựng một khách hàng đơn giản để tương tác với API Tìm kiếm Google của Scrapeless:

import json

import requests

import os

from dotenv import load_dotenv

load_dotenv()

class ScrapelessClient:

def __init__(self):

self.token = os.getenv('SCRAPELESS_API_TOKEN')

self.host = "api.scrapeless.com"

self.url = f"https://{self.host}/api/v1/scraper/request"

self.headers = {"x-api-token": self.token}

def search_google(self, query, **kwargs):

"""Thực hiện tìm kiếm Google bằng Scrapeless"""

payload = {

"actor": "scraper.google.search",

"input": {

"q": query,

"gl": kwargs.get("gl", "us"),

"hl": kwargs.get("hl", "en"),

"google_domain": kwargs.get("google_domain", "google.com"),

"location": kwargs.get("location", ""),

"tbs": kwargs.get("tbs", ""),

"start": str(kwargs.get("start", 0)),

"num": str(kwargs.get("num", 10))

}

}

response = requests.post(

self.url,

headers=self.headers,

data=json.dumps(payload)

)

if response.status_code != 200:

print(f"Lỗi: {response.status_code} - {response.text}")

return None

return response.json()Bước 3: Tích hợp Google Gemini để Phân tích

Bây giờ hãy thêm phân tích dựa trên AI vào kết quả tìm kiếm của chúng ta:

import google.generativeai as genai

class SearchAnalyzer:

def __init__(self):

genai.configure(api_key=os.getenv('GEMINI_API_KEY'))

self.model = genai.GenerativeModel('gemini-1.5-flash')

self.scraper = ScrapelessClient()

def analyze_topic(self, topic):

"""Tìm kiếm và phân tích một chủ đề"""

# Bước 1: Nhận kết quả tìm kiếm

print(f"Tìm kiếm: {topic}")

search_results = self.scraper.search_google(topic, num=20)

if not search_results:

return None

# Bước 2: Trích xuất thông tin quan trọng

extracted_data = self._extract_results(search_results)

# Bước 3: Phân tích với Gemini

prompt = f"""

Phân tích những kết quả tìm kiếm này về "{topic}":

{json.dumps(extracted_data, indent=2)}

Cung cấp:

1. Chủ đề và xu hướng chính

2. Nguồn thông tin chính

3. Những hiểu biết đáng chú ý

4. Hành động khuyến nghị

Định dạng phản hồi của bạn dưới dạng một báo cáo rõ ràng, có thể hành động.

"""

response = self.model.generate_content(prompt)

return {

"topic": topic,

"search_data": extracted_data,

"analysis": response.text

}

```python

def _extract_results(self, search_data):

"""Trích xuất dữ liệu liên quan từ kết quả tìm kiếm"""

results = []

if "organic_results" in search_data:

for item in search_data["organic_results"][:10]:

results.append({

"title": item.get("title", ""),

"snippet": item.get("snippet", ""),

"link": item.get("link", ""),

"source": item.get("displayed_link", "")

})

return resultsBước 4: Xây dựng các trường hợp sử dụng thực tế

Trường hợp sử dụng 1: Phân tích đối thủ cạnh tranh

Quan trọng: Trước khi chạy phân tích đối thủ cạnh tranh, hãy chắc chắn thay thế tên công ty ví dụ bằng tên công ty thực tế của bạn và các đối thủ trong mã bên dưới.

class CompetitorMonitor:

def __init__(self):

self.analyzer = SearchAnalyzer()

def analyze_competitors(self, company_name, competitors):

"""Phân tích một công ty so với các đối thủ cạnh tranh của nó"""

all_data = {}

# Tìm kiếm cho mỗi công ty

for comp in [company_name] + competitors:

print(f"\nĐang phân tích: {comp}")

# Tìm kiếm tin tức và cập nhật gần đây

news_query = f"{comp} tin tức cập nhật mới nhất 2025"

data = self.analyzer.analyze_topic(news_query)

if data:

all_data[comp] = data

# Tạo phân tích so sánh

comparative_prompt = f"""

So sánh {company_name} với các đối thủ cạnh tranh dựa trên dữ liệu này:

{json.dumps(all_data, indent=2)}

Cung cấp:

1. Vị trí cạnh tranh

2. Điểm mạnh độc đáo của mỗi công ty

3. Cơ hội thị trường

4. Khuyến nghị chiến lược cho {company_name}

"""

response = self.analyzer.model.generate_content(comparative_prompt)

return {

"company": company_name,

"competitors": competitors,

"analysis": response.text,

"raw_data": all_data

}Trường hợp sử dụng 2: Giám sát xu hướng

class TrendMonitor:

def __init__(self):

self.analyzer = SearchAnalyzer()

self.scraper = ScrapelessClient()

def monitor_trend(self, keyword, time_range="d"):

"""Giám sát xu hướng cho một từ khóa"""

# Ánh xạ các khoảng thời gian tới tham số tbs của Google

time_map = {

"h": "qdr:h", # Giờ qua

"d": "qdr:d", # Ngày qua

"w": "qdr:w", # Tuần qua

"m": "qdr:m" # Tháng qua

}

# Tìm kiếm với bộ lọc thời gian

results = self.scraper.search_google(

keyword,

tbs=time_map.get(time_range, "qdr:d"),

num=30

)

if not results:

return None

# Phân tích xu hướng

prompt = f"""

Phân tích xu hướng cho "{keyword}" dựa trên các kết quả tìm kiếm gần đây:

{json.dumps(results.get("organic_results", [])[:15], indent=2)}

Xác định:

1. Các mẫu mới nổi

2. Các phát triển chính

3. Cảm xúc (tích cực/tiêu cực/ trung tính)

4. Dự đoán trong tương lai

5. Thông tin chi tiết hành động

"""

response = self.analyzer.model.generate_content(prompt)

return {

"keyword": keyword,

"time_range": time_range,

"analysis": response.text,

"result_count": len(results.get("organic_results", []))

}Bước 5: Tạo ứng dụng chính

def main():

# Khởi tạo các thành phần

competitor_monitor = CompetitorMonitor()

trend_monitor = TrendMonitor()

# Ví dụ 1: Phân tích đối thủ cạnh tranh

# QUAN TRỌNG: Thay thế các công ty ví dụ này bằng công ty thực tế và các đối thủ của bạn

print("=== PHÂN TÍCH ĐỐI THỦ CẠNH TRANH ===")

analysis = competitor_monitor.analyze_competitors(

company_name="OpenAI", # Thay thế bằng tên công ty của bạn

competitors=["Anthropic", "Google AI", "Meta AI"] # Thay thế bằng các đối thủ cạnh tranh của bạn

)

print("\nKết quả phân tích cạnh tranh:")

print(analysis["analysis"])

# Lưu kết quả

with open("competitor_analysis.json", "w") as f:

json.dump(analysis, f, indent=2)

# Ví dụ 2: Giám sát xu hướng

# QUAN TRỌNG: Thay thế từ khóa bằng các thuật ngữ cụ thể cho ngành của bạn

print("\n\n=== GIÁM SÁT XU HƯỚNG ===")

trends = trend_monitor.monitor_trend(

keyword="quy định trí tuệ nhân tạo", # Thay thế bằng từ khóa của bạn

time_range="w" # Tuần qua

)

print("\nKết quả phân tích xu hướng:")

print(trends["analysis"])

# Ví dụ 3: Phân tích nhiều chủ đề

# QUAN TRỌNG: Thay thế các chủ đề này bằng các chủ đề cụ thể cho ngành của bạn

print("\n\n=== PHÂN TÍCH NHIỀU CHỦ ĐỀ ===")

topics = [

"ứng dụng kinh doanh AI sinh sinh", # Thay thế bằng chủ đề của bạn

"mối đe dọa an ninh mạng AI","máy học chăm sóc sức khỏe"

nếu không có kết quả tìm kiếm:

quay lại None

# Bước 2: Trích xuất thông tin chính

dữ liệu_trích xuất = self._extract_results(kết_quả_tìm_kiếm)

# Bước 3: Phân tích với Gemini

prompt = f"""

Phân tích những kết quả tìm kiếm này về "{chủ đề}":

{json.dumps(dữ liệu_trích xuất, indent=2)}

Cung cấp:

1. Chủ đề và xu hướng chính

2. Nguồn thông tin chính

3. Những điểm nổi bật

4. Hành động đề xuất

Định dạng phản hồi của bạn dưới dạng một báo cáo rõ ràng, có thể hành động.

"""

phản hồi = self.model.generate_content(prompt)

quay lại {

"chủ đề": chủ đề,

"dữ liệu_tìm_kiếm": dữ liệu_trích xuất,

"phân_tích": phản hồi.text

}

def _extract_results(self, dữ_liệu_tìm_kiếm):

"""Trích xuất dữ liệu liên quan từ kết quả tìm kiếm"""

kết quả = []

nếu "organic_results" trong dữ_liệu_tìm_kiếm:

cho mục trong dữ_liệu_tìm_kiếm["organic_results"][:10]:

kết quả.append({

"tiêu đề": mục.get("title", ""),

"đoạn trích": mục.get("snippet", ""),

"liên kết": mục.get("link", ""),

"nguồn": mục.get("displayed_link", "")

})

quay lại kết quảclass CompetitorMonitor:

def init(self):

self.analyzer = SearchAnalyzer()

def analyze_competitors(self, tên_công_ty, đối_thủ):

"""Phân tích một công ty so với các đối thủ của nó"""

tất_cả_dữ_liệu = {}

# Tìm kiếm cho mỗi công ty

cho đối thủ trong [tên_công_ty] + đối_thủ:

print(f"\nĐang phân tích: {đối thủ}")

# Tìm kiếm tin tức và cập nhật gần đây

truy_vấn_tin_tức = f"{đối thủ} tin tức và cập nhật mới nhất 2025"

dữ liệu = self.analyzer.analyze_topic(truy_vấn_tin_tức)

nếu dữ liệu:

tất_cả_dữ_liệu[đối thủ] = dữ liệu

# Thêm độ trễ giữa các yêu cầu

time.sleep(2)

# Tạo phân tích so sánh

prompt_so_sánh = f"""

So sánh {tên_công_ty} với các đối thủ dựa trên dữ liệu này:

{json.dumps(tất_cả_dữ_liệu, indent=2)}

Cung cấp:

1. Vị trí cạnh tranh

2. Điểm mạnh độc đáo của mỗi công ty

3. Cơ hội thị trường

4. Khuyến nghị chiến lược cho {tên_công_ty}

"""

phản hồi = self.analyzer.model.generate_content(prompt_so_sánh)

quay lại {

"công_ty": tên_công_ty,

"đối_thủ": đối_thủ,

"phân_tích": phản hồi.text,

"dữ_liệu_thô": tất_cả_dữ_liệu

}class TrendMonitor:

def init(self):

self.analyzer = SearchAnalyzer()

self.scraper = ScrapelessClient()

def monitor_trend(self, từ_khóa, khoảng_thời_gian="d"):

"""Theo dõi xu hướng cho một từ khóa"""

# Ánh xạ các khoảng thời gian sang tham số tbs của Google

bản_đồ_thời_gian = {

"h": "qdr:h", # Giờ qua

"d": "qdr:d", # Ngày qua

"w": "qdr:w", # Tuần qua

"m": "qdr:m" # Tháng qua

}

# Tìm kiếm với bộ lọc thời gian

kết quả = self.scraper.search_google(

từ_khóa,

tbs=bản_đồ_thời_gian.get(khoảng_thời_gian, "qdr:d"),

num=30

)

nếu không có kết quả:

quay lại None

# Phân tích xu hướng

prompt = f"""

Phân tích các xu hướng cho "{từ_khóa}" dựa trên kết quả tìm kiếm gần đây:

{json.dumps(kết quả.get("organic_results", [])[:15], indent=2)}

Xác định:

1. Mô hình nổi lên

2. Các phát triển chính

3. Tâm trạng (tích cực/tiêu cực/trung lập)

4. Dự đoán tương lai

5. Những điểm có thể hành động

"""

phản hồi = self.analyzer.model.generate_content(prompt)

quay lại {

"từ_khóa": từ_khóa,

"khoảng_thời_gian": khoảng_thời_gian,

"phân_tích": phản hồi.text,

"số_lượng_kết_quả": len(kết quả.get("organic_results", []))

}class DataExporter:

@staticmethod

def export_to_csv(dữ_liệu, tên_tập_tin=None):

"""Xuất kết quả tìm kiếm sang CSV"""

nếu tên_tập_tin là None:

tên_tập_tin = f"kết_quả_tìm_kiếm_{datetime.now().strftime('%Y%m%d_%H%M%S')}.csv"

# Làm phẳng cấu trúc dữ liệu

hàng = []

cho mục trong dữ_liệu:

nếu isinstance(mục, dict) và "dữ_liệu_tìm_kiếm" trong mục:

cho kết quả trong mục["dữ_liệu_tìm_kiếm"]:

hàng.append({

"chủ đề": mục.get("chủ đề", ""),

"tiêu đề": kết quả.get("tiêu đề", ""),

"đoạn trích": kết quả.get("đoạn trích", ""),

"liên kết": kết quả.get("liên kết", ""),

"nguồn": kết quả.get("nguồn", "")

})

df = pd.DataFrame(hàng)

vi

df.to_csv(filename, index=False)

print(f"Dữ liệu đã được xuất sang {filename}")

return filename

@staticmethod

def create_html_report(analysis_data, filename="report.html"):

"""Tạo báo cáo HTML từ dữ liệu phân tích"""

html = f"""

<!DOCTYPE html>

<html>

<head>

<title>Báo cáo Phân tích Tìm kiếm</title>

<style>

body {{ font-family: Arial, sans-serif; margin: 40px; }}

.section {{ margin-bottom: 30px; padding: 20px;

background-color: #f5f5f5; border-radius: 8px; }}

h1 {{ color: #333; }}

h2 {{ color: #666; }}

pre {{ white-space: pre-wrap; word-wrap: break-word; }}

</style>

</head>

<body>

<h1>Báo cáo Phân tích Tìm kiếm</h1>

<p>Ngày tạo: {datetime.now().strftime('%Y-%m-%d %H:%M:%S')}</p>

<div class="section">

<h2>Kết quả Phân tích</h2>

<pre>{analysis_data.get('analysis', 'Không có kết quả phân tích')}</pre>

</div>

<div class="section">

<h2>Tóm tắt Dữ liệu</h2>

<p>Chủ đề: {analysis_data.get('topic', 'N/A')}</p>

<p>Kết quả đã phân tích: {len(analysis_data.get('search_data', []))}</p>

</div>

</body>

</html>

"""

with open(filename, 'w') as f:

f.write(html)

print(f"Báo cáo HTML đã được tạo: {filename}")

def main():

# Khởi tạo các thành phần

competitor_monitor = CompetitorMonitor()

trend_monitor = TrendMonitor()

exporter = DataExporter()

# Ví dụ 1: Phân tích Đối thủ

print("=== PHÂN TÍCH ĐỐI THỦ ===")

analysis = competitor_monitor.analyze_competitors(

company_name="OpenAI",

competitors=["Anthropic", "Google AI", "Meta AI"]

)

print("\nKết quả Phân tích Cạnh tranh:")

print(analysis["analysis"])

# Lưu kết quả

with open("competitor_analysis.json", "w") as f:

json.dump(analysis, f, indent=2)

# Ví dụ 2: Theo dõi Xu hướng

print("\n\n=== THEO DÕI XU HƯỚNG ===")

trends = trend_monitor.monitor_trend(

keyword="quy định trí tuệ nhân tạo",

time_range="w" # Tuần trước

)

print("\nKết quả Phân tích Xu hướng:")

print(trends["analysis"])

# Ví dụ 3: Phân tích Đa Chủ Đề

print("\n\n=== PHÂN TÍCH ĐA CHỦ ĐỀ ===")

topics = [

"ứng dụng kinh doanh AI",

"mối đe dọa an ninh mạng AI",

"chăm sóc sức khỏe học máy"

]

analyzer = SearchAnalyzer()

all_results = []

for topic in topics:

print(f"\nĐang phân tích: {topic}")

result = analyzer.analyze_topic(topic)

if result:

all_results.append(result)

# Lưu phân tích cá nhân

filename = f"{topic.replace(' ', '_')}_analysis.txt"

with open(filename, "w") as f:

f.write(result["analysis"])

print(f"Phân tích đã được lưu vào {filename}")

# Tạm dừng giữa các yêu cầu

time.sleep(2)

# Xuất tất cả kết quả sang định dạng CSV

if all_results:

csv_file = exporter.export_to_csv(all_results)

print(f"\nTất cả kết quả đã được xuất sang: {csv_file}")

# Tạo báo cáo HTML cho kết quả đầu tiên

if all_results[0]:

exporter.create_html_report(all_results[0])

if __name__ == "__main__":

main()Kết Luận

Chúc mừng! Bạn đã xây dựng thành công một hệ thống phân tích tìm kiếm toàn diện kết hợp khả năng thu thập dữ liệu web cấp doanh nghiệp từ Scrapeless với phân tích AI tiên tiến của Google Gemini. Giải pháp thông minh này biến đổi dữ liệu tìm kiếm thô thành những hiểu biết kinh doanh có thể hành động một cách tự động.

Những gì bạn đã đạt được

Thông qua hướng dẫn này, bạn đã tạo ra một hệ thống mô-đun, sẵn sàng cho sản xuất bao gồm:

- Thu thập Dữ liệu Tự động: Kết quả tìm kiếm Google theo thời gian thực thông qua API Scrapeless

- Phân tích Dựa trên AI: Tạo ra những hiểu biết thông minh bằng cách sử dụng Google Gemini

- Thông tin về Đối thủ: Giám sát toàn diện cảnh quan cạnh tranh

- Phát hiện Xu hướng: Xác định và phân tích xu hướng thị trường theo thời gian thực

- Báo cáo Đa định dạng: Xuất định dạng CSV và báo cáo HTML để chia sẻ với các bên liên quan

- Kiến trúc Có thể Mở rộng: Thiết kế mô-đun dễ dàng tùy chỉnh và mở rộng

Lợi ích Chính cho Doanh Nghiệp của Bạn

Quyết định Chiến lược: Biến dữ liệu tìm kiếm thành những hiểu biết chiến lược giúp thúc đẩy quyết định kinh doanh thông minh và định vị cạnh tranh.

Hiệu quả Thời gian: Tự động hóa hàng giờ nghiên cứu thủ công chỉ trong vài phút phân tích tự động, giúp đội ngũ của bạn có thời gian cho công việc chiến lược có giá trị cao hơn.

Nhận thức Thị trường: Luôn đi trước các xu hướng ngành, động thái của đối thủ và cơ hội mới nổi với khả năng giám sát theo thời gian thực.

Trí Thông Minh Tiết Kiệm Chi Phí: Tận dụng các công cụ cấp doanh nghiệp với một phần chi phí so với các giải pháp nghiên cứu thị trường truyền thống.

Mở Rộng Hệ Thống Của Bạn

Kiến trúc mô-đun giúp dễ dàng mở rộng chức năng:

- Nguồn Dữ Liệu Bổ Sung: Tích hợp API mạng xã hội, nguồn tin tức hoặc cơ sở dữ liệu ngành

- Phân Tích Nâng Cao: Thêm phân tích cảm xúc, nhận diện thực thể hoặc mô hình dự đoán

- Trực Quan Hóa: Tạo bảng điều khiển tương tác bằng các công cụ như Streamlit hoặc Dash

- Thông Báo: Thực hiện thông báo thời gian thực cho các thay đổi quan trọng trên thị trường

- Hỗ Trợ Đa Ngôn Ngữ: Mở rộng theo dõi đến các thị trường toàn cầu với tìm kiếm địa phương hóa

Các Thực Hành Tốt Nhất Để Thành Công

- Bắt Đầu Nhỏ: Bắt đầu với các từ khóa cụ thể và dần dần mở rộng phạm vi theo dõi của bạn

- Lặp Lại Các Thông Điệp: Liên tục hoàn thiện các prompt AI của bạn dựa trên chất lượng đầu ra

- Xác Thực Kết Quả: Đối chiếu thông tin AI với xác minh thủ công ban đầu

- Cập Nhật Định Kỳ: Giữ cho danh sách đối thủ và từ khóa của bạn luôn cập nhật

- Phản Hồi Từ Cổ Đông: Thu thập ý kiến từ người dùng cuối để cải thiện tính liên quan của báo cáo

Những Suy Nghĩ Cuối Cùng

Hệ thống phân tích tìm kiếm này đại diện cho một bước quan trọng hướng đến trí tuệ kinh doanh dựa trên dữ liệu. Bằng cách kết hợp việc thu thập dữ liệu đáng tin cậy của Scrapeless với khả năng phân tích của Gemini, bạn đã tạo ra một công cụ mạnh mẽ có thể thích ứng với hầu như bất kỳ ngành nào hoặc trường hợp sử dụng nào.

Đầu tư xây dựng hệ thống này sẽ mang lại lợi ích thông qua việc cải thiện nhận thức về thị trường, trí tuệ cạnh tranh và khả năng ra quyết định chiến lược. Khi bạn tiếp tục hoàn thiện và mở rộng hệ thống, bạn sẽ khám phá thêm những cơ hội mới để tận dụng dữ liệu tìm kiếm cho sự phát triển kinh doanh.

Hãy nhớ rằng việc thực hiện thành công không chỉ phụ thuộc vào công nghệ, mà còn vào cách bạn tích hợp những hiểu biết này vào quy trình kinh doanh và quy trình ra quyết định của mình.

Để có thêm tài nguyên, tính năng nâng cao và tài liệu API, hãy truy cập Tài Liệu Scrapeless.

Tại Scrapless, chúng tôi chỉ truy cập dữ liệu có sẵn công khai trong khi tuân thủ nghiêm ngặt các luật, quy định và chính sách bảo mật trang web hiện hành. Nội dung trong blog này chỉ nhằm mục đích trình diễn và không liên quan đến bất kỳ hoạt động bất hợp pháp hoặc vi phạm nào. Chúng tôi không đảm bảo và từ chối mọi trách nhiệm đối với việc sử dụng thông tin từ blog này hoặc các liên kết của bên thứ ba. Trước khi tham gia vào bất kỳ hoạt động cạo nào, hãy tham khảo ý kiến cố vấn pháp lý của bạn và xem xét các điều khoản dịch vụ của trang web mục tiêu hoặc có được các quyền cần thiết.