Sử dụng Trình duyệt X Không bị rác

Senior Web Scraping Engineer

Sử dụng Browser Use là một SDK tự động hóa trình duyệt sử dụng ảnh chụp màn hình để ghi lại trạng thái trình duyệt và các hành động để mô phỏng tương tác của người dùng. Chương này sẽ giới thiệu cách bạn có thể dễ dàng sử dụng browser-use để thực hiện các tác vụ của tác nhân trên Web bằng các lệnh gọi đơn giản.

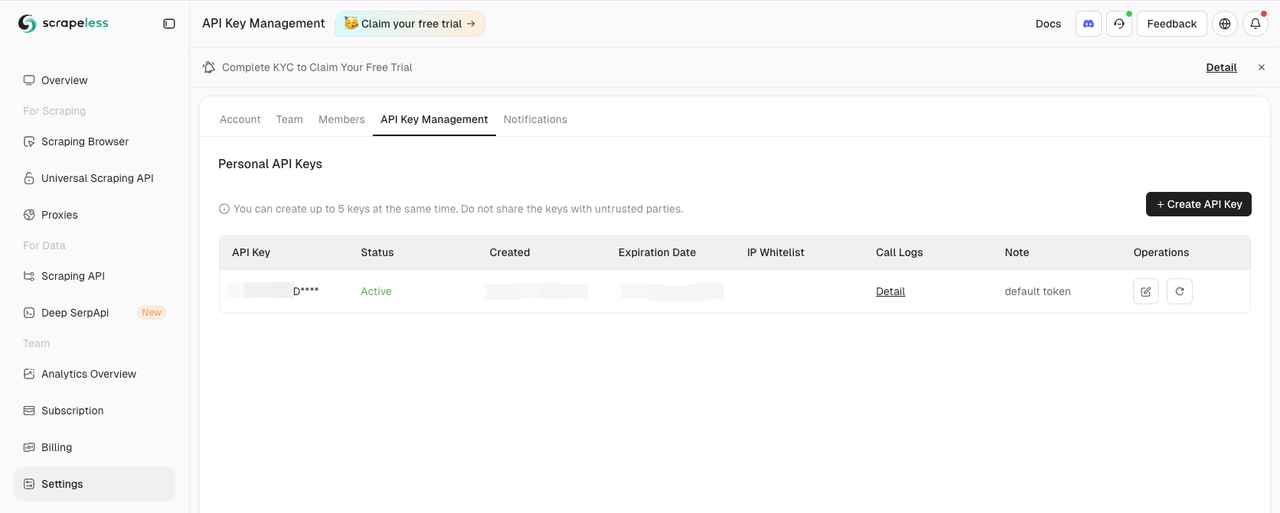

Lấy API Key Scrapeless

Truy cập vào Tab Cài đặt của Dashboard:

Sau đó, sao chép và thiết lập biến môi trường SCRAPELESS_API_KEY trong tệp .env của bạn.

Biến môi trường OPENAI_API_KEY trong tệp .env của bạn cũng cần thiết.

.env

OPENAI_API_KEY=your-openai-api-key

SCRAPELESS_API_KEY=your-scrapeless-api-key💡 Nhớ thay thế khóa API mẫu bằng khóa API thực của bạn

Cài đặt Browser Use

Sử dụng pip (Python>=3.11):

Shell

pip install browser-useĐối với chức năng bộ nhớ (yêu cầu Python<3.13 do khả năng tương thích với PyTorch):

Shell

pip install "browser-use[memory]"Cấu hình Trình duyệt và Tác nhân

Đây là cách cấu hình trình duyệt và tạo một tác nhân tự động hóa:

Python

from dotenv import load_dotenv

import os

import asyncio

from urllib.parse import urlencode

from langchain_openai import ChatOpenAI

from browser_use import Agent, Browser, BrowserConfig

from pydantic import SecretStr

task = "Đi đến Google, tìm kiếm 'Scrapeless', nhấp vào bài viết đầu tiên và quay trở lại tiêu đề"

async def setup_browser() -> Browser:

scrapeless_base_url = "wss://browser.scrapeless.com/browser"

query_params = {

"token": os.environ.get("SCRAPELESS_API_KEY"),

"session_ttl": 180,

"proxy_country": "ANY"

}

browser_ws_endpoint = f"{scrapeless_base_url}?{urlencode(query_params)}"

config = BrowserConfig(cdp_url=browser_ws_endpoint)

browser = Browser(config)

return browser

async def setup_agent(browser: Browser) -> Agent:

llm = ChatOpenAI(

model="gpt-4o", # Hoặc chọn mô hình bạn muốn sử dụng

api_key=SecretStr(os.environ.get("OPENAI_API_KEY")),

)

return Agent(

task=task,

llm=llm,

browser=browser,

)Tạo Hàm Chính

Đây là hàm chính kết hợp mọi thứ lại với nhau:

Python

async def main():

load_dotenv()

browser = await setup_browser()

agent = await setup_agent(browser)

result = await agent.run()

print(result)

await browser.close()

asyncio.run(main())Chạy tập lệnh của bạn

Chạy tập lệnh của bạn:

Shell

python run main.pyBạn sẽ thấy phiên Scrapeless của bạn bắt đầu trong Dashboard Scrapeless.

Mã Hoàn Chỉnh

Python

from dotenv import load_dotenv

import os

import asyncio

from urllib.parse import urlencode

from langchain_openai import ChatOpenAI

from browser_use import Agent, Browser, BrowserConfig

from pydantic import SecretStr

task = "Đi đến Google, tìm kiếm 'Scrapeless', nhấp vào bài viết đầu tiên và quay trở lại tiêu đề"

async def setup_browser() -> Browser:

scrapeless_base_url = "wss://browser.scrapeless.com/browser"

query_params = {

"token": os.environ.get("SCRAPELESS_API_KEY"),

"session_ttl": 180,

"proxy_country": "ANY"

}

browser_ws_endpoint = f"{scrapeless_base_url}?{urlencode(query_params)}"

config = BrowserConfig(cdp_url=browser_ws_endpoint)

browser = Browser(config)

return browser

async def setup_agent(browser: Browser) -> Agent:

llm = ChatOpenAI(

model="gpt-4o", # Hoặc chọn mô hình bạn muốn sử dụng

api_key=SecretStr(os.environ.get("OPENAI_API_KEY")),

)

return Agent(

task=task,

llm=llm,

browser=browser,

)

async def main():

load_dotenv()

browser = await setup_browser()

agent = await setup_agent(browser)

result = await agent.run()

print(result)

await browser.close()

asyncio.run(main())💡 Browser Use hiện chỉ hỗ trợ Python.

💡 Bạn có thể sao chép URL trong phiên trực tiếp để theo dõi tiến trình của phiên theo thời gian thực, và bạn cũng có thể xem lại video của phiên trong lịch sử phiên.

Tại Scrapless, chúng tôi chỉ truy cập dữ liệu có sẵn công khai trong khi tuân thủ nghiêm ngặt các luật, quy định và chính sách bảo mật trang web hiện hành. Nội dung trong blog này chỉ nhằm mục đích trình diễn và không liên quan đến bất kỳ hoạt động bất hợp pháp hoặc vi phạm nào. Chúng tôi không đảm bảo và từ chối mọi trách nhiệm đối với việc sử dụng thông tin từ blog này hoặc các liên kết của bên thứ ba. Trước khi tham gia vào bất kỳ hoạt động cạo nào, hãy tham khảo ý kiến cố vấn pháp lý của bạn và xem xét các điều khoản dịch vụ của trang web mục tiêu hoặc có được các quyền cần thiết.