Pipedream é uma poderosa plataforma de integração sem servidor que permite aos desenvolvedores conectar facilmente centenas de aplicativos e APIs, possibilitando a construção rápida de fluxos de trabalho automatizados. Os usuários podem escrever lógica personalizada usando JavaScript, Python e outras linguagens sem gerenciar nenhuma infraestrutura.

Ele suporta arquitetura orientada a eventos e integra-se a serviços populares como Slack, Notion, GitHub e Stripe. O Pipedream é especialmente adequado para construir webhooks, sincronização de dados, sistemas de notificação e outros cenários de automação, aumentando significativamente a eficiência e flexibilidade do desenvolvimento.

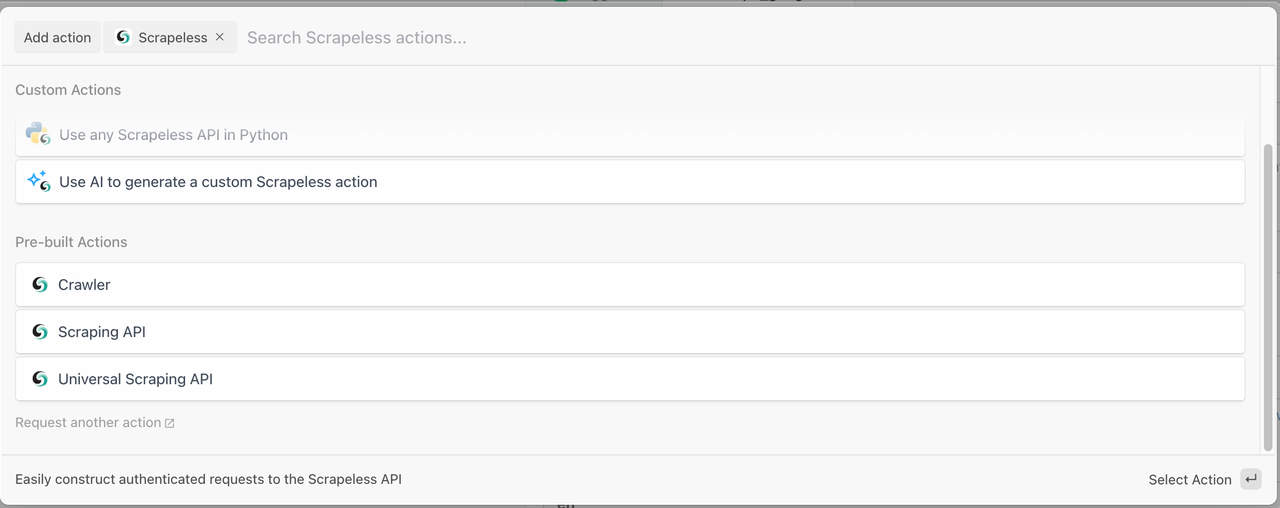

Scrapeless fornece os seguintes módulos dentro do Pipedream:

1. Crawler

- Crawler Scrape: Extrair dados de uma única página da web.

- Crawler Crawl: Navegar por um site e suas páginas vinculadas para extrair dados abrangentes.

2. Scraping API

- Acesse e recupere facilmente ricos dados de pesquisa do Google SERP e Google Trends.

3. Universal Scraping API

- Acesse páginas protegidas ou dinâmicas. Lida automaticamente com mecanismos de proteção contra scraping.

Como Criar um Sistema de Rastreamento Inteligente de Gráfico de Conhecimento (Pipedream + Scrapeless)

Pré-requisitos

- Você se registrou no Scrapeless e obteve um token de API.

- Você tem uma URL de Webhook do Discord (para enviar notificações).

Primeiro, você precisará concluir a seguinte configuração:

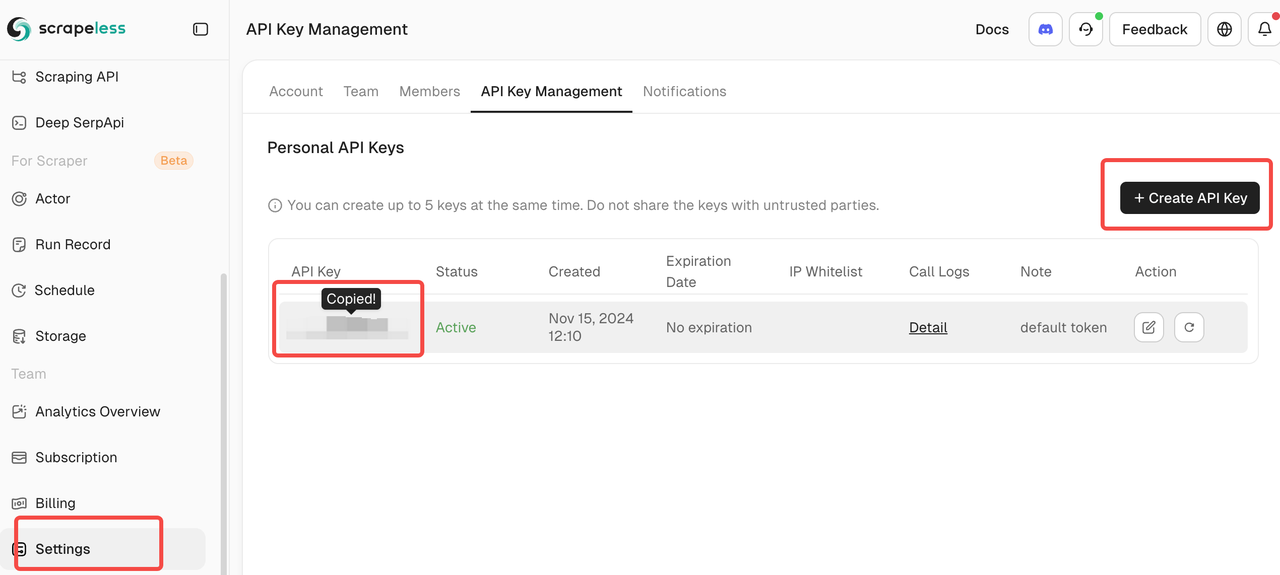

- Chave da API do Scrapeless: Por favor, inscreva-se para uma conta no Scrapeless. Após o registro, você pode acessar sua chave de API no painel.

- Conta Pipedream: Crie uma conta Pipedream.

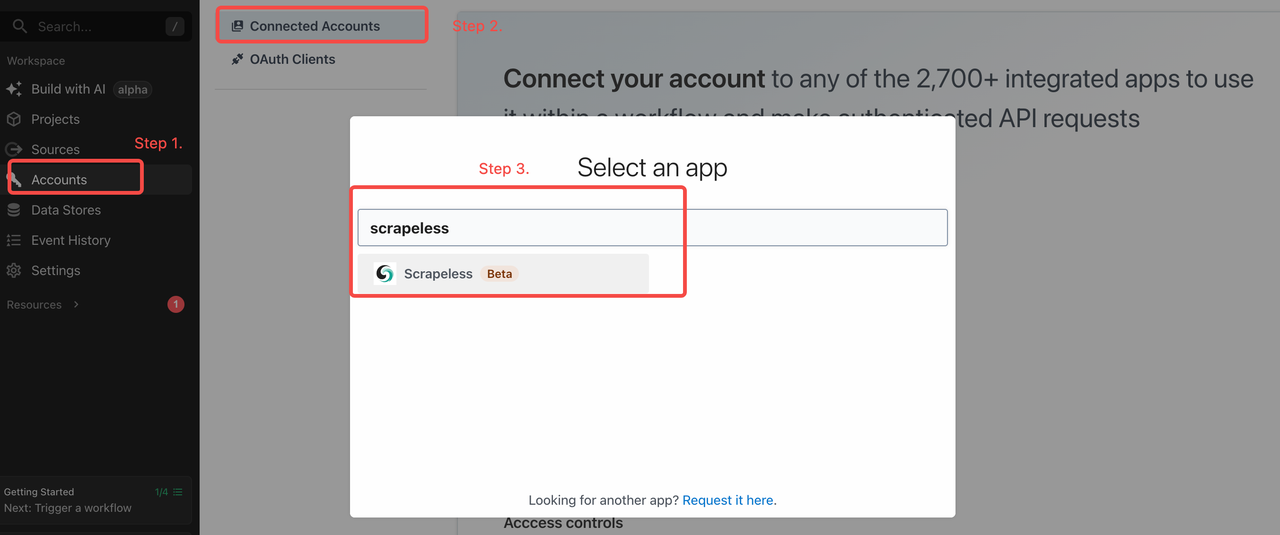

Etapa 1: Configure Sua Chave da API Scrapeless no Pipedream

Você precisa fazer login na sua conta Scrapeless e ir ao painel para obter sua chave de API.

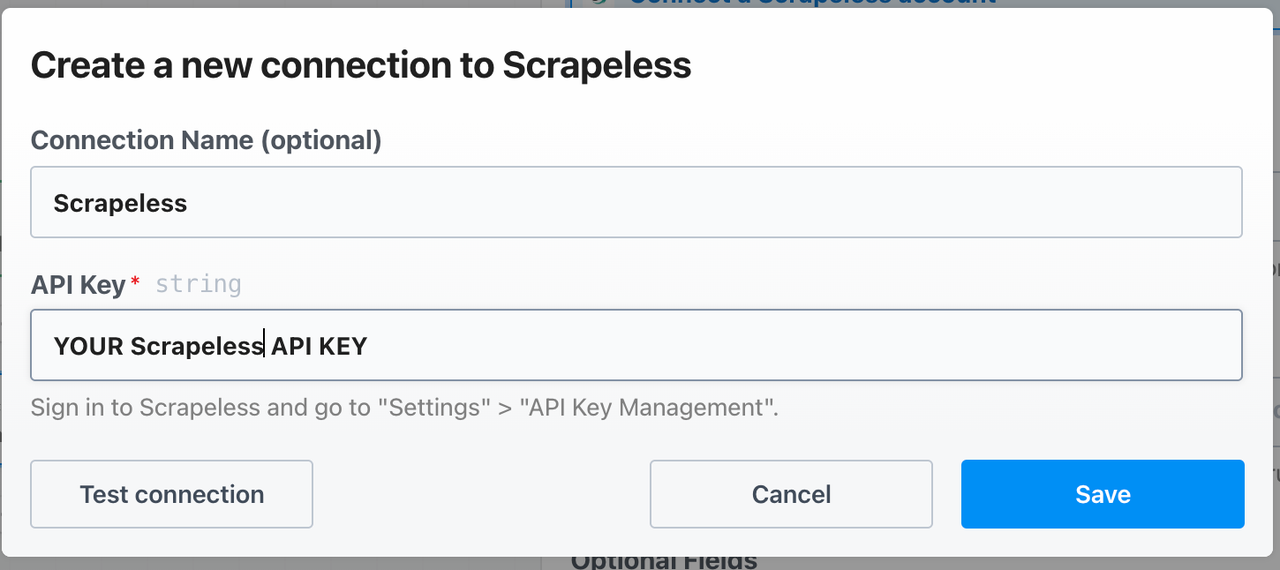

Uma vez que você tenha, vá até a aba "Contas" no Pipedream e adicione a chave lá, conforme mostrado abaixo:

Depois disso, defina sua chave de API assim:

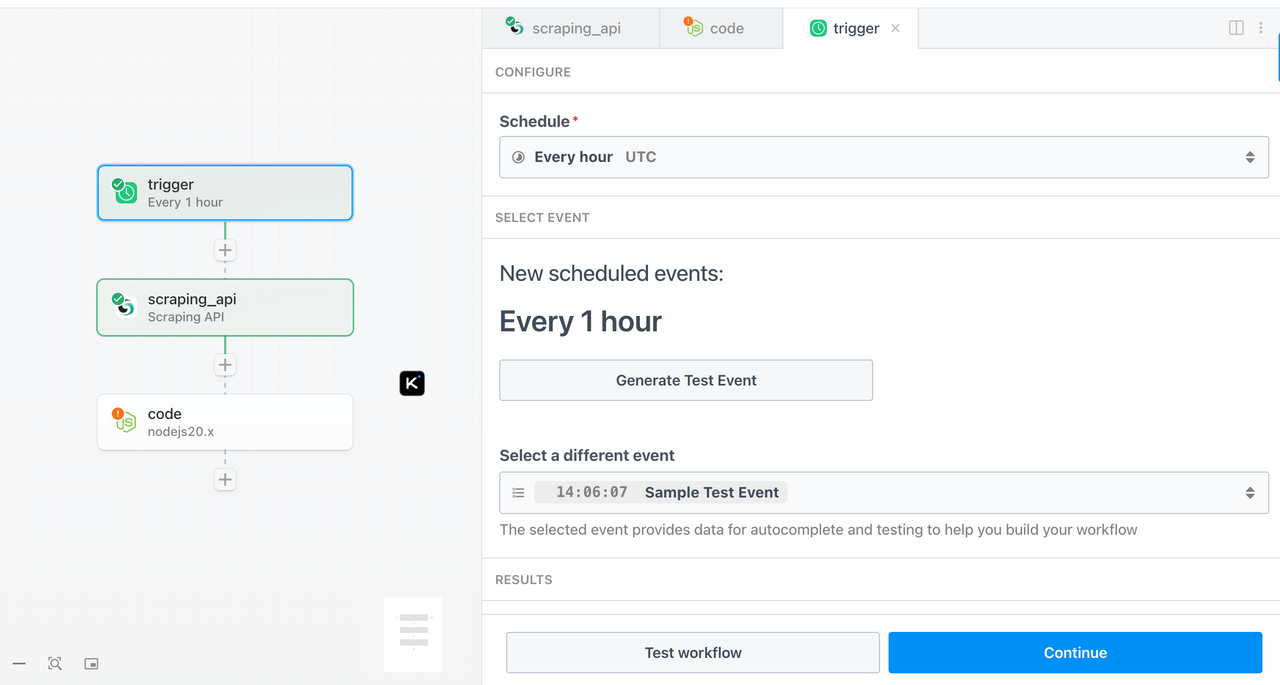

Etapa 2: Adicione um Gatilho - schedule_trigger

- Tipo: Agendar

- Hora do Gatilho: Todos os dias às 08:00 (UTC)

- Método: Use Cron ou um intervalo de tempo fixo

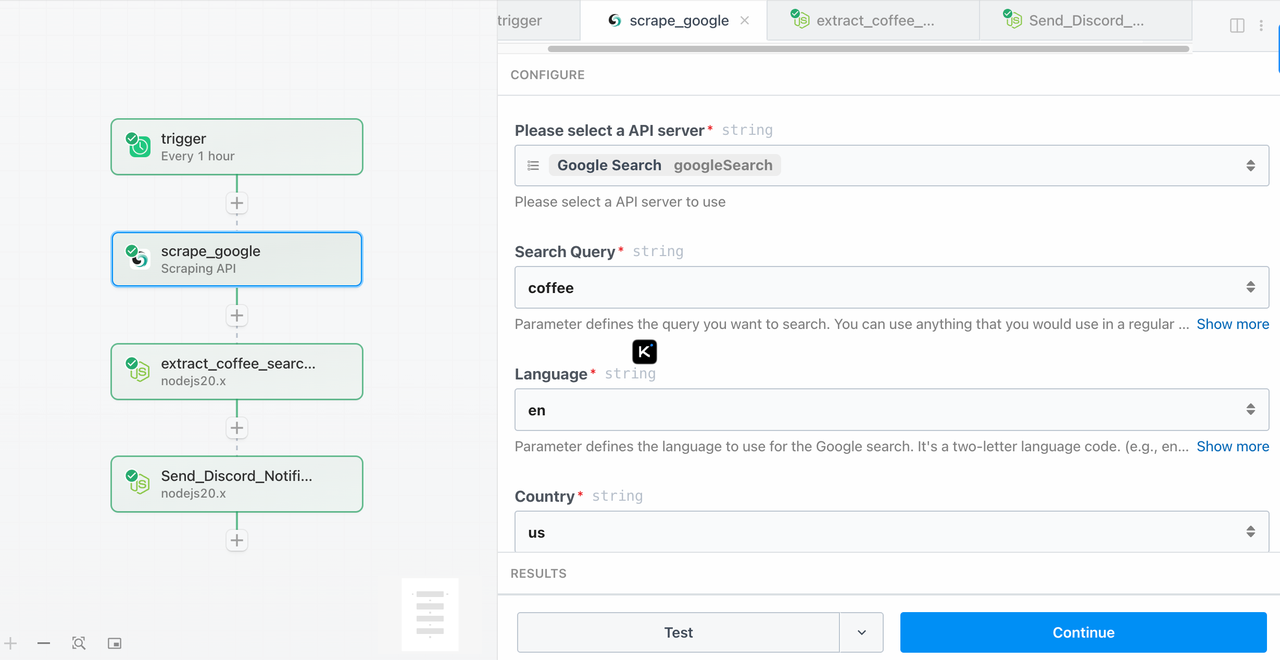

Etapa 3: Use Scrapeless para Pesquisar Informações do Painel de Conhecimento de uma Palavra-chave Específica

Componente:

google-search

Configurações dos Parâmetros:

query: cafégl: us (opcional)hl: en (opcional)

Etapa 4: Extraia Informações (extract_coffee_search_results)

Esta etapa extrai as informações do painel de conhecimento a partir dos dados da palavra-chave obtidos na etapa anterior.

Adicione uma etapa de código Node.js com o seguinte código:

export default defineComponent({

async run({ steps }) {

const searchResult = steps.scrape_google?.$return_value;

const webResults = searchResult?.knowledge_graph.web_results

if (!searchResult || !webResults) {

throw new Error("❌ Nenhum resultado válido retornado da Pesquisa Google do Scrapeless.");

}

const links = webResults.map((item) => item.link)

return {

links,

};

}

});Etapa 5: Envie Notificação do Discord (Send_Discord_Notification)

Esta etapa envia as informações obtidas na Etapa 4 para o seu canal do Discord especificado.

Adicione uma etapa Node.js com o seguinte código de exemplo:

import { axios } from "@pipedream/platform";

export default defineComponent({

async run({ steps, $ }) {

const results = steps.extract_coffee_search_results.$return_value?.links || []

console.log("resultado", results)

const sendLinks = results.slice(0, 5)

if (!sendLinks || sendLinks.length === 0) {

console.log("✅ Sem resultados de pesquisa para notificar.");

return { status: "no_results" };

}

const webhookUrl = "https://discord.com/api/webhooks/1381829187223949404/mweRKdQfJmA5OskoSZ0V_IApucOrMK7AHxN4YaAvjE3SRzp1xnbK4SFZLvMYjwnIFy1V"; // 🟡 Por favor, substitua isso pelo seu webhook

const lines = sendLinks.map(r => `📌 ${r}`).join("\n\n");

const message = {

content: `📡 **Monitor de Palavra-chave: "café"**\n\n${lines}\n\n⏰ Detectado em: ${new Date().toLocaleString()}`

};

try {

const res = await axios($, {

method: "POST",

url: webhookUrl,

headers: {

"Content-Type": "application/json"

},data: mensagem,

});

return { status: "enviado", res };

} catch (err) {

console.error("❌ Falha no webhook do Discord:", err);

return { status: "erro", error: err.message };

}},

});

Substitua a URL nesta linha pela sua própria URL do Webhook do Discord:const webhookUrl = "https://discord.com/api/webhooks/seu_id_do_webhook/seu_token_do_webhook";

---

Se você ainda não tem um Webhook, pode criar um no Discord da seguinte forma:

1. Abra o canal onde você deseja enviar notificações.

2. Clique em Configurações do Canal > Integrações > Webhooks.

3. Crie um novo Webhook e copie sua URL para usar como a webhookUrl mencionada acima.

---

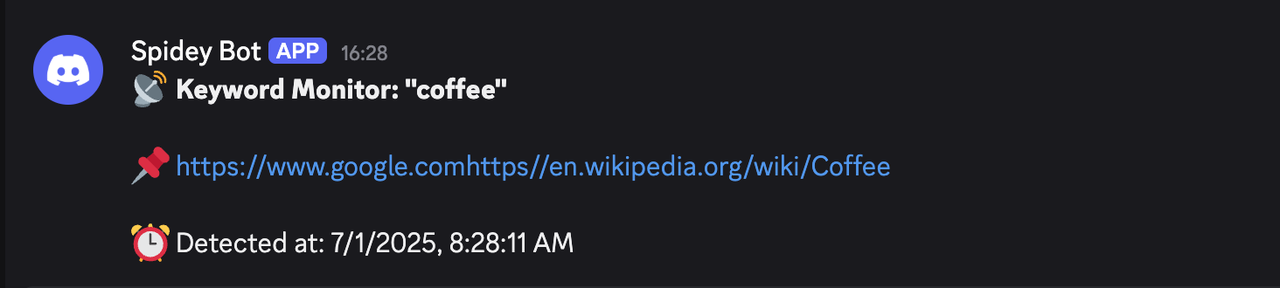

### Prévia (Mensagem Enviada)

Quando a página do Jasper.ai mudar, você receberá uma mensagem como esta no Discord:

Na Scorretless, acessamos apenas dados disponíveis ao público, enquanto cumprem estritamente as leis, regulamentos e políticas de privacidade do site aplicáveis. O conteúdo deste blog é apenas para fins de demonstração e não envolve atividades ilegais ou infratoras. Não temos garantias e negamos toda a responsabilidade pelo uso de informações deste blog ou links de terceiros. Antes de se envolver em qualquer atividade de raspagem, consulte seu consultor jurídico e revise os termos de serviço do site de destino ou obtenha as permissões necessárias.