Make(以前はIntegromatとして知られていた)は、複数のアプリケーション間の接続を可能にし、シームレスなデータ交換を促進する、視覚的なノーコードの統合プラットフォームです。Make自身の説明によれば、「アプリ間でデータを共有するために開発者である必要はありません。」

ScrapelessとMakeの統合により、ウェブデータの収集と処理が効率化されます。この統合を利用することで、ウェブサイトのスクレイピング、データセットの取得、APIコールなどのタスクを自動化できます。

Scrapelessは、Makeで以下の5つのモジュールを提供しています。

- ウェブサイトをアンロックする – ボットを通常ブロックするJSレンダリングされたウェブサイトからデータにアクセスし、抽出します。

- すべてのページからデータをクロールする – ウェブサイトとそのリンクされたページをクロールして包括的なデータを抽出します。

- 単一ページからデータをスクレイピングする – 単一のウェブページから情報を抽出します。

- Googleを検索する – Googleからリッチな検索データに簡単にアクセスし、取得します。

- APIコールを行う – Scrapeless APIに対して、任意の認可されたリクエストを実行します。

ScrapelessをMake.comで使用する理由

ScrapelessをMakeに統合することで、単一のコード行も書くことなく、複雑なウェブデータパイプラインを構築できます。

ダイアグラムを視覚的に設計し、Scrapelessを2,000以上の他のアプリケーションやサービスと接続して自動化できます。たとえば、次のことができます。

- ウェブアンロッカーを使用して制限を回避し、任意のウェブサイトにアクセスする。

- Crawler Crawlを使用して再帰的にクロールし、リンクされたすべてのページからデータを取得する。

- Crawler Scrapeを使用して、個々のページの詳細なスクレイピングを実行する。

- Deep SerpApiにアクセスして、単一のリクエストでGoogle SERPデータを取得・抽出する。

- 認可されたScrapeless APIコールをトリガーする。

これらの機能により、ScrapelessをGoogle Sheets、Airtable、Notion、Slack、または内部システムなどのツールと接続して、エンドツーエンドのデータフローを構築できます。

MakeでScrapelessサービスに接続する方法

ステップ1. Scrapeless APIキーを取得する

- アカウントを作成し、Scrapelessダッシュボードにログインします。

- Scrapeless APIキーを生成します。

ステップ2. 新しいシナリオを作成する

- Make.comアカウントにログインします。

- 右上の「新しいシナリオを作成」をクリックします。

ステップ3. Googleシートを作成する

スクレイピングしたデータを保存するためにGoogle Sheetsを使用します。以下の手順で作成します。

- A1:D1をテーブルヘッダーとして使用します(この範囲を後で参照します)。

- ヘッダー値を次のように設定します:

キーワード,タイトル,リンク,位置。

ステップ4. GoogleシートをMakeに接続する

- 「+」ボタンをクリックして、Google Sheetsの下の「範囲値を取得」を選択します。

- Googleアカウントに接続します。

- 適切な範囲を入力または選択します。

ヘッダーを設定したので、「はい」を選択し、ヘッダー範囲を入力します: "A1:D1"。

ステップ5. シナリオにScrapelessのモジュールを追加する

-

Google Sheetsモジュールの右側にある「+」ボタンをクリックします。

-

一覧から「Scrapeless」を検索して選択します。

-

「Googleを検索」モジュールを選択します。

-

「追加」をクリックして接続名を作成します。

-

Scrapelessダッシュボードに戻り、APIキーをコピーしてフィールドに貼り付けます。

-

検索クエリ、言語、国のパラメーターを必要に応じて入力します(デフォルト値が表示される)。 -

「一度実行」をクリックしてモジュールをテストします。

ステップ6. イテレータモジュールを追加する

- 同じ手順でイテレータモジュールを追加します。

- 配列フィールドでorganic_results[]を選択します。

- 出力を確認するためにモジュールを実行します。

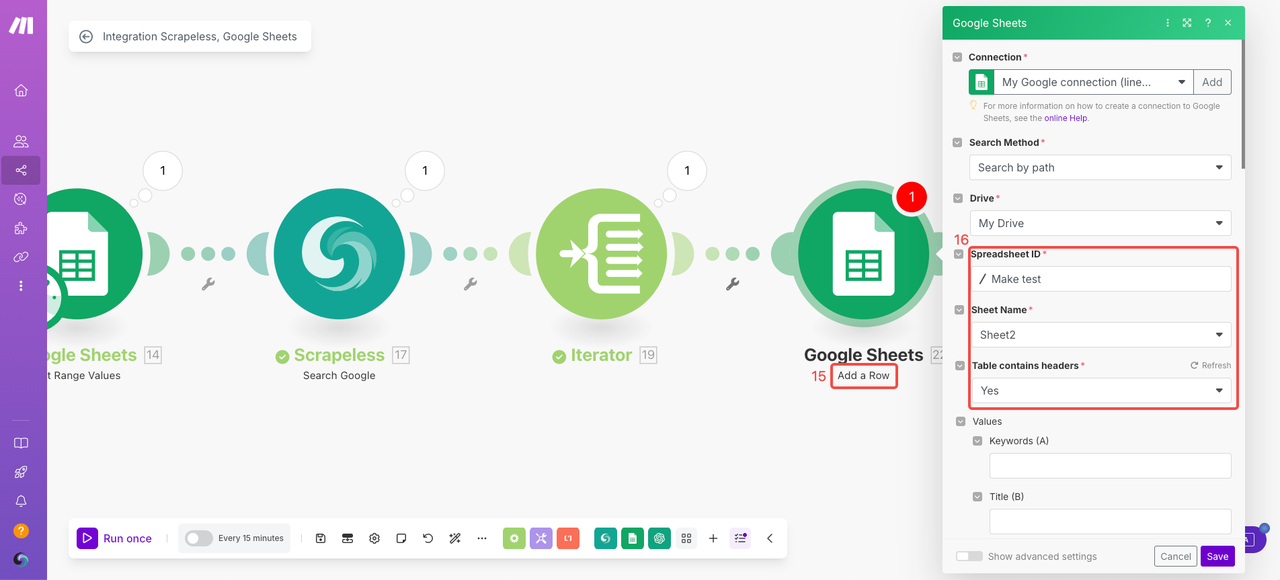

ステップ7. 「行を追加」を設定する

- Google Sheetsの下に「行を追加」モジュールを追加します。

- 基本のスプレッドシート設定を構成します。

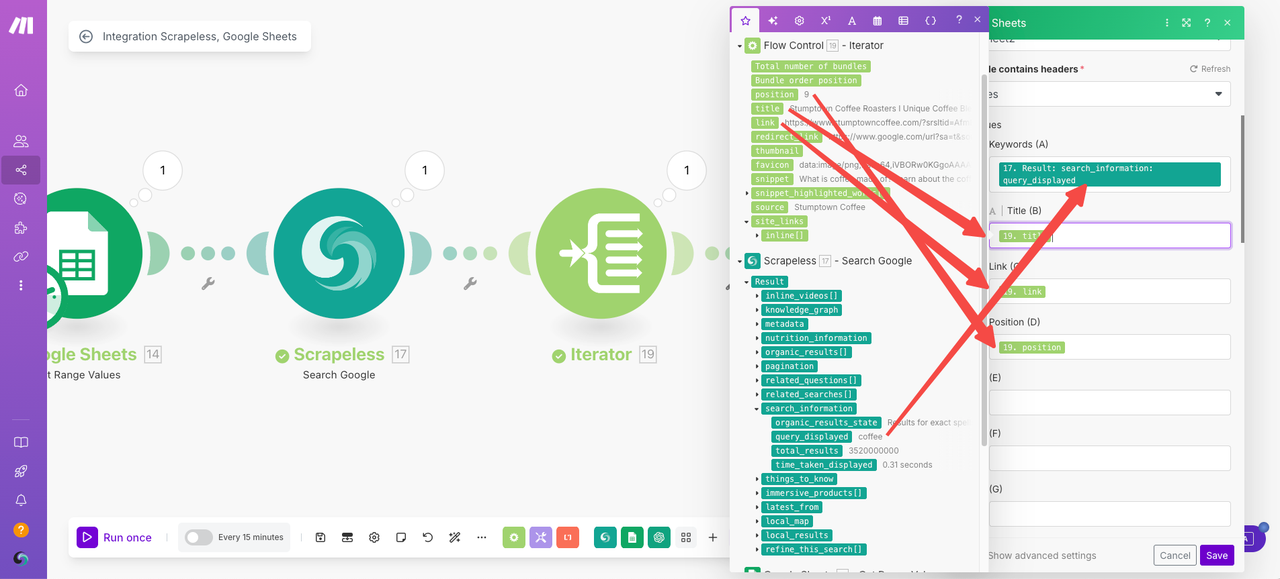

値セクションでは、Googleスプレッドシートが自動的に定義したヘッダーを検出します。出力フィールドを次のように論理的にマッピングします:

- キーワード → Scrapelessのリクエストパラメータを使用:

query_displayed - タイトル → イテレーターから選択:

title - リンク → イテレーターから選択:

link - 位置 → イテレーターから選択:

position

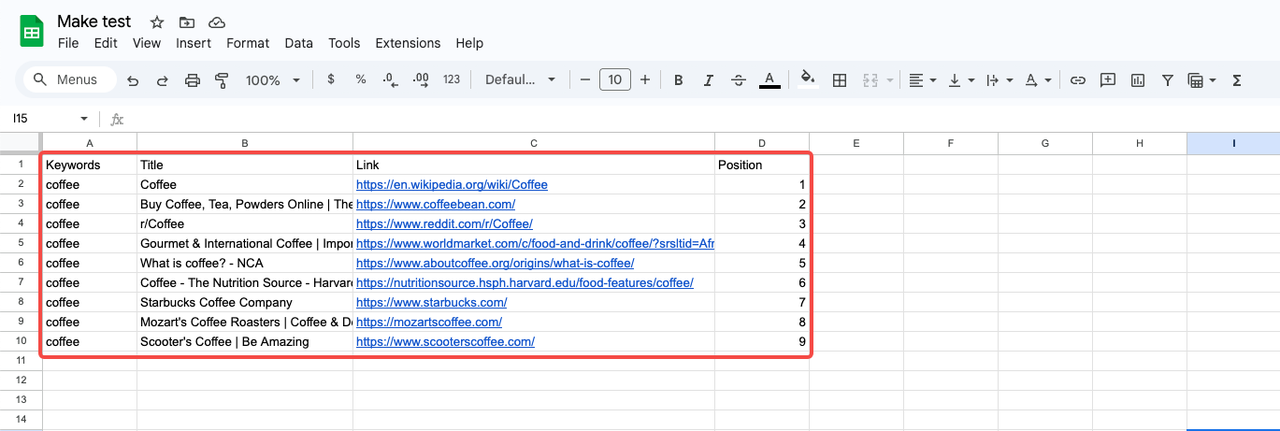

ステップ8. 実行してスクレイピング結果を取得する

- もう一度「1回実行」をクリックして、最終的なデータ結果をテストして取得します。

Scrapelessを使った初めてのMake自動化を構築する

ScrapelessとMakeの統合を今すぐ試して、フィードバックやユースケースを共有してください。ScrapelessダッシュボードからAPIキーを取得し、その後Make.comにアクセスして無料アカウントを作成し、自分自身のウェブデータ自動化ワークフローを構築し始めましょう!

Scrapelessでは、適用される法律、規制、およびWebサイトのプライバシーポリシーを厳密に遵守しながら、公開されているデータのみにアクセスします。 このブログのコンテンツは、デモンストレーションのみを目的としており、違法または侵害の活動は含まれません。 このブログまたはサードパーティのリンクからの情報の使用に対するすべての責任を保証せず、放棄します。 スクレイピング活動に従事する前に、法律顧問に相談し、ターゲットウェブサイトの利用規約を確認するか、必要な許可を取得してください。