ブラウザユースは、スクリーンショットを使用してブラウザの状態をキャプチャし、ユーザーのインタラクションをシミュレートするアクションを実行するブラウザ自動化SDKです。この章では、ブラウザユースを使用して、簡単な呼び出しでWeb上のエージェントタスクを実行する方法を紹介します。

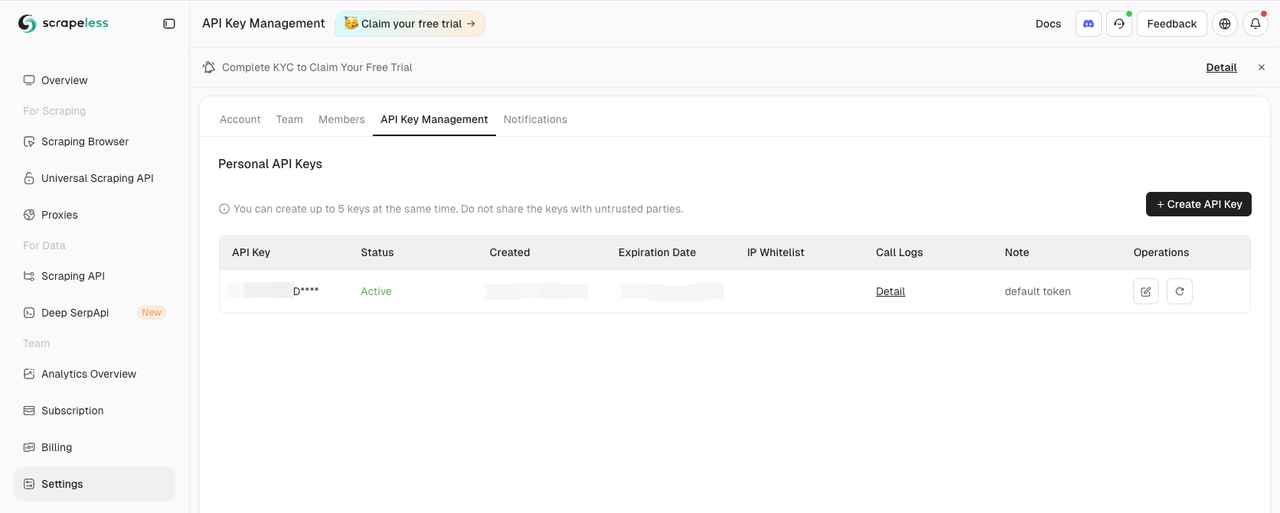

Scrapeless APIキーを取得する

ダッシュボードの設定タブに移動します。

次に、.envファイルにSCRAPELESS_API_KEY環境変数をコピーして設定します。

.envファイルにOPENAI_API_KEY環境変数も必要です。

.env

OPENAI_API_KEY=your-openai-api-key

SCRAPELESS_API_KEY=your-scrapeless-api-key💡 サンプルのAPIキーを実際のAPIキーに置き換えることを忘れないでください

ブラウザユースをインストールする

pipを使用して(Python>=3.11):

Shell

pip install browser-useメモリ機能を利用する場合(PyTorchの互換性のためにPython<3.13が必要):

Shell

pip install "browser-use[memory]"ブラウザとエージェントの構成を設定する

ブラウザを構成し、自動化エージェントを作成する方法は次のとおりです。

Python

from dotenv import load_dotenv

import os

import asyncio

from urllib.parse import urlencode

from langchain_openai import ChatOpenAI

from browser_use import Agent, Browser, BrowserConfig

from pydantic import SecretStr

task = "Googleに行き、'Scrapeless'を検索して、最初の投稿をクリックし、タイトルに戻ります"

async def setup_browser() -> Browser:

scrapeless_base_url = "wss://browser.scrapeless.com/browser"

query_params = {

"token": os.environ.get("SCRAPELESS_API_KEY"),

"session_ttl": 180,

"proxy_country": "ANY"

}

browser_ws_endpoint = f"{scrapeless_base_url}?{urlencode(query_params)}"

config = BrowserConfig(cdp_url=browser_ws_endpoint)

browser = Browser(config)

return browser

async def setup_agent(browser: Browser) -> Agent:

llm = ChatOpenAI(

model="gpt-4o", # または使用したいモデルを選択します

api_key=SecretStr(os.environ.get("OPENAI_API_KEY")),

)

return Agent(

task=task,

llm=llm,

browser=browser,

)メイン関数を作成する

すべてをまとめるメイン関数は次のとおりです。

Python

async def main():

load_dotenv()

browser = await setup_browser()

agent = await setup_agent(browser)

result = await agent.run()

print(result)

await browser.close()

asyncio.run(main())スクリプトを実行する

スクリプトを実行します。

Shell

python run main.pyScrapelessセッションがScrapelessダッシュボードで開始されるのが見えるはずです。

フルコード

Python

from dotenv import load_dotenv

import os

import asyncio

from urllib.parse import urlencode

from langchain_openai import ChatOpenAI

from browser_use import Agent, Browser, BrowserConfig

from pydantic import SecretStr

task = "Googleに行き、'Scrapeless'を検索して、最初の投稿をクリックし、タイトルに戻ります"

async def setup_browser() -> Browser:

scrapeless_base_url = "wss://browser.scrapeless.com/browser"

query_params = {

"token": os.environ.get("SCRAPELESS_API_KEY"),

"session_ttl": 180,

"proxy_country": "ANY"

}

browser_ws_endpoint = f"{scrapeless_base_url}?{urlencode(query_params)}"

config = BrowserConfig(cdp_url=browser_ws_endpoint)

browser = Browser(config)

return browser

async def setup_agent(browser: Browser) -> Agent:

llm = ChatOpenAI(

model="gpt-4o", # または使用したいモデルを選択します

api_key=SecretStr(os.environ.get("OPENAI_API_KEY")),

)

return Agent(

task=task,

llm=llm,

browser=browser,

)

async def main():

load_dotenv()

browser = await setup_browser()

agent = await setup_agent(browser)

result = await agent.run()

print(result)

await browser.close()

asyncio.run(main())💡 ブラウザユースは現在、Pythonのみをサポートしています。

💡 ライブセッションのURLをコピーして、セッションの進行状況をリアルタイムで監視でき、セッション履歴でセッションの再生を見ることもできます。

Scrapelessでは、適用される法律、規制、およびWebサイトのプライバシーポリシーを厳密に遵守しながら、公開されているデータのみにアクセスします。 このブログのコンテンツは、デモンストレーションのみを目的としており、違法または侵害の活動は含まれません。 このブログまたはサードパーティのリンクからの情報の使用に対するすべての責任を保証せず、放棄します。 スクレイピング活動に従事する前に、法律顧問に相談し、ターゲットウェブサイトの利用規約を確認するか、必要な許可を取得してください。