Kayak से उड़ान डेटा कैसे स्क्रैप करें

Advanced Data Extraction Specialist

क्या आप Kayak से उड़ान की कीमतों पर नज़र रखना, डील्स की तुलना करना या यात्रा संबंधी जानकारी इकट्ठा करना चाहते हैं? ✈️ उड़ान डेटा को स्क्रैप करना आपको एक प्रतिस्पर्धात्मक बढ़त दे सकता है, चाहे आप एक यात्रा विश्लेषक हों, डेवलपर हों या केवल सबसे अच्छी हवाई किराए की तलाश में हों। हालाँकि, Kayak के एंटी-स्क्रैपिंग उपाय डेटा को सीधे निकालना मुश्किल बनाते हैं।

इस गाइड में, हम आपको सही उपकरणों और तकनीकों का उपयोग करके Kayak से उड़ान डेटा को स्क्रैप करना सिखाएंगे—बिना ब्लॉक किए। अपने स्क्रैपिंग परिवेश को स्थापित करने से लेकर गतिशील सामग्री को संभालने और प्रतिबंधों को दरकिनार करने तक, आप कुशलतापूर्वक सटीक उड़ान जानकारी एकत्र करने के लिए आवश्यक सब कुछ सीखेंगे। आएँ शुरू करें!

Kayak क्या है?

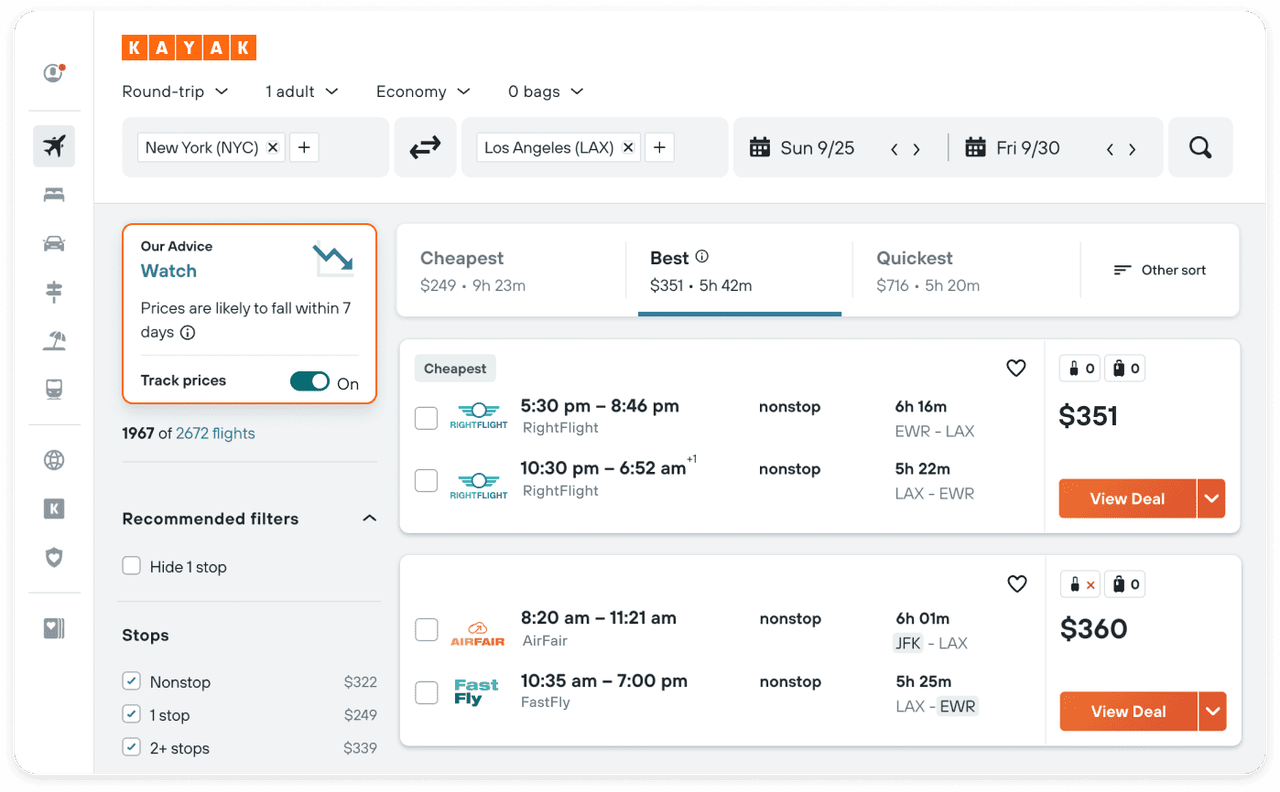

चित्र स्रोत: Kayak

2004 में लॉन्च किया गया, Kayak एक व्यापक रूप से उपयोग किया जाने वाला यात्रा खोज इंजन बन गया है, जो यात्रियों को उड़ानों, होटलों, कार किराए और छुट्टी पैकेजों पर सर्वोत्तम सौदे खोजने में मदद करता है। कई यात्रा साइटों से कीमतों को एकत्रित और तुलना करके, Kayak उपयोगकर्ताओं को सीधे प्रदाताओं के माध्यम से या अपने ही प्लेटफ़ॉर्म पर बुकिंग करने में सक्षम बनाता है।

उड़ान डेटा क्यों स्क्रैप करें?

उड़ान डेटा कई क्षेत्रों में अत्यधिक मूल्यवान है, जैसा कि निम्नलिखित है:

- यात्रा नियोजन: सटीक और वास्तविक समय की उड़ान जानकारी प्लेटफ़ॉर्म को उपयोगकर्ताओं को नवीनतम यात्रा जानकारी प्रदान करने में मदद कर सकती है, ताकि उपयोगकर्ता अपनी यात्राओं को सबसे उपयुक्त समय पर बुक कर सकें।

- मूल्य निगरानी: लंबे समय तक उड़ान की कीमतों पर नज़र रखने से, कंपनियां मूल्य में उतार-चढ़ाव के रुझानों की पहचान कर सकती हैं और यात्रियों के लिए टिकट खरीदने का सबसे अच्छा समय भविष्यवाणी कर सकती हैं।

- बाजार विश्लेषण: ऐतिहासिक उड़ान डेटा उपभोक्ता मांग, लोकप्रिय यात्रा अवधियों और मूल्य निर्धारण रणनीतियों में बदलते रुझानों को प्रकट कर सकता है, जो पर्यटन उद्योग विश्लेषकों और बाजार शोधकर्ताओं के लिए मजबूत समर्थन प्रदान करता है।

क्या Kayak का डेटा स्क्रैप करना कानूनी है?

Kayak के डेटा के तकनीकी विवरणों में उतरने से पहले, कानूनी और नैतिक मुद्दों पर विचार करना महत्वपूर्ण है:

- प्लेटफ़ॉर्म नियमों का पालन करें: यह पुष्टि करने के लिए कि क्या डेटा स्क्रैपिंग की अनुमति है, Kayak की सेवा की शर्तों को ध्यान से पढ़ें।

- Robots.txt फ़ाइलों का पालन करें: यह समझने के लिए कि क्रॉलर के लिए किन पृष्ठों की अनुमति है या प्रतिबंधित है, Kayak की Robots.txt फ़ाइल देखें।

- सर्वर तनाव से बचें: Kayak के सर्वरों को अभिभूत करने से बचने के लिए क्रॉलिंग अनुरोधों की आवृत्ति को उचित रूप से नियंत्रित करें।

Kayak से उड़ान डेटा कैसे स्क्रैप करें?

इस खंड में, हम Kayak से उड़ान डेटा को स्क्रैप करने के प्रभावी तरीके पेश करेंगे, यह सुनिश्चित करते हुए कि आपको सबसे सटीक और अद्यतित जानकारी मिले।

1. जिन उपकरणों का हम उपयोग करेंगे उनका परिचय

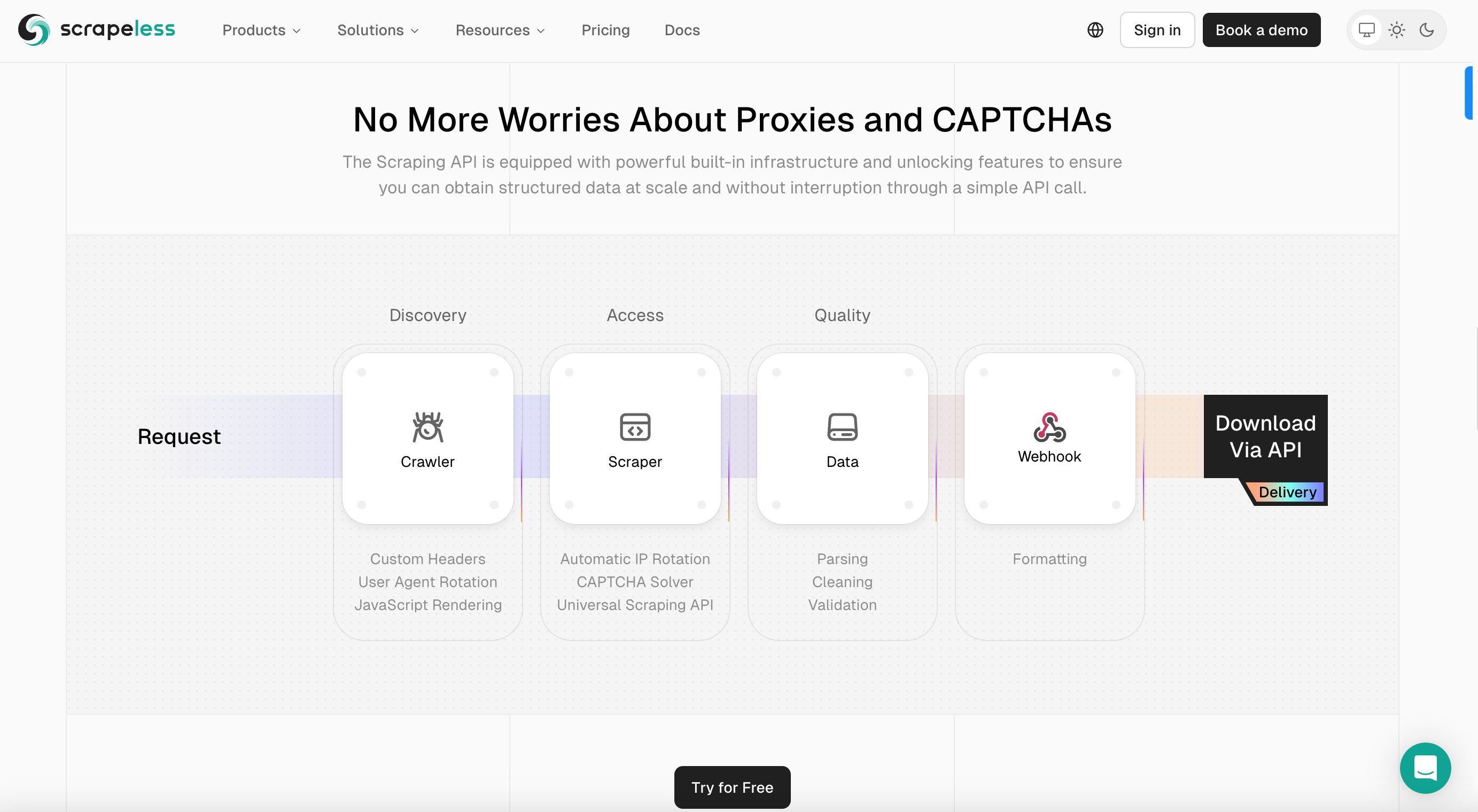

इस खंड में, हम Scrapeless का उपयोग करके Kayak उड़ान डेटा को आसानी से स्क्रैप करना कैसे सिखाएंगे। Scrapeless एक उन्नत वेब स्क्रैपिंग प्लेटफ़ॉर्म है जिसे निर्बाध और कुशल डेटा निष्कर्षण प्रदान करने के लिए डिज़ाइन किया गया है।

Scrapeless क्यों चुनें

- व्यापक प्रॉक्सी नेटवर्क: Scrapeless दुनिया भर में उच्च-गुणवत्ता वाले घूर्णन प्रॉक्सी का एक बड़ा और विविध नेटवर्क प्रदान करता है।

- व्यापक डेटा पहुँच: Scrapeless ई-कॉमर्स वेबसाइटों, खोज इंजनों, सोशल मीडिया आदि सहित विभिन्न प्रकार के डेटा स्रोतों तक पहुँच प्रदान करता है।

- वास्तविक समय डेटा संचरण: Scrapeless वास्तविक समय डेटा पुनर्प्राप्ति सुनिश्चित करता है, Kayak उड़ान जानकारी, बाजार अनुसंधान और प्रतिस्पर्धी विश्लेषण आदि को स्क्रैप करने के लिए समर्थन प्रदान करता है।

- अनुकूलन योग्य डेटा संग्रह: शक्तिशाली उपकरणों और API एकीकरण के साथ, Scrapeless उपयोगकर्ताओं को अपनी डेटा संग्रह प्रक्रिया को अनुकूलित करने की अनुमति देता है।

- अनुपालन और सुरक्षा: Scrapeless सभी कानूनी आवश्यकताओं के साथ डेटा गोपनीयता और अनुपालन को प्राथमिकता देता है।

2. सेटअप और तैयारी

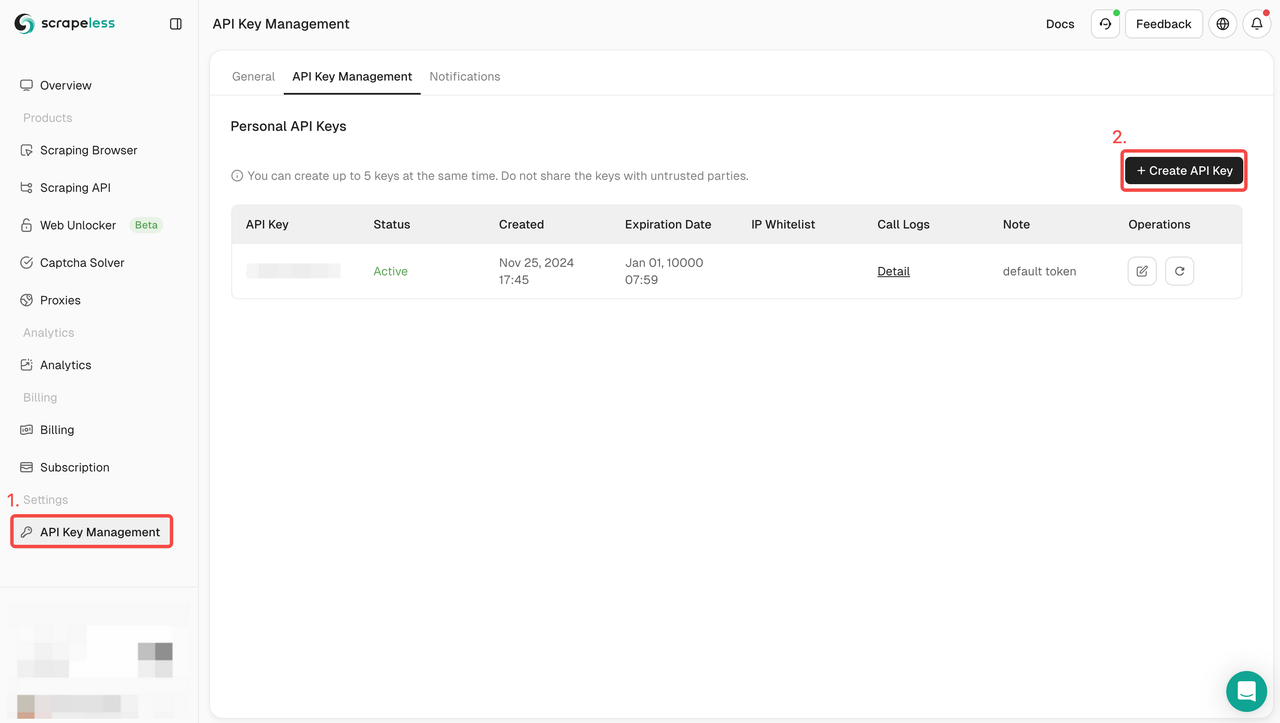

- Scrapeless पर मुफ्त में साइन अप करने के बाद, आपके पास खोज करने के लिए $2 मुफ़्त हैं।

- API कुंजी प्रबंधन पर जाएँ। फिर एक अद्वितीय API कुंजी उत्पन्न करने के लिए बनाएँ पर क्लिक करें। एक बार बनाए जाने के बाद, इसे कॉपी करने के लिए AP पर क्लिक करें।

3. क्रॉलिंग कोड लिखें

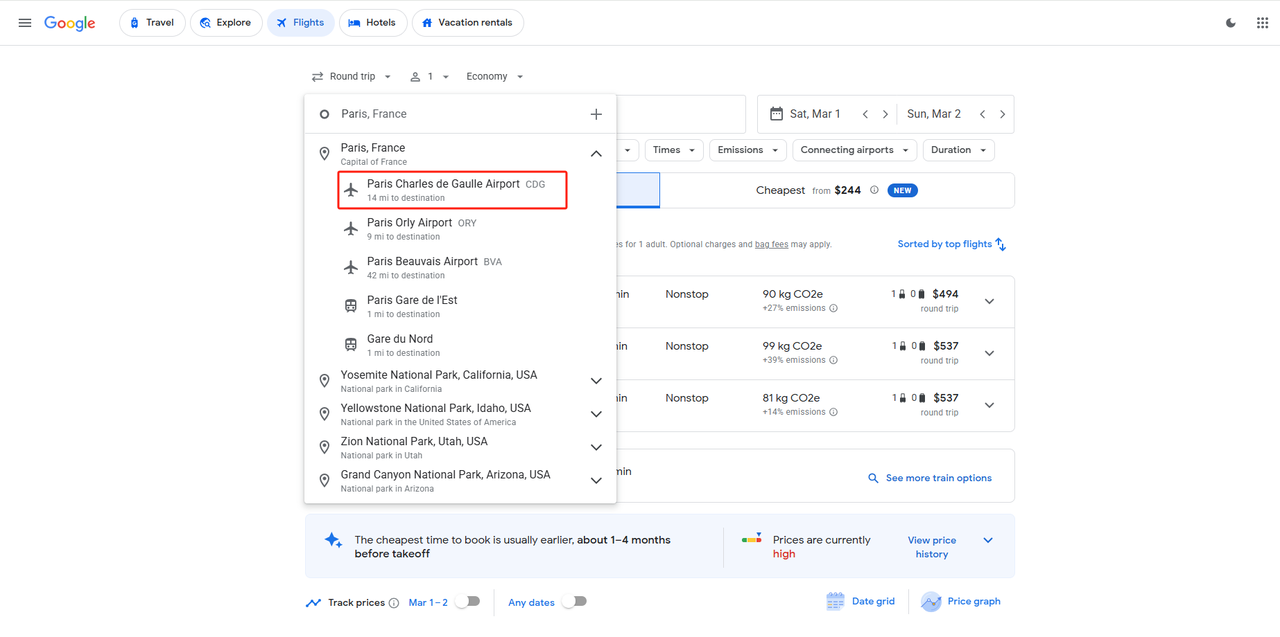

मान लीजिए कि हम 1 मार्च, 2025 को पेरिस चार्ल्स डी गॉल एयरपोर्ट से बर्लिन ब्रैंडेनबर्ग एयरपोर्ट पहुँचना चाहते हैं और 4 मार्च, 2025 को वापस आना चाहते हैं। एक बार जब हमारे पास प्रस्थान बिंदु, गंतव्य, प्रस्थान तिथि और वापसी तिथि हो जाती है, तो हम एक पूर्ण पैरामीटर संरचना बना सकते हैं:

input_data = {

"departure_id": "CDG",

"arrival_id": "BER",

"data_type": 1,

"outbound_date": "2025-03-01",

"return_date": "2025-03-04"

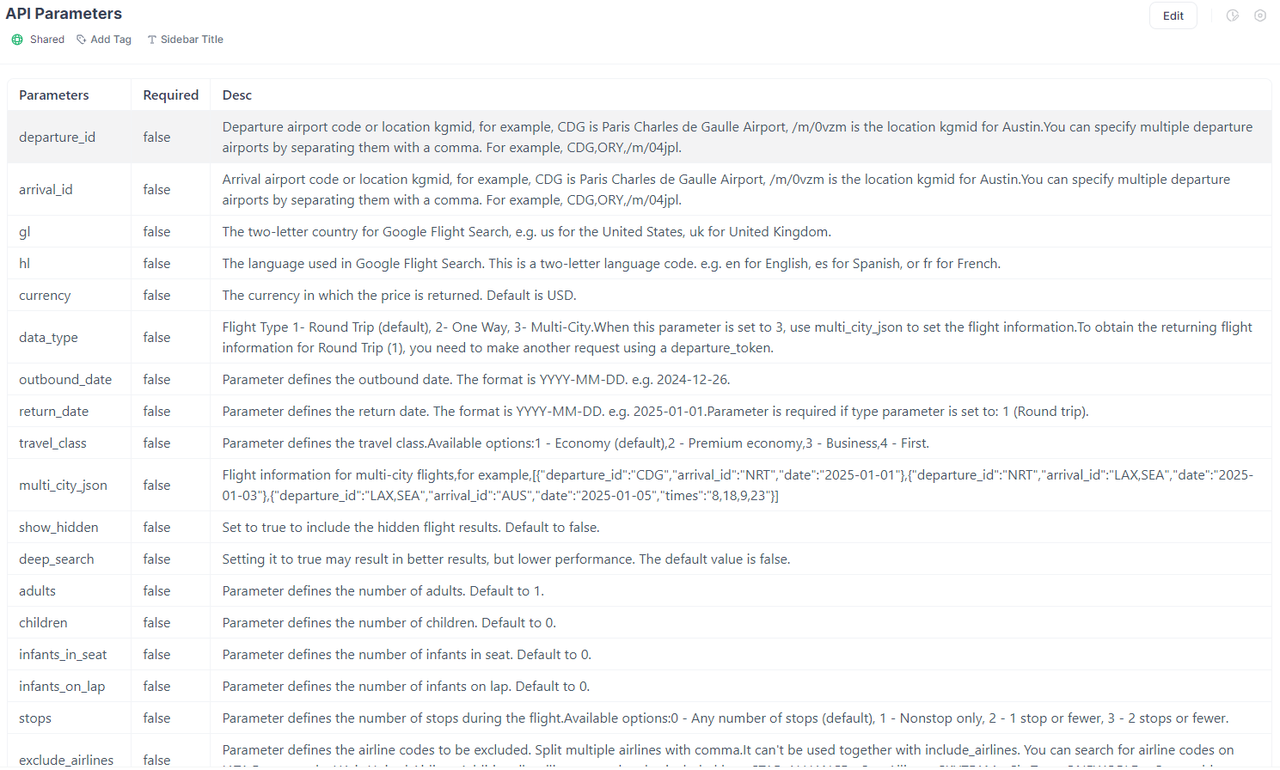

}पैरामीटर विवरण:

departure_id और arrival_id भरे गए हवाई अड्डों के अनुरूप हवाई अड्डे के कोड हैं, जो अंतर्राष्ट्रीय हवाई परिवहन संघ द्वारा निर्धारित किए गए हैं।यदि आप संबंधित हवाई अड्डे का कोड नहीं जानते हैं, तो आप इसे प्रस्थान और गंतव्य में प्राप्त करने के लिए सीधे Google Flights तक पहुँच सकते हैं।

data_type हमारे प्रस्थान प्रकार का प्रतिनिधित्व करता है, 1 राउंड ट्रिप का प्रतिनिधित्व करता है।

पैरामीटर बनने के बाद, हम पूर्ण कोड को असेंबल कर सकते हैं, जहाँ आपको अपनी Scrapeless API कुंजी के साथ your_token को बदलने की भी आवश्यकता है:

import json

import requests

class Payload:

def __init__(self, actor, input_data):

self.actor = actor

self.input = input_data

def send_request():

host = "api.scrapeless.com"

url = f"https://{host}/api/v1/scraper/request"

token = "your_token"

headers = {

"x-api-token": token

}

input_data = {

"departure_id": "CDG",

"arrival_id": "BER",

"data_type": 1,

"outbound_date": "2025-03-01",

"return_date": "2025-03-04"

}

payload = Payload("scraper.google.flights", input_data)

json_payload = json.dumps(payload.__dict__)

response = requests.post(url, headers=headers, data=json_payload)

if response.status_code != 200:

print("Error:", response.status_code, response.text)

return

print("body", response.text)

if __name__ == "__main__":

send_request()बेशक, हमारे पैरामीटर उससे कहीं अधिक हैं। हम आपको Google Flights के अन्य पैरामीटर भी प्रदान कर सकते हैं, जैसे कि यात्रियों की संख्या, स्टॉप की संख्या, अधिकतम मूल्य, आदि। विवरण के लिए, आप हमारे Scrapeless API आधिकारिक वेबसाइट दस्तावेज़ का उल्लेख कर सकते हैं।

हम Scrapeless Google Flights API से बहुत सारे डेटा प्राप्त कर सकते हैं, जैसे:

- प्रस्थान और आगमन का समय

- हवाई अड्डे की जानकारी

- उड़ान की अवधि

- कार्बन उत्सर्जन की जानकारी

- कीमत

- स्टॉपओवर जानकारी

- एयरलाइन की जानकारी

- और भी बहुत कुछ।

4. CSV में निर्यात कैसे करें

यदि आपको परिणामों को CSV में निर्यात करने की आवश्यकता है, तो बस निम्नलिखित कोड जोड़ें।

result = response.json()

best_flights = result['best_flights']

with open('flights-maps-results.csv', 'w', newline='') as csvfile:

csv_writer = csv.writer(csvfile)

# Write the headers

csv_writer.writerow(["departure_time", "arrival_time", "flight_number", "price"])

# Write the data

for best_flight in best_flights:

flights = best_flight['flights']

for flight in flights:

departure_airport = flight['departure_airport']

arrival_airport = flight['arrival_airport']

csv_writer.writerow(

[departure_airport["time"], arrival_airport["time"], flight["flight_number"], best_flight["price"]])

print('Done writing to CSV file.')5. Scrapeless आपके लिए और कौन सा डेटा क्रॉल कर सकता है?

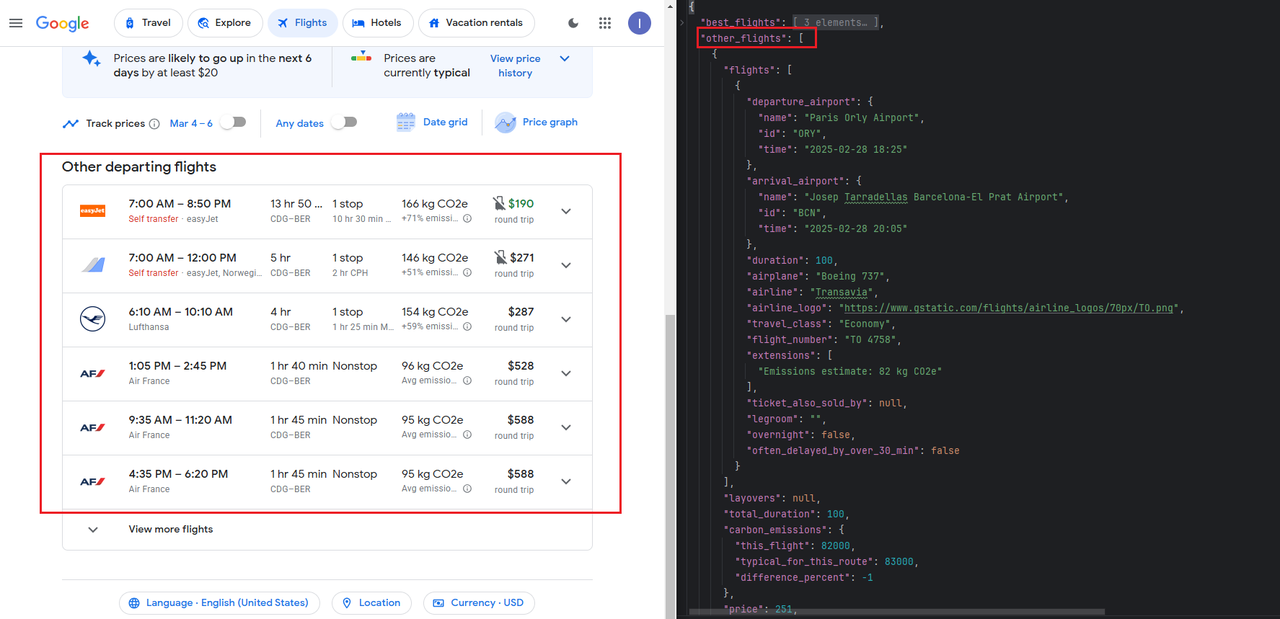

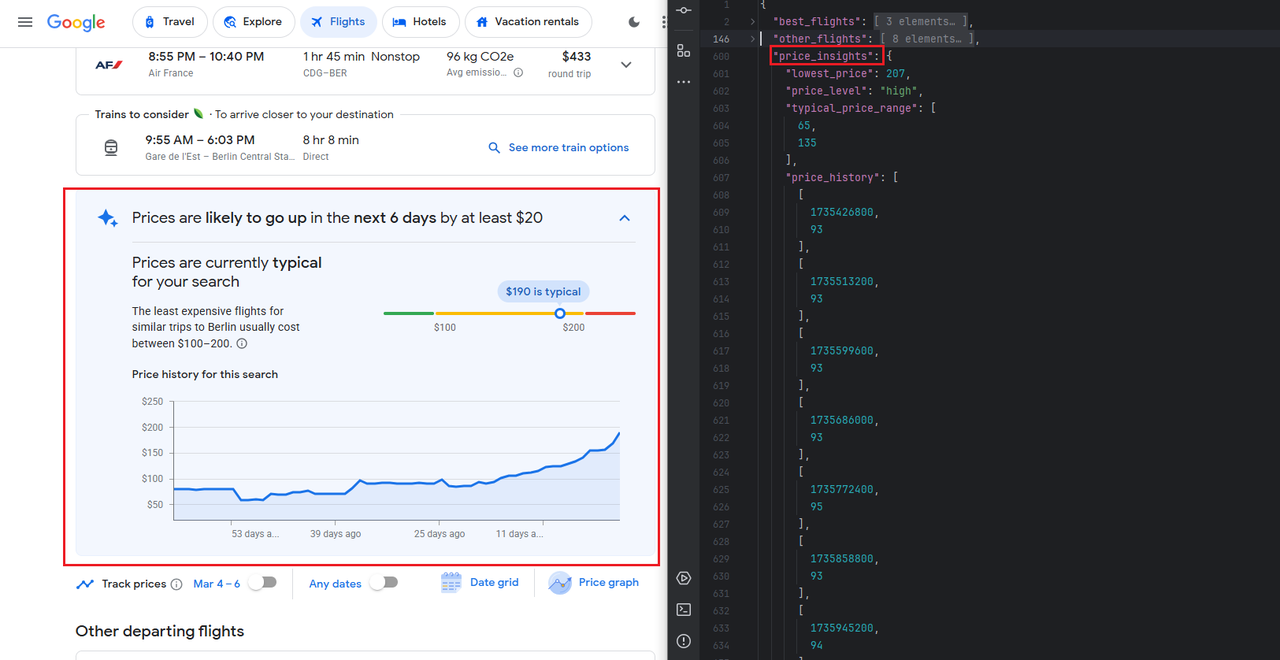

Scrapeless आपको विभिन्न प्रकार के क्रॉलिंग परिदृश्यों के साथ प्रदान करता है, जिसमें ऊपर दिखाई गई Kayak उड़ान का समय और मूल्य जानकारी शामिल है। Scrapeless 'अन्य प्रस्थान उड़ानें, ऐतिहासिक मूल्य रुझान आदि जैसी जानकारी भी प्रदान करता है। आपको केवल अलग-अलग पैरामीटर बनाने की आवश्यकता है:

अन्य प्रस्थान उड़ानें

ऐतिहासिक मूल्य रुझान

इसके अतिरिक्त, Scrapeless निम्नलिखित डेटा इंटरफेस भी प्रदान करता है:

- Google मानचित्र

- Google नौकरियां

- Google रुझान

- Google होटल

...

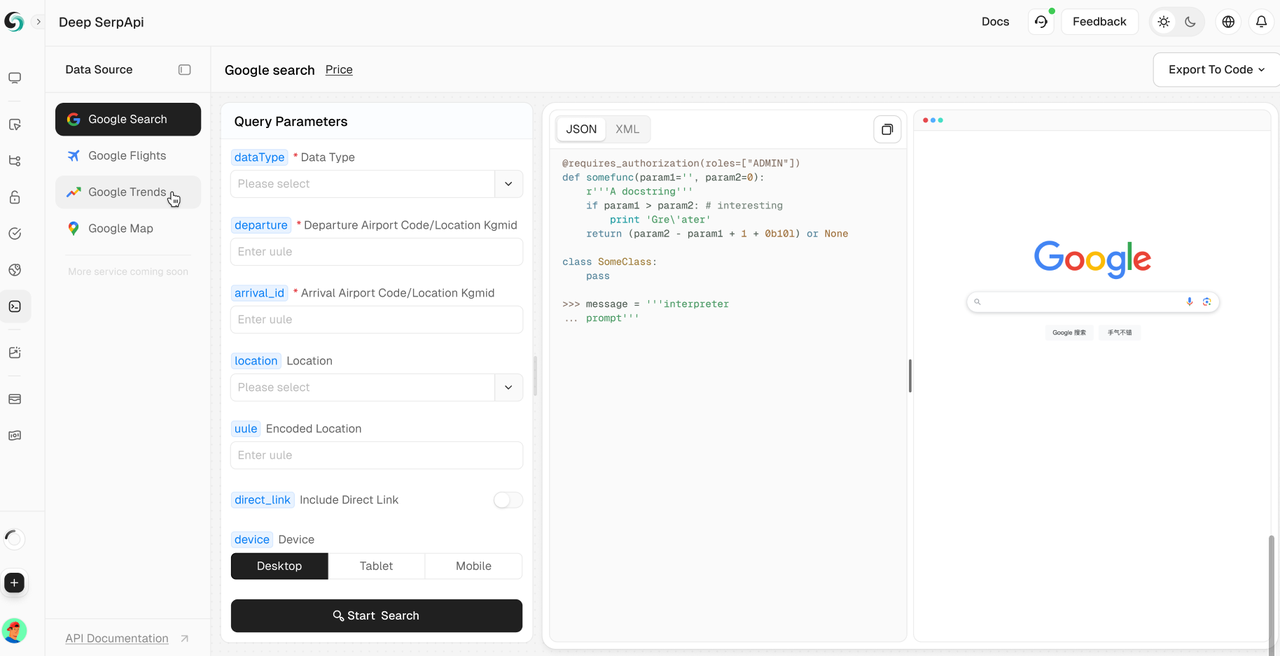

अन्य उपकरण अनुशंसाएँ: Scrapeless Deep SerpApi

Deep SerpApi बड़े भाषा मॉडल (LLM) और AI एजेंटों के लिए डिज़ाइन किया गया एक समर्पित खोज इंजन है, जिसका उद्देश्य AI अनुप्रयोगों को डेटा को कुशलतापूर्वक पुनः प्राप्त करने और संसाधित करने में मदद करने के लिए वास्तविक समय, सटीक और निष्पक्ष जानकारी प्रदान करना है।

मुख्य विशेषताएँ:

- व्यापक डेटा कवरेज और उच्च-मूल्य क्रॉलिंग: अंतर्निहित 20+ Google खोज API परिदृश्य इंटरफेस, मुख्यधारा के खोज इंजनों से डेटा तक पहुँच।

- वास्तविक समय डेटा अद्यतन: नवीनतम जानकारी सुनिश्चित करने के लिए पिछले 24 घंटों के लिए ऐतिहासिक डेटा अद्यतन का समर्थन करता है।

- लागत प्रभावी: Deep SerpApi प्रति हज़ार क्वेरी $0.10 से मूल्य निर्धारण प्रदान करता है, जिसमें 1-2 सेकंड का प्रतिक्रिया समय होता है, जिससे डेवलपर्स और उद्यम कुशलतापूर्वक और कम लागत पर डेटा प्राप्त कर सकते हैं।

- उन्नत डेटा एकीकरण क्षमताएँ: सभी उपलब्ध ऑनलाइन चैनलों और खोज इंजनों से जानकारी को एकीकृत कर सकता है।

🎺🎺रोमांचक घोषणा!

डेवलपर सहायता कार्यक्रम: अपने AI उपकरणों, अनुप्रयोगों या परियोजनाओं में Scrapeless Deep SerpApi को एकीकृत करें। [हम पहले से ही Dify का समर्थन करते हैं, और जल्द ही Langchain, Langflow, FlowiseAI और अन्य ढाँचों का समर्थन करेंगे]। फिर अपने परिणाम GitHub या सोशल मीडिया पर साझा करें, और आपको प्रति माह $500 तक, 1-12 महीने तक मुफ्त डेवलपर सहायता मिलेगी।

अतिरिक्त संसाधन

यदि आप अन्य Google स्क्रैपिंग तकनीकों में रुचि रखते हैं, तो आप निम्नलिखित विस्तृत लेख पढ़ सकते हैं:

- Google Scholar परिणामों को कैसे स्क्रैप करें

- Google जॉब परिणामों को कैसे स्क्रैप करें

- Google मानचित्र परिणामों को कैसे स्क्रैप करें

निष्कर्ष

निष्कर्ष में, Kayak से उड़ान डेटा को स्क्रैप करने से यात्रियों और व्यवसायों के लिए मूल्यवान अंतर्दृष्टि मिलती है। सही उपकरणों और नैतिक प्रथाओं का उपयोग करके, आप आसानी से वास्तविक समय डेटा एकत्र कर सकते हैं।

इसमें गोता लगाने के लिए तैयार हैं? अधिक सुझावों और सलाह के लिए हमारे Discord समुदाय में शामिल हों।

स्क्रैपलेस में, हम केवल सार्वजनिक रूप से उपलब्ध डेटा का उपयोग करते हैं, जबकि लागू कानूनों, विनियमों और वेबसाइट गोपनीयता नीतियों का सख्ती से अनुपालन करते हैं। इस ब्लॉग में सामग्री केवल प्रदर्शन उद्देश्यों के लिए है और इसमें कोई अवैध या उल्लंघन करने वाली गतिविधियों को शामिल नहीं किया गया है। हम इस ब्लॉग या तृतीय-पक्ष लिंक से जानकारी के उपयोग के लिए सभी देयता को कोई गारंटी नहीं देते हैं और सभी देयता का खुलासा करते हैं। किसी भी स्क्रैपिंग गतिविधियों में संलग्न होने से पहले, अपने कानूनी सलाहकार से परामर्श करें और लक्ष्य वेबसाइट की सेवा की शर्तों की समीक्षा करें या आवश्यक अनुमतियाँ प्राप्त करें।