डायनामिक कंटेंट को BeautifulSoup के साथ कैसे संभालें? अंतिम गाइड 2025

Expert Network Defense Engineer

मुख्य निष्कर्ष:

- ब्यूटीफुलसूप स्थैतिक एचटीएमएल के लिए है; यह JavaScript को निष्पादित नहीं कर सकता है ताकि गतिशील सामग्री को प्रस्तुत किया जा सके।

- गतिशील सामग्री को स्क्रैप करने के लिए, ब्यूटीफुलसूप को ब्राउज़र स्वचालन उपकरण (सेलेनियम, प्ले राइट) या विशिष्ट एपीआई के साथ मिलाएं।

- ब्राउज़र स्वचालन पृष्ठ को प्रस्तुत करता है, जिससे ब्यूटीफुलसूप पूर्ण एचटीएमएल को पार्स कर सकता है।

- जब गतिशील सामग्री ज्ञात एपीआई एंडपॉइंट्स से उत्पन्न होती है तो सीधे एपीआई को क्वेरी करना अत्यधिक प्रभावी होता है।

- विशिष्ट वेब स्क्रैपिंग एपीआई जटिल, JavaScript-चालित साइटों के लिए एक सुव्यवस्थित समाधान प्रदान करते हैं।

परिचय

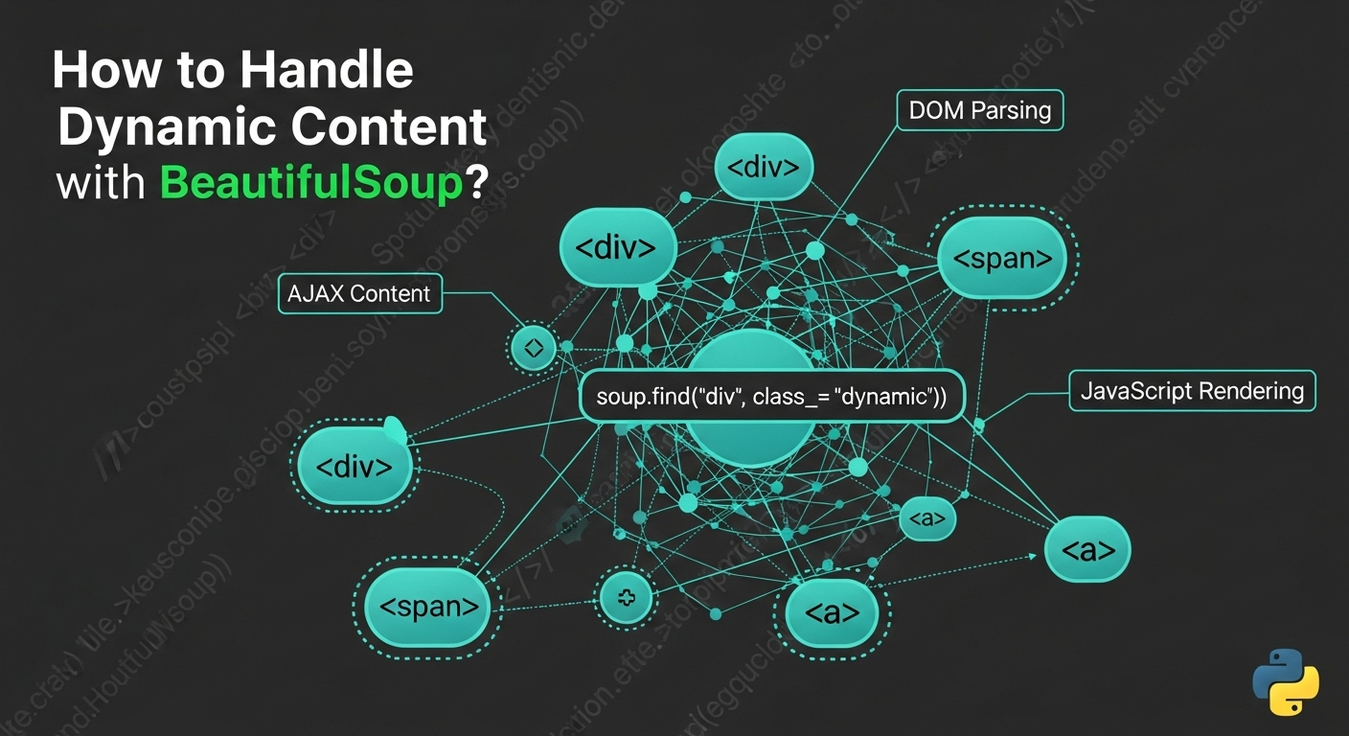

वेब स्क्रैपिंग अक्सर एक चुनौती का सामना करता है: गतिशील सामग्री। आधुनिक वेबसाइटें डेटा लोड करने और तत्वों को असिंक्रोनस तरीके से प्रस्तुत करने के लिए JavaScript का उपयोग करती हैं, जिससे ब्यूटीफुलसूप अकेले सामग्री को अदृश्य बनाता है। जबकि ब्यूटीफुलसूप स्थैतिक एचटीएमएल को पार्स करने में उत्कृष्ट है, यह JavaScript को निष्पादित नहीं कर सकता है। इस गाइड में ब्यूटीफुलसूप का उपयोग करते समय गतिशील सामग्री को संभालने के प्रभावी तरीकों का अन्वेषण किया जाएगा, जो JavaScript-चालित वेबसाइटों से डेटा निकालने के लिए व्यावहारिक उदाहरण और सर्वश्रेष्ठ प्रथाएँ प्रदान करता है।

गतिशील सामग्री और ब्यूटीफुलसूप की सीमाओं को समझना

गतिशील सामग्री से तात्पर्य है वेब पृष्ठ तत्व जो प्रारंभिक एचटीएमएल के बाद लोड या उत्पन्न होते हैं, आमतौर पर JavaScript के माध्यम से। उदाहरणों में AJAX कॉल, क्लाइंट-साइड रेंडरिंग (रीएक्ट, एंगुलर) और वेबसॉकेट शामिल हैं। ब्यूटीफुलसूप एक स्थैतिक पार्सर है; यह केवल उस एचटीएमएल को प्रोसेस करता है जो इसे प्राप्त होता है, जिसमें JavaScript इंजन या रेंडरिंग क्षमताएं नहीं होती हैं। इसलिए, यह प्रारंभिक पृष्ठ लोड के बाद JavaScript द्वारा उत्पन्न सामग्री तक पहुँच नहीं सकता है। इसे पार करने के लिए, ब्यूटीफुलसूप को उन उपकरणों के साथ जोड़ा जाना चाहिए जो ब्राउज़र वातावरण का अनुकरण करते हैं।

समाधान 1: ब्यूटीफुलसूप को सेलेनियम के साथ मिलाना

सेलेनियम वेब ब्राउज़रों का स्वचालन करता है, JavaScript को निष्पादित करता है और वेब तत्वों के साथ इंटरैक्ट करता है। इसका उपयोग पृष्ठ को लोड करने, गतिशील सामग्री को प्रस्तुत करने की अनुमति देने के लिए करें, फिर ब्यूटीफुलसूप को पार्स करने के लिए पूर्ण एचटीएमएल निकालें।

यह कैसे काम करता है:

सेलेनियम एक ब्राउज़र लॉन्च करता है, URL पर नेविगेट करता है, JavaScript के निष्पादित होने की प्रतीक्षा करता है, पूरा एचटीएमएल स्रोत पुनः प्राप्त करता है, और फिर इसे ब्यूटीफुलसूप को देता है।

स्थापना:

bash

pip install selenium beautifulsoup4 webdriver_managerपायथन कोड उदाहरण (स्निपेट):

python

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

from webdriver_manager.chrome import ChromeDriverManager

from bs4 import BeautifulSoup

import time

def scrape_dynamic_content_selenium(url):

options = webdriver.ChromeOptions()

options.add_argument('--headless')

driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()), options=options)

driver.get(url)

time.sleep(5) # देरी समायोजित करें

html_content = driver.page_source

soup = BeautifulSoup(html_content, 'html.parser')

# ... सूप के साथ डेटा निकालें ...

driver.quit()फायदे और नुकसान:

- फायदे: पूरा JavaScript निष्पादन, ब्राउज़र इंटरैक्शन, व्यापक रूप से अपनाया गया।

- नुकसान: संसाधन-गहन, धीमा, जटिल सेटअप, एंटी-बॉट पहचान के लिए प्रवीण [1]।

समाधान 2: ब्यूटीफुलसूप को प्ले राइट के साथ मिलाना

प्ले राइट Chromium, Firefox और WebKit ब्राउज़र को नियंत्रित करने के लिए एक आधुनिक लाइब्रेरी है। यह मजबूत प्रतीक्षा तंत्र प्रदान करता है और गतिशील सामग्री के लिए सेलेनियम की तुलना में अक्सर अधिक प्रदर्शनकारी होता है।

यह कैसे काम करता है:

प्ले राइट एक ब्राउज़र लॉन्च करता है, URL पर नेविगेट करता है, सामग्री लोड होने की प्रतीक्षा करता है, पूरा एचटीएमएल पुनः प्राप्त करता है, और फिर इसे ब्यूटीफुलसूप को देता है।

स्थापना:

bash

pip install playwright beautifulsoup4

playwright installपायथन कोड उदाहरण (स्निपेट):

python

from playwright.sync_api import sync_playwright

from bs4 import BeautifulSoup

def scrape_dynamic_content_playwright(url):

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto(url, wait_until="networkidle")

html_content = page.content()

soup = BeautifulSoup(html_content, 'html.parser')

# ... सूप के साथ डेटा निकालें ...

browser.close()फायदे और नुकसान:

- फायदे: मल्टी-ब्राउज़र समर्थन, आधुनिक एपीआई, तेज, स्वचालित प्रतीक्षा।

- नुकसान: संसाधन-गहन, ब्राउज़र बाइनरी की आवश्यकता, एंटी-बॉट सिस्टम द्वारा पहचान की जा सकती है [2]।

समाधान 3: ब्यूटीफुलसूप को Requests-HTML के साथ मिलाना

requests-html requests को एक हेडलेस क्रोमियम उदाहरण का उपयोग करके JavaScript को प्रस्तुत करने के लिए विस्तारित करता है, जटिल सामग्री को पूर्ण ब्राउज़र स्वचालन के बिना संभालने का एक सरल तरीका प्रदान करता है।

यह कैसे काम करता है:

requests-html प्रारंभिक एचटीएमएल को प्राप्त करता है, पृष्ठभूमि में JavaScript को प्रस्तुत करता है, और फिर ब्यूटीफुलसूप पार्सिंग के लिए प्रोसेस की गई एचटीएमएल प्रदान करता है।

स्थापना:

bash

pip install requests-html beautifulsoup4पायथन कोड उदाहरण (स्निपेट):

python

from requests_html import HTMLSession

from bs4 import BeautifulSoup

def scrape_dynamic_content_requests_html(url):

session = HTMLSession()

r = session.get(url)

r.html.render(sleep=3, keep_page=False)

html_content = r.html.html

soup = BeautifulSoup(html_content, 'html.parser')

# ... सूप के साथ डेटा निकालें ...फायदे और नुकसान:

- फायदे: सरल API, एकीकृत अनुरोध और रेंडरिंग, संभवतः हल्का।

- नुकसान: जटिल JS/एंटी-बॉट के लिए कम robust, Chromium निर्भरता, कई पृष्ठों के लिए धीमा हो सकता है।

समाधान 4: BeautifulSoup को Splash के साथ संयोजित करना

Splash एक स्क्रिप्टेबल हेडलेस ब्राउज़र है जो सर्वर पर चलता है, नियंत्रित जावास्क्रिप्ट रेंडरिंग के लिए आदर्श, विशेषकर Scrapy के साथ।

यह कैसे काम करता है:

आपका स्क्रिप्ट Splash सर्वर को अनुरोध भेजता है, जो पृष्ठ को रेंडर करता है और BeautifulSoup को पार्स करने के लिए पूरा HTML लौटाता है।

स्थापना:

Splash चलाने के लिए Docker की आवश्यकता है:

bash

docker run -p 8050:8050 scrapinghub/splashपायथन कोड उदाहरण (निष्पादन):

python

import requests

from bs4 import BeautifulSoup

def scrape_dynamic_content_splash(url, splash_url="http://localhost:8050"):

payload = {

"url": url,

"wait": 2,

"html": 1

}

response = requests.get(f"{splash_url}/render.html", params=payload)

html_content = response.text

soup = BeautifulSoup(html_content, 'html.parser')

# ... डेटा को soup के साथ निकालें ...फायदे और नुकसान:

- फायदे: एकाकी वातावरण, स्क्रिप्टेबल, Scrapy एकीकरण के लिए अच्छा।

- नुकसान: जटिल सेटअप (Docker), प्रदर्शन ओवरहेड, संसाधन-गहन।

समाधान 5: सीधा APIs का क्वेरी करना (जब उपलब्ध हो)

अक्सर, गतिशील सामग्री AJAX अनुरोधों के माध्यम से बैकएंड API के जरिए लोड की जाती है। इन APIs को सीधा क्वेरी करना ब्राउज़र रेंडरिंग से अधिक प्रभावी हो सकता है।

यह कैसे काम करता है:

ब्राउज़र विकास उपकरण में नेटवर्क ट्रैफ़िक की जांच करें ताकि API अंतिम बिंदुओं को खोजा जा सके। Python की requests लाइब्रेरी का उपयोग करके अनुरोध (पद्धति, हेडर, पेआउट) को अनुकरण करें। JSON/XML प्रतिक्रिया को पार्स करें। वैकल्पिक रूप से, यदि API HTML स्निपेट लौटाता है तो BeautifulSoup का उपयोग करें।

स्थापना:

bash

pip install requests beautifulsoup4पायथन कोड उदाहरण (निष्पादन):

python

import requests

import json

from bs4 import BeautifulSoup

def scrape_dynamic_content_api(api_url, headers=None, params=None, data=None):

response = requests.get(api_url, headers=headers, params=params) # या requests.post

response.raise_for_status()

api_data = response.json()

# ... api_data को प्रोसेस करें ...

# यदि API HTML स्निपेट लौटाता है:

# soup = BeautifulSoup(api_data["html_content"], 'html.parser')

# ... soup के साथ पार्स करें ...फायदे और नुकसान:

- फायदे: तेजी, संसाधन-हल्का, लक्षित डेटा, एंटी-बॉट के प्रति कम संवेदनशील।

- नुकसान: API खोज की आवश्यकता, API परिवर्तनों के प्रति संवेदनशील, प्रमाणीकरण प्रबंधन, हमेशा उपलब्ध नहीं होता है।

समाधान 6: हेडलेस ब्राउज़र (स्वतंत्र)

पूर्ण स्वचालन फ्रेमवर्क के बिना हल्के रेंडरिंग के लिए, pyppeteer (Puppeteer का Python समकक्ष) जैसे हेडलेस ब्राउज़र आधुनिक जावास्क्रिप्ट-भारी पृष्ठों को रेंडर करने के लिए एक ब्राउज़र पर प्रोग्रामेटिक नियंत्रण प्रदान करते हैं।

यह कैसे काम करता है:

एक हेडलेस ब्राउज़र शुरू होता है, URL पर नेविगेट करता है, जावास्क्रिप्ट निष्पादित करता है, पूरा HTML निकालता है, जिसे फिर BeautifulSoup को पार्स करने के लिए सौंपा जाता है।

स्थापना (pyppeteer के लिए):

bash

pip install pyppeteer beautifulsoup4पायथन कोड उदाहरण (निष्पादन):

python

import asyncio

from pyppeteer import launch

from bs4 import BeautifulSoup

async def scrape_dynamic_content_pyppeteer(url):

browser = await launch(headless=True)

page = await browser.newPage()

await page.goto(url, waitUntil="networkidle0")

html_content = await page.content()

soup = BeautifulSoup(html_content, 'html.parser')

# ... डेटा को soup के साथ निकालें ...

await browser.close()फायदे और नुकसान:

- फायदे: हल्का रेंडरिंग, आधुनिक जावास्क्रिप्ट समर्थन, बारीकी से नियंत्रण।

- नुकसान:

asyncioकी आवश्यकता, संसाधन खपत, Chromium सेटअप।

समाधान 7: वेब स्क्रेपिंग APIs का उपयोग करना (विशेषीकृत सेवाएँ)

जटिल परिदृश्यों के लिए, विशेषीकृत वेब स्क्रेपिंग APIs ब्राउज़र रेंडरिंग, जावास्क्रिप्ट निष्पादन, IP घुमाव, और एंटी-बॉट बचाव को संभालते हैं, पूर्ण रूप से रेंडर किए गए HTML या संरचित डेटा लौटाते हैं।

यह कैसे काम करता है:

आपका स्क्रिप्ट API को लक्षित URL के साथ एक साधारण HTTP अनुरोध भेजता है। API सभी रेंडरिंग और एंटी-बॉट उपायों को संभालता है, फिर BeautifulSoup को पार्स करने के लिए साफ HTML लौटाता है।

स्थापना:

bash

pip install requests beautifulsoup4पायथन कोड उदाहरण (निष्पादन):

python

import requests

from bs4 import BeautifulSoup

import json

def scrape_dynamic_content_api_service(target_url, api_key, api_endpoint="https://api.scrapeless.com/v1/scrape"):

payload = {

"url": target_url,

"api_key": api_key,

"render_js": True,

}

headers = {"Content-Type": "application/json"}

response = requests.post(api_endpoint, headers=headers, data=json.dumps(payload))

response.raise_for_status()

response_data = response.json()

html_content = response_data.get("html")

if html_content:

soup = BeautifulSoup(html_content, "html.parser")

# ... डेटा को soup के साथ निकालें ...- फायदे: सरलता, उच्च सफलता दर, स्केलेबिलिटी, दक्षता, डेटा पर ध्यान केंद्रित करना।

- नुकसान: भुगतान सेवा, बाहरी निर्भरता, कम नियंत्रण।

समाधान 8: Scrapy के साथ एकीकृत करना

Scrapy एक उच्च-स्तरीय वेब स्क्रैपिंग ढांचा है। जबकि यह स्वाभाविक रूप से जावास्क्रिप्ट निष्पादित नहीं करता, यह मध्यवर्ती सॉफ़्टवेयर के माध्यम से Splash या Selenium/Playwright जैसे उपकरणों के साथ एकीकृत हो सकता है ताकि गतिशील सामग्री को संभाला जा सके, इसे बड़े पैमाने पर परियोजनाओं के लिए उपयुक्त बनाता है।

यह कैसे काम करता है:

Scrapy एक अनुरोध भेजता है, जिसे मध्यवर्ती सॉफ़्टवेयर द्वारा अवरोधित किया जाता है और जावास्क्रिप्ट रेंडरिंग सेवा को अग्रेषित किया जाता है। रेंडर की गई HTML Scrapy को वापस की जाती है, जिसे फिर BeautifulSoup या Scrapy के अपने चयनकर्ताओं द्वारा पार्स किया जा सकता है।

स्थापना:

bash

pip install scrapy beautifulsoup4

# Splash एकीकरण के लिए: pip install scrapy-splash और Docker कंटेनर चलाएँफायदे और नुकसान:

- फायदे: स्केलेबिलिटी, मजबूती, लचीलापन, बड़े पैमाने पर परियोजनाओं के लिए अच्छा।

- नुकसान: तेज सीखने की अवस्था, सरल कार्यों के लिए ओवरहेड, जावास्क्रिप्ट रेंडरिंग के लिए बाहरी सेवा की आवश्यकता।

समाधान 9: सरल जावास्क्रिप्ट रेंडरिंग के लिए requests_html का उपयोग करना

requests_html जावास्क्रिप्ट को रेंडर करने के लिए requests को हेडलेस क्रोमियम के साथ जोड़ता है, जो पूर्ण ब्राउज़र ऑटोमेशन की तुलना में एक सरल दृष्टिकोण प्रदान करता है।

यह कैसे काम करता है:

यह कच्ची HTML लाता है, फिर हेडलेस ब्राउज़र में जावास्क्रिप्ट को रेंडर करता है, BeautifulSoup पार्सिंग के लिए पूरी तरह से रेंडर की गई HTML प्रदान करता है।

स्थापना:

bash

pip install requests-html beautifulsoup4पायथन कोड उदाहरण (स्निपेट):

python

from requests_html import HTMLSession

from bs4 import BeautifulSoup

def scrape_dynamic_content_requests_html_simple(url):

session = HTMLSession()

r = session.get(url)

r.html.render(sleep=2, keep_page=False)

html_content = r.html.html

soup = BeautifulSoup(html_content, 'html.parser')

# ... soup के साथ डेटा निकालें ...

session.close()फायदे और नुकसान:

- फायदे: सरलता, एकीकृत अनुरोध/रेंडरिंग, संभावित रूप से संसाधन-कुशल।

- नुकसान: जटिल JS/एंटी-बॉट के लिए कम मजबूत, क्रोमियम निर्भरता, धीमा हो सकता है।

समाधान 10: अंतर्निहित जावास्क्रिप्ट रेंडरिंग के साथ एक प्रॉक्सी सेवा का उपयोग करना

उन्नत प्रॉक्सी सेवाएँ अंतर्निहित जावास्क्रिप्ट रेंडरिंग प्रदान करती हैं, जो प्रॉक्सी, CAPTCHA और एंटी-बॉट उपायों को संभालने के दौरान पूरी तरह से रेंडर की गई HTML लौटाने के लिए मध्यस्थ के रूप में कार्य करती हैं।

यह कैसे काम करता है:

आपकी स्क्रिप्ट प्रॉक्सी सेवा को एक अनुरोध भेजती है, जो जावास्क्रिप्ट के साथ पृष्ठ को रेंडर करती है और BeautifulSoup पार्सिंग के लिए पूरी HTML लौटाती है।

स्थापना:

bash

pip install requests beautifulsoup4पायथन कोड उदाहरण (स्निपेट):

python

import requests

from bs4 import BeautifulSoup

import json

def scrape_dynamic_content_proxy_service(target_url, proxy_api_key, proxy_endpoint="https://api.someproxyservice.com/render"):

payload = {

"url": target_url,

"api_key": proxy_api_key,

"render_js": True,

}

headers = {"Content-Type": "application/json"}

response = requests.post(proxy_endpoint, headers=headers, data=json.dumps(payload))

response.raise_for_status()

response_data = response.json()

html_content = response_data.get("html")

if html_content:

soup = BeautifulSoup(html_content, "html.parser")

# ... soup के साथ डेटा निकालें ...फायदे और नुकसान:

- फायदे: सरलित बुनियादी ढांचा, एकीकृत समाधान (JS रेंडरिंग, एंटी-बॉट), स्केलेबिलिटी, उपयोग में सरलता।

- नुकसान: भुगतान सेवा, बाहरी निर्भरता, कम नियंत्रण।

तुलना सारांश: BeautifulSoup के साथ गतिशील सामग्री के समाधान

| समाधान | जटिलता (सेटअप/रखरखाव) | लागत (सामान्य) | प्रदर्शन | मजबूती (एंटी-बॉट) | सर्वश्रेष्ठ के लिए |

|---|---|---|---|---|---|

| 1. BeautifulSoup + Selenium | मध्यम से उच्च | कम (फ्री) | मध्यम | कम से मध्यम | जटिल इंटरैक्शन, परीक्षण, छोटे से मध्यम पैमाने की स्क्रैपिंग |

| 2. BeautifulSoup + Playwright | मध्यम | कम (फ्री) | अच्छा | कम से मध्यम | आधुनिक वेब ऐप, मल्टी-ब्राउज़र परीक्षण, छोटे से मध्यम पैमाने की स्क्रैपिंग |

| 3. BeautifulSoup + Requests-HTML | कम से मध्यम | कम (फ्री) | मध्यम | कम | सरल गतिशील पृष्ठ, त्वरित स्क्रिप्ट, कम जटिल JS रेंडरिंग |

| 4. BeautifulSoup + Splash | उच्च (Docker) | कम (फ्री) | मध्यम | मध्यम | Scrapy एकीकरण, अलग रेंडरिंग, जटिल JS, बड़े पैमाने पर परियोजनाएँ |

| 5. सीधे API को क्वेरी करना | कम (खोज) | कम (मुफ्त) | उच्च | उच्च (यदि API स्थिर है) | ज्ञात APIs से संरचित डेटा, उच्च गति, संसाधन-कुशल |

| 6. BeautifulSoup + हेडलेस ब्राउज़र (जैसे, Pyppeteer) | मध्यम | कम (मुफ्त) | अच्छा | कम से मध्यम | सरल JS रेंडरिंग, प्रोग्रामेटिक ब्राउज़र नियंत्रण, पूरे ढांचे की तुलना में कम ओवरहेड |

| 7. BeautifulSoup + वेब स्क्रैपिंग APIs | कम | मध्यम से उच्च | बहुत उच्च | बहुत उच्च | बड़े पैमाने पर, जटिल साइटें, एंटी-बॉट बचाव, उच्च विश्वसनीयता |

| 8. Scrapy एकीकरण (Splash/Selenium के साथ) | बहुत उच्च | कम (मुफ्त) | उच्च | मध्यम से उच्च | उद्यम-स्तरीय, बड़े पैमाने पर क्रॉलिंग, मजबूत डेटा पाइपलाइन |

9. requests_html (स्वतंत्र) |

कम | कम (मुफ्त) | मध्यम | कम | त्वरित स्क्रिप्ट, बुनियादी JS रेंडरिंग, पाइथोनिक दृष्टिकोण |

| 10. JS रेंडरिंग के साथ प्रॉक्सी सेवा | कम | मध्यम से उच्च | उच्च | उच्च | बुनियादी ढांचे को लोड से हटाना, एंटी-बॉट, मध्यम से बड़े पैमाने पर स्क्रैपिंग |

Scrapeless आपके लिए सबसे अच्छा विकल्प क्यों है

हालांकि BeautifulSoup HTML को पार्स करने के लिए उत्कृष्ट है, गतिशील सामग्री का प्रबंधन अक्सर महत्वपूर्ण जटिलता जोड़ता है। यहीं पर Scrapeless जैसे विशेषज्ञ वेब स्क्रैपिंग API एक सुव्यवस्थित और मजबूत समाधान प्रदान करते हैं। Scrapeless जावास्क्रिप्ट रेंडरिंग, IP रोटेशन, और एंटी-बॉट बचाव की चुनौतियों को दूर करता है, जिससे आप पूरी तरह से डेटा निष्कर्षण पर ध्यान केंद्रित कर सकते हैं।

Scrapeless कैसे गतिशील सामग्री स्क्रैपिंग को सरल बनाता है:

- स्वचालित जावास्क्रिप्ट रेंडरिंग: Scrapeless सभी जावास्क्रिप्ट को स्वचालित रूप से कार्यान्वित करता है, यह सुनिश्चित करता है कि AJAX, क्लाइंट-साइड ढांचों, या WebSockets से गतिशील सामग्री पूरी तरह से रेंडर की गई है। हेडलेस ब्राउज़रों का प्रबंधन करने की आवश्यकता नहीं है।

- बिल्ट-इन एंटी-बॉट और CAPTCHA बायपास: यह बुद्धिमान IP रोटेशन, ब्राउज़र फिंगरप्रिंटिंग, और CAPTCHA हल करने सहित उन्नत बचाव तकनीकों को एकीकृत करता है, जटिल एंटी-बॉट सिस्टम को निर्बाध रूप से बायपास करता है।

- सरल एकीकरण: आपका पाइथन स्क्रिप्ट Scrapeless API को एक सरल HTTP अनुरोध भेजता है। API सभी भारी काम संभालता है, BeautifulSoup के लिए पार्स करने के लिए साफ, पूरी तरह से रेंडर की गई HTML लौटाता है, आपके कोडबेस को काफी कम करता है।

- स्केलेबिलिटी और विश्वसनीयता: उद्यम-स्तरीय डेटा निष्कर्षण के लिए डिज़ाइन किया गया, Scrapeless unparalleled स्केलेबिलिटी और उच्च अपटाइम प्रदान करता है, बिना आपको बुनियादी ढांचे, प्रॉक्सियों, या ब्राउज़र इंस्टेंस का प्रबंधन किए।

- लागत-कुशलता: जबकि यह एक प्रीमियम सेवा है, Scrapeless अक्सर कस्टम गतिशील स्क्रैपिंग समाधान बनाने और बनाए रखने की तुलना में अधिक लागत-कुशल साबित होता है, विकास के समय और संसाधनों की बचत करता है।

Scrapeless को एकीकृत करके, आप गतिशील सामग्री स्क्रैपिंग को एक कुशल प्रक्रिया में बदलते हैं, जावास्क्रिप्ट रेंडरिंग और एंटी-बॉट उपायों की जटिलताओं के बिना BeautifulSoup की पार्सिंग ताकत का सर्वोत्तम प्रदर्शन करते हैं।

निष्कर्ष और कार्रवाई के लिए कॉल

BeautifulSoup के साथ गतिशील सामग्री को संभालना इसके स्थिर पार्सिंग क्षमताओं से आगे बढ़ने की आवश्यकता है। विभिन्न समाधान मौजूद हैं, BeautifulSoup को ब्राउज़र स्वचालन उपकरणों जैसे Selenium और Playwright के साथ जोड़ने से लेकर, Splash जैसी विशिष्ट सेवाओं का उपयोग करने या सीधे APIs को क्वेरी करने तक। प्रत्येक विधि स्पष्ट लाभ और व्यापार में परिवर्तन प्रदान करती है।

मॉडर्न, जावास्क्रिप्ट-भारी वेबसाइटों का सामना करने वाले डेवलपर्स के लिए, चुनाव परियोजना के पैमाने, गतिशील सामग्री की जटिलता, और एंटी-बॉट बचाव की जरूरतों के आधार पर होता है। जबकि स्व-प्रबंधित ब्राउज़र स्वचालन नियंत्रण प्रदान करता है, यह महत्वपूर्ण ओवरहेड और रखरखाव के साथ आता है।

एक कुशल, स्केलेबल, और परेशानी मुक्त दृष्टिकोण के लिए, Scrapeless जैसे समर्पित वेब स्क्रैपिंग API का उपयोग सबसे अच्छा है। जावास्क्रिप्ट रेंडरिंग, IP रोटेशन, और एंटी-बॉट बायपास की जटिलताओं को ऑफलोड करके, Scrapeless आपको बुनियादी ढांचे के प्रबंधन के बिना BeautifulSoup की पार्सिंग शक्ति को अधिकतम करने की अनुमति देता है। यह चुनौतीपूर्ण गतिशील वेबसाइटों से विश्वसनीय डेटा निष्कर्षण को सक्षम बनाता है।

क्या आप अपनी गतिशील वेब स्क्रैपिंग को सरल बनाना चाहते हैं?

आधुनिक सामग्री आपके डेटा निष्कर्षण लक्ष्यों के लिए बाधा न बने। जानें कि Scrapeless कैसे आपके कार्यप्रवाह को सरल बना सकता है और आपको आवश्यक वेब डेटा तक विश्वसनीय पहुंच प्रदान कर सकता है। आज ही अपनी मुफ्त परीक्षण अवधि शुरू करें और वेब स्क्रैपिंग के भविष्य का अनुभव करें।

अब Scrapeless के साथ अपनी मुफ्त परीक्षण अवधि शुरू करें!

अक्सर पूछे जाने वाले प्रश्न (FAQ)

प्रश्न 1: BeautifulSoup सीधे गतिशील सामग्री को संभाल क्यों नहीं सकता?

BeautifulSoup एक स्थिर HTML पार्सर है; इसमें जावास्क्रिप्ट इंजन और रेंडरिंग क्षमताओं की कमी है। यह अतिरिक्त सामग्री लोड करने या DOM को संशोधित करने वाली जावास्क्रिप्ट कोड को निष्पादित नहीं कर सकता, इसलिए प्रारंभिक लोड के बाद उत्पन्न होने वाली गतिशील सामग्री इसके लिए अदृश्य है।

प्रश्न 2: क्या गतिशील सामग्री के लिए हमेशा एक हेडलेस ब्राउज़र का उपयोग करना आवश्यक है?

यह हमेशा नहीं है। यदि डायनामिक सामग्री एक खोजने योग्य API से आती है, तो उस API को सीधे requests के माध्यम से क्वेरी करना अधिक कुशल है। हालांकि, जटिल जावास्क्रिप्ट इंटरएक्शन, क्लाइंट-साइड रेंडरिंग, या छिपे हुए APIs के लिए, एक हेडलेस ब्राउज़र या विशेष स्क्रैपिंग API की आवश्यकता होती है।

प्रश्न 3: सेलिनियम/प्ले राइट और वेब स्क्रैपिंग APIs के बीच मुख्य ट्रेड-ऑफ क्या हैं?

सेलिनियम/प्ले राइट: पूर्ण नियंत्रण प्रदान करता है, मुफ्त (इन्फ्रा को छोड़कर), परीक्षण के लिए अच्छा है। संसाधनों का उपभोग करता है, धीमा, जटिल सेटअप, एंटी-बॉट पहचान के प्रति संवेदनशील, उच्च रखरखाव।

वेब स्क्रैपिंग APIs: अत्यधिक कुशल, जटिलताओं (JS रेंडरिंग, प्रॉक्सीज, एंटी-बॉट) को अमूर्त करता है, स्केलेबल, विश्वसनीय। भुगतान सेवा, कम विस्तार नियंत्रण, बाहरी निर्भरता।

चुनाव परियोजना के पैमाने, बजट, और इच्छित नियंत्रण की तुलना में सुविधा पर निर्भर करता है।

प्रश्न 4: मैं कैसे पहचान सकता हूं कि कोई वेबसाइट डायनामिक सामग्री का उपयोग करती है?

- जावास्क्रिप्ट अक्षम करें: यदि सामग्री गायब हो जाती है, तो यह डायनामिक है।

- ब्राउज़र डेवलपर उपकरण (नेटवर्क टैब): प्रारंभिक HTML के बाद डेटा लोड करने वाले XHR/Fetch अनुरोधों की तलाश करें।

- पृष्ठ स्रोत देखें बनाम तत्व का निरीक्षण करें: यदि 'तत्व का निरीक्षण करें' अधिक सामग्री दिखाता है, तो यह डायनामिक है।

प्रश्न 5: क्या मैं वेब स्क्रैपिंग API द्वारा लौटाए गए HTML को पार्स करने के लिए BeautifulSoup का उपयोग कर सकता हूं?

हाँ, यह अत्यधिक अनुशंसित है। वेब स्क्रैपिंग APIs पूरी तरह से रेंडर की गई, स्थिर HTML लौटाती हैं, जिसे पार्स करने के लिए BeautifulSoup बिल्कुल सही बनाया गया है। यह मजबूत सामग्री पहुँच को लचीले डेटा निष्कर्षण के साथ जोड़ता है।

संदर्भ

[1] ZenRows: Selenium एंटी-बॉट बायपास

[2] Playwright: सर्वश्रेष्ठ अभ्यास

स्क्रैपलेस में, हम केवल सार्वजनिक रूप से उपलब्ध डेटा का उपयोग करते हैं, जबकि लागू कानूनों, विनियमों और वेबसाइट गोपनीयता नीतियों का सख्ती से अनुपालन करते हैं। इस ब्लॉग में सामग्री केवल प्रदर्शन उद्देश्यों के लिए है और इसमें कोई अवैध या उल्लंघन करने वाली गतिविधियों को शामिल नहीं किया गया है। हम इस ब्लॉग या तृतीय-पक्ष लिंक से जानकारी के उपयोग के लिए सभी देयता को कोई गारंटी नहीं देते हैं और सभी देयता का खुलासा करते हैं। किसी भी स्क्रैपिंग गतिविधियों में संलग्न होने से पहले, अपने कानूनी सलाहकार से परामर्श करें और लक्ष्य वेबसाइट की सेवा की शर्तों की समीक्षा करें या आवश्यक अनुमतियाँ प्राप्त करें।